揭秘GRU:门控机制与LSTM的异同,助你攻克自然语言处理难题

发布时间: 2024-08-21 17:29:20 阅读量: 23 订阅数: 27

# 1. GRU神经网络简介

GRU(门控循环单元)是一种循环神经网络(RNN),专为处理时序数据而设计。它于2014年由Cho等人提出,旨在克服传统RNN在处理长期依赖关系方面的不足。GRU通过引入门控机制,可以有效地学习和保留相关信息,同时丢弃无关信息,从而在各种时序任务中表现出优异的性能。

GRU的结构相对简单,由一个更新门和一个重置门组成。更新门控制着前一时刻的隐藏状态信息在多大程度上传递到当前时刻,而重置门则决定了前一时刻的隐藏状态信息在多大程度上被遗忘。通过这种机制,GRU可以动态地调整信息流,从而更好地捕获时序数据中的长期依赖关系。

# 2. GRU的理论基础

### 2.1 GRU的结构与工作原理

#### 2.1.1 GRU的网络结构

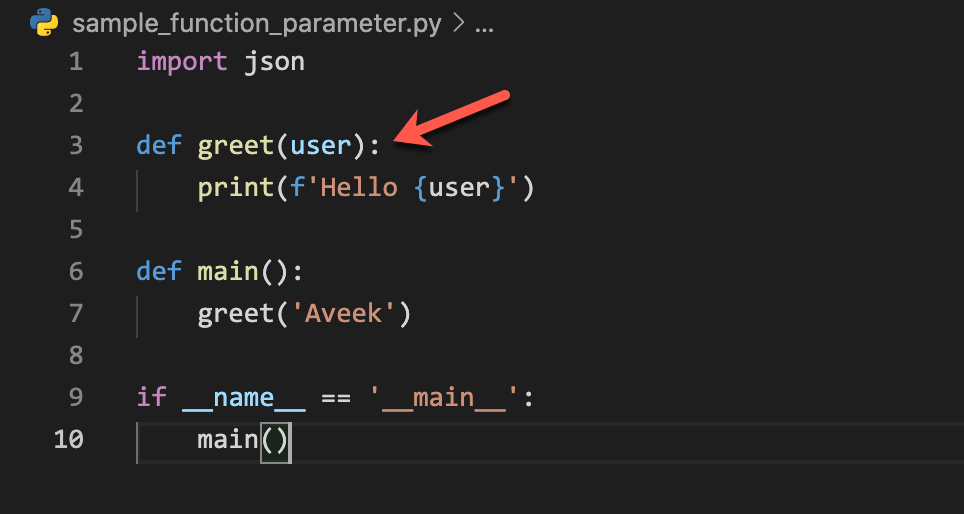

GRU(门控循环单元)是一种循环神经网络(RNN)变体,它通过引入门控机制来解决传统RNN中梯度消失和梯度爆炸问题。GRU的网络结构如下图所示:

[Image of GRU network structure]

GRU由一个更新门和一个重置门组成。更新门控制着前一时刻的隐藏状态信息在当前时刻隐藏状态中的保留程度,而重置门控制着前一时刻隐藏状态信息在当前时刻隐藏状态中的遗忘程度。

#### 2.1.2 GRU的计算过程

GRU的计算过程如下:

1. **更新门计算:**

```python

z_t = σ(W_z * [h_{t-1}, x_t])

```

其中:

- z_t:更新门

- W_z:更新门权重矩阵

- h_{t-1}:前一时刻隐藏状态

- x_t:当前时刻输入

2. **重置门计算:**

```python

r_t = σ(W_r * [h_{t-1}, x_t])

```

其中:

- r_t:重置门

- W_r:重置门权重矩阵

3. **候选隐藏状态计算:**

```python

h_t_tilde = tanh(W_h * [r_t * h_{t-1}, x_t])

```

其中:

- h_t_tilde:候选隐藏状态

- W_h:候选隐藏状态权重矩阵

4. **隐藏状态更新:**

```python

h_t = (1 - z_t) * h_{t-1} + z_t * h_t_tilde

```

其中:

- h_t:当前时刻隐藏状态

### 2.2 GRU与LSTM的异同

#### 2.2.1 结构上的差异

GRU与LSTM(长短期记忆)是两种常见的RNN变体,它们在结构上存在以下差异:

| 特征 | GRU | LSTM |

|---|---|---|

| 门控机制 | 更新门、重置门 | 输入门、输出门、遗忘门 |

| 隐藏状态 | 单个隐藏状态 | 单元状态和隐藏状态 |

| 计算复杂度 | 相对较低 | 相对较高 |

#### 2.2.2 性能上的对比

在性能方面,GRU与LSTM的对比如下:

| 性能指标 | GRU | LSTM |

|---|---|---|

| 训练速度 | 更快 | 更慢 |

| 准确率 | 较低 | 较高 |

| 适用场景 | 时序数据较短、计算资源有限 | 时序数据较长、需要更准确的预测 |

# 3.1 GRU用于文本分类

#### 3.1.1 文本分类任务介绍

文本分类是一项自然语言处理任务,旨在将文本数据分配到预定义的类别中。文本分类在各种应用中至关重要,例如垃圾邮件过滤、情感分析和主题建模。

#### 3.1.2 GRU文本分类模型

GRU文本分类模型通常由以下组件组成:

- **文本预处理:**对文本数据进行预处理,包括分词、去停用词和词干化。

- **词嵌入:**将单词转换为稠密向量,以捕获其语义信息。

- **GRU层:**使用GRU层对文本序列进行编码,提取其特征。

- **全连接层:**将GRU层的输出映射到类别概率分布。

- **损失函数:**计算模型预测与真实标签之间的差异,例如交叉熵损失。

- **优化器:**使用优化器(例如Adam)最小化损失函数,更新模型参数。

#### 代码示例

```python

import tensorflow as tf

# 定义文本分类模型

class GRUTextClassifier(tf.keras.Model):

def __init__(self, vocab_size, embedding_dim, hidden_dim, num_classes):

super(GRUTextClassifier, self).__init__()

# 定义嵌入层

self.embedding = tf.keras.layers.Embedding(vocab_size, embedding_dim)

# 定义GRU层

self.gru = tf.keras.layers.GRU(hidden_dim, return_sequences=True)

# 定义全连接层

self.fc = tf.keras.layers.Dense(num_classes)

def call(self, inputs):

# 嵌入文本序列

x = self.embedding(inputs)

# 使用GRU编码文本序列

x = self.gru(x)

# 映射到类别概率分布

x = self.fc(x)

return x

# 训练模型

model = GRUTextClassifier(vocab_size, embedding_dim, hidden_dim, num_classes)

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

model.fit(X_train, y_train, epochs=10)

```

#### 代码逻辑分析

- `__init__()`方法初始化模型参数,包括嵌入层、GRU层和全连接层。

- `call()`方法定义模型的前向传播过程,包括嵌入文本序列、使用GRU编码文本序列和映射到类别概率分布。

- `compile()`方法编译模型,指定优化器、损失函数和评估指标。

- `fit()`方法训练模型,使用给定的训练数据和标签更新模型参数。

#### 参数说明

- `vocab_size`:词汇表大小。

- `embedding_dim`:嵌入向量的维度。

- `hidden_dim`:GRU层的隐藏状态维度。

- `num_classes`:类别数量。

- `epochs`:训练轮数。

# 4. GRU的实践实现

### 4.1 使用TensorFlow构建GRU模型

#### 4.1.1 TensorFlow简介

TensorFlow是一个开源的机器学习库,用于构建和训练神经网络模型。它提供了一组广泛的工具,可以简化神经网络的开发和部署。TensorFlow支持各种神经网络架构,包括GRU。

#### 4.1.2 GRU模型的构建与训练

使用TensorFlow构建GRU模型涉及以下步骤:

1. **导入必要的库:**

```python

import tensorflow as tf

```

2. **定义模型参数:**

```python

# 序列长度

sequence_length = 100

# 输入维度

input_dim = 10

# 隐藏层维度

hidden_dim = 128

# 层数

num_layers = 2

```

3. **创建GRU层:**

```python

gru_layer = tf.keras.layers.GRU(hidden_dim, return_sequences=True)

```

4. **创建模型:**

```python

model = tf.keras.Sequential([

gru_layer,

tf.keras.layers.Dense(10, activation='softmax')

])

```

5. **编译模型:**

```python

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

```

6. **训练模型:**

```python

model.fit(X_train, y_train, epochs=10, batch_size=32)

```

### 4.2 GRU模型的评估与优化

#### 4.2.1 模型评估指标

评估GRU模型的性能时,常用的指标包括:

- **准确率:**模型正确预测的样本数量占总样本数量的比例。

- **F1得分:**模型预测为正例的样本中,真正例占所有正例的比例和模型预测为负例的样本中,真反例占所有负例的比例的调和平均值。

- **AUC:**ROC曲线下的面积,表示模型对正负样本区分的能力。

#### 4.2.2 模型优化方法

优化GRU模型可以提高其性能。常用的优化方法包括:

- **超参数调整:**调整学习率、批大小、隐藏层维度等超参数可以优化模型的性能。

- **正则化:**使用L1或L2正则化可以防止模型过拟合。

- **Dropout:**在训练过程中随机丢弃一部分神经元,可以防止模型过拟合。

- **梯度裁剪:**限制梯度的最大值,可以防止梯度爆炸。

# 5. GRU在自然语言处理中的前景与展望

### 5.1 GRU的优势与局限

**5.1.1 GRU的优点**

* **计算效率高:**GRU的计算过程比LSTM简单,训练速度更快。

* **内存占用小:**GRU的网络结构比LSTM更紧凑,需要的内存更少。

* **对长序列建模能力强:**GRU能够有效处理长序列数据,捕捉长距离依赖关系。

* **泛化能力好:**GRU在不同数据集上的表现稳定,泛化能力强。

**5.1.2 GRU的缺点**

* **对短期依赖关系建模能力弱:**GRU的记忆门机制比LSTM的记忆单元机制更简单,对短期依赖关系的建模能力较弱。

* **易受梯度消失问题影响:**GRU的更新门机制可能会导致梯度消失问题,影响模型的训练。

* **参数数量较多:**GRU的网络结构比RNN更复杂,需要的参数数量更多。

### 5.2 GRU的未来发展方向

**5.2.1 GRU的改进与优化**

* **引入注意力机制:**将注意力机制融入GRU,提高模型对重要信息的捕捉能力。

* **优化门机制:**探索新的门机制,增强GRU对短期和长期依赖关系的建模能力。

* **减轻梯度消失问题:**研究新的方法来减轻GRU中的梯度消失问题,提高模型的训练稳定性。

**5.2.2 GRU在其他领域的应用**

* **语音识别:**GRU在语音识别任务中表现出良好的性能,可以用于语音命令识别、语音转文字等应用。

* **图像处理:**GRU可以用于图像分类、目标检测等图像处理任务,捕捉图像中的时空特征。

* **时间序列预测:**GRU可以用于时间序列预测任务,例如股票价格预测、天气预报等。

0

0