【扩展应用场景】:探讨Hadoop CombineFileInputFormat的多样性使用场景

发布时间: 2024-10-27 18:56:51 阅读量: 24 订阅数: 27

Hadoop-CombineFileInputFormat:hadoop CombineFileInputFormat的示例实现

# 1. Hadoop CombineFileInputFormat简介

在大数据处理领域,Hadoop是一个不可或缺的生态系统,而MapReduce是其核心组件之一,它负责处理海量数据集的分布式计算。为了优化这一过程,Hadoop引入了多种InputFormat实现,其中CombineFileInputFormat特别引人关注。

CombineFileInputFormat被设计用来有效处理跨多个存储节点的数据,并且优化了小文件的处理。传统InputFormat在处理小文件时,会为每个文件创建一个Map任务,导致Map任务数量剧增,从而消耗大量资源。CombineFileInputFormat通过合并多个文件来减少Map任务的数量,并且能够同时读取多个文件,从而提高数据处理效率。

在本文的第一章中,我们将深入探讨CombineFileInputFormat的初衷与设计目标,以及它如何解决Hadoop在处理大规模数据时的难题。通过介绍CombineFileInputFormat的基本概念和工作方式,我们将揭开它的神秘面纱,为读者提供一个清晰的起始点,从而能够更好地理解其后的理论基础和实践应用。

# 2. Hadoop CombineFileInputFormat的理论基础

在深入探讨Hadoop CombineFileInputFormat(CFIF)的实践应用之前,本章节将重点介绍其理论基础,为读者提供一个全面的理解背景。首先,我们会回顾Hadoop MapReduce框架的核心组件和工作原理,接着对输入输出处理机制进行剖析。然后,本章将深入探究CombineFileInputFormat的基本概念,包括其分类、特点以及工作原理。最后,我们将讨论优化数据读取的策略,特别是针对数据本地性和网络带宽利用的优化方法。

## 2.1 Hadoop MapReduce框架概述

### 2.1.1 MapReduce核心组件和工作原理

Hadoop MapReduce是一个编程模型和处理大数据集的相关实现。它主要用于分布式计算,能够有效地处理PB级别的数据。MapReduce框架由以下几个核心组件构成:

- JobTracker: 负责资源管理和任务调度的主节点。

- TaskTracker: 在集群的每个节点上运行,负责执行具体的任务。

- JobClient: 用户与MapReduce作业交互的客户端。

MapReduce的工作流程遵循以下几个步骤:

1. **作业提交**:用户通过JobClient将MapReduce程序提交给JobTracker。

2. **作业初始化**:JobTracker负责初始化作业,为作业分配输入输出路径。

3. **任务分配**:根据TaskTracker的资源情况,JobTracker将Map任务和Reduce任务分配给TaskTracker。

4. **任务执行**:TaskTracker在获得任务后,负责启动任务运行。

5. **中间数据排序和分组**:Map任务完成后,输出的中间数据会进行排序和分组。

6. **归约阶段**:排序后的中间数据被传递给Reduce任务进行处理。

7. **输出**:Reduce任务处理完数据后,输出最终结果到指定位置。

MapReduce的工作原理建立在“分而治之”的策略上,通过将大任务拆分成小任务并行处理,然后对结果进行合并,以此提高处理大数据的效率。

### 2.1.2 输入输出处理机制

Hadoop的输入输出处理机制是MapReduce框架能够高效处理数据的关键。这一机制由InputFormat和OutputFormat两个接口定义:

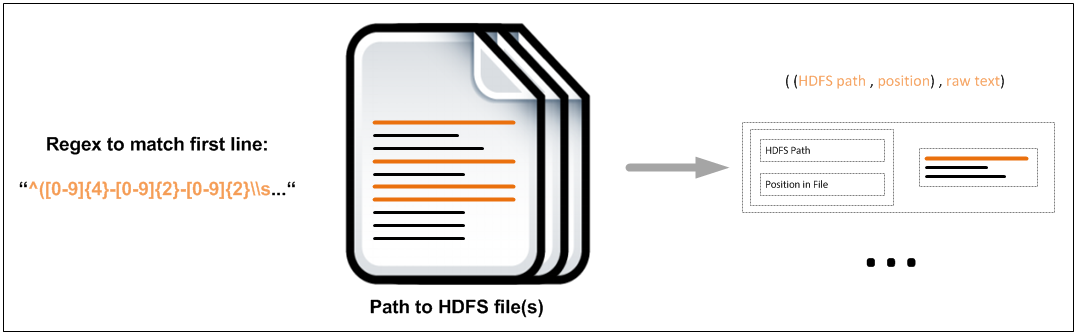

- **InputFormat**:负责定义输入数据的格式和规范。它提供了两个关键的方法:`getSplits`和`createRecordReader`。`getSplits`方法用于将输入数据分割成多个片段(splits),以便并行处理。`createRecordReader`方法用于创建用于读取数据的记录读取器。

标准的InputFormat实现包括`TextInputFormat`和`SequenceFileInputFormat`等,每种实现根据数据源的不同特点提供定制化的处理逻辑。

- **OutputFormat**:定义输出数据的格式和规范。它同样提供两个关键方法:`getRecordWriter`和`getOutputPath`。`getRecordWriter`方法用于获取用于写入数据的记录写入器,`getOutputPath`方法用于获取输出路径。

标准的OutputFormat实现包括`TextOutputFormat`和`SequenceFileOutputFormat`等,它们根据输出数据的格式需求提供相应的写入逻辑。

## 2.2 CombineFileInputFormat的基本概念

### 2.2.1 输入格式的分类和特点

在Hadoop MapReduce框架中,根据数据存储的大小和分布特点,我们可以将InputFormat分为三类:

- **小文件InputFormat**:用于处理小文件的场景。但频繁创建和关闭文件会产生大量的开销。

- **大文件InputFormat**:优化了对大文件的处理,但对小文件处理效率较低。

- **组合文件InputFormat(CFIF)**:旨在解决小文件处理效率低下的问题,它允许Map任务处理由多个文件组成的单个输入分片。

CFIF的特点在于它能够有效地合并多个文件和多个HDFS块到一个逻辑输入分片,减少Map任务的数量,提升数据处理的效率。

### 2.2.2 CombineFileInputFormat的工作原理

CFIF通过以下方式提高Map任务的效率:

- **减少Map任务的数目**:通过将多个小文件合并为一个输入分片,CFIF减少了Map任务的总体数目,这降低了任务初始化和管理的开销。

- **优化I/O操作**:CFIF利用HDFS块本地性原理,尽量保证输入分片中的数据都存储在同一个节点上,减少网络I/O开销。

## 2.3 优化数据读取的策略

### 2.3.1 数据本地性优化

数据本地性是Hadoop MapReduce框架性能的关键因素之一。理想情况下,一个任务应尽可能在存储其输入数据的节点上执行。这样可以最小化网络I/O消耗,并提升处理速度。

CFIF在处理大文件时通过将分散的数据块组织成一个大的输入分片,来增强数据的本地性。对于小文件处理,CFIF通过合并多个小文件到一个大的输入分片,降低了跨节点的数据传输需求。

### 2.3.2 网络带宽的利用和减少I/O开销

网络带宽的高效利用和I/O开销的减少是优化数据读取过程的另一个重要方面。CFIF通过以下几个策略实现:

- **数据合并**:CFIF能够在Map任务开始前合并多个小文件到一个大的输入分片,减少需要读取的数据量。

- **序列化优化**:CFIF通过减少网络传输的数据量,降低序列化和反序列化操作的次数,从而减轻节点的负载。

- **批处理**:数据读取时,CFIF可将多个记录组合成一个批次进行处理,这减少了网络传输的次数。

通过减少任务数和优化数据传输,CFIF大幅提高了Hadoop集群中数据处理的效率。

以上内容仅作为本章节的概览,为理解Hadoop CombineFileInputFormat的理论基础打下了坚实的基础。接下来,我们将详细探讨Hadoop CombineFileInputFormat的实践应用,包括处理大文件、合并小文件、整合多数据源的具体方法和案例。

# 3. Hadoop CombineFileInputFormat的实践应用

随着大数据技术的不断演进,Hadoop已经成为处理大规模数据集不可或缺的一部分。然而,在处理大型文件、小文件合并以及多数据源整合时,Hadoop的MapReduce框架面临着特定的挑战。本章节将探讨Hadoop CombineFileInputFormat在实际场景中的应用,如何通过实践解决这些挑战,以及如何通过优化策略来提升数据处理的效率。

## 3.1 大文件处理

### 3.1.1 大文件读取的挑战

处理大文件时,最大的挑战之一是内存管理。在MapReduce中,文件被切分成块,每个块由一个Mapper处理。若文件非常大,单个块可能无法完全加载到内存中,这会导致频繁的磁盘I/O操作,增加处理时间。此外,如果大文件被不均匀地切分,可能会造成某些Mapper的任务比其他任务重,从而影响整个作业的执行效率。

### 3.1.2 CombineFileInputFormat在大文件处理中的应用案例

一个典型的案例是处理大量的日志文件,这些日志文件往往非常庞大。使用CombineFileInputFormat,可以将这些大文件分割成较小的数据块,同时保证每个数据块跨越多个文件,这样可以在执行Map任务之前进行更有效的合并,减少Map任务的启动次数,提高整体的数据处理效率。

#### 代码块展示与分析

```java

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "CombineFileInputFormat Big File Example");

job.setInputFormatClass(CombineFileInputFormat.class);

CombineFileInputFormat.setMinInputSplitSize(job, 1024*1024*64); // 设置最小的数据块大小为64MB

CombineFileInputFormat.setMaxInputSplitSize(job, 1024*1024*128); // 设置最大的数据块大小为128MB

FileInputFormat.addInputPath(job, new P

```

0

0