SLF4J分布式系统应用:全局日志管理策略,专家建议

发布时间: 2024-09-27 19:05:23 阅读量: 20 订阅数: 28

# 1. SLF4J简介及日志管理基础

## SLF4J简介

SLF4J,即简单日志门面(Simple Logging Facade for Java),是一套为Java应用程序提供日志记录的高级抽象层。它本身并不提供日志记录的实现,而是通过桥接模块与Logback、Log4j等日志框架进行集成。SLF4J为开发人员提供了一种统一的日志管理方式,使得在项目中切换不同日志框架变得简单快捷。

## 日志管理基础

日志管理是软件开发中的核心部分,它涉及到记录应用程序运行时的信息,比如错误、警告和调试信息。在日志管理中,重要的是能够根据不同场景和需求选择合适的日志级别(如INFO、DEBUG、ERROR等)。基本的日志管理策略包括合理设置日志级别、定义日志格式、配置日志输出目的地(控制台、文件等)以及保证日志信息的安全性和合规性。日志管理不仅有助于问题的快速定位和解决,还可以作为分析系统行为和性能的依据。

# 2. SLF4J在分布式系统中的角色

## 2.1 分布式系统日志的挑战

分布式系统的设计使得各组件可以在不同的物理或虚拟环境中运行,但这也带来了日志管理的复杂性。分布式日志的挑战主要体现在以下几个方面:

### 2.1.1 分布式跟踪和日志关联性问题

分布式跟踪涉及到跨多个服务和组件的数据流追踪,这要求日志系统不仅要记录每个服务的独立日志信息,还要能够将这些分散的日志信息关联起来。日志关联性问题表现为,如何确保相关联的操作日志能够被正确地识别和追踪。例如,一个用户发起的交易流程可能涉及到前端服务、后端服务、数据库、缓存等多个组件,如何将这些组件的日志信息关联起来,以便于后续的调试和分析,是一个亟待解决的问题。

在SLF4J中,虽然本身不提供分布式跟踪功能,但可以通过与其他日志框架的桥接来实现。例如,可以结合使用如Brave、OpenTracing等分布式跟踪系统,通过SLF4J将日志信息与跟踪上下文关联起来。

### 2.1.2 性能开销与日志级别选择

在分布式系统中,性能始终是一个关注点。对于日志系统来说,性能开销主要来源于日志的写入操作。虽然日志记录提供了故障排查的便利,但过多的日志记录也会消耗系统资源,并可能影响整体性能。因此,在分布式系统中,选择合适的日志级别变得尤为重要。

通常情况下,开发者和运维人员需要根据系统运行情况,动态调整日志级别,以达到性能与日志信息完整性的平衡。SLF4J作为日志门面,本身不涉及日志记录的性能开销问题,但其提供了灵活的日志级别配置,使得开发者可以通过配置文件或者程序代码动态地调整日志级别,从而控制日志的输出量。

## 2.2 SLF4J的核心功能和优势

SLF4J不仅仅是一个简单的日志门面,它的核心功能和优势体现在以下几个方面:

### 2.2.1 日志抽象层的原理

SLF4J提供了日志抽象层,它允许开发者在代码中自由地记录日志,而无需关心底层日志框架的选择。这种抽象层的原理是通过绑定实现来桥接SLF4J API和具体的日志框架,如Logback、Log4j等。在运行时,SLF4J API通过查找合适的绑定实现来找到实际的日志框架,并调用相应的方法来记录日志。

### 2.2.2 SLF4J与日志框架的桥接

SLF4J通过桥接机制与不同的日志框架进行集成,这样的设计使得开发者在迁移日志框架时可以最小化代码的修改量。例如,如果一个项目从使用Log4j迁移到Logback,只需要更改依赖中的桥接模块,而不需要更改代码中SLF4J的API调用。这种桥接方式降低了日志框架变更的成本,并提高了系统的可维护性。

## 2.3 SLF4J的高级配置技巧

掌握SLF4J的高级配置技巧可以帮助开发者更有效地管理日志输出,优化系统性能,并满足特定场景的需求。

### 2.3.1 日志策略的配置方法

SLF4J支持多种日志策略的配置方法,其中最常见的就是通过外部配置文件来实现。例如,当SLF4J与Logback结合使用时,可以通过修改`logback.xml`配置文件来设置日志级别、日志格式、日志文件滚动策略等。同时,SLF4J也支持通过编程方式配置日志策略,例如,可以在应用启动时动态地添加和修改日志策略。

### 2.3.2 特定场景下的日志管理策略

在分布式系统中,日志管理需要考虑诸如高并发、大数据量的场景。SLF4J支持通过定制化的Appender来实现特定场景下的日志管理策略。例如,在高并发场景下,可以选择异步Appender来减少日志记录对业务性能的影响;在大数据量场景下,则可以配置日志文件的滚动和压缩,以有效管理磁盘空间。

### SLF4J与Logback结合的配置案例

```xml

<configuration>

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>%d{HH:mm:ss.SSS} [%thread] %-5level %logger{36} - %msg%n</pattern>

</encoder>

</appender>

<root level="info">

<appender-ref ref="STDOUT" />

</root>

<!-- 以下为针对特定类的日志配置 -->

<logger name="com.example.MyService" level="debug" additivity="false">

<appender-ref ref="STDOUT" />

</logger>

</configuration>

```

以上是一个简单的`logback.xml`配置文件案例,其中定义了一个控制台Appender,并设置了日志输出格式。同时,指定了根日志级别以及对特定类的日志级别进行单独配置。

通过SLF4J的配置技巧,可以灵活地应对不同场景下的日志管理需求。接下来的章节将深入探讨SLF4J的高级配置,以帮助开发者更好地掌握这一强大的日志管理工具。

# 3. SLF4J实践应用与案例分析

## 3.1 SLF4J在微服务架构中的应用

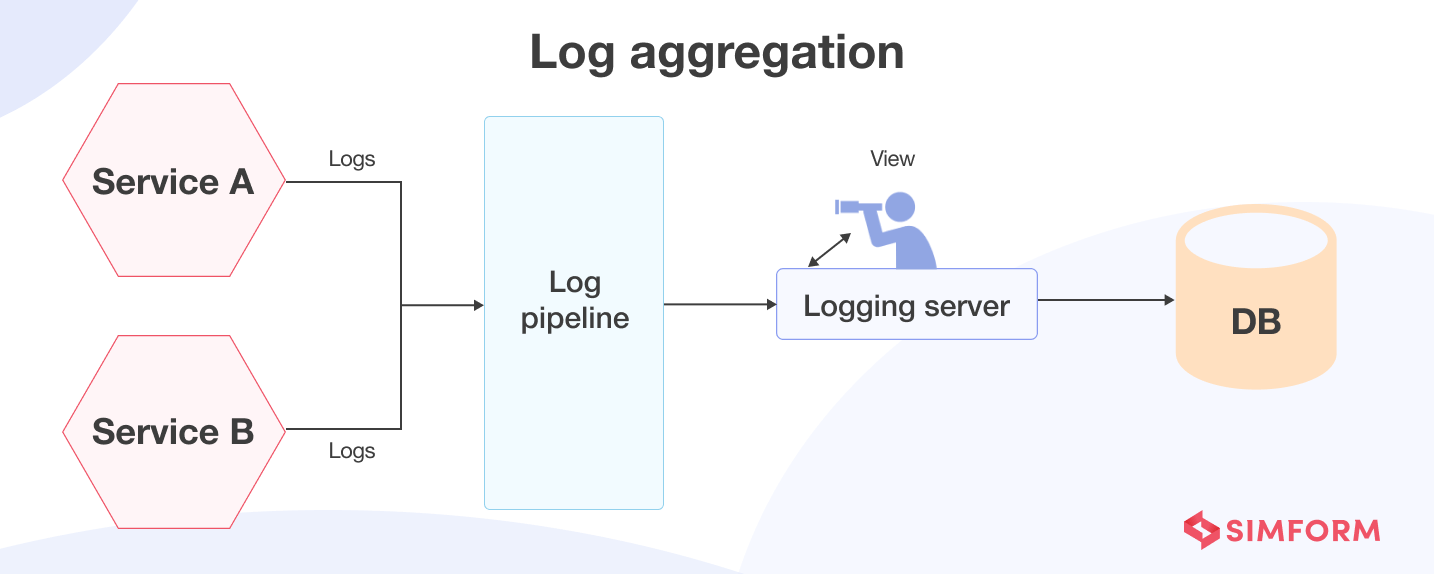

### 3.1.1 微服务日志的收集和聚合

微服务架构中,日志收集和聚合是至关重要的一步。SLF4J作为一个日志门面,可以有效地与各种日志框架进行集成。为了实现高效的日志收集和聚合,我们可以使用各种日志收集工具,如Logstash、Fluentd等。这些工具可以配置为从不同的微服务实例中收集日志,并将它们发送到中央日志管理系统,如ELK(Elasticsearch、Logstash、Kibana)堆栈。

在实施时,需要在每个微服务中配置SLF4J与相应日志框架的绑定,然后将日志框架配置为输出到特定的日志收集代理。例如,可以在Spring Boot微服务中使用SLF4J结合Logback,并配置LogstashAppender将日志转发到Logstash服务器。

```xml

<!-- 在logback.xml中配置LogstashAppender -->

<appender name="LOGSTASH" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>logstash-server:5000</destination>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder"/>

</appender>

<root level="info">

<appender-ref ref="LOGSTASH"/>

</root>

```

这段配置将日志输出到名为"LOGSTASH"的appender,该appender将日志数据发送到指定的Logstash服务器。Logstash服务器接收到日志后,可以进一步处理、存储和可视化。

### 3.1.2 服务链路追踪与日志分析

在微服务架构中,服务间的调用链路可能非常复杂,因此服务链路追踪对于快速定位和解决分布式系统中的问题至关重要。结合SLF4J和链路追踪工具(如Zipkin、Jaeger),开发者可以在日志中加入链路追踪信息,实现对请求全链路的监控。

SLF4J提供了MDC(Mapped Diagnostic Context)功能,可以将特定的上下文信息,如请求ID,存储在一个线程局部变量中,这样日志框架在记录日志时就可以将这些信息输出。在使用MDC时,需要在代码中适当地设置和清除上下文信息,避免造成内存泄漏或上下文信息混淆。

```java

import org.slf4j.MDC;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RestController;

@RestController

public class TracingController {

@GetMapping("/trace")

public String trace() {

MDC.put("requestId", "123456");

***("Handling request with ID: {}", MDC.get("requestId"));

MDC.clear();

return "Request traced!";

}

}

```

此代码段展示了如何在控制器方法中使用MDC来记录请求ID。请求处理完成后,应当清除MDC中的信息,以避免潜在的上下文污染。

## 3.2 SLF4J的实战配置示例

### 3.2.1 不同环境下的SLF4J配置案例

在实际项目中,根据不同的部署环境(如开发、测试、生产)可能需要不同的日志配置。SLF4J允许开发者通过外部配置文件来控制日志行为,常见的配置文件类型包括`.properties`和`.xml`,具体的文件类型取决于所绑定的日志框架。

例如,可以在`src/main/resources`目录下创建不同环境的日志配置文件,如`logback-dev.xml`、`logback-test.xml`和`logback-prod.xml`。然后,根据应用程序运行时的环境变量或配置参数来选择相应的配置文件。

```xml

<!-- logback-dev.xml -->

<configuration>

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>%d{HH:mm:ss.SSS} [%thread] %-5level %logger{36} - %msg%n</pattern>

</encoder>

</appender>

<root level="debug">

<appender-ref ref="STDOUT" />

</root>

</configuration>

```

这个示例配置文件适用于开发环境,将日志级别设为`debug`并输出到控制台。在生产

0

0