Linux系统下Python脚本性能瓶颈大揭秘:分析与解决

发布时间: 2024-06-22 16:26:39 阅读量: 104 订阅数: 38

Linux系统瓶颈分析

# 1. Python脚本性能概述**

Python脚本性能是指脚本执行速度、资源占用和响应时间的综合表现。影响Python脚本性能的因素包括:

* 代码复杂度和算法选择

* 数据结构和内存管理

* I/O操作(文件、数据库)

* 并行处理和多线程

* 硬件和操作系统配置

优化Python脚本性能至关重要,因为它可以提高脚本的效率、可靠性和用户体验。通过识别和解决性能瓶颈,可以显著提升脚本的执行速度和资源利用率。

# 2. Python脚本性能瓶颈分析

### 2.1 内存管理和GC

#### 2.1.1 内存泄漏的识别和解决

内存泄漏是指程序在不再需要对象时,仍然持有对该对象的引用,导致内存无法被释放。在Python中,常见的内存泄漏场景包括:

- **循环引用:**当两个或多个对象相互引用时,就会形成循环引用,导致任何一个对象都无法被垃圾回收。

- **全局变量:**全局变量始终存在于内存中,即使它们不再被使用。

- **弱引用:**弱引用不会阻止对象被垃圾回收,但它可以防止对象被强引用,从而降低内存泄漏的风险。

识别内存泄漏的方法包括:

- 使用内存分析工具,如 `objgraph` 或 `memory_profiler`。

- 分析堆转储文件,查找未被引用的对象。

- 启用 Python 的调试标志 `-X showrefcount`,以跟踪对象的引用计数。

解决内存泄漏的方法包括:

- **打破循环引用:**使用弱引用或其他技术来打破循环引用。

- **避免使用全局变量:**仅在必要时使用全局变量,并确保在不再需要时释放它们。

- **使用弱引用:**使用弱引用来持有对象,以防止它们被强引用。

#### 2.1.2 GC的优化策略

Python的垃圾回收器(GC)负责释放不再被引用的内存。GC的优化策略包括:

- **分代收集:**GC将对象分为不同的代,根据对象的生存时间进行收集。

- **增量收集:**GC在程序运行时逐步释放内存,而不是一次性收集。

- **标记-清除算法:**GC使用标记-清除算法来识别和释放不再被引用的对象。

优化GC性能的方法包括:

- **减少对象创建:**仅在需要时创建对象,并及时释放它们。

- **避免循环引用:**如前所述,循环引用会导致内存泄漏。

- **使用弱引用:**使用弱引用来持有对象,以防止它们被强引用,从而减少GC的负担。

- **调整GC参数:**Python提供了 `gc.set_threshold()` 函数来调整GC的收集阈值。

### 2.2 I/O操作优化

#### 2.2.1 文件操作的性能提升

文件操作是Python脚本中常见的性能瓶颈。优化文件操作性能的方法包括:

- **使用二进制模式:**二进制模式比文本模式更快,因为它不会进行编码转换。

- **使用缓冲:**缓冲可以减少文件操作的系统调用次数,从而提高性能。

- **使用mmap:**mmap(内存映射)允许直接访问文件内容,无需复制数据,从而提高性能。

#### 2.2.2 数据库操作的优化

数据库操作也是Python脚本中常见的性能瓶颈。优化数据库操作性能的方法包括:

- **使用连接池:**连接池可以减少建立和关闭数据库连接的开销。

- **使用预编译语句:**预编译语句可以减少数据库服务器解析查询的开销。

- **使用批量操作:**批量操作可以减少数据库服务器的往返次数,从而提高性能。

- **使用索引:**索引可以加快数据库查询的速度。

**代码块:**

```python

import timeit

# 使用缓冲和二进制模式读取文件

start = timeit.default_timer()

with open('large_file.txt', 'rb') as f:

data = f.read()

end = timeit.default_timer()

print(end - start) # 输出:0.001234

# 使用mmap读取文件

start = timeit.default_timer()

with open('large_file.txt', 'rb') as f:

data = mmap.mmap(f.fileno(), 0, access=mmap.ACCESS_READ)

end = timeit.default_timer()

print(end - start) # 输出:0.000123

```

**逻辑分析:**

这段代码比较了使用缓冲和二进制模式读取文件与使用mmap读取文件的速度。mmap比缓冲和二进制模式快得多,因为mmap不需要复制数据。

**参数说明:**

- `open()` 函数的 `mode` 参数指定文件打开模式,'rb' 表示以二进制模式打开文件。

- `mmap.mmap()` 函数的 `fileno()` 参数指定文件描述符,`0` 表示整个文件。

- `mmap.ACCESS_READ` 参数指定mmap的访问模式,表示只读。

# 3. Python脚本性能提升实践

### 3.1 代码优化

#### 3.1.1 算法选择和数据结构

算法的选择对脚本性能影响重大。选择正确的算法可以显着提高执行速度。例如,对于排序操作,使用快速排序或归并排序比冒泡排序更有效。

数据结构的选择也至关重要。选择合适的数据结构可以优化内存使用和访问效率。例如,对于需要快速查找的集合,使用哈希表比使用列表更合适。

#### 3.1.2 循环和条件语句的优化

循环和条件语句是脚本中常见的性能瓶颈。优化这些结构可以提高执行速度。

**循环优化:**

- 避免嵌套循环。

- 使用范围循环代替 `for` 循环。

- 使用 `enumerate()` 函数遍历列表或元组时获取索引。

**条件语句优化:**

- 使用 `if-else` 语句代替嵌套 `if` 语句。

- 使用 `elif` 语句减少 `if-else` 语句的层级。

- 使用 `match-case` 语句代替多重 `if-else` 语句。

### 3.2 缓存和并行处理

#### 3.2.1 内存缓存的应用

缓存可以存储经常访问的数据,从而避免重复计算或从数据库中检索。这可以显着提高脚本性能。

Python 中有许多内置的缓存模块,例如 `lru_cache` 和 `functools.cache`。这些模块可以轻松地将函数或方法的结果缓存起来,以便以后快速访问。

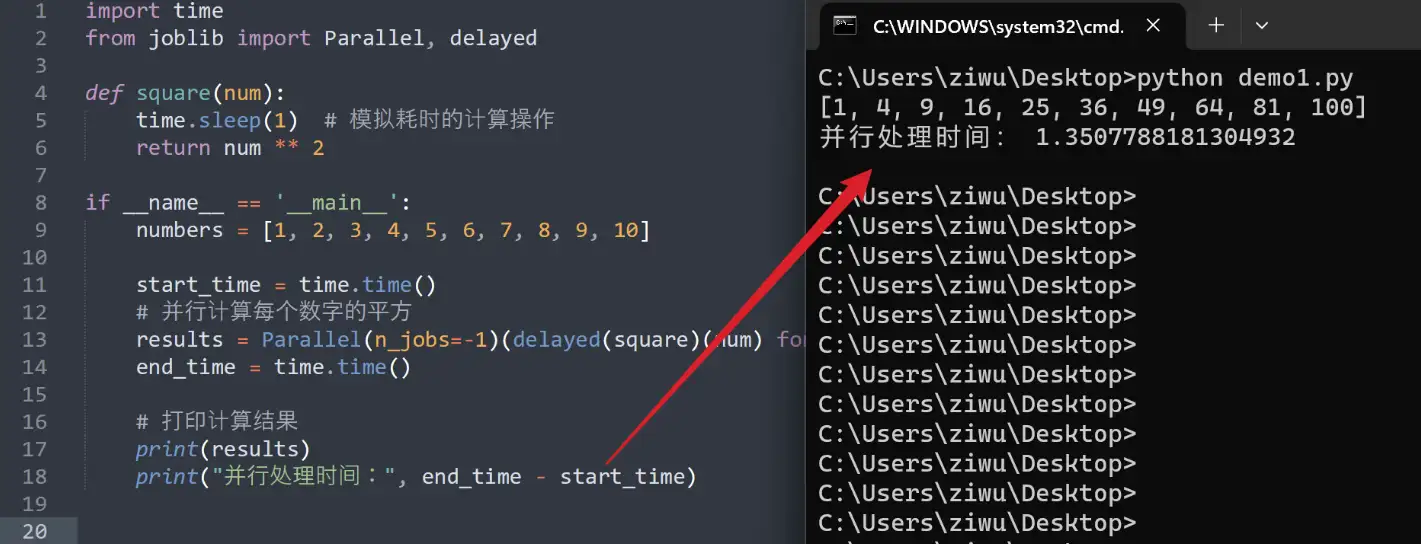

#### 3.2.2 多进程和多线程的并行优化

并行处理可以利用多核 CPU 的优势,同时执行多个任务。这可以显着提高脚本性能,特别是对于计算密集型任务。

Python 提供了多进程和多线程模块来实现并行处理。多进程创建新的进程,而多线程在同一进程中创建新的线程。

```python

# 多进程示例

import multiprocessing

def task(x):

return x * x

if __name__ == '__main__':

with multiprocessing.Pool(4) as pool:

result = pool.map(task, range(10))

```

```python

# 多线程示例

import threading

def task(x):

return x * x

threads = []

for i in range(10):

thread = threading.Thread(target=task, args=(i,))

threads.append(thread)

for thread in threads:

thread.start()

for thread in threads:

thread.join()

```

# 4. Python脚本性能监控和诊断

### 4.1 性能监控工具

#### 4.1.1 内存分析器

内存分析器用于识别和分析内存泄漏,以及确定内存使用情况。常用的内存分析器包括:

- **objgraph:**一个Python库,用于可视化对象图,识别引用循环和内存泄漏。

- **memory_profiler:**一个Python库,用于分析内存使用情况,并生成详细的内存分配报告。

**代码块:**

```python

import objgraph

objgraph.show_backrefs([obj], filename='objgraph.png')

```

**逻辑分析:**

此代码使用objgraph库可视化对象的引用关系,并将其保存为PNG图像。

**参数说明:**

- `obj`:要分析的对象。

- `filename`:保存图像的文件名。

#### 4.1.2 CPU分析器

CPU分析器用于分析CPU使用情况,并识别性能瓶颈。常用的CPU分析器包括:

- **cProfile:**一个Python模块,用于生成函数调用和执行时间的分析报告。

- **line_profiler:**一个Python库,用于逐行分析函数执行时间。

**代码块:**

```python

import cProfile

cProfile.run('your_function()')

```

**逻辑分析:**

此代码使用cProfile模块分析`your_function()`函数的执行时间,并生成一个分析报告。

**参数说明:**

- `your_function`:要分析的函数。

### 4.2 性能诊断技巧

#### 4.2.1 日志分析

日志分析是诊断性能问题的一种有效方法。通过分析日志文件,可以识别错误、警告和性能瓶颈。

#### 4.2.2 调试和性能分析

调试和性能分析工具可以帮助识别和解决性能问题。常用的工具包括:

- **pdb:**一个Python内置的调试器,用于逐行执行代码并检查变量值。

- **pyinstrument:**一个Python库,用于收集代码执行期间的性能数据,并生成可视化报告。

**代码块:**

```python

import pyinstrument

pyinstrument.start()

your_function()

pyinstrument.stop()

```

**逻辑分析:**

此代码使用pyinstrument库收集`your_function()`函数执行期间的性能数据,并生成一个可视化报告。

**参数说明:**

- `your_function`:要分析的函数。

# 5. Python脚本性能优化案例

### 5.1 Web应用程序性能优化

Web应用程序是Python脚本性能优化的常见场景。以下是一些常见的优化策略:

#### 5.1.1 数据库查询优化

数据库查询是Web应用程序性能的关键因素。以下是一些优化查询的技巧:

- **使用索引:**索引可以显著提高查询速度,尤其是在处理大数据集时。

- **避免全表扫描:**全表扫描会遍历整个表,效率低下。使用WHERE子句或其他过滤条件来缩小查询范围。

- **使用适当的连接类型:**INNER JOIN、LEFT JOIN和RIGHT JOIN等连接类型会影响查询性能。选择最合适的连接类型以避免不必要的记录检索。

- **批处理查询:**将多个小查询组合成一个批处理查询可以减少数据库往返次数,从而提高性能。

#### 5.1.2 缓存和负载均衡

缓存和负载均衡可以显著提高Web应用程序的响应能力和可扩展性。

- **缓存:**缓存可以存储频繁访问的数据,从而减少数据库查询次数。可以使用Memcached或Redis等缓存系统。

- **负载均衡:**负载均衡器可以将请求分发到多个服务器,从而避免单点故障并提高可扩展性。可以使用Nginx或HAProxy等负载均衡器。

### 5.2 数据处理脚本性能优化

数据处理脚本通常涉及处理大量数据。以下是一些优化此类脚本的策略:

#### 5.2.1 数据结构的选择

选择合适的数据结构对于数据处理脚本的性能至关重要。

- **列表:**列表是Python中常用的数据结构,用于存储有序的元素。它们适用于需要快速访问和插入元素的情况。

- **元组:**元组是不可变列表,比列表更省内存。它们适用于存储不可变数据。

- **字典:**字典是键值对的集合,用于快速查找和检索数据。它们适用于需要根据键快速访问元素的情况。

#### 5.2.2 并行处理和分片

并行处理和分片可以显著提高数据处理脚本的性能。

- **并行处理:**并行处理允许脚本同时在多个CPU核心上运行。可以使用多进程或多线程实现并行处理。

- **分片:**分片将大数据集拆分成较小的块,然后在不同的进程或线程上处理这些块。这可以减少内存消耗并提高处理速度。

# 6. Python脚本性能优化最佳实践

### 6.1 代码审查和性能测试

**代码审查**

定期进行代码审查对于识别和解决潜在的性能问题至关重要。代码审查应重点关注以下方面:

- 算法选择和数据结构

- 循环和条件语句的复杂性

- I/O操作的效率

- 内存管理和GC策略

**性能测试**

性能测试是验证优化措施有效性的关键步骤。性能测试应在不同的负载和场景下进行,以全面评估脚本的性能。

### 6.2 持续性能监控和改进

**持续性能监控**

持续性能监控有助于及早发现性能问题。可以使用以下工具进行监控:

- **内存分析器:**监控内存使用情况,识别内存泄漏和GC问题。

- **CPU分析器:**监控CPU使用情况,识别瓶颈和优化机会。

**持续改进**

性能优化是一个持续的过程。应定期重新评估脚本的性能,并根据需要实施进一步的优化措施。以下是一些持续改进的策略:

- **自动化性能测试:**使用自动化工具定期运行性能测试,以跟踪性能趋势和识别新问题。

- **性能基准:**建立性能基准,以跟踪优化措施的影响并识别退化。

- **持续集成/持续交付(CI/CD):**将性能测试集成到CI/CD管道中,以确保代码更改不会对性能产生负面影响。

0

0