完整性守卫者:HDFS DataNode数据校验策略与实践

发布时间: 2024-10-30 07:53:12 阅读量: 55 订阅数: 23

# 1. HDFS DataNode数据校验概述

在大数据技术迅速发展的今天,数据存储的可靠性变得至关重要。Hadoop分布式文件系统(HDFS)作为一种广泛使用的分布式存储系统,其数据的完整性检查显得尤为关键。本章将介绍HDFS中DataNode数据校验的基础知识,为读者展现数据校验的必要性和基本概念。在接下来的章节中,我们将深入探讨HDFS数据校验的理论基础、策略分析、实践操作以及高级应用和未来发展。

HDFS通过数据副本和校验机制来保证数据的可靠性。DataNode作为HDFS中的存储节点,负责存储实际的数据块,并执行数据校验来检测数据是否发生损坏。尽管HDFS本身设计了多种机制来预防数据丢失,但现实中的硬件故障、网络问题和软件缺陷都可能造成数据损坏。因此,定期的数据校验是维护数据可靠性不可或缺的一环。

在本章的后续部分,我们将会详细解释HDFS数据校验的各个方面,包括数据校验的流程、策略选择和优化调整,以及如何通过校验过程来提升HDFS数据存储的可靠性。这将为理解更深层次的数据校验技术和实践操作打下坚实的基础。

# 2. HDFS数据校验的理论基础

## 2.1 HDFS数据存储模型

### 2.1.1 HDFS的架构与组件

Hadoop分布式文件系统(HDFS)是一个高度容错的系统,适用于在廉价硬件上存储大量数据。它被设计为能够跨多个硬件设备存储大文件,并通过数据冗余在不可靠的硬件上提供高可靠性。HDFS的架构包括以下关键组件:

- **NameNode(主节点)**:负责管理文件系统的命名空间以及客户端对文件的访问。它记录每个文件中各个块所在的DataNode节点信息,但不保存块数据本身。

- **DataNode(数据节点)**:在集群的各个节点上运行,负责实际存储数据。每个文件被划分为一系列的块,并且每个块被复制到多个DataNode中,以便数据的持久性和可靠性。

- **Secondary NameNode(辅助节点)**:它的职责是合并编辑日志与文件系统的状态,然后将合并后的信息发送给主NameNode,以减少主NameNode的负载。

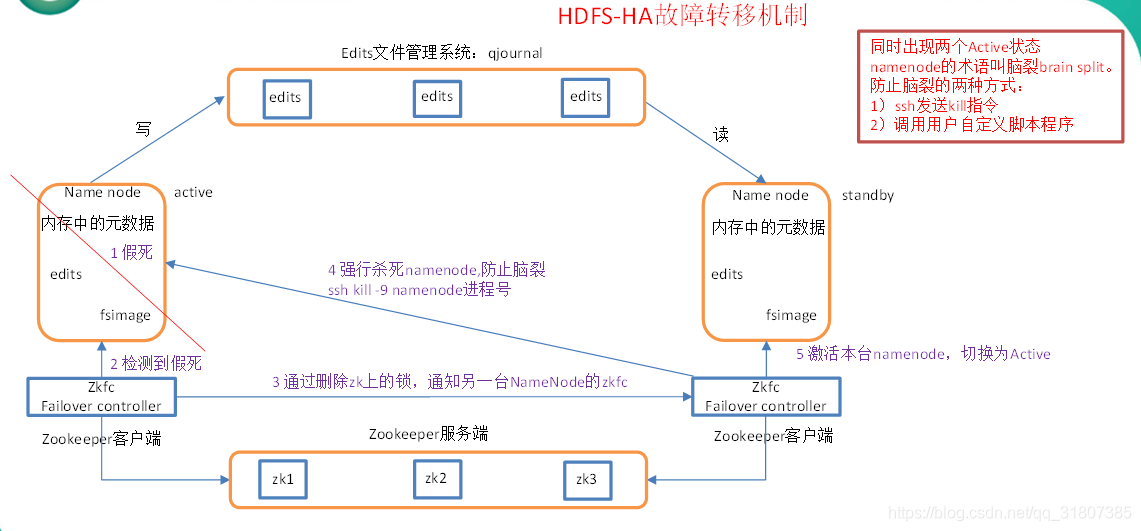

此外,HDFS架构还包括了支持高可用性(HA)和故障转移的组件,如ZooKeeper、JournalNode等。这些组件确保在主NameNode或DataNode出现故障时,文件系统依然可以继续提供服务。

### 2.1.2 DataNode在HDFS中的角色

DataNode作为HDFS的核心数据存储组件,承担着存储文件块的职责。每个DataNode负责管理其所在的节点上的存储空间,以及在存储空间中保存文件块。DataNode执行以下关键任务:

- **存储块数据**:文件被分割成块,并在多个DataNode之间以多个副本的形式存储。

- **块报告**:DataNode定期向NameNode报告其存储的块信息。

- **数据读写**:客户端通过NameNode定位到DataNode后,可以直接与DataNode交互进行数据的读写操作。

- **数据复制**:当有新的数据写入时,DataNode负责数据的复制操作,确保数据块的副本数符合HDFS的设置。

- **数据恢复**:在节点故障时,DataNode会从其他节点上重新复制数据块,以确保数据的完整性。

DataNode也参与数据的校验过程。在数据的读写过程中,DataNode会检查数据块的完整性,确保数据的准确性和可靠性。

## 2.2 数据完整性的重要性

### 2.2.1 数据损坏的原因分析

数据在存储和传输过程中,可能会因为多种原因而损坏,包括但不限于:

- **硬件故障**:硬盘损坏是最常见的数据损坏原因,尤其是当大量廉价硬盘被用于存储时。

- **软件错误**:系统软件或应用程序中未被发现的bug可能导致数据损坏。

- **网络问题**:在分布式系统中,网络不稳定可能导致数据传输错误。

- **人为错误**:如不当操作等,也可能引起数据损坏。

- **环境因素**:比如温度、湿度、静电等也可能对硬件设备造成损害。

了解数据损坏的原因有助于采取适当措施来预防和减轻数据损坏的风险。

### 2.2.2 数据完整性的评估标准

数据完整性评估通常依赖于以下几个标准:

- **校验和(Checksum)**:计算数据的校验和并进行比较,如果数据在存储或传输过程中未被篡改或损坏,则校验和应该保持一致。

- **副本一致性**:多个副本之间的数据内容应该完全一致,任何副本间的不一致性都可能表明数据损坏。

- **读写完整性测试**:通过读取数据块并校验其内容,可以确保数据的完整性。如果读取过程中发现数据不一致,则表明数据损坏。

HDFS通过内部机制,如校验和计算和数据块副本的维护,确保了数据的完整性和可靠性。

## 2.3 HDFS数据校验机制

### 2.3.1 副本校验的概念与原理

副本校验是HDFS确保数据完整性的核心机制之一。HDFS默认为每个文件创建三个副本,分布在不同的DataNode上。副本校验的原理包括:

- **写入时复制**:数据被写入HDFS时,会立即在多个DataNode上创建副本。

- **周期性校验**:HDFS会定期对存储的数据块进行校验,确保副本间的一致性。

- **校验和验证**:HDFS维护每个块的校验和,并在数据读取时验证校验和,以确保数据在未被读取时未被破坏。

### 2.3.2 校验码和校验策略

HDFS使用校验码(checksum)来检测数据损坏。每个数据块都会有一个校验码,并存储在NameNode上。校验策略包括:

- **校验策略**:HDFS默认提供快照和副本校验两种策略。快照校验适用于文件的完整性,副本校验适用于数据块的完整性。

- **校验频率**:HDFS允许管理员自定义校验频率,以平衡校验带来的性能开销和数据完整性的重要性。

通过实施有效的校验码和校验策略,HDFS能够有效地保护数据免受损坏。

通过本章节的介绍,我们已经了解了HDFS数据校验的基础知识,为后续章节中对数据校验策略的深入分析以及实践操作打下了坚实的基础。接下来的章节将详细介绍HDFS DataNode数据校验策略的类型、设置、以及校验过程中的性能考量。

# 3. HDFS DataNode数据校验策略分析

## 3.1 校验策略的类型与选择

### 3.1.1 心跳与数据块报告机制

心跳机制是Hadoop集群中各节点间通信的一种方式,用于监控节点状态和任务进度。DataNode通过定时向NameNode发送心跳信号来报告自身健康状况。心跳机制使得Hadoop能够快速检测到故障节点,并采取措施确保数据的高可用性。

数据块报告机制则是DataNode定期向NameNode汇报其存储的数据

0

0