服务快速恢复指南:HDFS DataNode故障转移机制

发布时间: 2024-10-30 07:46:29 阅读量: 25 订阅数: 32

# 1. HDFS架构与DataNode概览

在当今数据驱动的时代,Hadoop分布式文件系统(HDFS)成为了大数据存储解决方案中不可或缺的一环。作为HDFS的基石之一,DataNode承担着数据存储的重要角色,是实现大规模数据存储与处理的关键组件。本章节首先介绍HDFS架构,随后详细探讨DataNode的功能和工作原理,为读者构建起一个坚实的基础,以更好地理解后续章节中关于故障转移的深入讨论。

## HDFS架构简介

HDFS是Hadoop项目的一部分,专为分布式存储设计,能够存储大量数据并提供高吞吐率的访问。它将大文件分散存储在多个DataNode上,并由NameNode进行管理和维护文件系统的命名空间。这种设计使得HDFS能够有效地支持大规模数据集的读写操作。

## DataNode的功能与角色

DataNode作为HDFS中的工作节点,直接管理存储设备,负责数据的存储和检索。每个DataNode负责一个节点上的数据块存储,并通过心跳机制向NameNode报告自身状态。它实现了数据的复制,保证了数据的高可用性和容错能力。DataNode对于HDFS的高效数据处理和可靠性起到了至关重要的作用。

通过本章的学习,读者将对HDFS有了初步的认识,对于DataNode的功能和重要性有了初步了解。接下来的章节将深入探讨DataNode的故障转移机制及其优化策略。

# 2. DataNode故障转移的理论基础

## 2.1 Hadoop分布式文件系统(HDFS)核心概念

### 2.1.1 HDFS的设计原理与组件

Hadoop分布式文件系统(HDFS)是Hadoop的存储层,设计用来支持分布式计算的大量数据集。HDFS借鉴了Google的GFS设计,采用了主从(Master/Slave)结构。

- **NameNode**:HDFS的主节点,维护文件系统的元数据,如文件目录树和文件与数据块的映射关系。

- **DataNode**:HDFS的工作节点,负责存储实际的数据块,并执行来自NameNode的读写请求。

- **Secondary NameNode**:定期合并编辑日志和文件系统的元数据快照,帮助NameNode减少重启时间。

HDFS的设计原理基于以下几点:

- **高容错性**:通过数据块的多副本存储机制实现。

- **高吞吐量**:保证大数据集在多个节点上的高效处理。

- **简单一致性模型**:支持一次写入,多次读取,且不支持文件的更新操作。

### 2.1.2 DataNode的角色与功能

DataNode是HDFS中存储和检索数据块的组件。每个DataNode都运行在一个节点上,与NameNode和其他DataNode交互,以实现系统的稳定运行。

DataNode的核心功能包括:

- **存储管理**:管理本地文件系统的存储空间,负责数据块的存储和检索。

- **数据块复制**:依据HDFS的配置自动对数据进行备份,以实现容错。

- **负载均衡**:在节点间动态移动数据块,以优化集群性能。

- **健康报告**:定期向NameNode发送心跳信号报告自己的健康状态,并接收指令。

## 2.2 故障转移机制的重要性

### 2.2.1 数据高可用性的意义

数据高可用性是指在系统发生故障时,数据依然能够持续可用,不会丢失。在HDFS中,数据的高可用性是通过数据冗余和故障转移来实现的。每个数据块默认有三个副本,分布在不同的DataNode上,即使一个DataNode发生故障,数据依然可以从其他副本中恢复。

### 2.2.2 故障转移与系统稳定性的关系

故障转移是指当HDFS中的一个DataNode节点出现故障时,系统能够自动将该节点上的数据块复制到其他健康节点上,从而保证系统的稳定性和数据的可用性。故障转移机制的引入,使得HDFS具有自我修复的能力,极大地提高了系统的稳定性和容错性。

## 2.3 故障转移流程解析

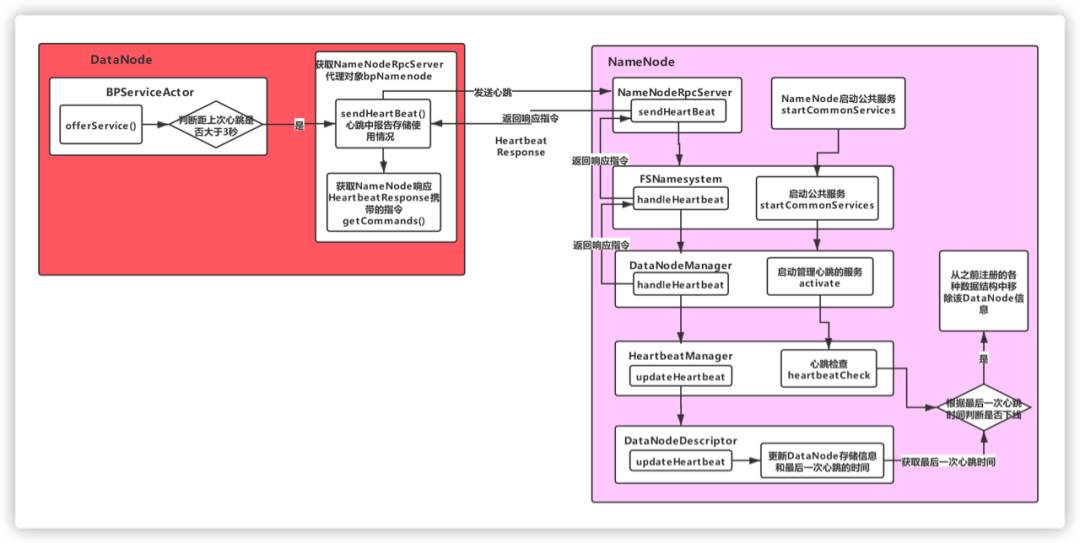

### 2.3.1 故障检测机制

HDFS的故障检测机制主要依赖于NameNode与DataNode之间的健康监控。

- **心跳机制**:DataNode定时向NameNode发送心跳消息,表明其存活状态。

- **超时机制**:如果在指定时间内NameNode没有收到某个DataNode的心跳,将认为该节点宕机。

### 2.3.2 自动故障恢复的步骤

故障恢复步骤通常包括:

- **检测到故障**:NameNode标记故障DataNode上存储的数据块为“已知坏块”。

- **数据复制**:NameNode开始重新复制这些数据块到其他健康节点。

- **数据块恢复**:当数据块在其他节点上复制完成,系统会更新文件系统的元数据,使得坏块被新的副本替换。

- **状态更新**:故障的DataNode重新上线后,会标记为健康,并根据需要将其上其他数据块的副本数量补充到正常水平。

故障转移是一个复杂的过程,需要考虑数据块的重新分布、网络负载、节点资源利用等多方面因素。一个良好的故障转移机制,能够最小化系统故障对于数据服务的影响。

在下一章节中,我们将深入讨论如何在实际环境中配置和操作故障转移,确保你的HDFS部署具备自动应对故障的能力。

# 3. 故障转移的实践操作

## 3.1 配置DataNode故障转移

### 3.1.1 关键配置参数解读

在Hadoop的配置文件`hdfs-site.xml`中,有许多关键的配置参数控制着DataNode的故障转移行为。理解这些配置参数对于优化故障转移过程至关重要。以下是一些关键的配置参数:

- `dfs.namenode.name.dir`: 指定NameNode中命名空间镜像和编辑日志的本地存储路径。这些文件是故障转移时用于恢复的关键数据。

- `dfs.datanode.data.dir`: 设置DataNode存储数据块的本地目录。

- `dfs.ha.fencing.methods`: 在故障转移期间,用于确保旧的活

0

0