Python强化学习基础:构建智能决策模型的初学者指南

发布时间: 2024-09-19 16:52:04 阅读量: 35 订阅数: 61

机器学习实践-案例应用解析-Python机器学习-Python机器学习及实践

# 1. 强化学习和智能决策模型概述

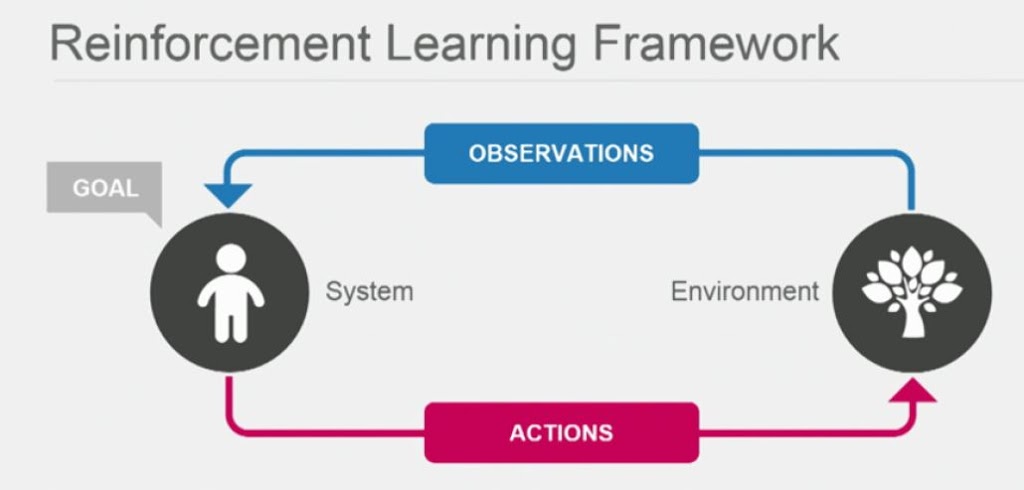

在人工智能领域,强化学习作为一种机器学习方法,是近年来研究的热点。它模仿了人类的学习过程,通过与环境的互动来实现智能决策。通过最大化累积奖励,智能体(agent)能够学会在特定环境中执行各种任务。

## 理解智能决策的挑战

智能决策模型的构建涉及许多挑战,尤其是在不确定性环境下的决策。强化学习通过奖励系统和惩罚机制,使智能体能够探索并利用环境,优化决策过程。

## 强化学习的应用领域

强化学习广泛应用于游戏AI、自动驾驶、机器人技术和推荐系统等领域。在这些应用中,智能体需要在复杂的环境中进行实时决策,而强化学习恰好提供了这样的学习框架。

# 2. 强化学习的理论基础

强化学习是机器学习的一个重要分支,它关注的是如何让机器通过与环境的交互来实现特定任务的目标。强化学习算法通常涉及到一个智能体(agent),智能体在一个环境中采取行动,并根据行动的结果得到反馈(奖励或惩罚)。智能体的目标是通过学习最大化其长期累计奖励。

### 2.1 马尔可夫决策过程(MDP)

#### 2.1.1 MDP的基本概念

马尔可夫决策过程(Markov Decision Process,MDP)是强化学习中最常用的数学框架之一。MDP提供了一种描述决策者(智能体)与环境交互的方式,并将过程建模为一系列状态、行动和奖励。

- **状态(State)**:环境在某一时刻的描述。

- **行动(Action)**:智能体在给定状态下可执行的动作。

- **转移概率(Transition Probability)**:从一个状态转移到另一个状态的概率。

- **奖励函数(Reward Function)**:在某个状态下执行某个行动后得到的即时奖励。

- **策略(Policy)**:一个从状态到行动的映射,是智能体在每个状态下选择行动的规则。

#### 2.1.2 奖励函数与价值函数

在MDP中,奖励函数和价值函数是评估行动好坏的两个关键概念。

- **奖励函数**:定义了智能体从环境中得到的即时反馈。它是一个数学期望,量化了在特定状态下执行特定行动所带来的即时奖励。

- **价值函数**:用于评估状态或状态-行动对的长期价值,它代表了智能体从当前状态出发,遵循某个策略,预期能获得的总奖励。

一个策略的价值函数Vπ(s)可以通过贝尔曼方程递归地定义,它表示从状态s开始,遵循策略π,预期得到的累积奖励。类似地,状态-行动价值函数Qπ(s, a)表示从状态s执行行动a开始,遵循策略π,预期得到的累积奖励。

```markdown

状态价值函数贝尔曼期望方程:

V(s) = Σ[a] Σ[s'] P(s'|s,a) [R(s,a,s') + γ V(s')]

```

其中P(s'|s,a)表示在状态s采取行动a转移到状态s'的概率,R(s,a,s')是在状态s采取行动a转移到状态s'的即时奖励,γ是折扣因子。

### 2.2 强化学习中的策略与算法

#### 2.2.1 策略评估和改进

策略评估是强化学习中的一个关键步骤,它涉及评估给定策略的价值函数。策略评估可以通过迭代计算贝尔曼期望方程来完成,直到收敛。

- **策略改进**:通过评估过程发现当前策略存在的缺点,进而改进策略,使得价值函数得到提升。

#### 2.2.2 贪心策略与ε-贪心策略

在策略改进的过程中,我们通常需要考虑如何选择行动。贪心策略是在每个状态下都选择当前能带来最大即时价值的行动。然而,为了探索环境,通常会使用ε-贪心策略,即大多数时候采用贪心策略,但以较小的概率ε随机选择行动。

#### 2.2.3 Q学习与SARSA算法

Q学习和SARSA是两种常见的无模型(model-free)强化学习算法。

- **Q学习**:通过更新Q值函数来学习最优策略,Q值函数表示从状态s开始,采取行动a,并之后遵循最优策略的预期累积奖励。

```python

for each episode:

initialize state S

repeat (for each step of episode):

choose action A from S using policy derived from Q (e.g., epsilon-greedy)

take action A, observe reward R, and new state S'

Q(S, A) := Q(S, A) + α [R + γ max(Q(S', A')) - Q(S, A)]

S := S'

```

- **SARSA**:与Q学习类似,但SARSA是在线(on-policy)算法,它在更新Q值时使用的是学习过程中遵循的策略所选的行动。

### 2.3 模型学习与预测

#### 2.3.1 模型预测和模型学习的区别

模型预测指的是给定策略后,计算在该策略下的价值函数;模型学习则涉及学习预测环境动态的模型,从而可以用来规划未来的行为。

#### 2.3.2 预测模型的建立和验证

预测模型是指通过观察到的行动和奖励,来学习状态转移概率和奖励函数。一旦建立了预测模型,就可以使用诸如动态规划等方法进行规划。

```python

def model_learning(transitions):

# 假设transitions是从环境观察到的转移数据,每个元素形如(s, a, r, s')

# 初始化状态转移概率和奖励函数

P = defaultdict(lambda: defaultdict(lambda: 0.0))

R = defaultdict(lambda: defaultdict(lambda: 0.0))

# 更新状态转移概率和奖励函数

for (s, a, r, s_prime) in transitions:

P[s][a][s_prime] += 1

R[s][a] += r

# 将概率转换为分布

for a in actions:

for s in states:

total = float(sum(P[s][a].values()))

for s_prime in P[s][a]:

P[s][a][s_prime] /= total

return P, R

```

在这一过程中,模型学习的一个关键挑战是处理不确定性和不完整性数据。实际应用时,往往需要对模型学习结果进行验证和调整。

以上内容的详细解释和分析包含了强化学习中基础理论的核心,介绍了MDP的定义,奖励函数和价值函数的作用,以及几种常见的强化学习策略和算法。在接下来的章节中,我们将进一步探讨如何使用Python来实现这些理论,并通过实际案例来加深理解。

# 3. Python在强化学习中的应用

Python作为一种高级编程语言,因其简洁的语法、丰富的库支持以及在数据科学领域的广泛应用,已经成为强化学习社区的首选语言之一。在本章中,我们将详细介绍如何使用Python实现强化学习算法,以及如何利用现成的库来简化开发过程。

## 3.1 Python强化学习库简介

Python拥有众多强化学习相关的库,其中最为人熟知的是TensorFlow和OpenAI Gym。它们为研究者和开发者提供了强大的工具集,用于构建和测试强化学习模型。

### 3.1.1 使用TensorFlow实现深度强化学习

TensorFlow是一个由Google开源的深度学习框架,它不仅支持传统的深度学习模型构建,还能用于实现复杂的深度强化学习算法。TensorFlow的强大之处在于它的灵活性和可扩展性,可以轻松构建和部署模型。

#### TensorFlow中的强化学习实现

首先,要在TensorFlow中实现深度强化学习,需要安装TensorFlow库,并熟悉其基本操作。接着,可以通过以下步骤构建一个基于TensorFlow的深度Q网络(DQN):

```python

import tensorflow as tf

from tensorflow.keras import layers, models, optimizers

# 构建神经网络模型

class DQNModel(models.Model):

def __init__(self, num_actions):

super(DQNModel, self).__init__()

self.dense1 = layers.Dense(64, activation='relu')

self.dense2 = layers.Dense(64, activation='relu')

self.dense3 = layers.Dense(num_actions, activation='linear')

def call(self, x):

x = self.dense1(x)

x = self.dense2(x)

x = self.dense3(x)

return x

# 实例化模型

model = DQNModel(num_actions=2)

model.build(input_shape=(None, 4)) # 以4个输入特征为例

o

```

0

0