【K-means算法调参全攻略】:如何选择参数以优化聚类结果

发布时间: 2024-12-15 18:42:47 阅读量: 4 订阅数: 5

基于K-means算法的光伏曲线聚类研究 关键词:k-means 光伏聚类 聚类 参考文档:基于改进 K-means 聚

参考资源链接:[K-means聚类算法详解及应用](https://wenku.csdn.net/doc/2fg9jjg6qn?spm=1055.2635.3001.10343)

# 1. K-means算法基础介绍

在现代数据科学领域中,聚类分析是一种基本且重要的无监督学习方法,它主要用于将数据集中的样本划分为若干组,使得同一组内的样本具有较高的相似度,而不同组间的样本差异较大。K-means算法就是聚类分析中最为广泛使用的方法之一,它以简单、高效著称。

## 1.1 K-means算法核心思想

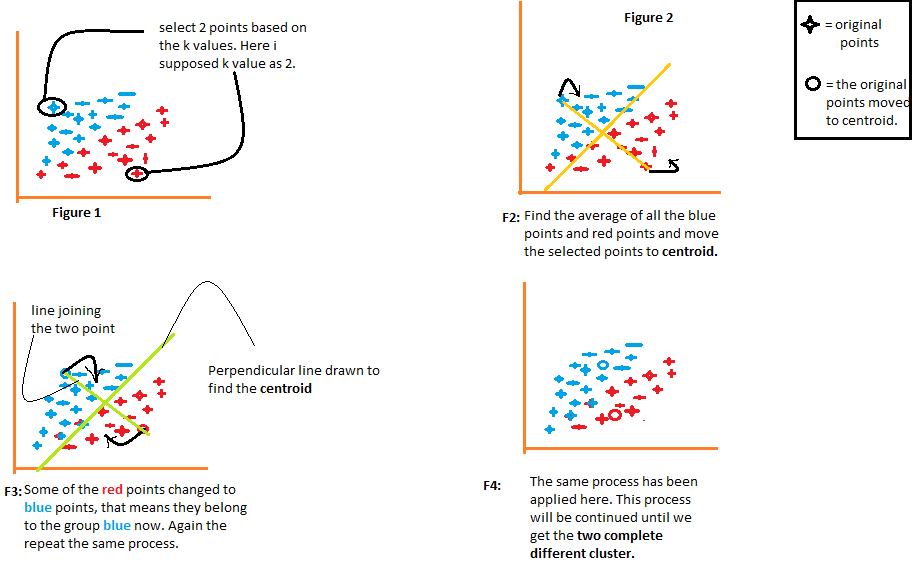

K-means的核心思想是“物以类聚”。该算法将数据点划分到K个簇中,使得每个数据点都属于距离最近的簇中心(质心)。算法的迭代过程就是不断调整簇中数据点的归属和质心的位置,直至达到收敛条件,比如质心位置不再变化或变化微小。

## 1.2 K-means算法的数学表达

数学上,K-means算法旨在最小化簇内平方和误差(SSE),即每个点到其簇中心的欧氏距离平方和。公式可以表示为:

```math

J = \sum_{j=1}^{k}\sum_{i=1}^{n_j} ||x_i - \mu_j||^2

```

其中,$x_i$是第i个数据点,$\mu_j$是第j个簇的中心点,$n_j$是第j个簇中数据点的数量,k是簇的数量。

## 1.3 K-means算法的应用场景

K-means算法因其计算效率高、易于理解和实现,被广泛应用于市场细分、社交网络分析、图像分割、天文数据分析等领域。不过,它也有局限性,例如对于非球形簇结构的适应性较差,且对噪声和离群点敏感。

通过本章的介绍,我们已经对K-means算法有了初步的了解。接下来的章节,我们将深入探讨其参数选择、优化策略和实际应用等更多细节。

# 2. ```

# 第二章:K-means算法参数详解

## 2.1 K值的选择

K-means算法的核心参数之一就是簇的数量K,选择不同的K值将直接影响聚类结果的质量。选择一个合适的K值是K-means算法的关键步骤,因为它直接影响到最终的聚类效果。

### 2.1.1 肘部法则

肘部法则是通过计算不同K值的成本函数(通常为簇内误差平方和)然后绘制出一个图表,图表中横坐标表示K值,纵坐标表示成本函数值。我们寻找一个“肘点”,即图中成本函数下降的速率开始减缓的位置。这个点就可以被视为合适的K值。

#### 示例代码

下面是一个使用Python和matplotlib库实现肘部法则的示例代码:

```python

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt

import numpy as np

# 假设已经有了一些数据X

X = np.array([[1, 2], [1, 4], [1, 0],

[10, 2], [10, 4], [10, 0]])

cost = []

for k in range(1, 6):

kmeans = KMeans(n_clusters=k).fit(X)

cost.append(sum(np.min(kmeans.cluster_centers_[kmeans.labels_]**2, axis=1)))

plt.plot(range(1, 6), cost, 'bx-')

plt.xlabel('k')

plt.ylabel('Cost')

plt.title('The Elbow Method showing the optimal k')

plt.show()

```

在这个例子中,我们尝试从K=1到K=5,并计算每个K值的成本函数值,然后绘制图表。图表中的“肘点”会帮助我们决定一个合理的K值。

### 2.1.2 手肘图分析

手肘图是肘部法则的可视化结果。在实际应用中,用户需要从图表中手动识别肘点,这依赖于用户对数据的了解程度和一定的主观判断。为了更精确地确定肘点,有时候还会使用一些数学计算方法辅助决策。

### 2.1.3 其他K值选择方法

除了肘部法则外,还可以使用轮廓系数、_gap_统计量等其他方法来选择最佳的K值。轮廓系数结合了聚类的凝聚度和分离度,而_gap_统计量则比较了实际数据集与假设的参照组之间的差异,可以帮助确定合适的聚类数目。

## 2.2 初始质心的确定

初始质心的选择是K-means算法运行过程中的另一重要环节,它决定了算法的收敛速度和最终的聚类结果。

### 2.2.1 随机选择

最简单的初始质心确定方法是随机选择数据点作为初始质心。这种方法的优点是简单快速,缺点是容易受到初始质心位置的随机性影响,可能会导致局部最优解。

#### 示例代码

```python

from sklearn.datasets import make_blobs

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt

# 生成数据集

X, _ = make_blobs(n_samples=300, centers=4, cluster_std=0.60, random_state=0)

# 使用随机初始质心的K-means

kmeans = KMeans(n_clusters=4, init='random', n_init=10)

kmeans.fit(X)

labels = kmeans.labels_

# 绘制结果

plt.scatter(X[:, 0], X[:, 1], c=labels, s=50, cmap='viridis')

plt.show()

```

### 2.2.2 K-means++算法

为了改善随机选择的缺陷,K-means++算法被提出来优化初始质心的选择。它通过一种智能的策略来选择初始质心,使得这些质心彼此之间的距离尽可能地远。

### 2.2.3 预先聚类方法

另一个策略是预先进行一个快速的聚类方法,例如使用层次聚类作为初始化的预聚类步骤。这种方法可以提供一个较为合理的初始质心集合,但它增加了算法的复杂度和计算时间。

## 2.3 迭代次数与收敛条件

K-means算法通过迭代地优化质心位置来最小化目标函数,因此迭代次数和收敛条件的设计对算法的性能有重要影响。

### 2.3.1 最大迭代次数的设定

为了防止算法无休止地运行,需要设置一个最大迭代次数。但设置过大可能会导致不必要的计算,过小可能会导致算法未能达到最优化。

### 2.3.2 收敛阈值的重要性

收敛阈值决定了何时停止算法的迭代。这个阈值可以是两次迭代质心位置的平均变化量,也可以是目标函数值的改变量。设置一个合适的收敛阈值可以提高算法的运行效率和聚类质量。

在本小节中,我们详细讨论了K-means算法中的K值选择、初始质心的确定以及迭代次数与收敛条件设置。这些参数的选择对K-means算法的性能和输出结果都有着显著的影响。因此,理解并适当调整这些参数是运用K-means算法时不可或缺的一个环节。

**注意**:以上内容章节是根据提供的目录框架生成的。实际的文章内容需要根据实际的数据集和应用场景进行详细的数据分析和实证研究。此外,本章节内容还需进一步丰富和扩展,以达到指定的字数要求。

```

# 3. K-means算法优化策略

K-means算法以其简单、快速的特点在聚类分析中广泛应用。然而,标准的K-means算法在面对复杂数据集时可能会遇到诸如初始质心选择不佳导致的局部最优问题、高维数据处理困难、计算效率不高等问题。因此,对算法进行优化成为提高聚类效果的关键。本章节将详细介绍K-means算法的几种优化策略,包括数据预处理、参数自适应方法以及高维数据处理技巧。

## 3.1 标准化与预处理

在应用K-means算法之前,对数据进行适当的预处理是非常必要的。预处理的主要目的是减少特征之间量纲的影响,同时提高聚类结果的稳定性和准确性。

### 3.1.1 数据标准化方法

数据标准化是聚类分析中常用的一种预处理技术。标准化的目的是将数据的特征缩放到一个标准的尺度上,使得每个特征对最终结果的贡献是平等的。常见的数据标准化方法包括Z-score标准化、Min-Max标准化等。

- **Z-score标准化**:通过减去均值并除以标准差,将数据转换为均值为0,标准差为1的分布。这种标准化方法对异常值敏感。

- **Min-Max标准化**:将数据线性变换到一个固定的范围,通常是[0,1]。这种标准化方法对异常值不敏感,但当存在极端值时,会压缩数据的动态范围。

下面是一个使用Python进行Z-score标准化的代码示例:

```python

import numpy as np

from sklearn

```

0

0