分布式进程管理:Kubernetes中的进程控制技术

发布时间: 2024-12-12 06:15:46 阅读量: 4 订阅数: 13

实操培训环节:Kubernetes 与微服务监控

# 1. 分布式进程管理基础

分布式进程管理是构建现代化可伸缩应用架构的关键。它允许开发者将单一进程拆分成多个分布式进程,这些进程可以在网络中的不同节点上运行。在这一章节中,我们将探讨分布式进程管理的一些核心概念。

## 分布式计算模型简介

分布式计算模型通过网络将计算任务分散到多个计算节点,提升系统的处理能力和弹性。例如,Google 的 Borg 和 Apache Hadoop 都是基于此模型。在这种模式下,进程不再是单打独斗,而是协同工作,构成一个复杂的系统。

## 进程间通信(IPC)机制

进程间通信(IPC)是分布式进程管理不可或缺的部分,它允许不同的进程交换信息和数据。IPC 可以通过多种方式实现,例如套接字编程、远程过程调用(RPC)以及消息队列等。选择合适的IPC 机制对于系统的性能和可靠性至关重要。

## 分布式进程的同步与一致性

同步是确保分布式进程正确协作的关键。在缺乏同步的情况下,进程可能会因为竞争条件而产生错误的结果。一致性协议如Raft或Paxos被广泛应用于分布式系统中,以维持数据状态的一致性。

通过这些基础概念的理解,我们可以为后续章节探讨Kubernetes的集群管理和资源控制打下坚实的基础。

# 2. Kubernetes架构解析

## 2.1 Kubernetes组件概述

### 2.1.1 Master节点组件

Kubernetes的Master节点承担着整个集群的控制和管理任务,关键组件包括API Server、Scheduler、Controller Manager以及etcd。

#### API Server

API Server是集群控制的入口点,所有的操作请求都通过API Server进行。它主要负责提供HTTP/HTTPS的RESTful API接口,以便集群内的所有组件进行通信。

#### Scheduler

Scheduler负责监控新创建的未分配到节点的Pods,然后为Pods选择合适的节点进行部署,这个过程称为调度。调度的决策依赖于资源需求、硬件/软件/策略限制、亲和性规范、数据位置等多个因素。

#### Controller Manager

Controller Manager运行控制器进程,包括Node Controller、Replication Controller、Endpoints Controller、Service Account & Token Controller等,负责集群的日常工作,如节点的健康检查、Pod复制、端点创建、安全控制等。

#### etcd

etcd是一个轻量级、分布式的键值存储系统,用于保存集群状态,如节点状态、Pod描述、PV、Secret等信息。由于其轻量和高性能的特性,使得etcd在分布式系统中被广泛使用。

### 2.1.2 Worker节点组件

Worker节点是运行应用容器的工作节点。核心组件包括Kubelet、Kube-Proxy和容器运行时。

#### Kubelet

Kubelet是集群中的代理,它运行在每个节点上,负责管理Pod以及容器的生命周期。它确保容器中的容器运行时都符合Pod Spec的要求,并且报告节点的状态信息到Master节点的API Server。

#### Kube-Proxy

Kube-Proxy负责在节点上维护网络规则,并且执行连接转发。它使用iptables规则或者IPVS(一种内核模块,用于负载均衡)来实现服务的访问和负载均衡。

#### 容器运行时

容器运行时是实际负责容器的创建和管理的底层软件,比如Docker、containerd、CRI-O等。

## 2.2 Kubernetes资源模型

### 2.2.1 Pod的设计和使用

Pod是Kubernetes中最小的调度单元,它封装了运行在容器中的应用程序。每个Pod包含一个或多个容器,以及这些容器运行时所必需的资源,如卷(volumes)、IP地址和运行选项。

#### Pod的关键特性

- **共享资源**:同一个Pod内的所有容器共享同一个网络命名空间和IPC命名空间,它们可以通过localhost进行通信。

- **生命周期**:Pod具有生命周期,可以被创建、调度到节点上,并且可以终止。

- **唯一性**:每个Pod都被赋予了IP地址,Pod内部的容器共享这个IP地址,并通过localhost进行通信。

#### Pod的使用案例

假设需要运行一个Web服务器和一个日志收集器,它们虽然功能不同,但需要共同工作。在这种情况下,可以把这两个容器放在一个Pod中运行。

### 2.2.2 控制器的角色和类型

控制器是管理Pod生命周期并确保Pod副本数量符合期望状态的运行时对象。

#### 控制器的功能

- **自我修复**:如果Pod失败或被删除,控制器可以自动启动新的Pod来替代。

- **扩展和收缩**:控制器可以根据负载自动扩展或收缩Pod的数量。

- **滚动更新**:控制器支持无缝的滚动更新,即逐步替换旧版本的Pod,以最小化更新过程中的中断时间。

#### 常见控制器类型

- **Deployment**:管理无状态应用,提供声明式的更新。

- **StatefulSet**:管理有状态应用,保证Pod的唯一性和持久化。

- **DaemonSet**:保证每个节点都运行特定Pod的副本,用于日志收集、监控等场景。

- **Job** 和 **CronJob**:控制一次性任务和定时任务。

## 2.3 Kubernetes网络模型

### 2.3.1 容器间通信原理

容器间的通信是通过Pod内部的IP地址进行的。同一个Pod内的容器共享网络命名空间,因此它们可以通过localhost通信。不同Pod之间的通信则涉及到网络插件,它负责配置和管理Pod网络。

#### CNI (Container Network Interface)

Kubernetes使用CNI插件来配置Pod网络。CNI插件包括Flannel、Weave Net、Calico等,每个插件都有自己的方式来分配IP地址,以及如何跨节点路由Pod的网络流量。

### 2.3.2 网络策略和服务发现机制

网络策略(Network Policies)是定义在Kubernetes集群中控制Pod间网络访问的规则。它们允许用户指定哪些Pod可以相互通信。

#### 网络策略的主要概念

- **Ingress**:定义从外部到Pod的访问规则。

- **Egress**:定义从Pod到外部的访问规则。

#### 服务发现机制

Kubernetes通过Service资源实现服务发现。Service是一组Pod的抽象,它定义了一个访问Pod的策略,通常通过一个固定的IP地址和DNS名称来实现。当Service创建时,它还会自动创建一个对应的Endpoint资源,包含所有对应的Pod IP。

#### 服务类型

- **ClusterIP**:在集群内部提供访问,不对外暴露。

- **NodePort**:在每个节点上暴露一个端口。

- **LoadBalancer**:使用云服务提供商的负载均衡器对外暴露。

- **ExternalName**:映射到外部的服务,通过CNAME记录实现。

```mermaid

graph LR

A[Pod] -->|内部通信| B[Pod]

A -->|外部通信| C[Service]

C -->|负载均衡| D[Endpoint]

D -->|NAT| E[NodePort]

E -->|外部负载均衡| F[LoadBalancer]

```

### 2.3.3 使用CNI插件实现网络策略

选择合适的CNI插件取决于具体的应用场景,比如网络隔离、安全性、性能要求等。

#### 配置网络策略

配置网络策略以限制Pod间通信:

```yaml

kind: NetworkPolicy

apiVersion: networking.k8s.io/v1

metadata:

name: example-policy

spec:

podSelector:

matchLabels:

role: db

policyTypes:

- Ingress

- Egress

ingress:

- from:

- podSelector:

matchLabels:

role: frontend

ports:

- protocol: TCP

port: 6379

egress:

- to:

- podSelector:

matchLabels:

role: cache

ports:

- protocol: TCP

port: 6379

```

本章节介绍了Kubernetes的核心组件和资源模型,涉及了Master节点和Worker节点的组件、Pod的设计和使用、控制器的角色和类型、网络模型、以及网络策略和服务发现机制。通过深入解析各组件的功能和内部交互流程,本章为读者提供了一个全面的Kubernetes架构概览。下一章将探讨Kubernetes进程控制技术,深入理解如何调度资源、管理Pod生命周期,以及实现集群的高可用性。

# 3. Kubernetes进程控制技术

在深入探讨Kubernetes进程控制技术之前,我们先来理解一下Kubernetes集群的基本操作和管理机制。进程控制技术是Kubernetes的核心特性之一,它确保了应用的高效运行和资源的合理分配。了解这些技术对构建稳定、可伸缩的分布式系统至关重要。

## 3.1 资源调度与分配

资源调度和分配是Kubernetes集群中最为重要的功能之一。集群需要决定在何处以及如何部署Pod,以满足性能、成本和资源利用等多方面的要求。Kubernetes使用调度器(kube-scheduler)来管理这一过程,它根据预设的规则和资源需求,将Pod调度到合适的节点上。

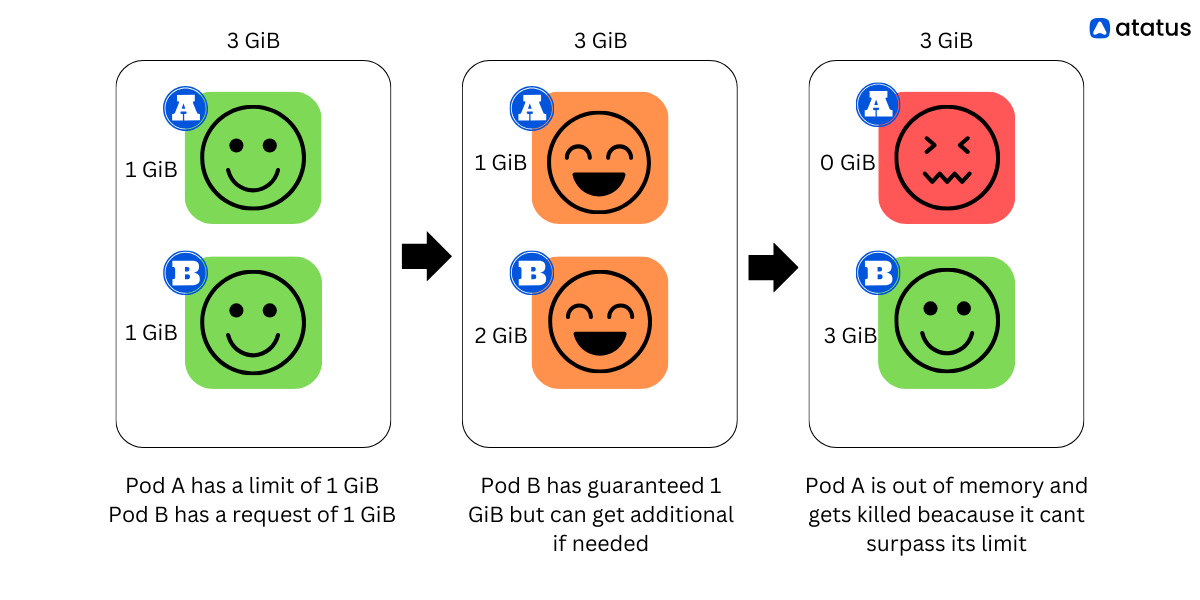

### 3.1.1 资源配额与限制

资源配额(Resource Quotas)和资源限制(Resource Limits)是Kubernetes用来控制命名空间中资源消耗的两个关键机制。资源配额可以限制命名空间中可以创建的资源类型和数量,而资源限制则是限制容器可以使用的计算资源的最大值。

通过配额,集群管理员能够防止资源被过度消耗,保持集群的正常运行。例如,限制CPU和内存的使用,可以避免资源密集型应用消耗过多的资源,影响其他应用的运行。

资源限制通常在Pod的定义文件中指定,例如:

```yaml

apiVersion: v1

kind: Pod

metadata:

name: resource-limits-pod

spec:

containers:

- name: test-container

image: k8s.gcr.io/e2e-test-images/agnhost:2.31

command: [ "/bin/sh", "-c", "--" ]

args: [ "while true; do sleep 1000; done;" ]

resources:

limits:

memory: "128Mi"

cpu: "500m"

requests:

memory: "64Mi"

cpu: "250m"

```

### 3.1.2 调度策略和优先级

调度策略是根据Pod的需求和节点的资源状态来决定Pod部署位置的规则。Kubernetes提供了多种调度策略,包括默认的调度器策略和可以扩展的调度器插件。调度策略确保了Pod按照预期的性能和需求被放置到最合适的节点上。

优先级机制则允许在多个Pod等待调度时,优先部署某些Pod。这可以通过为Pod配置优先级(PriorityClass)来实现。例如:

```yaml

apiVersion: scheduling.k8s.io/v1

kind: PriorityClass

metadata:

name: high-priority

value: 1000000

globalDefault: false

description: "This priority class should be used for high priority service pods."

```

当创建Pod时,通过在Pod定义中指定这个优先级类,就能确保Pod获得更高的调度优先级。

## 3.2 Pod生命周期管理

Pod作为Kubernetes中最小的部署单元,它的生命周期管理对保证服务的高可用性至关重要。生命周期管理涉及了Pod的启动、监控、停止及重启等一系列过程。

### 3.2.1 启动、停止和重启Pod

当Pod被调度到节点后,kubelet将负责启动容器,并监控它们的运行状态。如果Pod中

0

0