【数据分布与Map】:揭秘均匀分布数据提升性能的秘密武器

发布时间: 2024-10-31 21:35:50 阅读量: 26 订阅数: 25

svg map全国地图数据分布统计

# 1. 均匀分布数据与性能提升概述

在现代IT领域,数据处理是推动系统性能提升的关键因素之一。均匀分布数据,即数据在一定范围内按照统一的概率出现,是实现高效数据处理的基础。合理利用均匀分布数据不仅可以提高存储效率,还能在很大程度上优化计算和查询性能。

数据均匀分布对于性能的提升有着重要的作用,尤其是在并行计算、存储系统以及数据分析等方面。均匀分布的数据能够确保每个计算单元或存储节点负载均衡,避免因数据倾斜导致的性能瓶颈。

本章节将概述均匀分布数据的定义及其在性能提升中的关键作用,为后续章节深入探讨均匀分布数据的理论基础、在Map操作中的应用以及优化技巧奠定基础。

# 2. 均匀分布数据的理论基础

### 2.1 数据分布的概念与重要性

#### 2.1.1 数据分布的定义

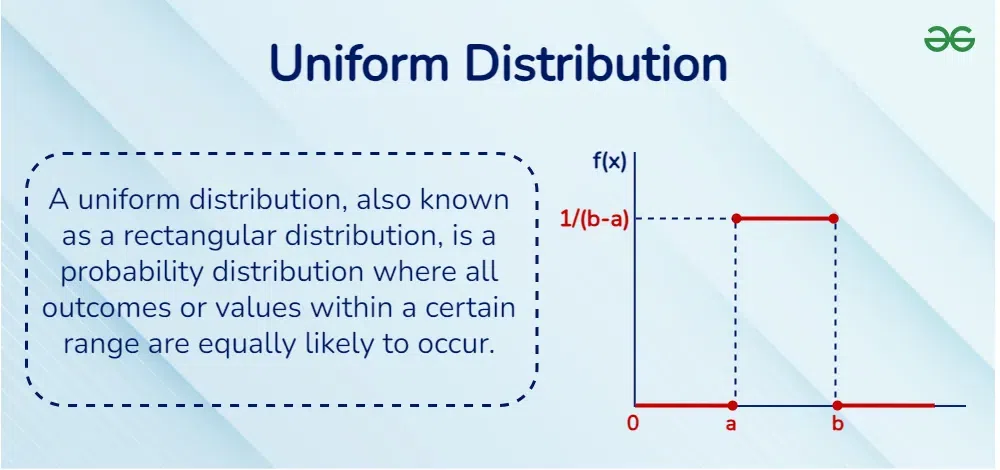

数据分布是统计学中的一个核心概念,指的是数据在一定范围内的分布规律与状态。数据分布的类型很多,均匀分布就是其中一种。在均匀分布中,数据在指定区间内出现的概率是恒定的,即每个子区间内数据出现的概率是相等的。从可视化角度来看,均匀分布数据在直方图中呈现出等高且等宽的柱状图形态。

理解数据分布的概念对于IT专业人士来说至关重要,因为它影响着数据处理、存储、传输和展示等多个方面。举例来说,在数据库查询优化中,数据分布情况直接决定了索引和查询效率;在数据采样中,数据分布的特性决定了采样策略和误差估计。

#### 2.1.2 数据均匀分布对性能的影响

均匀分布数据在计算机系统中极为重要,它能够优化计算资源的分配和使用,提升系统的整体性能。比如,在负载均衡的环境中,如果处理的数据服从均匀分布,那么可以相对容易地分配工作负载,减少系统热点和瓶颈的产生。均匀分布的数据也能改善缓存的命中率,因为在均匀分布的情况下,缓存的使用会更加平衡,不会出现某些数据集中访问而导致缓存频繁失效的问题。

此外,在一些计算密集型的任务中,均匀分布的数据可以提升并行计算效率,因为并行任务可以被均等地分配到各个计算节点上,最大化地利用计算资源。通过确保数据的均匀分布,系统设计者可以设计出更高效的算法和架构,从而提升整体的系统性能。

### 2.2 统计学中的均匀分布

#### 2.2.1 均匀分布的数学模型

在统计学中,均匀分布定义为一个连续概率分布,其概率密度函数(PDF)是一个常数。对于区间 [a, b] 上的均匀分布,其概率密度函数可以表示为:

```math

f(x) = 1 / (b - a) for a ≤ x ≤ b

= 0 otherwise

```

此函数表示在 [a, b] 区间内任意一点取值的概率是相同的,区间外的概率为零。该数学模型是理论分析和实际应用中构建均匀分布数据的基础。

#### 2.2.2 均匀分布的性质与应用场景

均匀分布的一个重要性质是它所有的统计参数(均值、方差等)都可以通过其定义区间直接计算得出。比如,对于均匀分布 U(a, b),其均值 μ 和方差 σ² 可以通过以下公式计算:

```math

μ = (a + b) / 2

σ² = (b - a)² / 12

```

均匀分布在多个领域内都有应用,例如在模拟和仿真中,常用于生成测试数据;在密码学中,均匀分布特性用于确保加密算法的随机性和安全性;在计算机图形学中,随机生成均匀分布的点可以用来创建平滑的视觉效果。均匀分布的应用场景非常广泛,理解其性质有助于在不同场景下应用这一特性。

### 2.3 均匀分布与计算机系统性能

#### 2.3.1 性能分析基础

性能分析是评估计算机系统运行效率和响应速度的过程。在进行性能分析时,数据分布的特性是重要考虑因素之一。均匀分布数据有利于性能分析的稳定性和可预测性。在测试系统性能时,使用均匀分布数据可以减少偶然因素对测试结果的影响,提供更准确的性能指标。

#### 2.3.2 均匀分布数据在存储系统中的作用

在存储系统设计中,均匀分布数据的概念可以用来优化数据的物理布局。通过确保数据的均匀分布,可以使得存储设备得到均衡使用,避免因访问热点而导致的设备过早磨损或性能瓶颈。例如,在构建 RAID (Redundant Array of Independent Disks) 阵列时,均匀分布数据能够提升磁盘的并行读写能力,从而提高整体的存储性能。

此外,均匀分布数据对存储系统的可靠性也有积极作用。均匀的读写负载使得每个存储单元的磨损程度保持一致,从而提升整个存储系统的使用寿命和数据安全。在实际应用中,这些优化措施是确保大型数据存储系统高性能和高可靠性的关键。

# 3. ```markdown

# 第三章:均匀分布数据在Map操作中的应用

## 3.1 Map操作与数据处理

### 3.1.1 Map操作简介

Map操作是数据处理框架中的核心概念之一,特别是在像Hadoop的MapReduce这样的批处理框架中。它指的是对输入数据集中的每个元素执行一个函数,将这个函数应用于每个元素,并输出新的键值对。这些键值对可以被进一步处理或直接用于排序和归约(Reduce)操作。在Map阶段,数据分布的均匀性对整个处理流程的性能有着重要的影响。均匀分布数据意味着每个Map任务将接收到等量或接近等量的数据量,这有助于充分利用集群的计算资源,并可以减少数据倾斜导致的性能瓶颈。

### 3.1.2 数据处理中的均匀分布原理

均匀分布原理在数据处理中的应用,主要体现在将数据集合理分配到不同的处理单元。如果数据均匀分布,那么可以期望每个Map任务在处理速度上相对一致,从而使得整个数据处理过程更加平滑。这避免了个别任务因为处理大量数据而成为瓶颈,导致整个作业的完成时间被延长。此外,均匀分布的数据也更容易进行并行化处理,因

```

0

0