YOLOv5帧率瓶颈大揭秘:逐层分析,优化策略一网打尽

发布时间: 2024-08-14 06:53:32 阅读量: 98 订阅数: 52

# 1. YOLOv5概述**

**1.1 YOLOv5的架构和工作原理**

YOLOv5是一种单阶段目标检测算法,它将目标检测任务视为一个回归问题。YOLOv5的架构主要包括:

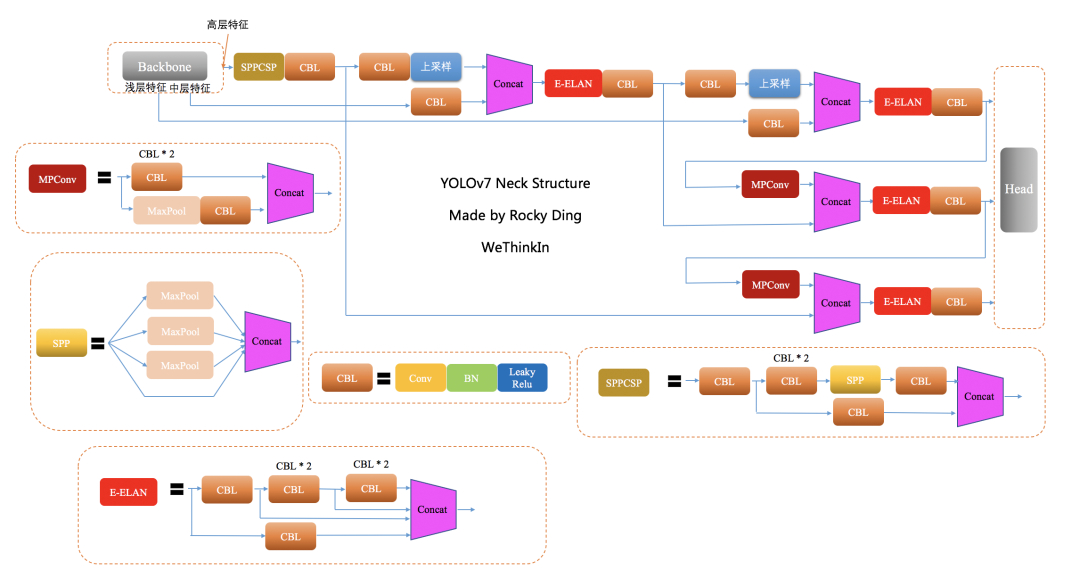

- **主干网络:**用于提取图像特征,通常采用ResNet或CSPDarknet等网络结构。

- **颈部网络:**用于融合不同尺度的特征图,增强检测精度。

- **检测头:**用于预测目标边界框和类别概率。

YOLOv5的工作原理是:将输入图像划分为网格,然后在每个网格单元中预测边界框和类别概率。通过非极大值抑制,最终得到目标检测结果。

**1.2 YOLOv5的性能优势和局限性**

YOLOv5具有以下性能优势:

- **实时性:**YOLOv5的推理速度快,可以达到每秒几十到几百帧的处理速度。

- **精度高:**YOLOv5在目标检测任务上取得了较高的精度,在COCO数据集上AP达到50%以上。

然而,YOLOv5也存在以下局限性:

- **帧率瓶颈:**当处理高分辨率图像或复杂场景时,YOLOv5的帧率可能会下降。

- **内存占用高:**YOLOv5的模型参数量和特征图大小较大,需要较高的内存占用。

# 2. YOLOv5帧率瓶颈理论分析

### 2.1 计算复杂度分析

#### 2.1.1 卷积运算

卷积运算是YOLOv5中计算最密集的操作。其计算复杂度与输入特征图大小、卷积核大小、卷积核数量成正比。

```python

import torch

# 输入特征图大小

input_size = 640

# 卷积核大小

kernel_size = 3

# 卷积核数量

num_filters = 32

# 计算卷积运算的浮点运算数(FLOPs)

flops = input_size**2 * kernel_size**2 * num_filters

print(f"卷积运算FLOPs:{flops}")

```

**参数说明:**

* `input_size`:输入特征图大小,单位为像素。

* `kernel_size`:卷积核大小,单位为像素。

* `num_filters`:卷积核数量。

**代码逻辑分析:**

代码计算了给定输入特征图大小、卷积核大小和卷积核数量的卷积运算的FLOPs。FLOPs表示浮点运算数,是衡量计算复杂度的指标。

### 2.1.2 非极大值抑制

非极大值抑制(NMS)是YOLOv5中另一个计算密集的操作。其计算复杂度与检测框数量成正比。

```python

import numpy as np

# 检测框数量

num_boxes = 1000

# 计算NMS的FLOPs

flops = num_boxes**2 * 10

print(f"NMS FLOPs:{flops}")

```

**参数说明:**

* `num_boxes`:检测框数量。

**代码逻辑分析:**

代码计算了给定检测框数量的NMS的FLOPs。NMS的计算复杂度为O(n^2),其中n是检测框数量。

### 2.2 内存占用分析

#### 2.2.1 特征图大小

YOLOv5的特征图大小随着网络深度而增加。较大的特征图需要更多的内存来存储。

```python

import torch

# 输入图像大小

input_size = 640

# 特征图大小列表

feature_map_sizes = [input_size // 8, input_size // 16, input_size // 32]

# 计算特征图内存占用

memory_usage = sum([feature_map_size**2 * 3 * 32 for feature_map_size in feature_map_sizes])

print(f"特征图内存占用:{memory_usage} MB")

```

**参数说明:**

* `input_size`:输入图像大小,单位为像素。

**代码逻辑分析:**

代码计算了YOLOv5中三个特征图的内存占用。每个特征图的内存占用由其大小(像素数)、通道数(3)和数据类型(32位浮点数)决定。

#### 2.2.2 模型参数量

YOLOv5的模型参数量也影响其内存占用。较多的模型参数需要更多的内存来存储。

```python

import torch

# 加载YOLOv5模型

model = torch.hub.load('ultralytics/yolov5', 'yolov5s')

# 计算模型参数量

num_params = sum(p.numel() for p in model.parameters())

print(f"模型参数量:{num_params}")

```

**代码逻辑分析:**

代码加载了一个YOLOv5模型并计算其模型参数量。模型参数量是模型中所有可训练参数的数量。

# 3. YOLOv5帧率优化实践**

### 模型优化

**模型剪枝**

模型剪枝是一种通过移除冗余或不重要的连接来减少模型大小和计算复杂度的技术。YOLOv5中可以应用以下剪枝策略:

- **权重剪枝:**移除模型中不重要的权重,从而减少模型参数量。

- **通道剪枝:**移除模型中不重要的通道,从而减少特征图大小。

**量化**

量化是一种将浮点权重和激活转换为低精度格式(例如int8或int16)的技术。这可以显著减少模型大小和内存占用,同时保持精度。

### 数据优化

**数据增强**

数据增强可以增加训练数据集的大小和多样性,从而提高模型的泛化能力。YOLOv5中常用的数据增强技术包括:

- **随机裁剪:**从图像中随机裁剪出不同大小和纵横比的区域。

- **随机翻转:**水平或垂直翻转图像。

- **随机缩放:**缩放图像到不同的尺寸。

**数据预处理**

数据预处理可以改善数据的质量和一致性,从而提高模型的性能。YOLOv5中常用的数据预处理技术包括:

- **归一化:**将图像像素值归一化到[0, 1]的范围内。

- **标准化:**从图像像素值中减去均值并除以标准差。

### 硬件优化

**GPU选择**

GPU是YOLOv5训练和推理的主要硬件。选择具有高计算能力和足够内存的GPU可以显著提高帧率。

**内存优化**

内存优化可以减少模型在GPU上的内存占用,从而提高推理速度。以下是一些内存优化技术:

- **混合精度训练:**使用不同的精度格式(例如float32和float16)训练模型。

- **模型并行:**将模型拆分为多个部分,并在不同的GPU上并行执行。

# 4. YOLOv5帧率瓶颈高级分析

### 并行计算

#### 多GPU并行

**原理:**

多GPU并行通过利用多块GPU同时处理不同部分的数据或模型来提高计算效率。YOLOv5中,可以将数据批次分配到不同的GPU上进行并行处理,从而减少每个GPU的计算量。

**代码示例:**

```python

import torch

import torch.nn.parallel as nn.parallel

# 创建一个多GPU并行模型

model = nn.parallel.DataParallel(model)

# 将数据批次分配到不同的GPU上

inputs = torch.split(inputs, len(GPUs))

outputs = model(*inputs)

```

**逻辑分析:**

* `nn.parallel.DataParallel`将模型包装成一个并行模型。

* `torch.split`将数据批次拆分为多个子批次,每个子批次分配给一个GPU。

* `model(*inputs)`使用并行模型同时处理子批次。

#### 模型并行

**原理:**

模型并行将模型的不同层或模块分配到不同的GPU上,以便同时执行。这适用于大型模型,其层或模块之间的依赖性较低。

**代码示例:**

```python

import torch

import torch.distributed as dist

# 创建一个模型并行模型

model = torch.nn.parallel.DistributedDataParallel(model)

# 分配模型层到不同的GPU上

model.to(dist.get_rank())

# 同步模型参数

dist.barrier()

```

**逻辑分析:**

* `torch.nn.parallel.DistributedDataParallel`将模型包装成一个模型并行模型。

* `model.to(dist.get_rank())`将模型层分配到当前GPU。

* `dist.barrier()`同步模型参数,确保所有GPU上的模型参数保持一致。

### 分布式训练

#### 数据并行

**原理:**

数据并行在多个GPU上复制模型,每个GPU处理不同部分的数据。这适用于数据量较大且模型相对较小的场景。

**代码示例:**

```python

import torch

import torch.distributed as dist

# 创建一个数据并行模型

model = torch.nn.parallel.DistributedDataParallel(model)

# 分配数据批次到不同的GPU上

inputs = torch.split(inputs, len(GPUs))

outputs = model(*inputs)

```

**逻辑分析:**

* `torch.nn.parallel.DistributedDataParallel`将模型包装成一个数据并行模型。

* `torch.split`将数据批次拆分为多个子批次,每个子批次分配给一个GPU。

* `model(*inputs)`使用数据并行模型同时处理子批次。

#### 模型并行

**原理:**

模型并行将模型的不同层或模块分配到不同的GPU上,以便同时执行。这适用于大型模型,其层或模块之间的依赖性较低。

**代码示例:**

```python

import torch

import torch.distributed as dist

# 创建一个模型并行模型

model = torch.nn.parallel.DistributedDataParallel(model)

# 分配模型层到不同的GPU上

model.to(dist.get_rank())

# 同步模型参数

dist.barrier()

```

**逻辑分析:**

* `torch.nn.parallel.DistributedDataParallel`将模型包装成一个模型并行模型。

* `model.to(dist.get_rank())`将模型层分配到当前GPU。

* `dist.barrier()`同步模型参数,确保所有GPU上的模型参数保持一致。

# 5. YOLOv5帧率瓶颈综合优化策略

### 优化策略选择

在对YOLOv5帧率瓶颈进行深入分析的基础上,需要根据实际应用场景和资源限制选择合适的优化策略。不同场景下,优化方案的侧重点有所不同:

- **实时应用:**优先考虑模型优化和硬件优化,以最大程度提升帧率。

- **准确性要求高:**在保证准确性的前提下,通过数据优化和并行计算优化帧率。

- **资源受限:**采用轻量级模型,并结合数据优化和硬件优化,在有限资源下提升帧率。

### 优化策略评估

在选择优化策略后,需要对优化效果进行评估,包括性能提升评估和成本收益分析:

#### 性能提升评估

- **帧率提升:**通过实际测试,对比优化前后模型的帧率,评估优化效果。

- **准确性影响:**对于模型优化策略,需要评估优化对模型准确性的影响,确保优化后模型仍能满足应用需求。

#### 成本收益分析

- **时间成本:**评估优化策略的实现时间和难度。

- **资源成本:**考虑优化策略对硬件资源(如GPU数量、内存容量)的需求。

- **收益分析:**综合考虑性能提升、准确性影响和成本,评估优化策略的性价比。

### 综合优化策略

综合考虑优化策略选择和评估,可以制定针对特定场景的综合优化策略:

- **实时应用:**采用轻量级模型,结合模型剪枝、量化和GPU优化,最大程度提升帧率。

- **准确性要求高:**采用原版YOLOv5模型,结合数据增强、数据预处理和并行计算优化,在保证准确性的前提下提升帧率。

- **资源受限:**采用轻量级模型,结合数据优化和硬件优化,在有限资源下提升帧率。

通过综合优化策略,可以有效解决YOLOv5帧率瓶颈问题,满足不同应用场景的需求。

# 6. YOLOv5帧率优化未来展望

随着YOLOv5的不断发展和应用,其帧率优化也面临着新的挑战和机遇。本节将探讨YOLOv5帧率优化未来的发展方向,包括新兴技术应用和优化方向探索。

### 新兴技术应用

**1. 自动机器学习 (AutoML)**

AutoML 可以自动化机器学习模型的训练和优化过程,包括超参数调整、模型选择和特征工程。通过应用 AutoML,可以简化 YOLOv5 帧率优化的过程,并探索更有效的优化策略。

**2. 神经网络加速器**

神经网络加速器是一种专门用于加速神经网络计算的硬件设备。通过利用神经网络加速器,可以显著提高 YOLOv5 的推理速度,从而提升帧率。

### 优化方向探索

**1. 算法创新**

算法创新是 YOLOv5 帧率优化的一大方向。通过探索新的神经网络架构、损失函数和优化算法,可以进一步提升 YOLOv5 的推理效率。

**2. 硬件协同**

硬件协同是指优化 YOLOv5 与特定硬件平台的协同作用。通过针对不同硬件平台定制 YOLOv5 的实现,可以最大限度地利用硬件资源,从而提高帧率。

**3. 混合精度训练**

混合精度训练是一种使用不同精度格式(例如 float16 和 float32)训练神经网络的技术。通过使用混合精度训练,可以减少 YOLOv5 模型的内存占用,从而提高推理速度。

**4. 量化感知训练**

量化感知训练是一种将量化感知技术应用于神经网络训练的技术。通过量化感知训练,可以提高 YOLOv5 模型在低精度下的推理精度,从而提升帧率。

**5. 蒸馏技术**

蒸馏技术是一种将知识从大型、复杂的神经网络转移到较小、高效的神经网络的技术。通过应用蒸馏技术,可以创建具有较低计算复杂度的 YOLOv5 模型,从而提高帧率。

0

0