揭秘FastText:文本表示的革命,助你解锁NLP新天地

发布时间: 2024-08-20 10:21:54 阅读量: 24 订阅数: 34

# 1. FastText简介**

FastText是一种先进的词嵌入模型,由Facebook AI Research团队开发。它通过将单词的子词信息纳入考虑,有效地捕获了单词的语义和语法信息。FastText在自然语言处理任务中表现出色,包括文本分类、情感分析和文本相似度计算。

FastText的优势在于它可以有效处理多语言文本,并支持句法分析和依存关系解析等更高级的自然语言处理任务。此外,FastText的训练速度快,易于使用,使其成为自然语言处理从业者的理想选择。

# 2. FastText原理与模型架构

### 2.1 词嵌入的原理与优势

词嵌入是一种将单词映射到低维向量空间的技术,它可以捕获单词之间的语义和语法关系。与传统的one-hot编码相比,词嵌入具有以下优势:

- **语义相似性:**词嵌入向量可以反映单词之间的语义相似性,相似的单词具有相似的向量表示。

- **维度压缩:**词嵌入将单词映射到低维空间,大大减少了数据维度,提高了模型训练和推理的效率。

- **泛化能力:**词嵌入可以学习单词的上下文信息,即使是未在训练集中出现的单词也可以通过上下文推断出其向量表示。

### 2.2 FastText词嵌入模型的结构

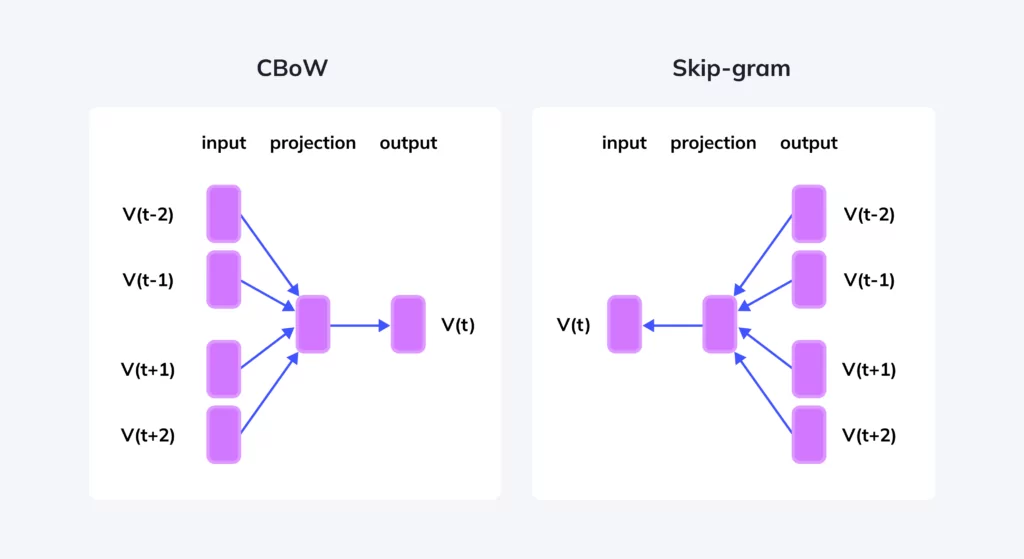

FastText是一个基于神经网络的词嵌入模型,它结合了CBOW(连续词袋)和Skip-gram模型的优点。

#### 2.2.1 CBOW模型

CBOW模型通过预测给定上下文单词序列中的目标单词来学习词嵌入。其结构如下:

```

Input: [w1, w2, ..., wn]

Output: w

```

其中,[w1, w2, ..., wn]是目标单词w的上下文单词序列。CBOW模型通过最大化目标单词w的条件概率来训练:

```

P(w | w1, w2, ..., wn) = softmax(W' * (v1 + v2 + ... + vn))

```

其中,W'是权重矩阵,v1, v2, ..., vn是上下文单词的词嵌入向量。

#### 2.2.2 Skip-gram模型

Skip-gram模型通过预测给定目标单词的上下文单词序列来学习词嵌入。其结构如下:

```

Input: w

Output: [w1, w2, ..., wn]

```

其中,w是目标单词,[w1, w2, ..., wn]是w的上下文单词序列。Skip-gram模型通过最大化上下文单词序列的条件概率来训练:

```

P(w1, w2, ..., wn | w) = softmax(W * v)

```

其中,W是权重矩阵,v是目标单词w的词嵌入向量。

FastText模型将CBOW和Skip-gram模型结合起来,同时预测目标单词和上下文单词,从而学习到更加丰富的词嵌入。

# 3.1 文本分类与情感分析

#### 3.1.1 文本分类的基本原理

文本分类是自然语言处理中一项基本任务,其目的是将文本文档自动分配到预定义的类别中。文本分类的原理主要基于特征提取和分类算法两方面。

首先,需要从文本文档中提取出能够代表其内容的特征。这些特征可以是词频、词共现、语法结构等。特征提取完成后,需要使用分类算法对这些特征进行建模,从而将文本文档分配到不同的类别中。

#### 3.1.2 FastText在文本分类中的应用

FastText词嵌入模型可以有效地用于文本分类任务。FastText通过将单词表示为向量,可以捕捉单词之间的语义和语法信息。这些向量作为文本分类模型的输入特征,能够提高模型的分类精度。

**代码示例:**

```python

import fasttext

# 训练文本分类模型

model = fasttext.train_supervised(input="train.txt", label="__label__")

# 对新文本进行分类

label = model.predict("新文本")

```

**参数说明:**

* `input`: 训练数据的路径,其中每一行包含一个文本文档和其对应的类别标签。

* `label`: 类别标签的前缀,用于区分文本文档和类别标签。

* `predict`: 需要分类的新文本。

**逻辑分析:**

该代码首先使用`train_supervised`函数训练一个FastText文本分类模型。该函数将文本文档和类别标签作为输入,并训练一个能够将文本文档分类到不同类别的模型。训练完成后,可以使用`predict`函数对新文本进行分类,并返回其预测的类别标签。

### 3.2 文本相似度计算

#### 3.2.1 文本相似度度量方法

文本相似度计算是衡量两个文本文档之间相似程度的任务。文本相似度度量方法有多种,包括余弦相似度、欧几里得距离、杰卡德相似系数等。

#### 3.2.2 FastText在文本相似度计算中的应用

FastText词嵌入模型可以通过计算两个文本文档中单词向量的相似度来计算文本相似度。FastText单词向量能够捕捉单词之间的语义和语法信息,因此可以有效地度量文本之间的相似程度。

**代码示例:**

```python

import fasttext

# 加载FastText模型

model = fasttext.load_model("model.bin")

# 计算两个文本的相似度

similarity = model.cosine_similarity("文本1", "文本2")

```

**参数说明:**

* `model`: 加载的FastText模型。

* `cosine_similarity`: 计算文本相似度的函数,使用余弦相似度方法。

* `文本1`, `文本2`: 需要计算相似度的两个文本。

**逻辑分析:**

该代码首先加载一个预训练的FastText模型。然后,使用`cosine_similarity`函数计算两个文本的相似度。该函数将两个文本的单词向量转换为余弦相似度,表示两个文本之间的相似程度。余弦相似度取值范围为[-1, 1],其中1表示完全相似,-1表示完全不相似。

# 4. FastText进阶应用

### 4.1 多语言文本处理

#### 4.1.1 FastText对多语言文本的支持

FastText模型具有强大的多语言文本处理能力,支持多种语言的词嵌入训练。其通过以下方式实现多语言文本处理:

- **子词模型:** FastText采用子词模型,将单词分解为更小的子词单位,从而可以处理不同语言中具有相似子词结构的单词。

- **语言标识符:** 在训练多语言模型时,FastText会为每个语言添加一个语言标识符,以区分不同语言的单词。

- **共享词向量:** 对于不同语言中具有相同语义的单词,FastText会共享它们的词向量,从而提高模型的泛化能力。

#### 4.1.2 多语言文本处理的应用场景

FastText的多语言文本处理能力在以下应用场景中发挥着重要作用:

- **机器翻译:** FastText可以为不同语言的单词提供语义相似的词向量,从而提高机器翻译模型的质量。

- **跨语言信息检索:** FastText可以帮助用户在不同语言的文档中检索相关信息,突破语言障碍。

- **多语言文本分类:** FastText可以训练多语言文本分类模型,对来自不同语言的文本进行分类。

### 4.2 句法分析与依存关系解析

#### 4.2.1 句法分析与依存关系解析的概念

**句法分析**是指识别句子中的词性、短语和句子成分,并建立它们的语法关系。**依存关系解析**是句法分析的细化,它分析句子中单词之间的依存关系,建立依存树结构。

#### 4.2.2 FastText在句法分析中的应用

FastText可以应用于句法分析和依存关系解析任务。其通过以下方式实现:

- **词性标注:** FastText可以训练词性标注模型,为句子中的单词分配词性标签。

- **依存关系解析:** FastText可以训练依存关系解析模型,识别句子中单词之间的依存关系,并构建依存树结构。

FastText在句法分析中的应用可以提高自然语言处理任务的准确性,例如:

- **机器翻译:** 句法分析可以帮助机器翻译模型理解句子的结构,从而生成更准确的翻译。

- **文本摘要:** 句法分析可以帮助文本摘要模型识别句子中的重要信息,从而生成更简洁、更具可读性的摘要。

- **问答系统:** 句法分析可以帮助问答系统理解用户的问题,并从文档中提取准确的答案。

# 5.1 模型超参数的优化

### 5.1.1 窗口大小

窗口大小是FastText模型的一个重要超参数,它决定了模型在训练过程中考虑的上下文单词范围。较大的窗口大小可以捕获更丰富的上下文信息,但也会增加计算成本。一般情况下,窗口大小设置为2-5比较合适。

```python

# 设置窗口大小

model = FastText(window=3)

```

### 5.1.2 词向量维度

词向量维度决定了词向量的维度,即每个词在向量空间中的表示长度。较高的词向量维度可以表示更丰富的语义信息,但也会增加模型的复杂度。一般情况下,词向量维度设置为100-300比较合适。

```python

# 设置词向量维度

model = FastText(vector_size=100)

```

### 5.1.3 负采样

负采样是一种优化FastText训练过程的技术。在负采样中,模型在训练过程中只考虑一小部分负样本,而不是所有可能的负样本。这可以显著提高训练速度,同时保持模型的准确性。

```python

# 设置负采样

model = FastText(negative=5)

```

0

0