【Python预测模型构建全记录】:最佳实践与技巧详解

发布时间: 2024-11-25 02:44:07 阅读量: 39 订阅数: 31

基于freeRTOS和STM32F103x的手机远程控制浴室温度系统设计源码

# 1. Python预测模型基础

Python作为一门多功能的编程语言,在数据科学和机器学习领域表现得尤为出色。预测模型是机器学习的核心应用之一,它通过分析历史数据来预测未来的趋势或事件。本章将简要介绍预测模型的概念,并强调Python在这一领域中的作用。

## 1.1 预测模型概念

预测模型是一种统计模型,它利用历史数据来预测未来事件的可能性。这些模型在金融、市场营销、医疗保健和其他行业中有着广泛的应用。

## 1.2 Python在预测建模中的地位

Python之所以在预测模型构建中备受青睐,是因为其拥有一系列成熟的库和框架,如Scikit-learn、TensorFlow、Keras、XGBoost等,这些工具为数据科学家提供了强大的分析和模型训练能力。

## 1.3 Python预测模型的基本步骤

构建Python预测模型一般遵循以下基本步骤:

- **数据收集与预处理**:获取并清洗数据,处理缺失值和异常值。

- **特征工程**:选择和提取有助于模型预测的特征。

- **模型构建与训练**:使用适当的数据集划分技术,训练并优化模型。

- **模型评估与选择**:评估模型性能并选择最佳模型。

- **模型部署与监控**:将模型部署到生产环境并持续监控其性能。

通过本章的介绍,我们为构建预测模型打下了基础,接下来的章节将深入探讨如何实施这些步骤,构建出稳健且预测性能优异的模型。

# 2. 预测模型的数据预处理

在构建预测模型之前,数据预处理是一个不可或缺的步骤。数据预处理的目的是确保数据的质量和一致性,使得模型能够从数据中学习到有效的特征。本章将详细介绍数据预处理的各个方面,包括数据收集与清洗、特征工程、数据集划分与标准化。

### 2.1 数据收集与清洗

#### 2.1.1 数据来源和获取方法

数据来源可以分为内部数据和外部数据。内部数据通常来源于公司自身的运营记录、客户交易历史等,而外部数据可能是公开数据集、市场研究报告等。获取数据的方法包括网络爬虫、公开API、购买数据服务等。在获取数据时,需要注意数据的版权问题和隐私问题,确保数据的合法性和合规性。

```python

# 示例代码:使用Python的requests库获取网页内容

import requests

from bs4 import BeautifulSoup

url = 'https://example.com/data'

response = requests.get(url)

soup = BeautifulSoup(response.content, 'html.parser')

# 解析网页并获取所需数据...

```

#### 2.1.2 缺失值处理和异常值分析

在数据集中,缺失值和异常值是常见的问题。缺失值可以通过填充(如平均值、中位数)或者删除来处理,而异常值需要根据数据的具体含义进行分析和处理。异常值可能是由于数据录入错误、测量误差等造成的,也可能是真实存在的极端情况。

```python

import pandas as pd

# 示例代码:使用Pandas处理缺失值

data = pd.read_csv('data.csv')

# 填充缺失值

data.fillna(data.mean(), inplace=True)

# 删除含有缺失值的行

data.dropna(inplace=True)

# 异常值处理

# 假设data中有一个数值列名为'feature'

# 使用Z-score方法检测异常值

from scipy import stats

import numpy as np

z_scores = np.abs(stats.zscore(data['feature']))

data = data[(z_scores < 3)] # 保留z-score小于3的数据点,通常认为是正常范围

```

### 2.2 特征工程

#### 2.2.1 特征选择方法

特征选择的目的是减少模型复杂度,提升模型性能,同时防止过拟合。特征选择方法包括单变量特征选择、递归特征消除、基于模型的特征选择等。单变量特征选择关注特征与目标变量之间的单变量统计测试,递归特征消除通过递归地考虑较小和较小的特征集来选择特征,而基于模型的特征选择则使用机器学习模型来评估特征的重要性。

```python

from sklearn.feature_selection import SelectKBest, f_classif

# 示例代码:使用SelectKBest进行特征选择

X = data.drop('target', axis=1)

y = data['target']

selector = SelectKBest(score_func=f_classif, k=5)

X_new = selector.fit_transform(X, y)

# 选择的特征索引

selected_features = data.columns[selector.get_support(indices=True)]

```

#### 2.2.2 特征提取技术

特征提取技术通常用于将原始数据转换为适合机器学习模型的格式。这包括主成分分析(PCA)、线性判别分析(LDA)和t分布随机邻域嵌入(t-SNE)等方法。PCA通过正交变换将可能相关的变量转换为线性无关的变量,LDA用于特征空间的线性分割,而t-SNE则是一种非线性降维技术。

```python

from sklearn.decomposition import PCA

# 示例代码:使用PCA进行特征提取

pca = PCA(n_components=2)

X_pca = pca.fit_transform(X)

# 展示主成分

print(pca.components_)

```

### 2.3 数据集划分与标准化

#### 2.3.1 训练集与测试集的划分

划分数据集是将数据分为训练集和测试集两个部分,训练集用于模型训练,测试集用于模型评估。划分数据集常用的方法有简单随机划分、分层采样等。分层采样尤其适用于分类问题,确保训练集和测试集中各类别的比例大致相同。

```python

from sklearn.model_selection import train_test_split

# 示例代码:划分数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

```

#### 2.3.2 数据标准化和归一化方法

标准化和归一化是常见的数据预处理步骤,目的是消除不同特征间的量纲影响。标准化方法包括Z-score标准化,它将数据的均值变为0,方差变为1。归一化方法如最小-最大归一化,将数据按比例缩放到一个特定范围,通常是[0, 1]。

```python

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 示例代码:使用StandardScaler进行标准化

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

# 使用MinMaxScaler进行归一化

min_max_scaler = MinMaxScaler()

X_train_normalized = min_max_scaler.fit_transform(X_train)

X_test_normalized = min_max_scaler.transform(X_test)

```

通过本章节的介绍,我们了解了数据预处理的重要性以及具体的操作方法。数据预处理是构建预测模型的基石,是影响模型性能的关键步骤之一。通过对数据的仔细处理,可以确保数据的质量,为后续的模型训练和评估打下坚实的基础。在实际应用中,应根据具体问题和数据集的特点,灵活运用不同的数据预处理技术。接下来的章节将介绍预测模型的构建与评估,以及如何应用机器学习库来提升模型的性能。

# 3. 模型构建与评估

在构建和评估预测模型的过程中,我们需要遵循一系列的方法论和技巧以确保最终模型的准确性和可靠性。本章节将深入讨论模型构建与评估的各个方面,包括对常用预测模型的介绍、模型训练与选择的策略,以及模型性能评估指标的运用。

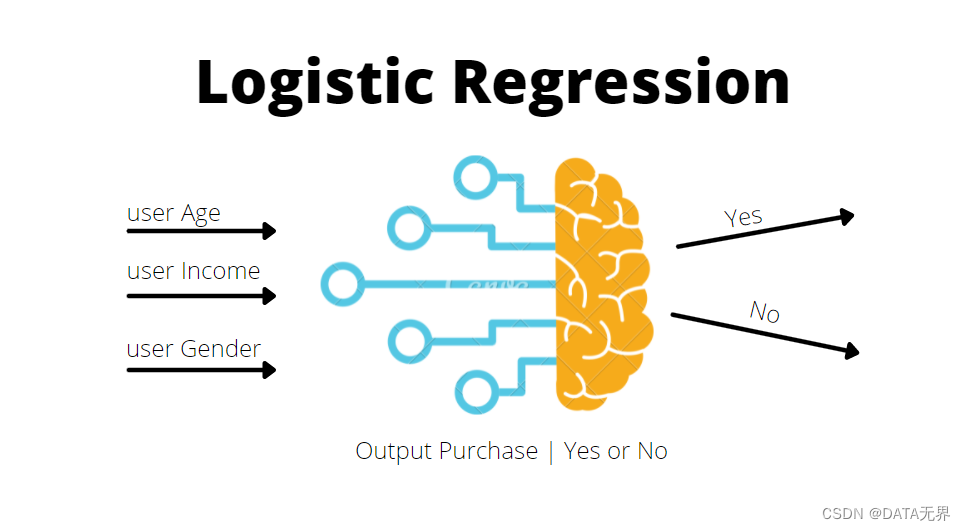

## 3.1 常用预测模型介绍

在预测模型构建的领域,多种算法和模型可用于解决不同类型的预测问题。了解各种模型的原理、优缺点和适用场景,是进行预测分析的基础。

### 3.1.1 线性回归模型

线性回归是预测分析中最基础也是应用最广泛的模型之一,它假定因变量与自变量之间存在线性关系。其模型表达式通常为:

```

y = β0 + β1x1 + β2x2 + ... + βnxn + ε

```

其中,`y` 是因变量,`x1, x2, ..., xn` 是自变量,`β0, β1, ..., βn` 是模型参数,`ε` 是误差项。

在Python中,线性回归模型可以通过Scikit-learn库中的`LinearRegression`类来实现:

```python

from sklearn.linear_model import LinearRegression

# 假设 X_train 是已经处理好的特征数据,y_train 是目标数据

model = LinearRegression()

model.fit(X_train, y_train)

```

线性回归模型简单直观,易于解释,但在面对非线性关系时表现不佳。在构建线性回归模型时,通常关注其`coef_`属性,该属性包含了模型系数,反映了自变量与因变量之间的关系。

### 3.1.2 决策树和随机森林

决策树通过一系列的判断规则将数据分割,形成树状结构,最终得到易于理解和解释的预测结果。随机森林则是由多个决策树构成的集成学习方法,它通过组合多个决策树的预测来降低过拟合的风险,提高预测的准确性和稳定性。

在Python中,可以使用Scikit-learn的`DecisionTreeClassifier`和`RandomForestClassifier`类来构建这两个模型

0

0