【预测模型的可解释性】:深度理解模型决策过程的黄金钥匙

发布时间: 2024-11-25 02:20:42 阅读量: 23 订阅数: 31

神经网络可解释性:透明化智能决策的钥匙

# 1. 预测模型可解释性的概念和重要性

在当今以数据驱动的决策时代,预测模型已成为各个领域不可或缺的工具。然而,随着模型复杂性的增加,人们开始关注模型的"黑盒"特性,即预测过程的不透明性,这直接关系到模型的可解释性问题。可解释性是预测模型的另一项关键指标,它关系到模型的可信度、合规性以及模型决策的透明度。可解释的模型能够揭示决策背后的逻辑与规则,有助于提升用户对模型预测结果的信心,进而促进模型在敏感和高风险领域的应用,如金融服务、医疗诊断和司法判决。因此,深入理解并实施预测模型的可解释性已成为提高模型价值和实现可持续发展的重要途径。

# 2. ```

# 第二章:可解释性理论基础

## 2.1 可解释性与模型透明度

### 2.1.1 透明度的概念及其在模型中的作用

在机器学习和人工智能领域,模型透明度指的是模型决策过程的可理解性。一个透明度高的模型能够允许研究人员、开发者甚至用户理解模型的运作方式,知晓特定输入如何影响输出。这种透明度对于建立信任尤其重要,它有助于检测和修正模型中的偏见,提高决策的透明度和责任性。

在模型中,透明度有多个层次:

- **算法透明度**:模型所使用的算法是公开和易于理解的。

- **模型透明度**:模型的参数、结构和预测逻辑清晰,可被解释和理解。

- **数据透明度**:用于训练模型的数据集是公开、清晰且可以获取的。

透明度在模型中的作用体现在:

- **增强用户信心**:当用户理解模型是如何工作的,他们更可能信任模型的决策。

- **便于调试**:透明度高的模型更容易诊断问题,便于维护和更新。

- **促进合规**:在一些受监管的行业,如金融和医疗,透明度是合规的关键部分。

### 2.1.2 可解释性的评估指标

为了量化模型的可解释性,研究者们已经提出了多种评估指标:

- **Fidelity**:衡量解释模型与原模型预测之间的一致性。

- **Stability**:评估当模型的输入数据有微小变化时,解释的稳健性。

- **Human-suitability**:衡量解释是否能够满足人类用户的理解需求。

这些评估指标有助于我们从多个维度评价和比较不同解释方法的有效性。

## 2.2 可解释性与人工智能伦理

### 2.2.1 伦理问题概述

人工智能伦理问题涉及到数据隐私、算法歧视、责任归属等多个层面。随着AI系统在关键领域(如医疗、司法和金融)中的应用增加,这些问题也日益引起公众和政府的关注。

伦理问题的核心在于保证AI系统的行为符合人类的道德和价值标准。这包括公平、无偏见、透明度、责任以及尊重用户隐私等原则。

### 2.2.2 可解释性在解决伦理问题中的作用

可解释性在解决伦理问题中扮演了关键角色:

- **识别偏见**:通过可解释的模型,我们能够识别和纠正潜在的偏见和歧视。

- **增加透明度**:提供足够的信息来解释决策过程,以避免不公正或误解。

- **促进责任归属**:当问题发生时,可解释的模型可以追溯责任,明确问题出现的原因和责任方。

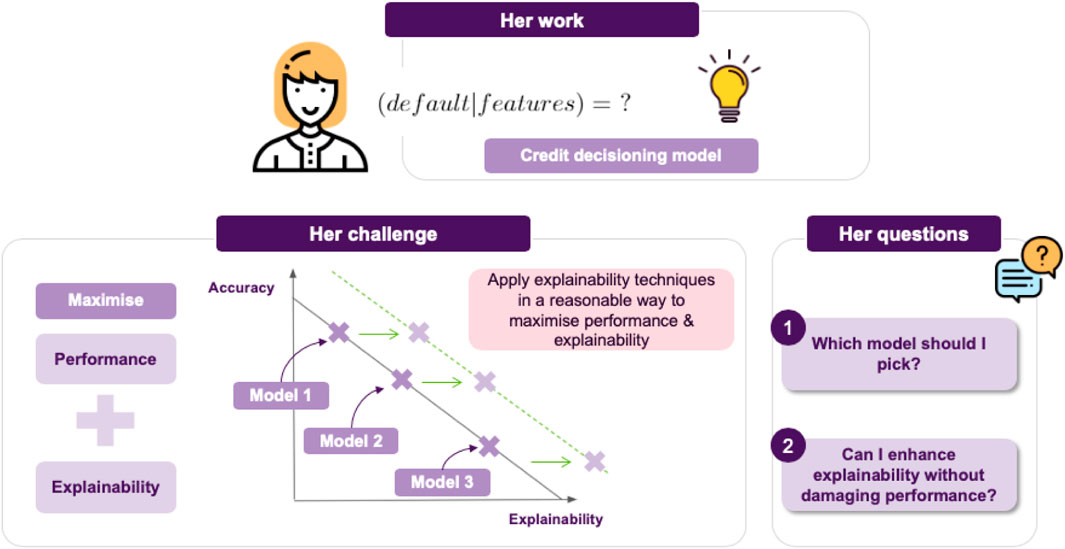

## 2.3 可解释性与模型性能

### 2.3.1 可解释性对模型优化的影响

模型优化不仅仅是提高预测准确性,还包括保证模型行为的合理性和可预测性。在优化过程中,可解释性起到以下几个关键作用:

- **提供洞察**:可解释模型可以帮助我们理解哪些特征对预测有重要影响,哪些可能产生误导。

- **避免过拟合**:通过分析特征贡献,可以识别模型中的噪声和不必要的复杂性。

- **指导特征工程**:了解模型的解释有助于识别和选择更有预测力的特征。

### 2.3.2 可解释性与模型泛化能力的关系

泛化能力是模型对未知数据进行准确预测的能力。可解释模型通过以下方式增强了模型的泛化能力:

- **提高鲁棒性**:可解释模型通常更简洁,避免了不必要的复杂性,使得它们在面对新数据时更为稳健。

- **减少过度拟合风险**:理解模型的内部工作机制有助于避免对训练数据的过度拟合。

- **调整模型结构**:通过理解特征的影响,可以进一步调整模型结构以优化泛化性能。

在接下来的章节中,我们将深入探讨可解释性与性能之间的具体关系,并通过实际案例来展示可解释性如何指导模型的优化过程。

```

# 3. 实现预测模型可解释性的方法

在当今的数据科学领域,预测模型在商业决策、医疗诊断、金融风险评估等诸多方面发挥着巨大的作用。然而,一个黑盒模型即使预测准确,也可能因为缺乏透明性而难以赢得用户的信任。因此,可解释性作为提升模型透明度和用户信任度的关键要素,成为模型开发过程中的重要考量。

## 3.1 模型固有可解释性方法

### 3.1.1 线性回归模型的可解释性分析

线性回归模型是最古老也是最直接的预测模型之一。其之所以具有固有可解释性,是因为模型形式简单,预测结果可以被量化成每个特征的权重和偏置项。

```python

import numpy as np

import statsmodels.api as sm

# 示例数据

X = np.array([[1, 2], [3, 4], [5, 6], [7, 8]])

y = np.array([1, 3, 5, 7])

# 添加常数项以适应线性回归模型

X = sm.add_constant(X)

# 估计模型参数

model = sm.OLS(y, X).fit()

# 打印模型参数

print(model.params)

```

在上述的线性回归示例中,每个特征前的系数表示该特征每变动一个单位,目标变量期望的变化量。例如,如果模型输出结果为`const 0.1

x1 0.5

x2 0.3`,则意味着x1每增加一个单位,目标变量平均增加0.5;x2每增加一个单位,目标变量平均增加0.3。

### 3.1.2 决策树模型的可解释性实践

决策树是一种通过树形结构进行决策的模型,其可解释性主要体现在能够可视化决策规则。每个决策节点表示一个特征测试,每个分支代表一个测试结果,最终叶节点给出预测结果。

```python

from sklearn import tree

import matplotlib.pyplot as plt

# 加载数据集

iris = load_iris()

X, y = iris.data, iris.target

```

0

0