【预测模型中的正则化方法】:避免过拟合的有效策略

发布时间: 2024-11-25 02:38:00 阅读量: 23 订阅数: 31

# 1. 正则化在预测模型中的重要性

在构建预测模型时,正则化是防止模型过拟合和提高模型泛化能力的关键技术之一。没有正则化的模型可能在训练数据上表现优异,但在未知数据上却可能效果大打折扣。通过在模型的目标函数中加入正则化项,我们可以在一定程度上限制模型的复杂度,防止模型对训练数据中的噪声过度学习。

在接下来的章节中,我们将深入探讨正则化的理论基础,包括过拟合与欠拟合的概念、正则化方法的分类以及正则化的目标函数和优化算法。理解这些基础知识是掌握正则化技术的前提,也是构建稳定和准确预测模型的必要条件。

本章内容旨在为读者构建起对正则化重要性的初步认识,并为深入学习后续章节内容做好铺垫。

# 2. 正则化理论基础

## 2.1 过拟合与欠拟合的概念

### 2.1.1 过拟合的定义及其影响

过拟合(Overfitting)是指一个模型对于训练数据集拟合得过于精确,以致于模型捕捉到了数据中的噪声和异常值,而非底层的分布规律。这种现象会导致模型在训练集上的性能非常好,但是当用于未见过的数据(测试集)时,其性能会大幅下降。过拟合的模型不具备良好的泛化能力。

为了理解过拟合的影响,我们首先要了解模型在训练和测试阶段的表现差异。理想情况下,一个模型在训练和测试数据上都应该有良好的表现。但在实际操作中,由于过拟合的存在,模型往往在训练数据上的预测误差极小,而在测试数据上的预测误差却显著增大。

过拟合对模型的影响主要体现在以下几个方面:

- **性能下降**:过拟合的模型在未见过的数据上表现不佳,导致其实际应用价值降低。

- **泛化能力缺失**:模型无法从数据中学习到通用的规律,因此难以推广到新的数据集上。

- **资源浪费**:过度复杂的模型需要更多的计算资源和时间,这在资源受限的情况下是不可取的。

### 2.1.2 欠拟合的定义及其影响

与过拟合相对的是欠拟合(Underfitting),它发生在模型过于简单,无法捕捉数据集中的基本趋势时。欠拟合的模型在训练数据集上表现不佳,同样在测试数据集上的表现也不会理想。欠拟合通常是由于模型选择不当或者训练不足导致的。

欠拟合的影响主要体现在:

- **预测能力弱**:由于模型结构过于简单,无法学习数据中的复杂关系。

- **改进困难**:与过拟合不同,欠拟合不涉及优化问题,简单的增加数据量、改变模型结构或增加训练轮数通常无法解决问题。

- **误导决策**:在实际应用中,欠拟合模型提供的结果可能严重误导决策制定。

### 表格展示过拟合与欠拟合的对比

| 特征 | 过拟合 | 欠拟合 |

| --- | --- | --- |

| 训练集性能 | 非常好 | 不好 |

| 测试集性能 | 差 | 差 |

| 问题描述 | 模型太复杂 | 模型太简单 |

| 解决方法 | 简化模型、正则化、数据增强等 | 增加模型复杂度、延长训练时间、特征工程等 |

## 2.2 正则化方法的分类

### 2.2.1 常见的正则化技术概述

正则化技术是机器学习中用来防止模型过拟合的方法。它通过在损失函数中添加一个额外的项来惩罚模型的复杂度,从而促使模型保持简单性。常见的正则化技术包括L1正则化、L2正则化和弹性网(Elastic Net)等。

- **L1正则化**:通过惩罚模型权重的绝对值之和(L1范数),使得模型倾向于产生稀疏解。这有助于特征选择和提高模型的可解释性。

- **L2正则化**:通过惩罚模型权重的平方和(L2范数),使得模型权重不会太大,降低了模型复杂度,有助于防止过拟合。

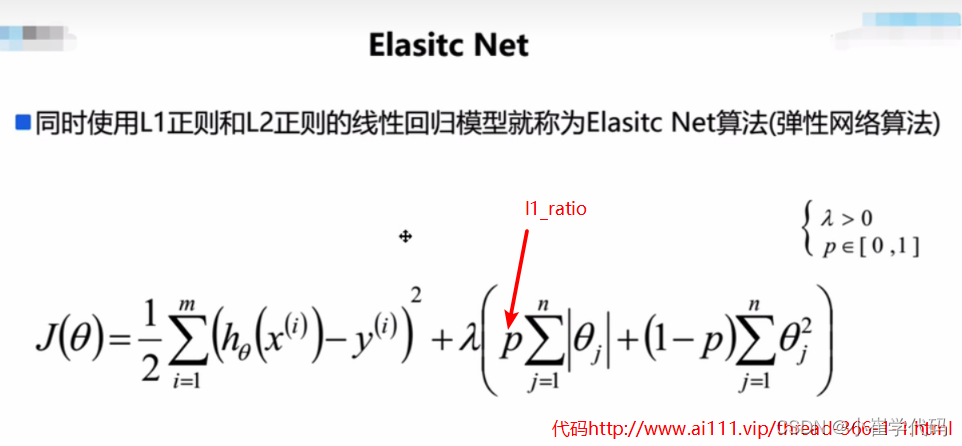

- **弹性网(Elastic Net)**:结合了L1和L2正则化,它的目标函数同时包含权重的绝对值之和和平方和。弹性网在保持稀疏性的同时,也能处理特征间的多重共线性问题。

### 2.2.2 L1和L2正则化的对比分析

L1和L2正则化的对比是理解和应用正则化技术的基础。二者在理论和应用上有不同的特点和适用场景。

- **理论差异**:

- L1正则化倾向于产生稀疏模型,因此可以用于特征选择。

- L2正则化则倾向于使模型权重均匀分布,通常不会产生零权重。

- **应用差异**:

- L1正则化适用于特征数量大但实际有用的特征较少的情况,有助于简化模型。

- L2正则化则适用于特征数量和模型复杂度适中的情况,有助于保持模型的稳定性和准确性。

- **优化算法差异**:

- L1正则化通常会使得优化问题更加困难,因为它导致的非光滑目标函数。

- L2正则化使得优化问题相对简单,可以通过求解凸问题来获得稳定的解。

- **实际选择**:

- 如果关注模型的稀疏性,并且需要进行特征选择,那么L1可能是更好的选择。

- 如果关心的是模型的稳定性和准确性,则L2正则化可能会更加适用。

正则化参数的不同取值也会对模型产生不同的影响,通常需要通过交叉验证等方法来选取合适的参数。

## 2.3 正则化的目标函数与优化算法

### 2.3.1 正则化项对目标函数的影响

正则化技术通过修改目标函数来实现对模型复杂度的控制。在目标函数中引入正则化项,可以将问题转化为求解一个带有约束条件的优化问题。例如,在线性回归模型中,目标函数可以表示为:

```math

J(\theta) = \frac{1}{2m} ||X\theta - y||^2 + \alpha \Omega(\theta)

```

这里,`J(θ)` 是损失函数,`||Xθ - y||^2` 是原始的平方损失项,`Ω(θ)` 是正则化项,`α` 是正则化参数。正则化项 `Ω(θ)` 的存在使得模型在最小化误差的同时,还必须考虑到模型复杂度的控制。

### 2.3.2 优化算法的选择与应用

正则化问题的求解通常涉及到优化算法的选择。对于不同的正则化技术,选择合适的优化算法非常重要。

- **L1正则化**:因为涉及到求解非光滑优化问题,因此在实际应用中通常需要使用特殊算法,比如Lasso问题的解决方法(如坐标下降法)。

- **L2正则化**:由于L2正则化的目标函数是凸函数,所以可以使用梯度下降法、牛顿法或其他优化凸函数的算法来求解。

- **弹性网**:结合了L1和L2正则化,因此其优化算法需要同时处理L1的非光滑性和L2的凸性。

下面是一个梯度下降法求解带有L2正则化项的线性回归问题的Python代码示例。

```python

import numpy as np

# 假设X, y是已经加载的特征矩阵和目标向量

# alpha是正则化参数

def ridge_regression(X, y, alpha=0.1):

m, n = X.shape

# 初始化权重向量

w = np.zeros(n)

# 学习率和迭代次数

learning_rate = 0.01

iterations = 1000

# 梯度下降法

for _ in range(iterations):

# 计算预测值和误差的梯度

predictions = np.dot(X, w)

gradient = (1/m) * np.dot(X.T, (predictions - y))

# 加入L2正则化项的梯度

gradient += (alpha/m) * w

# 更新权重

w -= learning_rate * gradient

return w

# 使用ridge_regression函数进行模型训练

weights = ridge_regression(X_train, y_train, alpha=1.0)

```

在这段代码中,我们定义了一个`ridge_regression`函数,它通过梯度下降法来求解带有L2正则化项的线性回归问题。函数首先初始化权重向量,然后在每次迭代中计算梯度并更新权重。最终返回的`weights`是经过正则化调整后的模型参数。

在使用上述代码时,需要确保已经加载了相应的特征矩阵`X`和目标向量`y`。对于正则化参数`alpha`的调整,通常需要通过交叉验证来实现最佳的泛化性能。在实际应用中,可能还需要对特征进行标准化处理,以避免因为特征的量纲不同导致的优化问题。

通过以上内容,我们可以了解到正则化在理论和实际应用中的重要性,以及如何在机器学习模型中实现和选择适当的正则化方法。在后续章节中,我们将深入探讨正则化在不同预测模型中的具体应用,并通过案例分析来加深理解。

# 3. 实践中的正则化应用

在上一章中

0

0