【数据仓库扩展性】:云数据仓库扩展解决方案应对业务增长挑战

发布时间: 2024-12-15 18:04:26 阅读量: 1 订阅数: 4

Oracle数据仓库解决方案.pptx

参考资源链接:[LMS Virtual.Lab 13.6 安装教程:关闭安全软件与启动证书服务](https://wenku.csdn.net/doc/29juxzo4p6?spm=1055.2635.3001.10343)

# 1. 数据仓库基本概念与发展挑战

在信息化时代,数据仓库作为企业决策支持系统中的核心组成部分,扮演着至关重要的角色。数据仓库不仅涉及传统数据库管理技术,还融合了数据处理、数据分析和数据可视化等技术,用于收集、存储和管理历史和当前数据,支持企业进行业务分析与决策制定。然而,在这个信息爆炸、数据量日益增长的时代,数据仓库面临着巨大的挑战。

首先,随着企业规模扩大、数据量激增,如何存储和处理海量数据成为一大难题。传统的数据仓库可能无法应对数据的快速增长,需要考虑引入新的技术和架构来应对大数据挑战。

其次,随着业务需求的不断变化和复杂化,数据仓库需要具备灵活性和可扩展性,以支持各种复杂的数据分析需求。企业需要构建能够适应快速变化的业务环境的数据仓库体系。

最后,数据仓库的性能优化也是不可忽视的挑战。在处理大量并发查询和复杂的数据分析任务时,必须确保数据仓库能够提供高速的查询响应和准确的分析结果。

为了应对这些挑战,数据仓库需要不断演化以适应新时代的需求。本章将深入探讨数据仓库的基本概念、架构演变、以及面临的挑战与应对策略。接下来的章节将详细分析云数据仓库的技术架构,并探讨在实际应用中如何进行扩展性和多租户架构设计,最终在第五章展望数据仓库领域的未来趋势和技术创新。

# 2. 云数据仓库的技术架构分析

## 2.1 云数据仓库的核心技术组件

在本章节中,我们将深入了解云数据仓库的核心技术组件,包括分布式存储与计算引擎以及数据加载与ETL处理的细节,探讨它们是如何协同工作以实现数据处理的高效性。

### 2.1.1 分布式存储与计算引擎

分布式存储和计算引擎是云数据仓库的基础架构组件,它们共同工作以确保大规模数据处理的性能和可靠性。分布式存储提供数据的冗余和备份,而计算引擎则负责执行复杂的查询和分析任务。

**分布式存储** 是通过将数据分布在多个物理或虚拟存储设备上,以提高数据访问速度和容错能力。为了达到高可用性和高扩展性,分布式存储通常实现数据的多副本存储和自动故障转移机制。一些流行的分布式存储解决方案包括Google的Colossus、Amazon的S3以及开源的HDFS。

**计算引擎**,如Apache Spark和Hadoop MapReduce,则利用分布式存储上的数据执行并行处理。通过将计算任务分散到多个节点,这些引擎可以在短时间内处理大量数据。它们支持高度优化的查询优化器和执行计划,以进一步提高执行效率。

#### 案例代码块:Apache Spark SQL查询示例

```scala

import org.apache.spark.sql.SparkSession

// 创建Spark Session

val spark = SparkSession.builder()

.appName("Distributed Data Warehouse")

.config("spark.some.config.option", "some-value")

.getOrCreate()

// 读取存储在分布式存储系统中的数据

val df = spark.read.format("parquet").load("s3a://path/to/your/data/")

// 执行一个SQL查询

df.createOrReplaceTempView("data_warehouse")

val results = spark.sql("SELECT product_id, COUNT(*) FROM data_warehouse GROUP BY product_id")

// 展示结果

results.show()

```

**代码分析**:

- 上述代码块展示了如何使用Apache Spark来执行一个简单的数据仓库查询操作。

- 我们首先创建了一个`SparkSession`对象,这是使用Spark SQL的入口点。

- 接着,我们使用`read`方法从S3对象存储中读取数据。这里假设数据以Parquet格式存储。

- `createOrReplaceTempView`方法将DataFrame注册为一个临时视图,这样我们就可以使用SQL语言查询数据。

- 最后,我们使用`sql`函数执行一个分组聚合操作,并使用`show`方法展示查询结果。

### 2.1.2 数据加载与ETL处理

数据加载是指将数据从各种数据源导入到数据仓库中。ETL(提取、转换、加载)处理涉及到数据清洗、转换成一致的格式,并最终加载到数据仓库中。

在云环境中,数据加载通常通过批量加载或实时流处理两种方式实现。批量加载涉及周期性地将数据从源系统导入数据仓库,而实时流处理则是通过消息队列或事件驱动的方式,以流的形式持续加载数据。

**批量数据加载**的一个例子是通过AWS Data Pipeline或Google Cloud Dataflow这样的服务来调度数据导入任务。数据在导入之前可以经过一系列转换步骤,例如数据清洗、规范化或去重。

**实时数据流处理**通常涉及到Apache Kafka或Amazon Kinesis这样的消息系统。这些系统可以处理高速、高并发的数据流,并且与计算引擎的集成使得实时分析成为可能。

#### 代码块示例:Apache Kafka实时数据流处理

```java

Properties props = new Properties();

props.put("bootstrap.servers", "kafka-broker:9092");

props.put("group.id", "use_a_separate_group_id_for_each_stream");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

while (true) {

ConsumerRecords<String, String> records = consumer.poll(100);

for (ConsumerRecord<String, String> record : records) {

// 处理数据逻辑

String key = record.key();

String value = record.value();

System.out.printf("key = %s, value = %s%n", key, value);

}

}

```

**代码分析**:

- 这段Java代码展示了如何使用Apache Kafka的客户端API进行实时数据消费。

- 我们首先配置消费者的属性,指定了Kafka集群的位置、消费者组ID、以及键和值的反序列化器。

- 在一个无限循环中,消费者定期从Kafka主题拉取记录。

- 对于每条记录,我们执行必要的数据处理逻辑。

- 这个例子中简化的处理逻辑,实际上可以包括数据清洗、转换和加载到数据仓库等复杂操作。

## 2.2 数据仓库的可扩展性设计原则

数据仓库的可扩展性设计是关键,它确保了数据仓库能够适应不断增长的数据量和用户需求。本小节将探讨水平扩展与垂直扩展的对比,以及弹性资源管理和自动缩放机制的设计原则。

### 2.2.1 水平扩展与垂直扩展的对比

在讨论扩展性时,水平扩展(也称为横向扩展)和垂直扩展(也称为纵向扩展)是两个基本策略。它们各自有优势和局限性,而在设计云数据仓库时,通常需要根据具体的工作负载和成本效益进行选择。

**水平扩展**意味着通过添加更多的服务器或节点来提升数据仓库的处理能力。这种方法的主要优势在于它可以线性地提高性能,理论上可以无限扩展。水平扩展非常适合于大数据环境,其中数据量和查询复杂性不断增长。

**垂直扩展**是指升级现有服务器的硬件资源,如CPU、内存或存储能力。这种方法的局限性在于单点故障的风险,以及硬件升级的物理和经济成本。

### 2.2.2 弹性资源管理和自动缩放机制

在云数据仓库中,弹性资源管理和自动缩放机制是支持水平扩展的关键技术之一。这些机制能够自动调整数据仓库的计算资源,以应对不同时段的工作负载变化,确保资源的有效利用和成本的优化。

**弹性资源管理**通常包含以下方面:

- **资源配额和限制**:定义计算资源的使用上限和下限,以防止资源的过度消耗和节约成本。

- **资源请求和分配**:当需要更多计算资源时,系统能够自动请求额外的资源,而当负载减少时释放这些资源。

- **动态伸缩策略**:根据工作负载的变化自动调整资源的分配。

**自动缩放机制**的核心是监控资源的使用情况,并根据预设的规则来增加或减少资源。例如,当CPU使用率超过一定阈值时,自动增加计算实例数;反之,当使用率低于某个水平时,减少实例数。

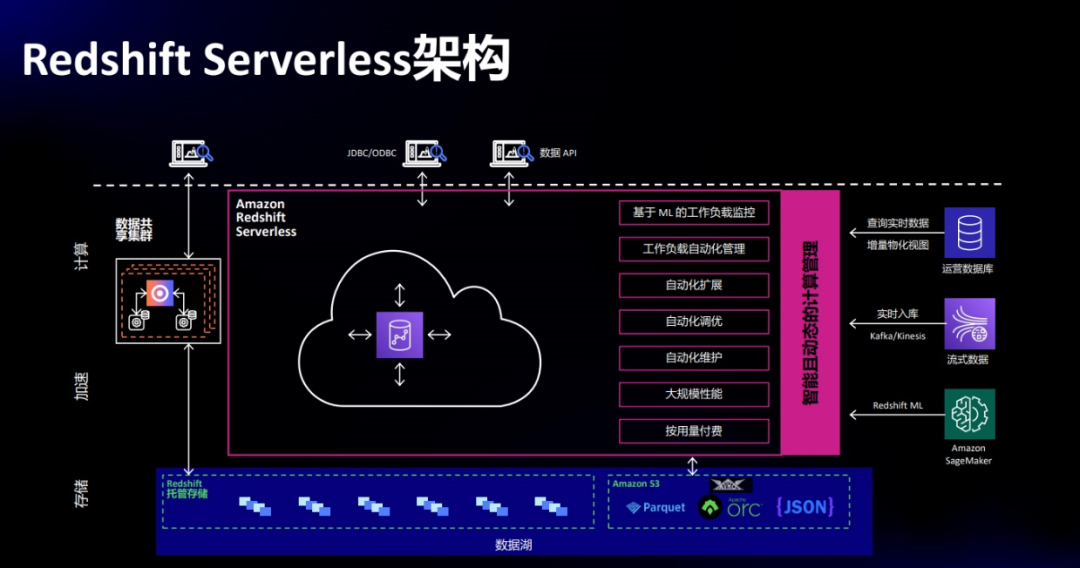

#### 案例研究:AWS Redshift的弹性伸缩机制

Amazon Redshift是一个可完全托管的云数据仓库服务,它提供了自动的水平和垂直伸缩能力,以支持不同规模的数据分析工作。Redshift使用自动伸缩策略,根据工作负载的变化,自动调整计算节点的数量(水平伸缩),并优化节点的性能配置(垂直伸缩)。

下表展示了自动伸缩策略的执行逻辑:

| 资源使用情况 | 伸缩策略 |

|:------------------|:------------|

| CPU使用率超过80% | 增加节点数量以提高计算能力 |

| CPU使用率低于50% | 减少节点数量以节省成本 |

| 查询响应时间超过预期 | 增加

0

0