【YOLOv8部署秘籍】:跨平台高效运行的策略与技巧

发布时间: 2024-12-11 22:21:23 阅读量: 7 订阅数: 16

YOLOv8的跨平台部署:实现多环境目标检测的灵活性与效率

# 1. YOLOv8的基本概念与优势

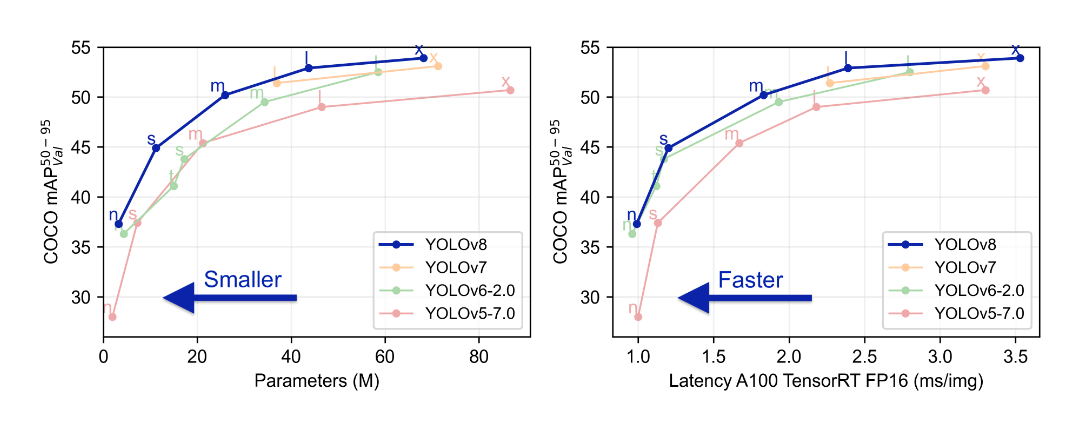

在这一章节,我们将开始探索YOLOv8的宇宙,揭开它的神秘面纱。YOLOv8,作为You Only Look Once系列的最新版本,是一个在实时目标检测领域中具有革新意义的深度学习模型。YOLOv8通过优化算法效率和网络架构,实现了更快的检测速度和更高的准确率。本章将会详细剖析YOLOv8的核心优势,从基本概念到它的技术突破,帮助读者建立一个清晰的理解。我们将逐步讨论YOLOv8的快速处理能力如何使之成为诸多应用的理想选择,以及它如何在实际场景中提升用户体验和效率。

在接下来的章节中,我们将深入探讨如何在不同的工作环境中搭建和部署YOLOv8,并逐步探索如何通过高级配置与性能调优来达到最佳的运行状态。让我们开始吧,YOLOv8的世界等待你去发现。

# 2. YOLOv8的环境搭建和部署

## 2.1 系统与硬件要求

### 2.1.1 兼容的操作系统选择

YOLOv8作为深度学习模型在视觉领域的重要工具,其运行环境的选择对于确保其性能至关重要。它支持多种操作系统,但在选择部署YOLOv8的平台时,通常推荐使用以下几种:

- **Linux操作系统**:尤其是Ubuntu,因为它有着广泛的深度学习库支持和社区资源,使得在Linux环境下安装、配置和运行YOLOv8变得相对简单。

- **Windows操作系统**:适用于没有特定Linux操作知识的用户,尤其是Windows 10/11系统,其子系统Linux(WSL)的版本已经非常成熟,能提供类Unix环境。

- **macOS**:苹果用户可以使用macOS作为开发环境,但要注意部分依赖可能需要通过Homebrew进行安装。

选择操作系统时,需要考虑到兼容性、社区支持、个人熟悉程度等因素。在Linux上,YOLOv8能获得最佳的性能和集成度。在Windows上,如果对Linux环境不是那么熟悉,可以使用WSL,但这可能会引入额外的复杂性,并可能影响性能。

### 2.1.2 硬件加速与资源需求分析

为了实现YOLOv8的高效运行,硬件配置必须能够满足深度学习模型的计算要求。YOLOv8对硬件的要求取决于具体的使用场景,如实时视频分析、大规模图像批处理等。一些关键的硬件需求如下:

- **CPU**:多核心CPU可以有效地处理数据预处理和后处理任务。推荐至少为多核处理器,如Intel的i7或AMD的Ryzen系列。

- **GPU**:对于需要实时处理的应用,一块具备CUDA核心的NVIDIA GPU是必须的,因为YOLOv8在GPU上加速计算。显存至少需要4GB以上,如果处理高清视频则需要更高。

- **内存(RAM)**:8GB以上内存能够支持大多数应用场景,但如果要处理大型数据集或运行多个进程,则建议至少16GB以上。

在资源需求分析上,合理的规划可以避免系统过载。可以使用工具如nvidia-smi来监控GPU的使用情况,使用top或htop命令来监控CPU和内存的使用状态。

## 2.2 官方工具链的使用

### 2.2.1 安装YOLOv8的依赖环境

YOLOv8依赖于一系列的库和工具,例如Python、PyTorch、OpenCV等。为了简化安装流程,官方提供了YOLOv8的依赖环境安装脚本,可以高效地完成整个依赖链的安装。在Linux系统中,这些步骤大致如下:

1. 更新系统的软件包索引:

```bash

sudo apt-get update

```

2. 安装Python和其他必要的依赖:

```bash

sudo apt-get install python3 python3-pip python3-setuptools

```

3. 安装PyTorch,通过PyTorch官网获取最新的安装命令。

4. 克隆YOLOv8的官方仓库:

```bash

git clone https://github.com/ultralytics/yolov8

```

5. 进入YOLOv8目录,运行安装脚本:

```bash

cd yolov8 && bash scripts/install.sh

```

这个安装脚本会自动处理绝大多数的依赖关系,并且会根据运行环境自动选择合适版本的依赖进行安装。对于不同的操作系统,一些步骤可能略有不同,具体可以参考YOLOv8官方文档中对应的安装指南。

### 2.2.2 利用官方脚本一键部署

YOLOv8官方提供了多个脚本用于快速部署,这些脚本简化了安装和部署过程,使得开发者能够快速上手。使用官方脚本一键部署的步骤可以分为:

1. 确保Python和pip已经安装,并且环境变量配置正确。

2. 克隆YOLOv8仓库:

```bash

git clone https://github.com/ultralytics/yolov8

```

3. 进入仓库目录,并执行一键部署脚本:

```bash

cd yolov8 && bash scripts/deploy.sh

```

部署脚本通常包含以下内容:

- **依赖环境检测**:脚本会检查所有依赖是否已经正确安装,否则会尝试自动安装。

- **预编译二进制包安装**:脚本可能会自动下载预编译的YOLOv8二进制包,以避免从源代码编译时的复杂配置。

- **配置文件生成**:一些必要的配置文件将会被生成,以便YOLOv8运行时使用。

通过官方提供的脚本进行部署,不仅简化了部署流程,还减少了可能由于人为配置错误引起的运行问题。

## 2.3 自定义环境的搭建

### 2.3.1 手动安装和配置深度学习框架

虽然官方脚本能够极大地简化安装过程,但在一些特殊的场景下,可能需要进行手动安装和配置深度学习框架。这里以手动安装PyTorch为例,介绍手动安装流程:

1. 打开PyTorch官网,选择对应的系统、包管理器(conda或pip)和PyTorch版本,下载安装命令。

2. 使用命令行工具执行下载的命令,例如使用pip安装命令:

```bash

pip3 install torch torchvision torchaudio

```

如果选择使用conda,则命令类似:

```bash

conda install pytorch torchvision torchaudio -c pytorch

```

3. 在安装过程中,系统会自动下载和编译依赖的库,包括CUDA Toolkit等,如果已经安装过这些依赖,可以根据提示选择跳过。

4. 完成安装后,可以通过以下Python代码验证安装是否成功:

```python

import torch

print(torch.__version__)

```

手动安装深度学习框架的过程可能比使用官方脚本稍微复杂一些,但可以进行更细致的配置。例如,可以选择安装特定版本的CUDA Toolkit来匹配GPU的能力,或者安装特定版本的依赖库来满足特定的科研或开发需求。

### 2.3.2 优化安装流程与性能调校

性能调校是深度学习模型部署过程中的一个重要环节,尤其是在资源有限的环境中,合理的性能调校可以确保模型以最佳的性能运行。以下是一些性能调校的建议:

- **编译优化**:在安装深度学习框架(如PyTorch)时,可以加上`-O3`优化标志来开启编译器的最优化。

- **内存管理**:对于Python项目,使用`gc`模块进行垃圾回收的自动管理,或使用`numba`模块进行即时编译,可以提高代码执行效率。

- **异步IO**:使用异步编程技术,如Python的`asyncio`库,可以避免阻塞IO操作,提升性能。

- **资源限制**:设置合理的线程数和进程数,可以避免因资源竞争导致的性能瓶颈。

下面是一个使用`numba`进行即时编译的简单例子:

```python

from numba import jit

@jit(nopython=True)

def my_function(x, y):

return x + y

result = my_function(2, 3)

print(result)

```

这个例子中,`numba`的即时编译器会将Python函数编译成机器码,大幅提升运行速度。

通过这些步骤,可以手动优化YOLOv8的安装和配置流程,确保模型在特定硬件上运行时性能最大化。

# 3. YOLOv8在不同平台的部署实践

## 3.1 Linux平台的部署

YOLOv8在Linux平台的部署是其应用中最为普遍的情况,Linux系统的稳定性和开源特性使得其成为开发和部署深度学习模型的理想选择。本部分将详细介绍基于Docker的快速部署方法,以及在Linux系统下进行性能测试与优化的策略。

### 3.1.1 基于Docker的快速部署

Docker容器技术能够提供一种轻量级的虚拟化方式,它允许开发者和运维人员打包应用及其依赖环境,以容器的形式实现应用的快速部署和运行。YOLOv8的Docker部署流程如下:

首先,确保本地已安装Docker环境,并更新到最新版本。然后,拉取YOLOv8官方提供的Docker镜像:

```bash

docker pull yolov8:latest

```

拉取完成后,使用以下命令启动容器:

```bash

docker run --gpus all -it --rm yolov8:latest

```

此命令将启动一个带有GPU支持的YOLOv8容器实例,并提供交互式终端。`--gpus all` 参数确保容器可以使用所有可用的GPU设备。

紧接着,可以克隆YOLOv8的官方GitHub仓库,并在容器内运行YOLOv8模型进行测试:

```bash

git clone https://github.com/ultralytics/yolov8.git

cd yolov8

python detect.py --source data/images --weights weights/yolov8s.pt --img 640 --conf 0.25 --save-crop

```

上述代码中,`detect.py` 是YOLOv8的检测脚本,`--weights` 指定了模型权重文件的路径,`--source` 指定了输入图片的路径,`--img` 参数指定了图片大小,`--conf` 参数指定了置信度阈值。`--save-crop` 参数表示将预测的检测框区域保存为新的图片文件。

### 3.1.2 Linux系统下的性能测试与优化

在完成YOLOv8的初步部署之后,为了确保模型在特定硬件上的性能达到最优,进行性能测试和调优是必要的。以下是性能测试与优化的基本步骤:

1. **硬件配置检查**

首先需要确认系统的硬件配置是否满足YOLOv8的要求,特别是GPU的规格与数量。

```bash

nvidia-smi

```

该命令用于检查NVIDIA GPU的运行状态。

2. **系统资源监控**

使用`htop`或`glances`等工具监控系统资源使用情况,包括CPU、内存和GPU利用率。

3. **基准性能测试**

运行YOLOv8的测试脚本,记录下不同输入尺寸和批处理大小下的推理时间。

```bash

python detect.py --source data/videos --weights weights/yolov8m.pt --img 1280 --conf 0.25 --save-crop --nosave-vid

```

这里,`--img` 参数设置为1280,以评估模型在更高分辨率下的性能。

4. **性能优化**

根据基准测试的结果,可以通过调整模型参数或硬件加速选项来优化性能。例如,可以通过增加批处理大小来利用GPU的并行计算能力,但需要注意不要超过GPU的显存限制。

```bash

python train.py --batch 16 --epochs 300 --weights yolov8s.pt

```

此命令设置批处理大小为16,可以在硬件允许的范围内尝试更大的批处理大小以提高性能。

性能优化是一个迭代的过程,通常需要结合具体应用场景和硬件资源进行多次测试和调整。

## 3.2 Windows平台的部署

Windows平台的部署比Linux更为复杂,因为Windows不是深度学习模型部署的传统选择。不过,随着Windows Subsystem for Linux (WSL) 的推出以及对Docker的改进支持,部署YOLOv8变得更加便捷。

### 3.2.1 使用Windows子系统Linux部署

WSL 允许在 Windows 系统上直接运行 Linux 环境,极大地简化了在 Windows 上进行 Linux 应用的开发和部署。具体部署步骤如下:

1. 启用 WSL 功能

在 Windows 功能设置中启用 WSL 功能。打开 PowerShell 作为管理员,然后执行以下命令:

```powershell

dism.exe /online /enable-feature /featurename:Microsoft-Windows-Subsystem-Linux /all /norestart

```

2. 安装 Linux 发行版

通过 Microsoft Store 安装一个 Linux 发行版。例如,安装 Ubuntu 18.04 LTS。

3. 配置 WSL 环境

打开 Ubuntu 终端,设置用户名和密码,然后更新系统包列表:

```bash

sudo apt-get update

sudo apt-get upgrade

```

4. 部署 YOLOv8

接着,就可以按照 Linux 平台的部署方法来部署 YOLOv8,使用 Docker 或手动安装依赖。

### 3.2.2 Windows原生环境下的部署策略

YOLOv8 也可以在 Windows 原生环境下进行部署,主要采用直接安装依赖和配置环境的方式:

1. **安装 GPU 支持的 Python 环境**

- 下载并安装适合 Windows 的 Python 版本。

- 安装 GPU 版本的 PyTorch,确保其与本地 NVIDIA GPU 兼容。

2. **安装深度学习框架和依赖**

- 使用 `pip` 或 `conda` 安装深度学习库,例如:`pip install torch torchvision torchaudio`。

- 其他依赖库的安装,例如 `numpy`、`opencv-python` 等。

3. **部署YOLOv8模型**

- 克隆YOLOv8的GitHub仓库。

- 按照官方文档的指导,下载预训练模型并运行检测脚本。

Windows平台部署YOLOv8的难点在于确保所有依赖库和驱动程序与Windows系统的兼容性。在处理依赖问题时,可能需要对照官方文档和社区讨论,逐一解决可能出现的问题。

# 4. YOLOv8的高级配置与性能调优

## 4.1 模型精度与速度的权衡

### 4.1.1 调整模型参数以适应不同应用场景

在实际应用中,YOLOv8的模型性能与精度往往需要根据不同的场景进行适当的调整。例如,在处理实时监控视频流时,我们可能更关注模型的运行速度,以便快速响应。相反,在一些高质量图像的分析任务中,例如医学影像分析,模型的精度则成为我们的首要考量。

调整模型参数可以通过修改模型结构和训练过程中的超参数来实现。比如,增加模型层数能够提升精度,但同时会牺牲速度;调整卷积核的数量和大小、使用不同类型的激活函数、改变损失函数等都可能影响到模型的性能。

一个常用的策略是首先在大规模数据集上预训练一个通用模型,然后在特定任务的数据集上进行微调(Fine-tuning)。这样的方法可以在保证模型精度的同时,适当降低模型复杂度,提高运行速度。

### 4.1.2 使用量化技术提升运行效率

量化技术是一种常见的模型优化手段,其目的是降低模型参数和计算过程的精度,从而减少模型大小和加速推理速度。量化分为静态量化和动态量化。静态量化在模型训练完成后进行,将模型中的浮点数参数转换成低精度的整数形式;而动态量化则是在运行时实时进行,通常用于模型部署阶段。

在YOLOv8中,可以通过以下步骤应用量化技术:

1. 使用支持量化的深度学习框架,如TensorRT或PyTorch的torch.ao.quantization模块。

2. 设置量化配置,选择适当的量化策略。

3. 在预训练模型上应用量化。

4. 测试量化模型的性能,包括精度和速度,如果需要,可以进行微调。

5. 部署量化后的模型到目标设备。

在进行量化时,需要权衡模型精度和运行速度之间的关系。虽然量化通常会带来精度的微小下降,但是可以显著提升模型的运行效率,尤其在计算资源受限的设备上。

```

# 示例:PyTorch中对YOLOv8模型进行量化

import torch

import torch.nn as nn

# 加载预训练模型

model = ... # 从torchvision导入预训练模型

model.load_state_dict(torch.load("yolov8_pretrained.pth"))

# 准备数据集

test_dataset = ... # 加载验证数据集

test_loader = torch.utils.data.DataLoader(test_dataset, batch_size=1)

# 应用量化配置

quantized_model = torch.quantization.quantize_dynamic(

model, # the original model

{nn.Linear}, # a set of layers to dynamically quantize

dtype=torch.qint8 # the target dtype for quantized weights

)

# 测试量化模型

for images, targets in test_loader:

outputs = quantized_model(images)

# 进行精度和速度测试

# 保存量化模型

torch.save(quantized_model.state_dict(), "yolov8_quantized.pth")

```

在上述代码块中,展示了如何将一个预训练的YOLOv8模型进行量化处理。代码逻辑的逐行解读分析包括加载预训练模型、准备测试数据集、设置量化配置、应用量化并测试量化模型的性能、保存量化后的模型文件。通过量化,我们可以得到一个运行效率更高、模型大小更小的YOLOv8模型,以适应边缘计算和移动设备上的部署需求。

# 5. YOLOv8的未来展望与社区贡献

## 5.1 YOLOv8的开源生态和社区动态

随着深度学习技术的快速发展,YOLOv8作为其中的佼佼者,已经形成了一个庞大而活跃的开源社区。社区不仅为开发者提供了一个交流学习的平台,也是项目创新和进化的源泉。

### 5.1.1 项目贡献方式与参与指导

贡献者可以通过多种方式参与YOLOv8的项目开发,例如,提交代码修复、改进现有功能、提供新的特性,或者优化文档和教程。一个成功的开源项目鼓励开放和包容,任何有建设性的意见和贡献都将受到欢迎。

为了鼓励新贡献者参与,社区提供了详细的贡献指南。这些指南通常包括:

- ** Fork 项目并进行修改**:在GitHub上Fork YOLOv8的仓库,然后在自己的分支上进行修改或增加功能。

- ** 代码审查**:提交Pull Request后,社区成员会对代码进行审查,保证代码质量和风格符合项目标准。

- ** 遵循代码规范**:YOLOv8有自己的代码规范和格式化标准,确保代码的可读性和一致性。

- ** 测试**:所有的代码提交都应该附带相应的单元测试,保证功能的正确性和健壮性。

```mermaid

graph LR

A[开始贡献] --> B[在GitHub Fork项目]

B --> C[在本地修改代码]

C --> D[提交Pull Request]

D --> E[代码审查]

E -->|通过| F[合并代码]

E -->|未通过| G[提出修改意见]

F --> H[完成贡献]

G --> C

```

### 5.1.2 社区交流与最新进展分享

社区成员之间的交流是促进项目发展的重要因素。YOLOv8社区通过多种渠道进行交流:

- **邮件列表**:这是最传统的沟通方式,适用于讨论项目相关的问题和计划。

- **论坛和聊天室**:如Reddit上的子版块或Discord聊天室,用于即时沟通和快速反馈。

- **定期会议**:社区可能还会定期举行线上或线下的会议,分享项目进展和讨论未来方向。

社区成员通过这些渠道不仅能够获得项目最新动态,还可以与其他开发者建立联系,这对于个人职业发展和人脉拓展都是有益的。

## 5.2 新兴技术与YOLOv8的融合

YOLOv8作为一个先进的目标检测模型,持续地与新兴技术融合,以期保持其在技术前沿的地位。

### 5.2.1 集成最新AI算法的策略

集成最新的人工智能算法是提高YOLOv8性能的关键策略之一。社区开发者与研究者们紧密合作,将最新的研究成果如Transformer架构、注意力机制等融入到YOLOv8中,从而提高模型的准确性和鲁棒性。

### 5.2.2 跨领域应用案例与创新思路

除了在传统的目标检测领域中不断创新,YOLOv8也在积极探索跨领域的应用,例如在自动驾驶、机器人视觉、医疗影像分析等场景中发挥作用。例如,结合医疗影像分析,YOLOv8可以被用于自动检测和识别疾病标志,辅助医生进行诊断。

这些跨领域的探索将为YOLOv8带来新的应用场景,同时也为研究者和开发者提供了新的挑战和机遇。社区的贡献者们在这些领域中积极尝试和实践,推动了YOLOv8以及整个目标检测技术的边界。

0

0