激光雷达点云与2D俯视图映射:最新算法实践案例分析

发布时间: 2025-01-09 15:41:20 阅读量: 13 订阅数: 6

深度学习多传感器融合之激光雷达点云如何映射到2D俯视图和前视图

# 摘要

本文系统地探讨了激光雷达点云技术的各个方面,从基础知识入手,逐步深入到点云数据处理和2D俯视图构建的理论与实践。文章详细阐述了点云数据预处理的技巧以及如何将三维点云数据映射到二维平面的过程。通过对映射算法的案例分析,本文展示了在实际应用中如何优化这些算法,并对其未来应用前景进行了展望。本文旨在为研究者和工程师提供一个全面的关于激光雷达点云映射技术的参考资料,以便更好地理解、应用和改进相关算法。

# 关键字

激光雷达;点云数据;2D映射;数据预处理;俯视图构建;映射算法优化

参考资源链接:[激光雷达点云2D映射:俯视图与前视图的投影方法](https://wenku.csdn.net/doc/5012pnok69?spm=1055.2635.3001.10343)

# 1. 激光雷达点云基础知识

## 简介

激光雷达(LiDAR)通过发射激光脉冲来测量反射回来的光来确定目标与自身的距离,这种技术生成的三维坐标数据集称为点云。点云是激光雷达系统最重要的输出形式,它在测绘、遥感、三维建模等众多领域有着广泛的应用。

## 点云的生成

点云数据是由激光雷达系统收集的三维空间中的一系列点组成的集合,每个点都包含有其在空间中的精确位置信息(X、Y、Z坐标)及反射强度等属性。这些数据点是在扫描目标区域时按一定密度采集而成,能够高度还原被扫描物体或场景的形状和结构。

## 点云数据的特点

点云数据具有点密度高、信息丰富、可以实现高精度测量等特点。然而,点云数据量巨大,对存储和处理提出了更高的要求。未经处理的原始点云数据通常含有噪声和不规则分布的问题,需要进行滤波、去噪等预处理步骤以提高数据质量。

```plaintext

// 示例代码块,非实际操作代码

// 点云数据的简单格式示例

// x, y, z, intensity

1024.1, 1130.3, 98.1, 125

1024.2, 1130.4, 98.2, 126

```

激光雷达点云数据是三维重建和环境感知的基础,而其后续处理与分析,则是提取有用信息的关键步骤。

# 2. 点云到2D映射的理论基础

点云数据是通过激光雷达扫描物体表面所获得的空间点集。这些点反映了物体表面的物理特性,例如距离、反射率等。要将三维空间中的点云数据映射到二维平面,就需要理解点云到2D映射的理论基础。

## 点云数据的坐标系和空间变换

三维点云数据通常由一系列(x, y, z)坐标组成,表示扫描到的物体表面上的点。而2D映射通常是将这些点投影到一个特定的二维平面,如地面平面。因此,需要进行坐标转换,涉及到从世界坐标系到图像平面坐标的映射。

### 坐标转换的基本理论

点云数据的2D映射需要从三维空间坐标系(x, y, z)转换到二维图像坐标系(u, v)。这个过程包含以下步骤:

1. 平移变换:将点云中的点相对于某个参考点进行平移。

2. 旋转变换:根据雷达的放置角度,将点云进行旋转,使其符合世界坐标系。

3. 缩放变换:根据实际应用需要,可能需要对点云进行缩放以适应映射比例。

4. 投影变换:最后,需要将三维坐标投影到二维平面上。

### 数学模型的建立

要建立一个准确的数学模型,可以使用齐次坐标表示法。通过构建一个4x4的变换矩阵,将三维坐标变换为二维坐标。公式如下:

```

[ u ]

[ v ]

[ 1 ] = [ R11 R12 R13 Tx ] * [ x ]

[ y ] [ R21 R22 R23 Ty ] [ y ]

[ 1 ] [ R31 R32 R33 Tz ] [ z ]

[ 0 0 0 1 ]

```

这里,R矩阵代表旋转,T代表平移,而u和v代表了变换后的二维坐标。

## 2D映射技术的分类

点云数据到2D映射可以使用多种技术,最常见的是正射投影和透视投影。

### 正射投影

正射投影是将三维点直接投影到2D平面,不考虑透视效果。该方法用于获取没有变形的俯视图。其数学表达式为:

```

u = x / z

v = y / z

```

### 透视投影

透视投影则模拟了人眼或相机的视觉效果,更符合真实世界的透视现象。在该方法中,远处的物体看起来更小。数学表达式为:

```

u = f * x / z

v = f * y / z

```

其中,f为焦距。

## 应用实例分析

为了更好地理解点云到2D映射的过程,我们可以考虑一个实际的应用场景,例如自动驾驶车辆的激光雷达系统。

### 自动驾驶车辆中的应用

在自动驾驶技术中,车辆依赖于激光雷达来获取周围环境的三维信息。将这些信息映射为2D图像对于路径规划和障碍物检测至关重要。以下是几个映射步骤:

1. 获取点云数据:通过激光雷达扫描周围环境,收集点云数据。

2. 坐标转换:将雷达坐标系下的点云数据转换到车辆坐标系中。

3. 投影映射:根据所需的视角(如前视、侧视、俯视等),选择合适的映射技术将三维数据映射到二维平面。

4. 数据处理:在2D图像上执行图像处理操作,例如滤波、边缘检测等。

通过以上的步骤,车辆可以获取到简化的2D地图,进一步用于计算路径和规避障碍物。

## 本章小结

本章深入探讨了点云数据到2D平面映射的理论基础。从坐标系的转换到不同类型映射技术的应用,提供了对实现点云二维化的系统性理解。这些理论为实践中的映射算法的开发和应用奠定了坚实的基础。

# 3. 点云数据预处理技巧

## 引言

在激光雷达点云数据的实际应用中,数据的质量直接影响到后续处理的准确性和效率。数据预处理作为数据处理流程的第一步,其重要性不言而喻。良好的预处理可以去除噪声,纠正误差,从而提高点云数据的可用性,为后续的映射和分析打下坚实的基础。本章将详细介绍点云数据预处理的各种技巧。

## 去噪技巧

### 空间滤波法

空间滤波是一种常用的点云去噪方法。它通过在空间域内对每个点周围一定范围内的点进行分析,来判断该点是否为噪声。常见的空间滤波算法包括均值滤波、中值滤波和自适应滤波等。

均值滤波通过取周围点的均值位置来替换噪声点,这种方法可以有效减少孤立的噪声点,但对于点云的边界可能造成模糊。中值滤波则选取周围点的中值位置替换噪声点,这种方法对尖锐边缘和细节保留更好,但可能会保留一些噪声。自适应滤波综合考虑了邻域点的分布情况,能够更加精确地定位噪声。

### 代码展示与解析

以下是一个使用中值滤波的简单Python示例代码。这个例子使用了`laspy`库来读取和写入LAS文件,以及`numpy`进行数学运算。

```python

import laspy

import numpy as np

def median_filter(input_file, output_file, window_size):

# 读取点云数据

las = laspy.file.File(input_file, mode="r")

# 创建用于保存过滤结果的数组

x_filtered = np.zeros(las.x.size, dtype=np.float64)

y_filtered = np.zeros(las.y.size, dtype=np.float64)

z_filtered = np.zeros(las.z.size, dtype=np.float64)

# 使用中值滤波

for i in range(las.x.size):

# 选取窗口内的点

points_in_window = np.array([las.x[i], las.y[i], las.z[i]]) + \

np.array([las.x, las.y, las.z]) - \

np.array([las.x[i], las.y[i], las.z[i]])

points_in_window = points_in_window[np.abs(points_in_window) <= window_size]

# 计算中值

median = np.median(points_in_window, axis=1)

x_filtered[i], y_filtered[i], z_filtered[i] = median

# 创建输出的LAS文件

with laspy.file.File(output_file, mode="w", header=las.header) as las_out:

las_out.x = x_filtered

las_out.y = y_filtered

las_out.z = z_filtered

for dimension in las.point_format.dimensions:

las_out.add_dimension(dimension, idx=las_out.point_format.index(dimension.name))

# 调用函数,窗口大小设为3

median_filter('input.las', 'output.las', 3)

```

在上述代码中,`median_filter`函数接收输入文件名、输出文件名和窗口大小作为参数,读取点云数据,并对其x、y、z坐标分别进行中值滤波处理。处理完毕后,将滤波后的数据写入新的LAS文件。在逻辑分析中,中值滤波通过选取邻近点的坐标值,计算其统计中值来达到去噪的目的。

### 高频噪声的抑制

高频噪声在点云数据中表现为许多不规则的小波纹或尖峰,这些噪声在数据采集过程中由于激光雷达的测量误差、表面粗糙度等因素产生。为了去除这些高频噪声,可以采用低通滤波器。

## 数据裁剪

### 用途和方法

数据裁剪是为了降低后续处理的数据量以及去除无关的数据区域,提高处理效率。在实际应用中,可能只需要处理特定区域的点云数据,因此裁剪可以有效地排除不需要的点云部分。

### 基于空间矩形区域的裁剪

基于空间矩形区域的裁剪是最简单且常用的一种方法。首先需要确定裁剪区域的边界坐标,然后选择落在这个边界内的点云数据,丢弃其他部分。

### 代码展示与解析

以下是一个裁剪点云数据至特定空间矩形区域的Python代码示例。

```python

import laspy

import numpy as np

def clip_lidar_data(input_file, output_file, min_x, max_x, min_y, max_y, min_z, max_z):

las = laspy.file.File(input_file, mode="r")

x_filtered = np.array(las.x)

y_filtered = np.array(las.y)

z_filtered = np.array(las.z)

clipped_x = x_filtered[(x_filtered >= min_x) & (x_filtered <= max_x)]

clipped_y = y_filtered[(y_filtered >= min_y) & (y_filtered <= max_y)]

clipped_z = z_filtered[(z_filtered >= min_z) & (z_filtered <= max_z)]

clipped_points = np.column_stack((clipped_x, clipped_y, clipped_z))

with laspy.file.File(output_file, mode="w", header=las.header) as las_out:

las_out.points = las.points[las_x >= min_x]

las_out.points = las.points[las_x <= max_x]

las_out.points = las.points[las_y >= min_y]

las_out.points = las.points[las_y <= max_y]

las_out.points = las.points[las_z >= min_z]

las_out.points = las.points[las_z <= max_z]

las_out.close()

clip_lidar_data('input.las', 'clipped_output.las', -100, 100, -100, 100, 0, 50)

```

在这段代码中,`clip_lidar_data`函数通过设定x、y、z的边界值来筛选出落在矩形区域内的点。通过读取LAS文件中的点坐标信息,并使用numpy数组的条件筛选功能,最终将筛选后的数据写入新的LAS文件。参数`min_*`和`max_*`定义了裁剪区域的边界。

## 强化算法选择与应用

### 基于局部点密度的滤波

点云数据往往包含不同密度的信息,局部点密度滤波算法通过评估每个点周围的点密度来决定是否保留该点。如果点的局部密度低于某个阈值,则该点可能被视为噪声并被去除。这种方法的优点是可以适应不同密度的点云数据。

### 基于统计的滤波

基于统计的滤波方法会计算点云数据的统计特性,比如均值、中值、标准差等。异常值是根据统计特性来识别的,保留的点云数据将更具有代表性和一致性。

## 结论

点云数据预处理的技巧多种多样,需要根据具体的应用场景选择合适的方法。无论是去噪、裁剪还是滤波,目标都是为了得到更为干净和准确的点云数据,为接下来的2D俯视图构建和映射算法的实现提供坚实的基础。本章介绍了几种常见且有效的点云数据预处理技巧,配合具体的代码示例和逻辑分析,希望读者能够在实际工作中灵活应用,提高工作效率和数据处理质量。

# 4. 2D俯视图构建方法

## 4.1 点云数据转换为2D图像的预处理步骤

构建2D俯视图的第一步是将点云数据转换为可以在2D空间中处理的格式。预处理包括以下关键步骤:

### 4.1.1 数据清洗

数据清洗是预处理阶段的首要任务,涉及去除噪声和无效数据,这对提升最终俯视图质量至关重要。根据激光雷达系统特性和环境因素,点云中可能包含离群点和干扰信号,例如反射不正常的点。

```mermaid

graph LR

A[原始点云数据] --> B[识别离群点]

B --> C[移除噪声]

C --> D[填补空洞]

D --> E[数据对齐]

```

上述流程图展示了点云数据清洗步骤。首先识别出离群点,然后移除噪声,填补空洞,并进行数据对齐。对齐过程中,可能需要进行坐标变换,确保数据在同一坐标系下。

### 4.1.2 数据投影

清洗后的点云数据需要投影到二维平面上。通常情况下,采用透视投影或正投影的方式将三维点云映射到二维图像上。

```mermaid

graph LR

A[清洗后的点云数据] --> B[选择投影方法]

B --> C[透视投影]

B --> D[正投影]

C --> E[生成俯视图]

D --> E[生成俯视图]

```

在选择投影方法时,根据实际应用场景的不同,透视投影能更真实地模拟人类视觉,适用于需要模拟真实视觉场景的应用;而正投影则适用于需要精确度量的应用场景。

### 4.1.3 栅格化处理

投影之后的数据需要栅格化处理,转换为像素值。这个步骤包括确定图像尺寸、分辨率为映射后的点云数据创建一个网格,并将点云数据映射到对应像素上。

```python

import numpy as np

import matplotlib.pyplot as plt

# 假设我们有一组清洗后的三维点云数据

points_3d = np.array([

[x1, y1, z1],

[x2, y2, z2],

# ...更多点...

])

# 设定栅格化参数,如俯视图尺寸和分辨率

image_size = (500, 500) # 例如500x500像素

resolution = 0.1 # 每个像素代表的实际世界中的距离单位

# 栅格化处理

def rasterize(points, image_size, resolution):

min_x = np.min(points[:, 0])

max_x = np.max(points[:, 0])

min_y = np.min(points[:, 1])

max_y = np.max(points[:, 1])

# 计算俯视图中每个像素的起始坐标

x_range = int((max_x - min_x) / resolution)

y_range = int((max_y - min_y) / resolution)

# 初始化二维数组,代表俯视图的像素

image = np.zeros((y_range, x_range))

# 对每个点进行映射

for point in points:

x_idx = int((point[0] - min_x) / resolution)

y_idx = int((point[1] - min_y) / resolution)

image[y_idx, x_idx] = 1 # 假设1代表有物体,0代表无物体

return image

# 生成2D俯视图

raster_image = rasterize(points_3d, image_size, resolution)

# 显示图像

plt.imshow(raster_image, cmap='gray')

plt.show()

```

上述Python代码块展示了如何将3D点云数据栅格化处理为2D图像。其中,`rasterize`函数接受点云数据、图像尺寸和分辨率参数,通过将点云数据映射到像素坐标并赋予相应的值,生成最终的2D俯视图。

### 4.1.4 数据增强

为了提高2D俯视图的质量和算法的鲁棒性,可能需要进行数据增强。数据增强包括平移、旋转、缩放等操作。

```python

def augment_data(image):

# 随机平移图像

horizontal_shift = np.random.randint(-10, 10)

vertical_shift = np.random.randint(-10, 10)

# 旋转图像

angle = np.random.uniform(-15, 15)

# 缩放图像

scale = np.random.uniform(0.9, 1.1)

# 应用变换

rotated_image = scipy.ndimage.rotate(image, angle, reshape=False, mode='nearest')

translated_image = scipy.ndimage.shift(rotated_image, (vertical_shift, horizontal_shift), mode='nearest')

scaled_image = scipy.ndimage.zoom(translated_image, scale, mode='nearest')

return scaled_image

# 增强图像示例

augmented_image = augment_data(raster_image)

plt.imshow(augmented_image, cmap='gray')

plt.show()

```

这段代码演示了对生成的俯视图进行随机变换以模拟现实世界的变化,增强模型的泛化能力。

## 4.2 投影算法的选择与实现

### 4.2.1 投影算法对比

选择正确的投影算法对于2D俯视图的精确度和实用性至关重要。投影算法包括透视投影和正投影,它们各自有不同的优缺点,下面表格展示这两种算法的对比情况:

| 特性 | 透视投影 | 正投影 |

| --- | --- | --- |

| 复杂度 | 较高 | 较低 |

| 真实感 | 较强 | 较弱 |

| 计算速度 | 较慢 | 较快 |

| 适用场景 | 视觉模拟、增强现实 | 工程测量、环境建模 |

| 实现难度 | 较难 | 较易 |

选择投影算法时,需要根据具体的应用需求来决定。例如,对于需要模拟真实视觉场景的应用,透视投影会是更好的选择;而在需要精确度量的应用中,正投影更适用。

### 4.2.2 投影算法的Python实现

接下来,通过实际代码展示如何在Python中实现这两种投影算法。

#### 4.2.2.1 透视投影算法实现

透视投影通常较为复杂,因为它需要考虑观察者的位置、观察方向以及观察者与被观察物体之间的距离等因素。

```python

import numpy as np

from mpl_toolkits.mplot3d import Axes3D

# 假设我们有一个观察者视角

observer_position = np.array([0, 0, 10]) # 观察者位置(0, 0, 10)

view_direction = np.array([0, 0, -1]) # 观察方向为-z轴

# 假设有一组三维点

points_3d = np.array([

[x1, y1, z1],

[x2, y2, z2],

# ...更多点...

])

# 计算每个点到观察者的视线

directions = points_3d - observer_position

directions /= np.linalg.norm(directions, axis=1).reshape(-1, 1)

# 计算透视投影点

projected_points = observer_position + directions * 10 # 假设10为观察距离

# 生成2D图像(这里仅作为示例,实际还需栅格化步骤)

fig = plt.figure()

ax = fig.add_subplot(111, projection='3d')

ax.scatter(projected_points[:, 0], projected_points[:, 1], projected_points[:, 2])

ax.set_xlabel('X axis')

ax.set_ylabel('Y axis')

ax.set_zlabel('Z axis')

plt.show()

```

上述代码模拟了从一个给定观察者位置对3D空间中的点进行透视投影的过程。最终生成的3D散点图在真实视觉模拟中有一定的参考价值。

#### 4.2.2.2 正投影算法实现

正投影算法相对简单,它不考虑观察者的视角,直接将三维坐标映射到二维平面上。

```python

# 继续使用之前的points_3d数据

# 正投影算法只需要直接忽略z轴的深度信息,将其映射到二维平面上即可

projected_points_2d = points_3d[:, :2] # 忽略z坐标

# 生成2D图像(这里仅作为示例,实际还需栅格化步骤)

plt.scatter(projected_points_2d[:, 0], projected_points_2d[:, 1])

plt.xlabel('X axis')

plt.ylabel('Y axis')

plt.show()

```

这段代码将点云数据的z轴信息丢弃,直接在二维平面展示,这在精确度量中非常有用。

### 4.2.3 投影算法对最终结果的影响

不同的投影算法会对最终的2D俯视图带来不同的影响。透视投影可以提供更贴近人类视觉的图像,但容易受到距离和视点的影响导致变形。正投影则能够提供变形最小的图像,适合用于精确测量,但缺乏透视感。

## 4.3 栅格化处理与结果优化

### 4.3.1 栅格化处理方法

栅格化处理是指将点云数据转换为规则的像素值的过程。在生成俯视图时,需要确定图像的尺寸以及分辨率,然后为每个像素赋予相应的值。

```python

import numpy as np

# 假设我们有清洗后的三维点云数据

points_3d = np.array([

[x1, y1, z1],

[x2, y2, z2],

# ...更多点...

])

# 设定栅格化参数,例如俯视图尺寸和分辨率

image_size = (500, 500) # 500x500像素

resolution = 0.1 # 每个像素代表的实际世界中的距离单位

# 栅格化处理

def rasterize(points, image_size, resolution):

min_x = np.min(points[:, 0])

max_x = np.max(points[:, 0])

min_y = np.min(points[:, 1])

max_y = np.max(points[:, 1])

# 计算俯视图中每个像素的起始坐标

x_range = int((max_x - min_x) / resolution)

y_range = int((max_y - min_y) / resolution)

# 初始化二维数组,代表俯视图的像素

image = np.zeros((y_range, x_range))

# 对每个点进行映射

for point in points:

x_idx = int((point[0] - min_x) / resolution)

y_idx = int((point[1] - min_y) / resolution)

image[y_idx, x_idx] = 1 # 假设1代表有物体,0代表无物体

return image

# 生成2D俯视图

raster_image = rasterize(points_3d, image_size, resolution)

```

上述代码块中定义了一个`rasterize`函数,它根据输入的点云数据、图像尺寸和分辨率生成了一个2D的俯视图。

### 4.3.2 结果优化策略

在栅格化处理之后,为了提高图像的质量和可用性,可以采取以下几种优化策略:

- 空洞填补:由于点云密度不均或遮挡等问题,栅格化后可能在图像上留下空洞,可以采用插值方法填补。

- 二值化处理:为区分物体和背景,通常需要将图像进行二值化处理。

- 边缘增强:通过边缘检测算法增强物体轮廓,使物体形状更加清晰。

```python

from scipy.ndimage import binary_fill_holes

from skimage.filters import threshold_otsu

from skimage.feature import canny

# 空洞填补

filled_image = binary_fill_holes(raster_image)

# 二值化处理

threshold_value = threshold_otsu(filled_image)

binary_image = filled_image > threshold_value

# 边缘增强

edges = canny(binary_image)

# 展示最终结果

fig, axs = plt.subplots(1, 3, figsize=(15, 5))

axs[0].imshow(raster_image, cmap='gray')

axs[0].set_title('原始栅格化图像')

axs[1].imshow(filled_image, cmap='gray')

axs[1].set_title('填补空洞后的图像')

axs[2].imshow(edges, cmap='gray')

axs[2].set_title('边缘增强后的图像')

plt.show()

```

通过代码展示上述优化策略的实际应用。先填补了栅格化图像的空洞,然后进行二值化处理,最后应用边缘检测增强物体轮廓。这些优化步骤对于提升图像质量和清晰度有显著作用。

## 4.4 可视化工具与技术

### 4.4.1 数据可视化库的选择

为了可视化2D俯视图和中间处理结果,选择合适的库至关重要。常用的数据可视化库有:

- Matplotlib:适合绘制各种静态、动态、交互式的图表。

- Seaborn:基于Matplotlib,提供了更高级的接口和更美观的默认样式。

- OpenCV:在计算机视觉和图像处理方面有很强的能力。

### 4.4.2 可视化代码示例

下面将展示如何使用Matplotlib库将2D俯视图和中间处理结果进行可视化。

```python

import matplotlib.pyplot as plt

# 假设我们有一系列中间处理结果

intermediate_results = [raster_image, filled_image, binary_image, edges]

# 可视化中间处理结果

fig, axs = plt.subplots(1, 4, figsize=(20, 5))

for i in range(4):

axs[i].imshow(intermediate_results[i], cmap='gray')

axs[i].set_title(f'Result {i+1}')

plt.show()

```

通过上述代码,我们可以将中间处理结果以图表的形式展示出来,方便观察每一步操作带来的影响,并进一步调整参数。

## 4.5 本章小结

第四章主要介绍了构建2D俯视图的核心方法,包括点云数据转换、投影算法的选择、栅格化处理、结果优化以及可视化技术。通过这些步骤,点云数据被有效地转换为2D图像,为后继的分析和应用提供了基础。在下一章中,将探讨映射算法的实践应用和优化策略,以及进一步的应用前景。

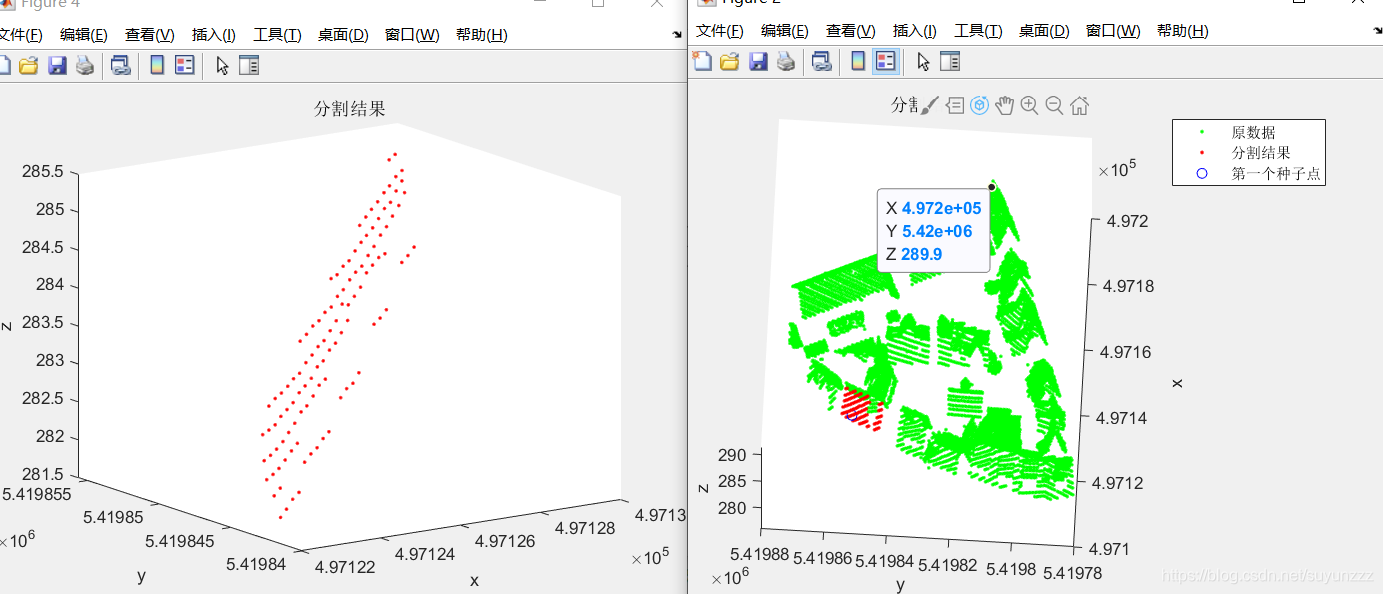

# 5. 映射算法的实践与案例分析

映射算法是将三维激光雷达点云数据转换为二维或三维空间中可用形式的关键技术。这种转换不仅涉及数据的解析,还包含实际应用中的复杂场景,比如环境建模、自动驾驶汽车的路径规划、机器人导航等。本章将深入探讨映射算法的实践应用,分析不同类型的案例,并展示如何针对具体问题进行算法优化。

## 映射算法的实践应用

在实际应用中,映射算法需要解决的一个核心问题是将激光雷达的点云数据转换成一个二维地图,即2D俯视图。这个过程通常包括点云处理、环境建模和地图更新等步骤。下面详细探讨这些关键步骤的实现方法和应用场景。

### 点云处理

点云处理是映射算法的首要步骤,涉及噪声去除、地面点分离、特征提取等环节。高效的点云处理可以为后续的映射工作提供更加准确的基础数据。

#### 噪声去除

在激光雷达的测量过程中,由于外界因素的影响,采集的点云数据中往往包含噪声。噪声去除是点云处理中的一个关键步骤,常用的去噪方法包括统计滤波、中值滤波等。

```python

import numpy as np

import open3d as o3d

def remove_noise(points, nb_neighbors, std_ratio):

"""

Remove noise from point cloud using statistical outlier removal method.

Parameters:

points: numpy.array

The input point cloud data.

nb_neighbors: int

The number of neighboring points to use for computing the mean distance.

std_ratio: float

The standard deviation ratio used to identify outliers.

Returns:

numpy.array

The denoised point cloud data.

"""

pcd = o3d.geometry.PointCloud()

pcd.points = o3d.utility.Vector3dVector(points)

pcd = pcd.remove_statistical_outlier(nb_neighbors=nb_neighbors, std_ratio=std_ratio)[0]

return np.asarray(pcd.points)

# Example usage:

# noisy_points = ...

# denoised_points = remove_noise(noisy_points, nb_neighbors=30, std_ratio=2.0)

```

在上述代码中,我们使用了`open3d`库的`remove_statistical_outlier`方法来去除点云数据中的噪声。此方法根据点与其邻域点的平均距离和标准差来识别并移除异常值。

### 地面点分离

地面点分离在室外环境映射中尤为重要,因为地面点通常占点云的大多数,但在建图中往往不是重点。地面点分离有助于减少不必要的数据处理,提高建图效率。

```python

def separate_ground_points(points, max_angle=15):

"""

Separate ground points from point cloud data.

Parameters:

points: numpy.array

The input point cloud data.

max_angle: float

The maximum angle between the point normal and the ground plane to be considered as ground points.

Returns:

numpy.array

The ground points in the point cloud data.

"""

pcd = o3d.geometry.PointCloud()

pcd.points = o3d.utility.Vector3dVector(points)

plane_model, inliers = pcd.segment_plane(distance_threshold=0.01,

ransac_n=3,

num_iterations=1000,

max_angle=max_angle)

return np.asarray(pcd.points)[inliers]

# Example usage:

# point_cloud = ...

# ground_points = separate_ground_points(point_cloud, max_angle=15)

```

本代码片段使用了`open3d`的`segment_plane`方法,该方法基于随机抽样一致性(RANSAC)算法,能有效地从点云数据中提取出地面点。

### 特征提取

在点云数据中提取特征点,对于环境理解及定位导航非常重要。特征点包括角点、边缘点等,它们可以帮助算法更好地理解环境。

```python

def extract_features(points, radius_search=0.02, num_neighbors=10):

"""

Extract feature points from point cloud using the fast point feature histogram (FPFH) algorithm.

Parameters:

points: numpy.array

The input point cloud data.

radius_search: float

Radius to search for neighbors.

num_neighbors: int

The number of neighbors to use for the feature computation.

Returns:

numpy.array

The extracted features.

"""

pcd = o3d.geometry.PointCloud()

pcd.points = o3d.utility.Vector3dVector(points)

pcd.estimate_normals(search_param=o3d.geometry.KDTreeSearchParamHybrid(

radius=radius_search, max_nn=num_neighbors))

features = o3d.pipelines.registration.compute_fpfh_feature(

pcd,

o3d.geometry.KDTreeSearchParamHybrid(radius=radius_search, max_nn=num_neighbors))

return np.asarray(features.data)

# Example usage:

# point_cloud = ...

# feature_points = extract_features(point_cloud, radius_search=0.02, num_neighbors=10)

```

通过`open3d`的`compute_fpfh_feature`方法,我们可以计算得到每个点的快速点特征直方图(FPFH),用于后续的特征匹配和定位。

## 环境建模

环境建模是将处理好的点云数据转换成可用的环境模型。这一过程涉及到多个步骤,包括地图初始化、数据关联、状态估计等。

### 地图初始化

地图初始化是环境建模的第一步,它涉及到创建一个新的地图或加载一个已有的地图。在自动驾驶系统中,地图通常被存储为一系列的点或线,代表道路、障碍物等。

```python

def initialize_map():

"""

Initialize a new map for localization.

Returns:

Map

A new empty map object.

"""

# Initialize a map object

new_map = Map()

return new_map

# Example usage:

# empty_map = initialize_map()

```

在这段伪代码中,我们定义了一个`initialize_map`函数来创建一个新的地图对象。具体实现依赖于实际应用中地图的数据结构。

### 数据关联

数据关联是确定新采集的点云数据与已有地图之间的对应关系。该步骤能够提高环境建模的准确性。

```python

def data_association(new_points, map_points):

"""

Associate new point cloud data to the existing map data.

Parameters:

new_points: numpy.array

The newly acquired point cloud data.

map_points: numpy.array

The points in the existing map.

Returns:

Associations

The associations between the new points and the map points.

"""

# Apply a registration algorithm, e.g., ICP (Iterative Closest Point)

reg_p2p = o3d.pipelines.registration.registration_icp(

o3d.geometry.PointCloud(o3d.utility.Vector3dVector(new_points)),

o3d.geometry.PointCloud(o3d.utility.Vector3dVector(map_points)),

max_correspondence_distance=0.05,

estimation_method=o3d.pipelines.registration.TransformationEstimationPointToPoint())

# Compute the associations based on the registration result

associations = compute_associations(reg_p2p.transformation)

return associations

# Example usage:

# associations = data_association(new_points, map_points)

```

在这段示例代码中,我们使用了`open3d`的`registration_icp`方法来进行点云数据的关联。这是一种基于迭代最近点(ICP)算法的数据配准方法,能够找到新旧点云数据之间的最佳匹配关系。

### 状态估计

状态估计是动态环境中地图更新的关键步骤。通过状态估计,可以预测物体的未来位置,并在地图上更新物体的位置信息。

```python

def estimate_state(new_measurements):

"""

Estimate the current state of the environment.

Parameters:

new_measurements: numpy.array

The latest measurements from the sensors.

Returns:

State

The estimated state of the environment.

"""

# Apply a state estimation algorithm, e.g., Kalman Filter

estimated_state = kalman_filter.predict(new_measurements)

return estimated_state

# Example usage:

# current_state = estimate_state(new_measurements)

```

该代码片段展示了使用卡尔曼滤波器(Kalman Filter)进行状态估计的示例。在实际应用中,状态估计方法的选择取决于环境的动态特性和传感器的种类。

## 地图更新

地图更新是指在环境建模的过程中,根据新采集的数据不断修正和更新地图的过程。这一过程包括局部更新和全局更新,以及地图融合和一致性维护。

### 局部更新

局部更新主要针对地图中那些发生变化的区域,比如新出现的障碍物或者移动的物体。局部更新能够使地图保持时效性,适应环境变化。

```python

def local_map_update(map, new_data, affected_region):

"""

Update the map only in the region affected by new data.

Parameters:

map: Map

The current map object.

new_data: numpy.array

The new point cloud data to update the map.

affected_region: Region

The region of the map that is affected by the new data.

Returns:

Map

The updated map object.

"""

# Update the map in the affected region

map.update_region(affected_region, new_data)

return map

# Example usage:

# updated_map = local_map_update(current_map, new_data, affected_region)

```

在这段伪代码中,我们定义了一个`local_map_update`函数来实现局部地图更新。在实际应用中,这可能涉及到复杂的图割(Graph Cut)算法或局部ICP算法。

### 全局更新

全局更新则是指对整个地图进行更新。当有足够多的新信息收集时,全局更新可以修正地图中的累积误差,提高地图的全局一致性。

```python

def global_map_update(map, all_new_data):

"""

Update the entire map with all the new data collected.

Parameters:

map: Map

The current map object.

all_new_data: numpy.array

All the new point cloud data to update the entire map.

Returns:

Map

The updated map object.

"""

# Perform a global update on the map

map = map.update(all_new_data)

return map

# Example usage:

# updated_map = global_map_update(current_map, all_new_data)

```

上述示例中,我们展示了如何使用`update`方法对整个地图进行全局更新。全局更新需要综合考虑新旧数据的一致性,并可能需要重新进行数据关联和状态估计。

## 案例分析

### 案例一:自动驾驶汽车的环境建模

自动驾驶汽车使用的映射算法需要实时处理和更新环境地图,以保证行车安全。一个典型的案例涉及利用激光雷达和相机数据,进行动态障碍物的检测和规避。

```python

# Pseudo code for autonomous driving environment modeling

def driveCAR(point_cloud_data, camera_data):

# Process point cloud data

processed_points = process_point_cloud(point_cloud_data)

# Detect and track dynamic obstacles

dynamic_obstacles = detect_dynamic_obstacles(processed_points, camera_data)

# Plan a path that avoids the dynamic obstacles

safe_path = plan_path(processed_points, dynamic_obstacles)

# Execute the path

execute_path(safe_path)

# Update the map based on new data

car_map = local_map_update(car_map, processed_points)

return car_map

# Example usage:

# updated_map = driveCAR(point_cloud_data, camera_data)

```

这段伪代码简要描述了一个自动驾驶汽车环境建模的过程。实际的实现会更加复杂,需要集成更多的传感器数据,并使用高级的算法来确保处理速度和精度。

### 案例二:室内导航机器人地图构建

对于室内导航机器人来说,建立一个准确的地图是实现有效导航的基础。这类映射算法通常需要处理复杂室内环境的多个层次,并且能够不断更新地图以适应家具摆设的变动。

```python

# Pseudo code for indoor robot mapping

def build IndoorMap(lidar_data):

# Process point cloud data from lidar

indoor_map = initialize_map()

for data in lidar_data:

# Update map based on new scan data

indoor_map = update_map(indoor_map, data)

return indoor_map

# Example usage:

# indoor_map = buildIndoorMap(lidar_data)

```

这个示例展示了室内导航机器人如何使用激光雷达数据构建地图。此过程涉及多帧数据的整合,以及不断迭代更新地图以适应环境变化。

## 映射算法的优化

随着应用场景的不断拓宽,映射算法的优化需求日益增长。本节将探讨一些常见的映射算法优化方法,包括数据融合、算法并行化和机器学习的应用等。

### 数据融合

数据融合是将来自不同传感器的数据综合起来,以提供更丰富、更可靠的环境信息。例如,激光雷达与摄像头数据的融合,可以用于提高障碍物检测的准确性。

```python

def data_fusion(lidar_data, camera_data):

"""

Combine data from lidar and camera sensors to improve the accuracy of obstacle detection.

Parameters:

lidar_data: numpy.array

The point cloud data from the lidar sensor.

camera_data: numpy.array

The image data from the camera sensor.

Returns:

FusedData

The fused data from both sensors.

"""

# Process the data separately

processed_lidar = process_lidar_data(lidar_data)

processed_camera = process_camera_data(camera_data)

# Combine the processed data

fused_data = combine_processed_data(processed_lidar, processed_camera)

return fused_data

# Example usage:

# fused_data = data_fusion(lidar_data, camera_data)

```

### 算法并行化

算法并行化是利用多核处理器或多处理器系统,同时执行算法中的多个独立任务,从而提升算法的运行效率。

```python

def parallel_processing(data):

"""

Parallelize the processing of the point cloud data to speed up the algorithm.

Parameters:

data: numpy.array

The point cloud data to be processed.

Returns:

numpy.array

The processed data.

"""

# Split data into chunks

chunks = split_data_into_chunks(data)

# Process each chunk in parallel

processed_chunks = parallel_execute PROCESSING_FUNCTION on chunks

# Combine results from chunks

processed_data = combine_processed_chunks(processed_chunks)

return processed_data

# Example usage:

# processed_data = parallel_processing(point_cloud_data)

```

### 机器学习的应用

机器学习,尤其是深度学习,在映射算法中的应用日益广泛。例如,深度学习模型可以用于从数据中学习特征表示,提高特征提取的准确性。

```python

def deep_learning_feature_extraction(points):

"""

Extract features from point cloud data using a deep learning model.

Parameters:

points: numpy.array

The input point cloud data.

Returns:

numpy.array

The features extracted by the deep learning model.

"""

# Load pre-trained deep learning model

model = load_pretrained_model('pointnet')

# Use the model to extract features

features = model.extract_features(points)

return features

# Example usage:

# deep_learning_features = deep_learning_feature_extraction(point_cloud_data)

```

## 总结

映射算法的实践与案例分析展示了从数据处理到环境建模的整个过程。通过具体案例,我们了解了映射算法在实际应用中的运作方式。针对不同应用场景,映射算法需要进行相应的优化,以提高其准确性和效率。未来的发展趋势将朝着更智能、更自适应的方向演进,这将为IT行业和相关行业带来更多的创新机遇。

# 6. 映射算法的优化与应用前景

## 映射算法优化的必要性

映射算法的优化对于提升数据处理效率、减少错误和提高系统整体性能至关重要。随着数据量的增加以及应用复杂性的提高,优化算法能够降低资源消耗,加快处理速度,进而提高应用的可行性和用户体验。下面我们将讨论一些常见的映射算法优化策略。

## 算法优化策略

### 精简数据点

在保证精度的前提下,通过减少数据点的数量来优化算法性能是一种常见方法。这可以通过聚类、降采样等技术实现,减少计算量。

```python

# 示例:使用随机抽样的方法减少点云数据量

from sklearn.cluster import KMeans

import numpy as np

def reduce_point_cloud(points, num_clusters):

kmeans = KMeans(n_clusters=num_clusters)

kmeans.fit(points)

return kmeans.cluster_centers_

```

### 优化数据结构

利用高效的数据结构,如KD树、八叉树等,可以大幅降低查找和邻近搜索的复杂度,从而优化映射算法的执行效率。

```python

# 示例:使用KD树进行空间搜索

from scipy.spatial import KDTree

def build_kd_tree(points):

return KDTree(points)

```

### 多线程和并行处理

通过使用多线程或并行处理技术,可以充分调动多核处理器资源,加速算法处理过程,特别是在进行大规模点云数据处理时效果显著。

```python

# 示例:使用Python的multiprocessing模块实现并行处理

from multiprocessing import Pool

def process_point(point):

# 处理单个点的逻辑

pass

def parallel_process(points):

with Pool() as pool:

pool.map(process_point, points)

```

### 硬件加速

利用GPU或其他专用硬件加速器进行算法加速可以极大提升数据处理速度,尤其在图形渲染和大规模数据并行处理场景中效果显著。

## 映射算法的应用前景

随着自动驾驶、机器人导航、三维建模和虚拟现实等应用领域的快速发展,映射算法的应用前景变得越来越广阔。未来,映射算法将需要适应更加动态和复杂的工作环境,而算法的优化将使得这些应用更加高效和可靠。

### 自动驾驶领域

在自动驾驶领域,精确的环境映射是实现安全导航的关键。映射算法不仅需要处理静态的物理环境,还需要实时响应动态变化的交通情况。

### 机器人导航

机器人在执行任务时,依靠映射算法来识别环境并规划路径。优化后的算法能够提升机器人的自主性和效率。

### 三维建模与虚拟现实

三维扫描和建模技术的进步依赖于高效的映射算法,尤其是在虚拟现实和增强现实应用中,实时、高精度的环境映射是提供真实体验的基石。

### 空间探索与考古

在空间探索或考古等领域,映射算法不仅能够帮助复原未知或古老遗迹的三维结构,还能在分析和保存这些数据方面发挥作用。

## 结语

本章节深入探讨了映射算法的优化策略,并展望了其应用前景。随着技术的进步和市场需求的增加,映射算法正变得越来越重要,优化这些算法将有助于打开更多可能性的大门。

0

0