【YAML与JSON深度对比】:选择最佳数据格式的5大策略(Python实战篇)

发布时间: 2024-10-04 12:30:31 阅读量: 134 订阅数: 32

# 1. 数据序列化格式概述

数据序列化是将结构化数据转化为可存储或可传输的格式的过程。在计算机科学中,这一概念尤为重要,因为它涉及到数据在不同系统或语言之间的交换。序列化格式,如YAML和JSON,通过将数据结构编码为文本格式,简化了存储和通信的复杂性。

**数据序列化的核心优势**包括:

- **可读性**:文本格式的数据更容易被人类阅读和理解。

- **跨平台**:独立于平台和编程语言,易于在多种环境中使用。

- **易于调试**:文本数据格式有助于问题诊断和调试。

在后续章节中,我们将深入探讨YAML和JSON之间的差异,并分析它们在Python中的应用。接下来,我们将通过实战案例来理解这两种格式在实际开发中的选择与应用策略。

# 2. YAML与JSON的理论对比

## 2.1 数据结构的表达差异

### 2.1.1 对象和数组的表示方法

在数据序列化领域,YAML和JSON都支持对象和数组的表示方法,但它们之间存在着明显的表达差异。

YAML使用缩进和冒号`:`来表示键值对,而JSON则使用花括号`{}`和逗号`,`。例如,表示一个对象时,JSON的格式如下:

```json

{

"name": "John",

"age": 30

}

```

而在YAML中,相同的对象可能会这样表示:

```yaml

name: John

age: 30

```

在数组的表示上,JSON使用方括号`[]`,而YAML依旧依赖于缩进来区分数组元素。例如:

```json

[

"apple",

"banana",

"cherry"

]

```

对应的YAML格式如下:

```yaml

- apple

- banana

- cherry

```

### 2.1.2 数据的层级和嵌套

YAML和JSON在数据层级和嵌套方面的表达能力也有所不同。YAML的缩进规则使其在表示层级结构时非常直观,而JSON则通过嵌套的花括号和方括号来实现。

在YAML中,层级关系是通过缩进的空格数来表达的,缩进的一级代表一层。例如:

```yaml

parent:

child1: value1

child2:

grandchild1: value2

```

在JSON中,层级结构则是通过嵌套的括号来实现的:

```json

{

"parent": {

"child1": "value1",

"child2": {

"grandchild1": "value2"

}

}

}

```

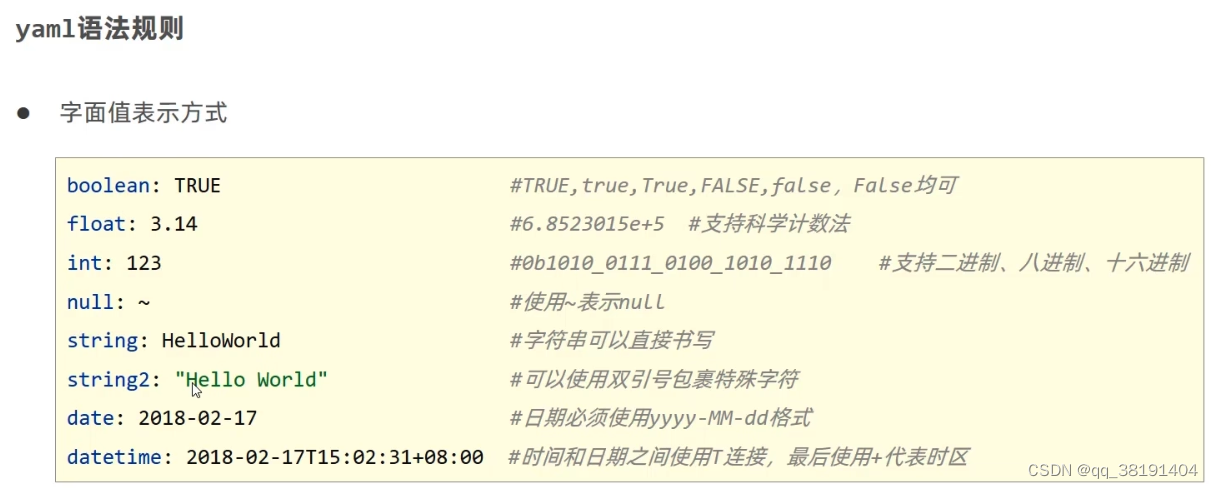

## 2.2 语法规则的比较分析

### 2.2.1 基本语法规则的差异

在基本语法规则方面,YAML和JSON都定义了自己的规则集,它们在键值对的分隔符、数据类型等方面存在差异。

YAML支持的键值对分隔符除了冒号`:`之外,还可以使用问号`?`后跟一个字符串。此外,YAML支持的数据类型更为丰富,包括时间、日期等。例如:

```yaml

question: ? Is YAML better?

answer: !!str No.

date: 2023-01-15

```

在JSON中,键值对必须使用冒号`:`分隔,且不支持上述YAML中使用的扩展数据类型:

```json

{

"question": "Is YAML better?",

"answer": "No.",

"date": "2023-01-15"

}

```

### 2.2.2 注释和空白字符的处理

JSON不支持注释,而YAML支持注释。这一特性使得YAML在某些情况下更易于阅读和编辑。注释在YAML中以井号`#`开始:

```yaml

# This is a comment in YAML

key: value # Another comment

```

在JSON中,任何添加的注释都会导致格式错误:

```json

// JSON does not support comments

{

"key": "value"

}

```

空白字符在YAML中用于表示层级结构,不同的缩进级别代表不同的层级。而在JSON中,空白字符仅用于分隔数据和美观,不影响数据结构。

## 2.3 读写性能和易用性

### 2.3.1 大小和读写速度的对比

在大小和读写速度方面,YAML和JSON各有优劣。通常,YAML的可读性更强,但由于使用了更多的空白字符,其文件大小往往会更大。而JSON由于其紧凑性,文件大小通常较小。

读写速度方面,由于JSON的解析过程更为简单直接,通常其读写速度会比YAML快。这使得JSON在需要频繁读写的应用场景中更加适用。

### 2.3.2 用户友好度的评价

在用户友好度方面,YAML因其易于阅读和编辑而受到许多人的青睐,尤其适合人类直接阅读和编辑的场景,如配置文件。JSON虽然不如YAML直观,但它简洁的格式在机器处理方面更加高效。

YAML的这种易用性是它在某些应用场景中脱颖而出的原因,尤其是在需要人类干预的配置管理场景中。然而,这种格式上的优势是以牺牲一定的性能为代价的,因此在选择使用YAML还是JSON时,需要在可读性和性能之间做出权衡。

```mermaid

graph LR

A[YAML] -->|易用性强| B[配置管理]

A -->|牺牲性能| C[性能要求高场景]

D[JSON] -->|性能优越| C

D -->|可读性较差| B

```

以上分析为在选择数据序列化格式时需要考虑的因素。在后续章节中,我们将深入探讨YAML与JSON在Python中的解析和使用,以及它们在实际应用场景中的表现和选择策略。

# 3. Python中的YAML与JSON解析

## 3.1 YAML在Python中的解析和使用

### 3.1.1 PyYAML库的基本使用

YAML的解析在Python中主要依赖于`PyYAML`这个第三方库,它的安装非常简单,可以通过pip安装:

```bash

pip install pyyaml

```

下面是一个简单的Python脚本,演示了如何使用PyYAML库来解析一个YAML文件,并将其转换为Python字典:

```python

import yaml

# 假设有一个名为config.yaml的文件,内容如下:

name: John Doe

age: 30

skills:

- Python

- Java

- C++

# 使用PyYAML的load函数加载YAML文件

with open("config.yaml", 'r') as stream:

try:

data = yaml.safe_load(stream)

print(data)

except yaml.YAMLError as exc:

print(exc)

# 输出将是:

# {'name': 'John Doe', 'age': 30, 'skills': ['Python', 'Java', 'C++']}

```

上面的代码块中,`yaml.safe_load(stream)`函数用于加载YAML文件内容。这里使用的是`safe_load`,它是推荐的安全载入方式,因为它避免了执行任意代码的危险。PyYAML库也支持`yaml.load`函数,但是这个函数已经不推荐使用了。

### 3.1.2 复杂数据结构的处理

PyYAML库在处理复杂数据结构,例如列表、字典、嵌套结构和布尔值时,提供了非常好的支持。下面是一个处理复杂数据结构的例子:

```python

import yaml

yaml_str = """

name: John Doe

age: 30

is_student: false

skills:

- Python

- Java

- C++

education:

- degree: Bachelor's

school: University A

- degree: Master's

school: University B

data = yaml.safe_load(yaml_str)

print(data)

```

执行上述代码,输出结果将会是:

```

{

'name': 'John Doe',

'age': 30,

'is_student': False,

'skills': ['Python', 'Java', 'C++'],

'education': [

{'degree': 'Bachelor\'s', 'school': 'University A'},

{'degree': 'Master\'s', 'school': 'University B'}

]

}

```

在这个例子中,我们可以看到如何将YAML中的列表和嵌套字典解析为Python中的列表和字典。

## 3.2 JSON在Python中的解析和使用

### 3.2.1 json模块的基本操作

JSON的解析在Python中可以通过内置的`json`模块来完成。这个模块提供了多种功能来处理JSON数据,包括序列化(将Python对象转换为JSON字符串)和反序列化(将JSON字符串转换回Python对象)。

下面是一个使用`json`模块的基本例子:

```python

import json

# 将Python字典转换为JSON字符串

data_dict = {

"name": "Jane Doe",

"age": 25,

"skills": ["Python", "JavaScript"]

}

json_str = json.dumps(data_dict)

print(json_str)

# 输出: {"name": "Jane Doe", "age": 25, "skills": ["Python", "JavaScript"]}

# 将JSON字符串转换回Python字典

data_str = '{"name": "John Doe", "age": 30, "skills": ["Python", "Java", "C++"]}'

data_dict = json.loads(data_str)

print(data_dict)

# 输出: {'name': 'John Doe', 'age': 30, 'skills': ['Python', 'Java', 'C++']}

```

### 3.2.2 数据类型转换和自定义解析

Python的`json`模块提供了多种自定义功能,允许我们以特定方式处理数据类型转换。`object_pairs_hook`参数允许你定义如何处理对象的键值对,而`object_hook`参数允许你定义如何将JSON对象转换为其他Python对象。

下面的例子展示了如何自定义解析过程中处理数据类型的转换:

```python

import json

def decode_int_pair(ordered_pairs):

return {int(key): value for key, value in ordered_pairs}

def convert_object(data):

if '__type__' in data:

if data['__type__'] == 'datetime':

return datetime.strptime(data['value'], '%Y-%m-%d')

return data

json_str = '{"__type__": "datetime", "value": "2021-01-01"}'

# 使用object_hook将数据转换为datetime对象

data = json.loads(json_str, object_hook=convert_object)

print(data)

# 输出: datetime.datetime(2021, 1, 1)

# 使用object_pairs_hook将键值对转换为整数键

ordered_dict = json.loads(json_str, object_pairs_hook=decode_int_pair)

print(ordered_dict)

# 输出: {0: '__type__', 1: 'datetime', 2: 'value'}

```

在这个例子中,`convert_object`函数检查了数据中是否有一个特殊的键`__type__`,如果存在,就根据其值来将数据转换为正确的类型。`decode_int_pair`函数将所有键转换为整数类型。这显示了`json`模块如何允许定制化和灵活性在处理JSON数据。

# 4. 实战对比:YAML与JSON的应用场景

## 4.1 配置文件的处理

### 4.1.1 配置文件的读写需求

配置文件是任何应用程序不可或缺的组成部分,它允许程序在不进行代码更改的情况下调整其行为。对于配置文件的处理,需要考虑以下几个关键需求:

- **易读性**:配置文件应易于阅读和理解,以便开发者和系统管理员能够快速定位和修改配置项。

- **易编辑性**:配置文件应支持文本编辑器编辑,方便用户通过简单的文本操作进行调整。

- **结构化**:配置项应有清晰的结构,支持复杂的数据组织,如嵌套的设置或列表等。

- **版本兼容性**:配置格式应保持向后兼容性,以便于程序的逐步升级和维护。

### 4.1.2 YAML和JSON的实际应用案例

在实际应用中,YAML和JSON格式各有千秋。以下是具体的应用案例分析:

#### YAML 应用案例

**Docker Compose** 是一个用于定义和运行多容器 Docker 应用的工具。它使用 YAML 文件来配置应用程序的服务。例如,以下是一个简单的 `docker-compose.yml` 文件示例:

```yaml

version: '3'

services:

web:

image: nginx:alpine

ports:

- "80:80"

```

在这个文件中,Docker Compose 使用YAML结构清晰地组织了服务信息。YAML格式简洁、易读的特性在这里表现得淋漓尽致。

#### JSON 应用案例

**MongoDB** 是一个广泛使用的非关系型数据库,它支持JSON格式作为数据存储和配置的标准。在配置MongoDB时,通常会编辑 `mongod.json` 配置文件,例如:

```json

{

"storage": {

"dbPath": "/var/lib/mongodb",

"journal": {

"enabled": true

}

},

"systemLog": {

"destination": "file",

"path": "/var/log/mongodb/mongod.log",

"logAppend": true

}

}

```

这个文件的JSON格式确保了结构化和标准化的数据配置,使得文件易于被解析和处理。

## 4.2 数据交换和API通信

### 4.2.1 RESTful API中的数据格式选择

在RESTful API设计中,客户端与服务器之间的数据交换格式的选择对API的可用性和性能有直接影响。以下是选择数据格式时需要考虑的因素:

- **可读性**:易于开发者阅读和调试的数据格式有助于提升开发效率。

- **兼容性**:数据格式应与广泛使用的编程语言和框架兼容。

- **数据量**:格式应尽可能紧凑,以减少网络传输的数据量。

### 4.2.2 数据交换的效率和安全性考量

在考虑数据交换效率和安全性时,需要权衡数据格式的特性和API的业务需求:

- **效率**:格式的序列化和反序列化速度直接影响到API的响应时间。

- **安全性**:一些数据格式可能因为其结构特性而更适合在安全敏感的环境中使用。

## 4.3 系统和服务的配置管理

### 4.3.1 系统配置的标准化和灵活性

系统配置的标准化和灵活性是保证IT环境稳定性和可扩展性的关键。YAML和JSON在系统配置管理方面的应用表现如下:

- **YAML的灵活性**:YAML的层级结构和注释支持使得它在复杂的系统配置中表现出色。

- **JSON的标准化**:JSON的广泛支持和一致性使得它在需要标准化的配置场景中更为合适。

### 4.3.2 服务发现和配置管理工具中的应用

在服务发现和配置管理领域,工具如Kubernetes、Consul等使用特定的数据格式来存储和管理配置信息。例如,在Kubernetes中,使用YAML格式的配置文件来定义服务的各种参数,这依赖于YAML强大的数据描述能力。

```yaml

apiVersion: v1

kind: Pod

metadata:

name: nginx

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

```

## 代码块和逻辑分析

```json

{

"config": {

"server": "***",

"port": 8080,

"timeout": 30

},

"settings": {

"theme": "dark",

"language": "en"

}

}

```

在此JSON示例中,定义了一个配置对象,包含服务器设置和用户界面设置。此格式易于编程语言解析,并且可以清晰地表达复杂的层次结构。

```yaml

server: ***

port: 8080

timeout: 30

settings:

theme: dark

language: en

```

在这个等效的YAML示例中,相同的数据被以更易读的格式展现。缩进和换行增强了层级结构的可读性,且支持注释和空白字符的特性使得文件更易被开发者阅读和维护。

# 5. 选择最佳数据格式的策略

在现代软件开发中,选择合适的数据序列化格式是至关重要的一环。数据格式不仅影响了数据的存储、传输,还可能影响系统的性能和可维护性。因此,开发者必须了解不同数据格式的特点,并在不同的应用场景中做出明智的选择。

## 5.1 选择标准的制定

### 5.1.1 数据复杂度和格式要求

当选择数据序列化格式时,首要考虑的是数据的复杂度。简单数据结构,如键值对或列表,通常不会对选择造成太大影响,但当数据结构变得复杂时,选择合适的格式就显得尤为重要。

比如,YAML格式提供了较为自然的表示方式来处理复杂数据结构,它支持的数据类型丰富,并且可以很容易地表示层级和嵌套结构。相对而言,JSON则更适合轻量级的数据交换,它的数据类型较少,层级表示也比较直接。因此,对于配置文件或是复杂的数据描述,YAML往往是更好的选择。

**数据格式要求**也对选择产生影响。某些应用场景可能需要强类型的格式,而某些则需要更高的可读性。YAML的可读性是其一大优势,尤其在配置文件和文档中,良好的可读性可以大大提高开发效率和减少错误。

### 5.1.2 性能和扩展性的影响因素

除了数据复杂度和格式要求,性能和扩展性也是选择数据格式时的重要考虑因素。通常,性能包括两个方面:读写速度和所占空间的大小。YAML和JSON在性能上各有优劣,但它们之间通常只存在细微的差别。如果性能是关键考虑因素,需要针对实际应用场景进行基准测试。

扩展性主要指的是数据格式是否易于添加新的数据类型或字段,以及在未来升级时的灵活性。这一点在进行长期项目开发时尤为重要。在选择数据格式时,我们需要考虑该格式未来可能面临的扩展需求,是否能适应快速变化的技术环境。

## 5.2 案例分析与实践建议

### 5.2.1 典型应用场景的分析

在实际应用中,不同数据格式因其特性被用于不同的场景。例如:

- **配置文件**:通常需要频繁修改,并且需要良好的可读性。YAML在这里非常合适,因为它允许使用注释,并且结构清晰。

- **数据交换**:如果需要与其他系统交互,可能会选择JSON,因为它是一个广泛支持的标准,并且许多编程语言都原生支持JSON解析。

- **日志记录**:日志文件需要易于读取,并且可以容纳丰富的数据类型。YAML格式可以更好地满足这些需求。

**实践建议**是在选择格式时,应该根据实际应用的需求来进行选择。如果应用需求对格式有特定的限制,或者对性能有极高的要求,那么可能需要考虑更专业的序列化格式。

### 5.2.2 数据格式选择的实践建议

在进行选择时,可以遵循以下步骤:

1. **需求分析**:确定应用对数据格式的具体需求。

2. **候选格式选择**:选择几种可能适用的数据格式作为候选。

3. **性能测试**:对候选格式进行实际的性能测试,包括读写速度和大小。

4. **易用性评估**:评估不同格式在当前开发环境中的易用性,包括工具支持和社区资源。

5. **决策**:综合考虑上述因素,做出最终选择。

## 5.3 未来趋势和新技术的考虑

### 5.3.1 新兴技术对格式选择的影响

随着技术的发展,新兴技术的出现可能会对数据格式的选择产生影响。例如,物联网(IoT)、大数据和人工智能(AI)领域的发展可能会推动对新类型数据格式的需求。

**数据格式**需要适应这些技术所处理的数据类型,例如,IoT设备可能需要轻量级的格式进行数据传输,而AI则可能需要格式来支持更复杂的结构和数据类型。

### 5.3.2 长远发展视角下的格式选择策略

在长远的视角下,选择数据格式的策略应该考虑到技术的**可持续性和兼容性**。格式需要能够随着技术的演进而进行演进,同时能够与其他技术进行良好的交互。

选择时,应该关注格式的**标准化进程**和**社区活跃度**。一个活跃且标准化程度高的数据格式更有可能在未来保持其竞争力和适用性。同时,对于**企业**来说,还应该考虑所选择的数据格式是否与企业的技术栈和未来规划相符合。

```mermaid

graph TD

A[开始选择数据格式] --> B[需求分析]

B --> C[候选格式选择]

C --> D[性能测试]

D --> E[易用性评估]

E --> F[做出最终选择]

```

在以上流程中,我们可以通过这个图表来帮助理解在选择数据格式时的决策过程。

通过综合考虑以上因素,开发者可以更明智地选择适合自己项目的数据序列化格式,并为未来的项目变化做好准备。

# 6. YAML与JSON在大数据环境下的应用与挑战

在大规模数据处理的场景下,数据序列化格式的选择变得尤为重要。本章节将深入探讨在大数据环境中的YAML与JSON应用,并分析它们面临的挑战。

## 6.1 大数据环境下的数据序列化格式需求

随着数据量的激增,数据序列化和反序列化的性能成为大数据处理中的关键。数据格式必须具备高效率的编码和解码能力,以及较低的存储消耗。

### 6.1.1 数据处理的速度与效率

数据处理速度直接影响着整个系统的性能。YAML和JSON在大数据环境下的表现如何?

```python

import time

import yaml

import json

large_data = {...} # 大规模数据样本

start_time = time.time()

yaml.dump(large_data, open('large_data.yaml', 'w'))

end_time = time.time()

print(f"YAML serialization time: {end_time - start_time}")

start_time = time.time()

json.dump(large_data, open('large_data.json', 'w'))

end_time = time.time()

print(f"JSON serialization time: {end_time - start_time}")

```

通过实际代码运行,我们可以得出YAML和JSON处理大规模数据时的性能差异。

### 6.1.2 存储空间的优化

存储空间的优化是大数据环境下的另一个关键需求。YAML和JSON格式在压缩后存储空间上的表现如何?

我们可以使用压缩工具(如gzip)来评估压缩后的效果。

```bash

gzip -k large_data.yaml # 保持原文件,输出压缩文件

gzip -k large_data.json # 保持原文件,输出压缩文件

```

执行上述命令后,我们可以使用`ls -lh`来查看压缩前后文件的大小差异。

## 6.2 大数据环境下的数据序列化格式挑战

大数据环境对数据格式提出了一系列挑战,其中包括处理速度、存储效率、可扩展性以及跨平台兼容性等。

### 6.2.1 分布式环境中的兼容性问题

在分布式系统中,不同节点间的数据传输需要考虑格式的兼容性问题。YAML和JSON在不同系统和语言间的兼容性表现如何?

一个具体的例子是,我们可以在Hadoop分布式环境中测试YAML和JSON的兼容性。

### 6.2.2 大数据处理工具的集成与支持

大数据处理工具如Apache Spark、Hadoop等,它们对于数据序列化格式的支持程度如何?

具体实践可以包括使用Spark读写YAML和JSON格式的数据文件。

```python

# Spark读取JSON文件的示例

from pyspark.sql import SparkSession

from pyspark.sql.types import *

spark = SparkSession.builder.appName("YAMLvsJSON").getOrCreate()

json_df = spark.read.json("path_to_large_data.json")

yaml_df = spark.read.format("com.databricks.spark.yaml").load("path_to_large_data.yaml")

# 执行DataFrame操作...

```

通过上述代码,我们可以测试在Spark环境下读写JSON和YAML数据的效率和兼容性。

### 6.2.3 实时数据处理和分析

在实时数据处理和分析的场景中,数据格式的轻量级和快速处理是关键。YAML和JSON在这一方面的表现如何?

我们可以通过设置一个实时数据流处理场景,并用YAML和JSON格式分别处理数据,记录处理时间和资源消耗。

## 6.3 解决方案和最佳实践

面对大数据环境下的挑战,开发者和数据工程师可以采取哪些措施来确保选择最合适的数据序列化格式?

### 6.3.1 格式转换和优化策略

对于数据格式的转换和优化,有哪些有效的策略?

在一些情况下,可能会考虑在数据录入和输出时使用一种格式,而在数据处理过程中转换成另一种格式。这需要详细的性能测试来指导决策。

### 6.3.2 系�列化格式的选择案例研究

通过研究具体的成功案例,我们可以了解到在特定场景下选择和应用YAML与JSON的决策过程。

例如,某大数据分析公司根据数据大小、处理速度和系统兼容性选择YAML作为内部数据交换格式,并提供转换工具。

在大数据环境下选择数据序列化格式时,需要进行多维度的考量和权衡。通过对YAML与JSON的实际应用案例进行深入分析,可以帮助我们更好地理解它们在不同场景下的适用性。

通过本章的讨论,我们可以看到YAML与JSON在大数据环境中的表现和挑战。基于这些讨论,读者应当能够更明智地选择适合他们特定需求的数据序列化格式。

0

0