Seq2Seq模型在搜索引擎中的突破与挑战:重塑信息检索的新范式

发布时间: 2024-08-21 03:06:00 阅读量: 24 订阅数: 22

# 1. Seq2Seq模型概述**

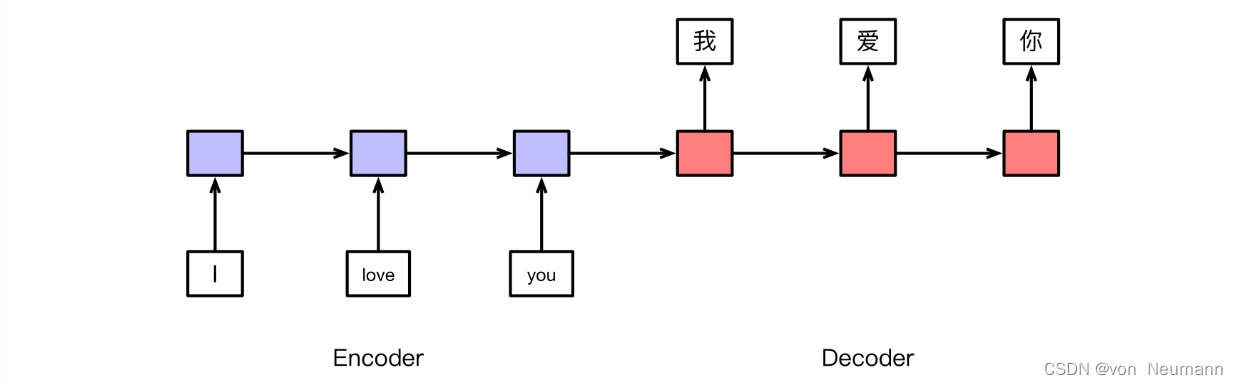

Seq2Seq模型是一种神经网络架构,专门用于处理序列到序列的转换任务。它由两个主要组件组成:编码器和解码器。编码器将输入序列转换为固定长度的向量表示,而解码器使用该表示生成输出序列。

Seq2Seq模型广泛应用于各种自然语言处理任务,包括机器翻译、文本摘要和问答。其核心思想是将序列中的每个元素视为一个向量,并使用神经网络学习序列之间的映射关系。通过端到端的训练,Seq2Seq模型可以自动学习输入和输出序列之间的复杂转换规则。

# 2. Seq2Seq模型在搜索引擎中的应用

Seq2Seq模型在搜索引擎中得到了广泛的应用,主要体现在搜索结果摘要生成和搜索查询重写两个方面。

### 2.1 搜索结果摘要生成

#### 2.1.1 模型架构和训练方法

搜索结果摘要生成任务旨在自动生成给定搜索查询的摘要,为用户提供快速而全面的搜索结果概述。Seq2Seq模型通常用于此任务,其架构如下:

```python

encoder = nn.LSTM(input_dim, hidden_dim)

decoder = nn.LSTM(hidden_dim, output_dim)

```

- `input_dim`:搜索查询的嵌入维度

- `hidden_dim`:编码器和解码器的隐藏状态维度

- `output_dim`:摘要的词汇表大小

训练过程包括:

1. 将搜索查询编码为隐藏状态序列。

2. 将隐藏状态序列作为解码器的输入,生成摘要序列。

3. 使用交叉熵损失函数优化模型参数。

#### 2.1.2 评价指标和性能优化

搜索结果摘要生成模型的评价指标通常包括:

- **ROUGE**:衡量摘要与参考摘要之间的重叠程度

- **BLEU**:衡量摘要的流畅性和信息含量

性能优化技巧包括:

- **注意力机制**:允许模型专注于输入序列中与摘要生成最相关的部分。

- **拷贝机制**:允许模型直接从输入序列中复制单词或短语。

- **正则化技术**:防止模型过拟合,如 dropout 和 L2 正则化。

### 2.2 搜索查询重写

#### 2.2.1 问题建模和模型设计

搜索查询重写任务旨在将模糊或不完整的搜索查询转换为更明确和相关的查询。Seq2Seq模型用于此任务,其架构如下:

```python

encoder = nn.GRU(input_dim, hidden_dim)

decoder = nn.GRU(hidden_dim, output_dim)

```

- `input_dim`:原始搜索查询的嵌入维度

- `hidden_dim`:编码器和解码器的隐藏状态维度

- `output_dim`:重写查询的词汇表大小

训练过程包括:

1. 将原始搜索查询编码为隐藏状态序列。

2. 将隐藏状态序列作为解码器的输入,生成重写查询序列。

3. 使用交叉熵损失函数优化模型参数。

#### 2.2.2 训练数据和评估策略

搜索查询重写模型的训练数据通常来自搜索日志,其中包含原始搜索查询和相应的重写查询。

评价指标包括:

- **点击率**:衡量重写查询的质量

- **查询长度减少率**:衡量重写查询的简洁程度

性能优化技巧包括:

- **问题类型分类**:将搜索查询分类为不同的类型,并使用特定于类型的模型。

- **知识图谱增强**:利用知识图谱中的信息来丰富搜索查询。

- **用户偏好建模**:考虑用户的搜索历史和偏好来个性化重写查询。

# 3. Seq2Seq模型在搜索引擎中的挑战

### 3.1 数据稀疏性和泛化能力

**3.1.1 数据增强技术**

数据稀疏性是Seq2Seq模型在搜索引擎中面临的主要挑战之一。由于搜索查询和文档的巨大多样性,收集和标注大量高质量的训练数据非常困难。为了解决这一问题,研究人员开发了各种数据增强技术,包括:

- **回译(Back-Translation):**将目标语言翻译回源语言,然后再次翻译回目标语言,生成新的训练数据。

- **同义词替换(Synonym Re

0

0