深度学习在JavaScript人脸识别中的应用

发布时间: 2024-11-15 22:23:57 阅读量: 2 订阅数: 2

# 1. 深度学习与人脸识别概述

随着科技的进步,深度学习已经成为推动人脸识别技术发展的关键技术之一。在本章节中,我们将探讨深度学习的基础以及其在人脸识别领域中的应用。首先,我们会简要介绍深度学习的基本原理及其在图像识别中的作用,然后过渡到人脸识别技术,探讨其在各种场景中的应用现状和潜力。

## 1.1 深度学习简介

深度学习(Deep Learning)是机器学习的一个分支,它使用多层神经网络来模拟人脑处理信息的方式,通过“学习”大量数据来优化性能。这种学习过程模仿了人类学习认知的层次结构,从简单的特征中抽象出复杂的概念。

## 1.2 人脸识别技术概述

人脸识别技术是一种利用生物特征进行个体识别的技术。它涉及图像处理、模式识别、计算机视觉等多个领域。如今,这种技术在安全验证、身份认证和智能监控等领域发挥着重要作用。在深度学习的辅助下,人脸识别的准确性有了显著提高。

## 1.3 深度学习与人脸识别的结合

深度学习与人脸识别技术的结合使得计算机能够更准确地识别和分类人脸图像。神经网络,尤其是卷积神经网络(CNN),在特征提取和识别方面取得了革命性的进步。我们将探讨CNN如何能够自动学习并提取人脸图像中的关键特征,从而极大提高了人脸识别系统的准确性和效率。

# 2. 深度学习基础理论

## 2.1 神经网络基础

### 2.1.1 神经元与激活函数

神经网络由众多的神经元(Neuron)组成,每个神经元可以看作是信息处理的基本单元。在深度学习中,一个简单的神经元通常包括输入、权重(weights)、偏置(bias)和激活函数(activation function)。输入即为前一层神经元的输出或输入层接收到的数据特征,权重表示连接强度,偏置用来调整输出的值,而激活函数则用来增加非线性因素。

激活函数是神经网络的重要组成部分,它将线性组合的输入转换为非线性输出,允许网络学习复杂的任务。常见的激活函数包括Sigmoid、Tanh和ReLU等。

**Sigmoid函数**的数学表达式为 `σ(x) = 1 / (1 + e^(-x))`,其输出范围在0到1之间,常用于二分类任务。

```python

import numpy as np

def sigmoid(x):

return 1 / (1 + np.exp(-x))

```

**Tanh函数**(双曲正切函数)是Sigmoid函数的变形,输出范围在-1到1之间,其导数比Sigmoid函数更有利于梯度下降法。

```python

def tanh(x):

return np.tanh(x)

```

**ReLU函数**(Rectified Linear Unit)是目前最常用的激活函数之一,它将负值置为0,正值保持不变,计算效率高,但可能会导致“神经元死亡”。

```python

def relu(x):

return np.maximum(0, x)

```

### 2.1.2 前馈神经网络和反向传播算法

前馈神经网络是深度学习中最基本的网络类型,数据从输入层经过隐藏层(可能有一个或多个),最后到达输出层。在前馈神经网络中,信息的流动是单向的,从输入到输出。

反向传播算法(Backpropagation)是深度学习模型训练的核心算法。它的基本思想是通过从输出层开始,向前计算每层的误差梯度,然后根据梯度下降法调整权重,以最小化预测输出与实际输出之间的差异。

反向传播的步骤如下:

1. **前向传播**:输入数据通过网络前向传播直到输出层。

2. **计算误差**:将网络的输出与真实值比较,计算损失函数。

3. **反向传播误差**:根据损失函数计算误差的梯度。

4. **更新权重和偏置**:利用梯度下降法更新网络中的权重和偏置。

## 2.2 卷积神经网络(CNN)

### 2.2.1 CNN结构与原理

卷积神经网络(CNN)是一种深层的前馈神经网络,特别适合处理具有网格状拓扑结构的数据,如图像。CNN通过使用卷积层,可以有效地提取输入数据的空间特征。网络通过共享权重的卷积核(也称为滤波器)在输入数据上滑动,并在每个位置计算卷积核和局部区域的点积,这样可以大大减少模型参数的数目。

CNN由以下几种层组成:

- **卷积层**:提取特征。

- **池化层**(Pooling):减少特征的空间尺寸,从而减少计算量,并使特征检测更加鲁棒。

- **全连接层**(Fully Connected):学习非线性组合,最后的全连接层输出分类结果。

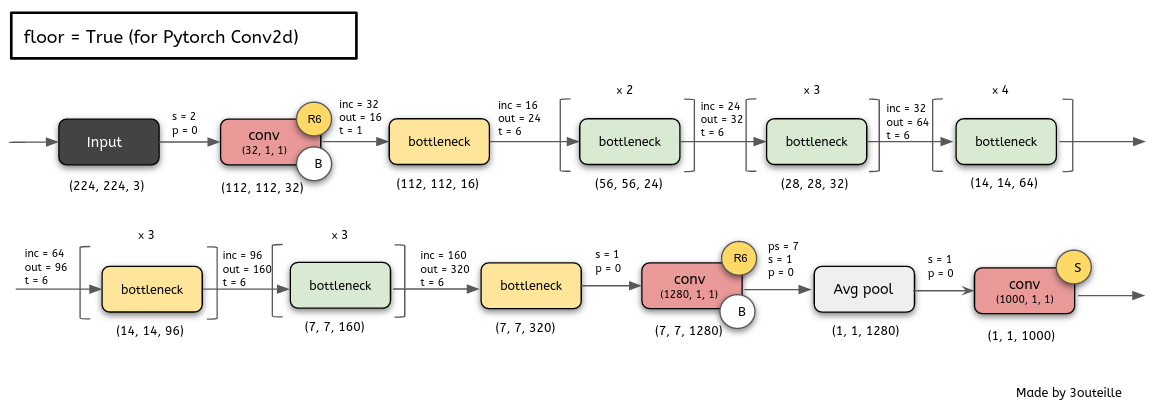

### 2.2.2 常见的CNN架构简介

**LeNet**是早期最成功的CNN架构之一,主要用于手写数字识别。它通常包含几个卷积层和池化层,最后是全连接层。

**AlexNet**是一个更深的网络结构,由5个卷积层和3个全连接层组成,显著提高了图像识别的准确率。它的成功拉开了深度学习在图像识别领域广泛应用的序幕。

**VGGNet**通过重复使用小尺寸的卷积核(如3x3)构建网络,证明了深度对性能的重要性。VGGNet通常由多个卷积层组成,最后通过全连接层进行分类。

**ResNet**引入了“残差学习”的概念,通过“跳跃连接”解决了深层网络中梯度消失的问题,使得训练更深的网络成为可能。ResNet在多个图像识别比赛中获得冠军,证实了其优越性。

## 2.3 深度学习训练与优化

### 2.3.1 数据增强与正则化

数据增强(Data Augmentation)是提高模型泛化能力的重要手段,尤其在样本较少时效果显著。它通过对原始数据进行变换生成新的数据,变换方式包括旋转、缩放、翻转等。

正则化(Regularization)的目的是防止模型过拟合,常用的方法有L1正则化和L2正则化。L1正则化倾向于生成更加稀疏的权重矩阵,而L2正则化则使权重值接近于0但不会完全为0。

### 2.3.2 损失函数与优化算法

损失函数(Loss Function)衡量的是预测值与真实值之间的差异,深度学习中最常用的损失函数包括均方误差(MSE)和交叉熵损失(Cross-Entropy Loss)。

优化算法用于最小化损失函数,常用的优化算法包括梯度下降法(GD)、随机梯度下降法(SGD)、批量梯度下降法(BGD)、Adam和RMSprop等。

- **梯度下降法(GD)**:通过计算损失函数相对于模型参数的梯度并沿着梯度下降的方向更新参数。

- **随机梯度下降法(SGD)**:每次只用一个样本更新参数,提高了计算效率,但收敛速度可能不稳定。

- **Adam**:结合了动量(Momentum)和RMSprop的优点,自适应调整学习率。

## 2.4 深度学习框架与工具

### 2.4.1 TensorFlow与Keras

TensorFlow是一个开源的深度学习框架,由Google开发,支持多种语言,包括Python、C++和JavaScript等。TensorFlow的核心是张量(tensor),可以理解为多维数组,通过计算张量之间的操作来构建和训练深度学习模型。

Keras是一个高层神经网络API,它可以使用TensorFlow、Theano或CNTK作为后端进行计算。Keras的设计目标是实现快速的实验,它支持即时执行(eager execution)和模块化的网络层构建,非常适合快速原型设计和研究。

### 2.4.2 PyTorch

PyTorch是由Facebook开发的一个开源机器学习库,它同样支持GPU加速的张量计算,并提供了丰富的API进行深度学习模型的构建和训练。PyTorch的一个显著特点是使用了动态计算图,可以更灵活地构建复杂的神经网络结构。

与TensorFlow相比,PyTorch更受学术界欢迎,因为它更接近Python的使用习惯,代码易于编写和调试。此外,PyTorch社区提供了大量的教程和文档,对于初学者非

0

0