SPiiPlus Utilities日志分析速成:追踪解读日志的高手之道

发布时间: 2024-12-14 17:14:04 阅读量: 4 订阅数: 13

SPiiPlus Utilities User Guide.pdf

参考资源链接:[SPiiPlus软件用户指南:2020年9月版](https://wenku.csdn.net/doc/xb761ud9qi?spm=1055.2635.3001.10343)

# 1. SPiiPlus Utilities日志分析基础

## 1.1 SPiiPlus Utilities概述

在本章中,我们将概述SPiiPlus Utilities(以下简称SPU)这一强大的日志分析工具。SPU是一种专门用于处理和分析日志数据的软件,它能够帮助IT专业人员高效地监控和诊断系统性能,以及安全事件。SPU集成了一系列功能,如日志解析、可视化、存储管理和报告生成,使它成为日志分析领域的佼佼者。

## 1.2 日志分析的重要性

日志分析是IT运营不可或缺的一部分,它帮助IT团队理解系统行为,跟踪问题,满足合规要求,并最终保障业务连续性。在SPU的帮助下,日志数据的深入分析可以实现以下目标:

- 提高系统的透明度,从而更有效地管理和维护系统。

- 通过识别和解决性能瓶颈来提高系统性能。

- 通过实时监控和警报机制预防潜在的安全威胁。

- 简化故障排除过程,快速定位和解决技术问题。

## 1.3 日志分析的基本步骤

日志分析通常遵循一系列基本步骤,这些步骤确保能够全面了解日志信息:

1. **收集日志数据**:使用SPU等工具从各种源收集日志数据,包括服务器、应用程序、网络设备等。

2. **解析日志信息**:将收集到的日志文件转换成可以理解的格式,并提取有用的信息,如日志级别、时间戳等。

3. **存储和索引**:存储解析后的日志信息,并建立索引以便快速检索。

4. **分析和解释**:分析日志数据,寻找模式或异常行为,并基于此提出相应的解决方案。

5. **报告和警报**:通过制作报告或触发警报,将分析结果传达给需要的人。

在接下来的章节中,我们将详细介绍日志数据的结构、存储、提取技术、以及在SPU环境中进行日志分析的具体方法和技巧。

# 2. 日志数据理论与解析

### 2.1 日志数据的组成与结构

#### 2.1.1 日志级别与分类

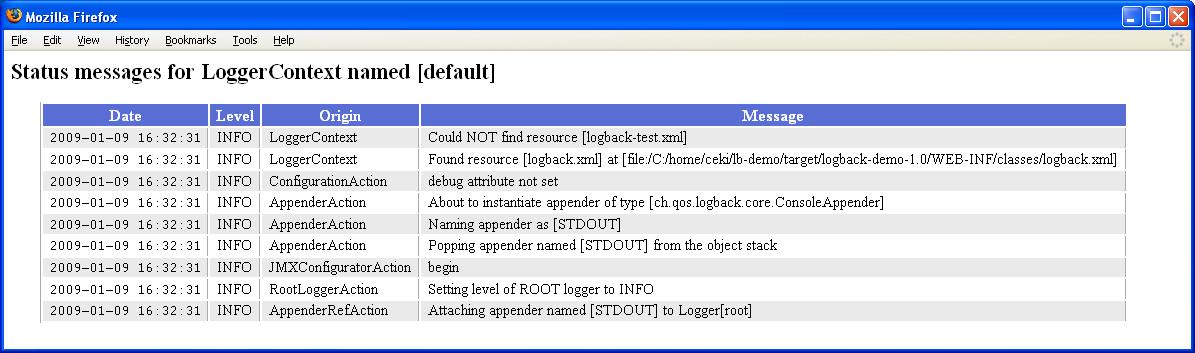

日志级别是日志记录的优先级分类,它们为不同类型的事件指定了不同的严重程度。在SPiiPlus Utilities中,日志级别可能包括ERROR、WARN、INFO、DEBUG和TRACE等。这些级别通常按照严重性从高到低排序,其中ERROR级别用于记录错误和异常,而TRACE级别通常包含最多的详细信息,用于开发和调试阶段。

一个典型的应用日志结构可能包含以下元素:

1. **时间戳**:记录事件发生的确切时间。

2. **日志级别**:指示消息的严重性或重要性。

3. **组件/源**:记录消息来源的模块或服务名称。

4. **消息内容**:事件的描述信息。

5. **数据**:附加信息,比如异常堆栈跟踪、用户信息等。

**表 1** 展示了不同日志级别可能包含的典型日志内容。

| 日志级别 | 描述 | 示例 |

|----------|---------------------------------------|----------------------------------------|

| ERROR | 记录系统运行错误 | "Error occurred: Database connection failed" |

| WARN | 记录可能引发错误的情况 | "Warning: Low disk space detected" |

| INFO | 记录系统运行的常规信息 | "INFO: User logged in successfully" |

| DEBUG | 记录调试信息,仅在开发和调试阶段使用 | "DEBUG: Checking database connection..."|

| TRACE | 记录记录更多的运行时详细信息 | "TRACE: Invoked method XYZ" |

#### 2.1.2 时间戳和事件标识

时间戳是日志记录中不可或缺的一部分,它允许日志分析工具快速排序和过滤日志条目。事件标识,例如序列号或事务ID,有助于将相关的日志条目组合在一起。通过这些信息,可以更好地进行问题追踪和性能分析。

### 2.2 日志信息的提取技术

#### 2.2.1 关键字筛选方法

关键字筛选是通过在日志数据中查找特定文本字符串来提取有用信息的一种简单方法。它适用于具有明确关键短语或术语的日志记录,这些短语或术语与特定事件相关联。

例如,若要识别与数据库连接失败相关的日志条目,可以搜索关键字"Database connection failed"。代码块2.1展示了如何使用Python实现关键字筛选。

**代码块 2.1**

```python

# Python code for searching logs for a specific keyword

def search_keyword_in_logs(logs, keyword):

results = []

for log in logs:

if keyword in log:

results.append(log)

return results

# 假设这是日志文件的全部内容

log_file_content = [

"INFO: User logged in successfully",

"ERROR: Database connection failed",

"DEBUG: Checking database connection...",

"INFO: User logged out"

]

# 搜索特定错误

db_error_logs = search_keyword_in_logs(log_file_content, "Database connection failed")

# 输出结果

for error_log in db_error_logs:

print(error_log)

```

#### 2.2.2 正则表达式在日志提取中的应用

正则表达式提供了一种强大而灵活的方法来匹配复杂的文本模式,它在处理不规则格式的日志时非常有用。例如,以下正则表达式可用于匹配日期和时间格式的日志条目:

```

\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2}

```

这个表达式将匹配类似于"2023-03-15 12:30:45"的日期时间格式。代码块2.2演示了如何在Python中使用正则表达式来提取具有特定格式的日期时间戳。

**代码块 2.2**

```python

# Python code for searching logs with regular expressions

import re

def extract_timestamps(logs, pattern):

timestamps = []

for log in logs:

result = re.search(pattern, log)

if result:

timestamps.append(result.group(0))

return timestamps

# 假设这是日志文件的全部内容

log_file_content = [

"INFO: User logged in successfully at 2023-03-15 12:30:45",

"ERROR: Database connection failed at 2023-03-15 13:45:58",

"DEBUG: Checking database connection at 2023-03-15 14:00:10...",

"INFO: User logged out at 2023-03-15 15:05:23"

]

# 提取日志中的时间戳

timestamps = extract_timestamps(log_file_content, r"\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2}")

# 输出提取的时间戳

for timestamp in timestamps:

print(timestamp)

```

### 2.3 日志的存储与安全

#### 2.3.1 日志的存储机制

日志的存储机制影响了日志数据的可访问性、可靠性和存储成本。常见的存储方法包括直接写入磁盘、数据库存储或使用专用日志管理系统。

**表 2** 对比了几种常见的日志存储机制。

| 存储机制 | 描述 | 优点 | 缺点 |

|----------|----------------------------------------------------------------------------------------|-------------------------------------------|------------------------------------------------|

| 文件系统 | 将日志直接写入服务器的文件系统中,例如.txt或.log文件。 | 简单、成本低 | 不易于搜索、管理和分析;可能对磁盘空间有较高需求 |

| 数据库 | 将日志存储在数据库中,通常使用专门的日志数据库如Elasticsearch或Splunk。 | 可搜索、可扩展;支持复杂的数据分析和查询。 | 成本较高;可能需要维护数据库的性能和安全。 |

| 日志管理系统 | 使用日志管理系统如Graylog、Logstash等集中存储和处理日志。 | 易于管理;支持多种日志源和输出;可扩展性高。| 成本较高;需要额外的学习和管理成本。 |

#### 2.3.2 日志的加密与保护策略

随着对日志数据隐私和安全的关注日益增加,加密和保护日志数据变得至关重要。常用的加密方法包括传输中加密和静态加密。

**传输中加密**通常指使用SSL/TLS等加密技术在日志从源传输到日志服务器时进行加密保护。**静态加密**则是指在将日志存储到磁盘或数据库时进行加密,以防止未经授权的访问。

此外,还可以通过实现访问控制策略来保护日志数据的安全性,确保只有授权用户才能访问特定的日志文件或信息。

通过本章节的介绍,我们了解了日志数据的基本组成、提取技术、存储机制以及保护策略。下一章将进入实际操作,展示如何利用日志分析工具来解读和分析日志数据。

# 3. SPiiPlus Utilities日志分析实践

## 3.1 日志分析工具的使用

### 3.1.1 通用日志分析工具介绍

日志分析工具是系统管理员和IT专业人员用来诊断问题、监测系统状态和性能、以及确保安全的重要工具。常见的日志分析工具有ELK Stack(Elasticsearch、Logstash、Kibana)、Splunk、Graylog等。这些工具通常支持对日志进行实时处理和搜索,并提供可视化界面来帮助用户理解日志内容。

例如,ELK Stack作为一个开源日志分析平台,能够处理大规模的日志数据。Logstash用于日志的收集和处理,Elast

0

0