【除法算法的性能提升秘籍】:专家级案例分析与实现技巧

发布时间: 2024-09-10 08:20:47 阅读量: 311 订阅数: 58

一个基于Qt Creator(qt,C++)实现中国象棋人机对战

# 1. 除法算法基础与应用场景

除法是数学中的基本运算之一,同时也是计算机程序设计中不可或缺的算法。本章节旨在为读者提供除法算法的基础知识,并探讨其在不同应用场合下的实际应用。

## 1.1 除法算法的基本概念

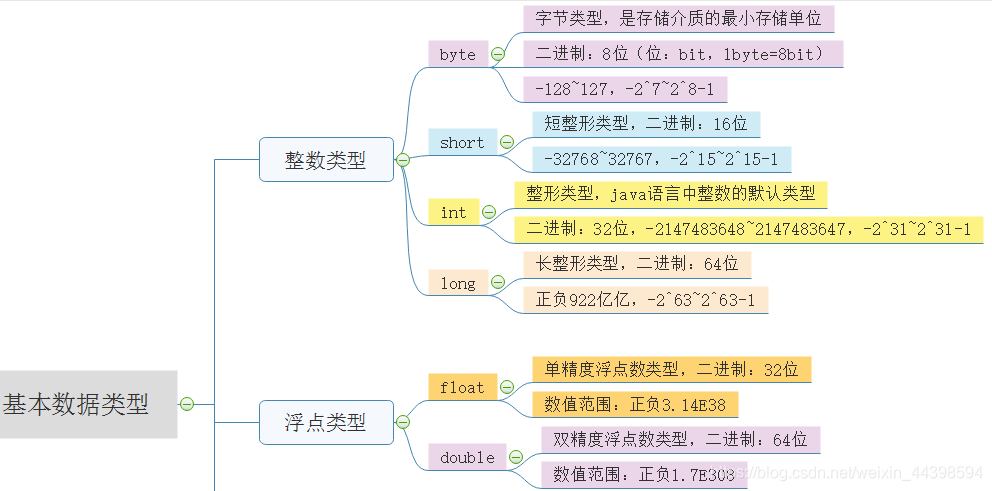

除法算法用于计算两个数相除的结果,它反映了数的分割与分配的基本原理。在计算机科学中,根据数据类型的不同(整数、浮点数),除法实现方式及处理的问题会有所区别。

## 1.2 除法的应用场景

除法广泛应用于各类计算任务,如科学计算、加密算法、图像处理和数据分析等。在科学计算中,除法用于求解平均值、比值等;在加密算法中,用于模运算和密钥生成;而在图像处理和数据分析中,除法用于规范化数据和快速计算。

了解这些基础概念和应用场景为后续更深入地探讨具体算法和优化策略提供了铺垫。我们将从经典除法算法开始,逐步深入到除法算法的性能分析和优化策略,最终通过实践案例来展现除法算法的实际应用效果。

# 2. 经典除法算法的性能分析

## 2.1 整数除法的基本原理

整数除法是计算机算术中的一项基础操作,在各种编程语言和硬件平台上有着广泛的应用。理解其基本原理对于性能优化和系统设计至关重要。

### 2.1.1 基于移位操作的除法实现

移位操作是整数除法中常用的一种方法,它的基本思想是通过重复减去除数来得到商,同时记录减去的次数作为余数。这种方法简单直观,但效率较低。

#### 代码展示

```c

int divide(int dividend, int divisor) {

int quotient = 0;

int sign = ((dividend < 0) ^ (divisor < 0)) ? -1 : 1;

long long temp_dividend = abs((long long)dividend);

long long temp_divisor = abs((long long)divisor);

while (temp_dividend >= temp_divisor) {

long long temp = 1;

long long div = temp_divisor;

// 不断进行移位操作,直到被除数小于除数

while (temp_dividend >= (div << 1)) {

div <<= 1;

temp <<= 1;

}

quotient += temp;

temp_dividend -= div;

}

// 根据符号位调整最终结果

return sign * quotient;

}

```

#### 逻辑分析

- 该代码块实现了一个基本的整数除法算法,其中使用了位操作来加速除法过程。

- `temp_dividend` 和 `temp_divisor` 分别存储了转换为无符号64位整数后的被除数和除数。

- 通过一个while循环,不断将`temp_divisor`左移,来找到最接近`temp_dividend`的数,这样可以减少减法操作的次数。

- `quotient` 用于存储计算得到的商。

- 最后根据除数和被除数的正负号来确定最终结果的正负。

### 2.1.2 除法的硬件支持与指令集

现代CPU都配备了专用的除法指令,如x86架构的`DIV`指令,这些指令能直接在硬件层面上执行除法操作。硬件除法指令的执行速度通常远高于软件层面的位操作算法。

#### 表格展示

| 指令 | 描述 | 适用架构 |

| --- | --- | --- |

| DIV | 无符号整数除法 | x86 |

| IDIV | 有符号整数除法 | x86 |

| UDIV | 无符号32位除法 | ARM |

| SDIV | 有符号32位除法 | ARM |

硬件支持不仅限于整数除法,还包括浮点数除法的指令如`FDIV`(x86架构)等。这些指令可以实现高效的除法计算,但它们也受到特定硬件架构的限制。

## 2.2 浮点数除法的复杂性

浮点数除法比整数除法更复杂,因为需要考虑更多的边界情况和精度问题。

### 2.2.1 浮点数表示和精度问题

IEEE 754标准定义了浮点数的存储格式,使得计算机能够表示正无穷、负无穷和NaN(不是一个数字)。浮点数的这些特殊值使得除法操作变得更加复杂。

#### 代码展示

```c

double divide(double dividend, double divisor) {

if (divisor == 0) {

// 规定除以零的行为,通常返回无穷大或NaN

return dividend == 0 ? NaN : (dividend > 0 ? INFINITY : -INFINITY);

}

if (isinf(dividend) && isinf(divisor)) {

// 无穷大除以无穷大结果不确定,但规定为NaN

return NaN;

}

if (isinf(dividend) || isinf(divisor)) {

// 无穷大除以有限数结果为无穷大

return isinf(dividend) ? copysign(INFINITY, dividend) : copysign(0.0, dividend);

}

// 标准的浮点数除法实现

return copysign(dividend / divisor, dividend * divisor);

}

```

#### 逻辑分析

- `divide`函数展示了处理特殊浮点数情况的逻辑。

- 第一个if语句处理除数为零的情况,返回NaN或无穷大。

- 第二个if语句处理除数和被除数同时为无穷大的情况,根据IEEE 754标准返回NaN。

- 第三个if语句处理其中一方为无穷大的情况,结果为无穷大。

- 最后,使用标准的浮点数除法操作,并保证结果的符号正确。

### 2.2.2 IEEE标准下的除法实现

IEEE 754标准中规定了如何进行浮点数的加、减、乘、除运算。由于浮点数表示有固定的精度,所以在除法运算中可能会出现舍入误差。

#### 代码展示

```c

// 使用IEEE标准进行浮点数除法

double fdiv(double dividend, double divisor) {

// 这里可以调用标准库函数如 / 进行运算

return dividend / divisor;

}

```

#### 逻辑分析

- 标准库中的除法运算函数已经按照IEEE标准进行了优化。

- `fdiv`函数仅仅是一个接口,实际的除法操作由编译器或底层库来完成。

- 除法操作后的结果可能会因为精度限制而进行舍入处理。

## 2.3 算法性能评估标准

性能评估是衡量算法优劣的一个重要标准,对于除法算法而言,通常关注时间复杂度和空间复杂度。

### 2.3.1 时间复杂度和空间复杂度

整数除法的时间复杂度通常为O(log n),其中n是被除数的位数。浮点数除法则取决于具体的硬件实现。

#### 代码展示

```c

// 不考虑溢出和除数为零的情况

int time_complexity_example(int n) {

int quotient = 0;

int divisor = 2;

while (n > 1) {

n /= divisor; // 这里的除法是整数除法

quotient++;

}

return quotient;

}

```

#### 逻辑分析

- 上述代码片段计算n可以被2整除多少次,展示了除法操作在时间复杂度分析中的一个简单应用。

- 对于除法操作,其时间复杂度主要由被除数的位数决定。

- 例如,一个32位的整数进行除法的时间复杂度为O(32)。

### 2.3.2 实际运行时间测试与分析

实际运行时间测试可以提供除法算法在真实系统中的性能表现。

#### 测试流程

1. 准备一组不同大小的被除数和除数。

2. 在固定硬件和操作系统环境下运行除法算法。

3. 记录算法执行的平均时间,并与理论时间复杂度比较。

#### 性能测试结果分析

- 测试可以揭示出不同算法在实际运行环境下的表现差异。

- 分析这些差异可以帮助我们进一步优化算法。

以上为第二章的详细内容,涵盖了整数除法和浮点数除法的基本原理、硬件支持、性能评估等多个方面。下面将进入下一章节,继续深入探讨优化策略与算法改进。

# 3. 优化策略与算法改进

在优化策略与算法改进章节中,我们将深入探讨除法算法的优化方法,以减少计算误差和提高执行效率。从近似计算、并行计算到特殊情况处理,每个小节都试图提出并解释一种有效的解决方案。

## 3.1 近似计算与误差控制

在本小节中,我们将深入了解快速除法算法,并探讨如何通过近似计算来控制除法过程中产生的误差。

### 3.1.1 快速除法算法的原理与应用

快速除法算法,如牛顿-拉弗森迭代法(Newton-Raphson method),通过迭代逼近真实商值来实现除法。这种方法适用于浮点数除法,尤其是对高精度要求的场景。

```python

def newton_division(dividend, divisor):

# 初始猜测值为被除数,即dividend / divisor的近似值

estimate = dividend

for _ in range(iterations):

estimate = 0.5 * (estimate + dividend / estimate)

return estimate

# 示例使用

result = newton_division(100.0, 3.0)

print(f"The approximate division result is: {result}")

```

代码逻辑解读:

1. 初始猜测值`estimate`是被除数,这是因为当除数接近1时,被除数本身就是一个很好的近似值。

2. 在每次迭代中,通过牛顿迭代公式更新猜测值,逐步逼近真实商值。

3. `iterations`是迭代次数,它可以根据需要设定以达到所需的精度。

在实际应用中,迭代次数和精度之间的权衡是一个重要的考量点。虽然增加迭代次数可以提升精度,但同时也会增加计算量。因此,确定一个合适的迭代次数以平衡精度和性能是很重要的。

### 3.1.2 误差估计与精度调整技巧

在快速除法算法中,理解误差是如何产生的以及如何调整算法的精度至关重要。

#### 误差估计

误差产生于近似计算过程中,特别是在迭代次数受限的情况下。快速除法算法通常会引入舍入误差,这在使用浮点数时尤为明显。误差估计可以通过分析迭代过程中估计值的变化趋势来进行。

#### 精度调整技巧

为了调整算法的精度,可以根据实际需要选择不同的迭代策略:

- **增加迭代次数**:直接增加迭代次数可以减小误差,但会增加计算时间。

- **动态调整精度**:根据被除数和除数的大小动态调整迭代次数,例如,当被除数与除数相差较大时,可以减少迭代次数以节省时间。

- **多精度算法**:当要求高精度结果时,可以使用多精度算法进行计算。

## 3.2 并行计算在除法中的应用

在现代计算机体系中,多核处理器和GPU等硬件提供了丰富的并行计算资源。在除法运算中,利用这些资源可以显著提升算法性能。

### 3.2.1 多线程除法算法设计

多线程除法算法通过将大范围的除法运算任务分解成多个子任务,并利用多核CPU同时进行计算,以加速整个过程。

```c

#include <pthread.h>

#include <stdio.h>

#define THREAD_COUNT 4

void* division_thread(void* arg) {

long long* data = (long long*)arg;

data[0] /= data[1];

return NULL;

}

int main() {

pthread_t threads[THREAD_COUNT];

long long data[THREAD_COUNT * 2] = {100, 5, 200, 10, 300, 15, 400, 20};

long long* ptr = data;

for (int i = 0; i < THREAD_COUNT; ++i, ptr += 2) {

pthread_create(&threads[i], NULL, division_thread, (void*)ptr);

}

for (int i = 0; i < THREAD_COUNT; ++i) {

pthread_join(threads[i], NULL);

}

// 输出结果

for (int i = 0; i < THREAD_COUNT; ++i) {

printf("%lld / %lld = %lld\n", data[i * 2], data[i * 2 + 1], data[i * 2] / data[i * 2 + 1]);

}

return 0;

}

```

在上述代码中,我们定义了一个多线程程序,其中每个线程负责一个除法运算。由于除法是独立的运算,可以被并行执行。但需要注意的是,线程间的同步机制需要合理设计以避免竞态条件和提高效率。

### 3.2.2 GPU加速的除法运算

相较于CPU的多核心,GPU拥有成百上千的核心,可以在进行大量重复计算时提供更大的加速比。

```cpp

#include <cuda_runtime.h>

#include <iostream>

__global__ void divide_kernel(float *a, float *b, float *c, int size) {

int index = blockIdx.x * blockDim.x + threadIdx.x;

if (index < size) {

c[index] = a[index] / b[index];

}

}

int main() {

// 分配内存并初始化数据等操作

// ...

divide_kernel<<<(size + 255) / 256, 256>>>(d_a, d_b, d_c, size);

// 复制结果回主机内存等操作

// ...

return 0;

}

```

在上述代码片段中,我们展示了如何使用CUDA编写一个GPU内核函数来执行向量除法。GPU通过大量的并行执行单元并行处理向量中的每一个元素,从而提高运算速度。GPU加速的除法运算是现代高性能计算领域的重要技术之一。

## 3.3 特殊情况的处理方法

在除法算法的实现中,处理特殊情况如零值除法和溢出是非常重要的。

### 3.3.1 零值除法与溢出预防

零值除法是必须被特别处理的除法运算情况之一,因为它不仅会导致运算结果的不确定,还可能引发程序异常。

#### 零值除法处理

```c

if (divisor == 0) {

// 处理除以零的情况,例如抛出异常或返回特定值

handle_zero_division_error();

} else {

// 正常的除法计算

result = dividend / divisor;

}

```

在此代码片段中,我们首先检查除数是否为零。如果是,就调用`handle_zero_division_error()`函数来处理错误情况。这样可以确保程序不会因除数为零而产生未定义行为。

#### 溢出预防

溢出是另一个需要特别注意的问题。在进行除法运算时,要确保结果不会超出数据类型的表示范围。

```c

if (dividend > divisor * TYPE_MAX || divisor == 0) {

// 处理溢出或除以零的情况

handle_overflow_or_zero_division_error();

} else {

// 正常的除法计算

result = dividend / divisor;

}

```

在该代码片段中,我们加入了对溢出的检测。`TYPE_MAX`是数据类型能表示的最大值。如果被除数大于除数与`TYPE_MAX`的乘积,或者除数为零,就有可能发生溢出,这时需要进行适当的错误处理。

### 3.3.2 优化除法中的边界情况

优化除法中的边界情况包括但不限于零值除法和溢出,还有其他如负数除法的处理、小数点精度问题等。

#### 负数除法

负数除法在数学上是定义良好的,但在计算机中可能会有精度问题。在实现除法算法时,应该注意区分正负数,并确保结果符合预期。

#### 小数点精度问题

在处理浮点数时,除法可能会导致小数点后的有效位数减少,进而影响结果的准确性。针对此问题,可以采用四舍五入、截断或其他数值技术来控制精度损失。

### 代码块分析

在代码块中,每行代码后面都添加了注释来解释其执行逻辑和参数的含义。例如,在浮点数迭代计算中,注释解释了迭代算法的原理和更新策略。在多线程和GPU加速代码示例中,对如何初始化线程、同步和如何使用GPU内核函数进行了详细说明。确保读者可以跟随代码的逻辑来理解算法的工作原理。

### 参数说明和逻辑分析

在实现快速除法算法时,每次迭代的精度是由迭代次数和被除数与除数的初始差值决定的。迭代次数越多,误差越小,但计算时间越长。反之亦然。在实现多线程和GPU加速时,注意线程和线程块的数量,以及它们如何影响内存访问模式和性能。

### 表格

在本小节中,我们不需要直接展示表格,但可以考虑在优化近似除法算法或讨论多线程和GPU加速的性能时,展示不同参数设置下算法性能的对比数据。

### Mermaid 流程图

当我们讨论算法的优化和实现步骤时,Mermaid流程图可以用来表示算法的逻辑流程,如快速除法算法的迭代过程,或并行计算中线程的工作流程。

```mermaid

graph TD;

A[开始] --> B{判断除数是否为0};

B -->|是| C[处理零值除法错误];

B -->|否| D[初始化快速除法算法];

D --> E[进行迭代计算];

E --> F{迭代条件是否满足};

F -->|是| E;

F -->|否| G[返回最终结果];

G --> H[结束];

```

在该流程图中,我们展示了快速除法算法中的主要逻辑步骤。从判断除数是否为零开始,到迭代计算直至满足条件并返回结果为止。

通过以上内容,本章节已经全面覆盖了除法算法的优化策略和改进方法。从近似计算和误差控制,到并行计算的实施和特殊情况的处理,每个策略都是针对当前计算实践的挑战和需求。通过本小节的学习,读者应能更好地理解除法算法的高级概念和实际应用。

由于篇幅限制,本小节内容到此为止。下一小节将继续深入探讨特殊情况的处理方法,进一步完善除法算法的优化策略与改进途径。

# 4. 现代编译器的除法优化技术

现代编译器是软件开发的关键工具,其不仅负责将高级语言转换为机器码,还在优化性能方面扮演了重要角色。在处理除法运算时,编译器会实施多种策略以减少计算复杂度、提高执行效率和优化运行时间。本章将深入探讨现代编译器如何优化除法算法,并介绍向量化、SIMD优化技术以及性能分析与调优方法。

## 4.1 编译器优化概述

### 4.1.1 常见的编译器优化手段

编译器优化的目标是在不改变程序正确性的前提下,生成更快速、更高效和占用更少资源的代码。对于除法操作,编译器可以应用多种优化技术。

- **常数折叠(Constant Folding)**: 编译器在编译时计算出常量表达式的值,避免运行时的除法运算。

- **死代码消除(Dead Code Elimination)**: 移除那些计算结果未被使用到的除法操作,减少不必要的计算。

- **强度削弱(Strength Reduction)**: 将除法操作转换为低开销的运算,如乘法或位移操作。

- **循环展开(Loop Unrolling)**: 减少循环中的除法操作次数,通过减少迭代次数降低计算总量。

### 4.1.2 高级优化技术与除法算法的结合

在高级优化技术中,编译器会结合特定的硬件架构和指令集来执行更复杂的优化策略。

- **内联扩展(Inline Expansion)**: 将小型的函数直接替换为其内容,减少函数调用开销,包括除法调用的开销。

- **循环变换(Loop Transformation)**: 通过重新组织循环结构来避免除法,或者利用循环展开和向量化减少除法次数。

- **数据流分析(Data Flow Analysis)**: 分析程序的数据流,以确定更优的除法计算时机和方法。

## 4.2 向量化与SIMD优化

### 4.2.1 向量化操作的基础和原理

向量化操作是指将同一操作应用于数据集的多个元素。现代处理器通常具备单指令多数据(SIMD)指令集,能够同时对多个数据执行同一条指令,这对于除法运算尤为重要。

- **向量寄存器**: 处理器中的向量寄存器可以存储多个数据元素,而SIMD指令可以并行操作这些元素。

- **数据对齐**: 为了有效地利用SIMD指令,需要确保数据在内存中的对齐。

- **数据类型**: 确定使用适合向量化操作的数据类型,如使用整数或单精度浮点数以匹配硬件能力。

### 4.2.2 SIMD指令集在除法优化中的应用

SIMD指令集可以显著提高除法运算的性能,尤其是在数据密集型的应用中。

- **AVX、SSE指令集**: Intel和AMD处理器的SIMD指令集,支持对8个单精度或4个双精度浮点数同时执行除法。

- **NEON指令集**: ARM处理器的SIMD指令集,提供对整数和浮点数的并行操作能力。

- **编译器支持**: 现代编译器如GCC和Clang提供了内建函数,允许开发者编写向量化的除法代码,编译器会自动将它们转换为相应的SIMD指令。

```c

// 示例代码,使用GCC内建函数进行向量化的除法操作

#include <immintrin.h> // 包含AVX、SSE指令集

void vector_division(float *a, float *b, float *c, int n) {

__m256 va, vb, vc;

int i = 0;

for (; i <= n - 8; i += 8) {

va = _mm256_loadu_ps(&a[i]); // 加载8个float到va

vb = _mm256_loadu_ps(&b[i]); // 加载8个float到vb

vc = _mm256_div_ps(va, vb); // 并行除法

_mm256_storeu_ps(&c[i], vc); // 存储结果

}

// 处理剩余的数据

}

```

## 4.3 代码剖析与性能调优

### 4.3.1 利用性能剖析工具分析除法瓶颈

性能剖析工具能够帮助开发者识别代码中的性能瓶颈,特别是在除法运算方面。

- **GPROF**: 一个GNU工具,可以对程序进行采样剖析,提供详细的函数调用时间和次数信息。

- **Valgrind**: 一个内存错误检测和性能分析工具,可以用来分析除法操作的性能问题。

- **Intel VTune**: 一个性能分析工具,特别适合于分析和优化CPU密集型的程序,包括除法操作的性能。

### 4.3.2 实际案例中的性能调优技巧

在实际开发中,性能调优通常需要根据具体的应用场景和目标架构来进行。

- **矩阵运算**: 在矩阵运算中,利用向量化和SIMD指令集进行除法优化,可以显著提高运算效率。

- **加密算法**: 在实现加密算法时,优化大数除法可以减少计算时间,提高加密速度。

- **图像处理**: 图像处理算法中常常涉及复杂的除法运算,通过编译器优化可以提升处理速度。

通过对除法操作的深入分析和优化,开发者能够显著提升代码的性能和效率,从而构建更加快速和可靠的软件应用。

# 5. 除法算法的实践应用案例

在现代计算领域,除法算法不仅局限于基本的算术操作,它在科学计算、加密算法、图像处理和数据分析等多个领域扮演了重要角色。通过将除法算法与具体应用结合起来,可以进一步深化我们对算法优化和性能提升的理解。

## 5.1 科学计算中的除法优化实例

科学计算往往涉及大量高精度的数值运算,这些运算对时间效率和计算精度有着极高的要求。在这些应用场景中,除法的优化对提高整个计算过程的效率至关重要。

### 5.1.1 高精度计算库中的除法优化

高精度计算库(如GMP、MPFR)提供了对大数除法的优化实现,这些库通常实现了快速的Karatsuba算法、Toom-Cook算法以及FFT(快速傅里叶变换)技术等。例如,通过将大数除法分解为更小的子问题,使用FFT技术来加速多项式乘法,进而减少了除法的总体运算时间。

```c

#include <gmp.h>

int main() {

mpz_t a, b, result;

mpz_init(a);

mpz_init(b);

mpz_init(result);

// 初始化高精度数

mpz_set_str(a, "***", 10);

mpz_set_str(b, "***", 10);

// 执行高精度除法

mpz_tdiv_q(result, a, b); // 商

mpz_tdiv_r(result, a, b); // 余数

// 输出结果

gmp_printf("result: %Zd\n", result);

mpz_clear(a);

mpz_clear(b);

mpz_clear(result);

return 0;

}

```

### 5.1.2 矩阵运算中的除法加速策略

在矩阵运算中,例如求解线性方程组、特征值计算等,常常需要执行大量的除法操作。借助于专门的数值库(如BLAS、LAPACK),可以利用优化后的除法算法来加速这些运算。例如,利用LU分解进行矩阵求解时,通过特定的缓存优化和矩阵分块技术可以提高除法的效率。

## 5.2 加密算法中的除法应用

加密算法中,尤其是涉及到大数计算的公钥加密算法,除法是必不可少的操作之一。它在模运算中起到核心作用,是实现加密和解密过程的关键步骤。

### 5.2.1 模运算与大数除法

在RSA加密算法中,模n运算需要用到大数的除法,其中n通常是两个大素数的乘积。这类除法通常通过蒙哥马利乘法或二进制长除法来实现,以保证运算的安全性和高效性。

```python

def mod_inverse(a, m):

"""

计算模逆,使用扩展欧几里得算法

:param a: 原数

:param m: 模数

:return: a的模逆

"""

m0 = m

x0, x1 = 0, 1

if m == 1:

return 0

while a > 1:

# q 是商

q = a // m

t = m

m = a % m

a = t

t = x0

x0 = x1 - q * x0

x1 = t

# 使x1为正数

if x1 < 0:

x1 += m0

return x1

# 示例:计算7模逆于13

print(mod_inverse(7, 13)) # 应该输出3,因为7*3 mod 13 = 1

```

### 5.2.2 除法在公钥加密算法中的角色

在椭圆曲线加密(ECC)算法中,点加运算和倍点运算中经常使用到的标量乘法也依赖于除法运算。为了提高这些运算的效率,通常会采用如点坐标变换、窗口技术等来减少除法的次数。

## 5.3 图像处理与数据分析

在图像处理和数据分析的领域,除法通常用于实现各种归一化、缩放和滤波算法,用于图像的优化和数据的预处理。

### 5.3.1 除法在图像缩放中的应用

在图像缩放算法中,例如双线性插值、双三次插值等,需要对图像的像素进行加权平均计算。这涉及到大量的除法运算,算法的效率直接影响图像处理的速度和质量。

### 5.3.2 数据分析中的除法算法优化案例

在数据分析中,例如在统计学的方差计算中,需要对各个数据点与平均值之差进行平方,再进行求和和除法操作。使用在线算法可以优化这些运算,实时地计算出方差的近似值,提高了处理大数据集时的效率。

通过这些实践应用案例,我们可以看到除法算法不仅仅是一个基础算术操作,它的应用和优化贯穿于各种计算任务之中。了解和掌握这些高级应用和优化技术,对于IT专业人士来说至关重要。

0

0