【模型可视化】:PyTorch多任务学习模型工作机制深入可视化

发布时间: 2024-12-12 01:39:36 阅读量: 2 订阅数: 11

TensorBoard:PyTorch模型训练的可视化利器

# 1. 多任务学习与PyTorch概述

在当今的数据驱动时代,机器学习和深度学习模型变得越来越复杂,其应用范围也越来越广泛。为了充分利用数据集中的信息和提高模型的泛化能力,多任务学习应运而生。多任务学习是一种训练方法,它允许多个相关任务共享知识,通过联合学习优化来提升模型的整体性能。

PyTorch是一个开源的机器学习库,以其直观性和灵活性深受研究者和开发者的喜爱。它使用动态计算图,为研究人员提供了一种易于探索和实验的平台。PyTorch与多任务学习的结合,为开发者提供了一种有效的方式来构建和训练复杂模型。

本章将为读者提供多任务学习的基础知识和PyTorch的基本介绍。我们将从定义、优势以及挑战来探讨多任务学习,并进一步深入了解PyTorch框架的核心概念及其与多任务学习的兼容性。这将为接下来章节中构建和优化多任务学习模型打下坚实的基础。

# 2. PyTorch多任务学习基础

## 2.1 多任务学习的基本原理

### 2.1.1 多任务学习的定义和优势

多任务学习(Multi-task learning, MTL)是一种机器学习方法,它通过学习多个任务的共享表示来改善模型对每个任务的泛化能力。在多任务学习中,相关任务可以共享某些学习组件,比如特征提取器,这样可以在多个任务之间传递知识,达到更好的性能。通过联合学习任务之间的共同结构,模型能够利用较少的数据和参数量,同时提高各个任务的性能。

从应用的角度来看,多任务学习有几个显著的优势:

- **资源利用效率**:多任务学习可以共享计算资源和数据,减少对大量标注数据的依赖。

- **模型泛化能力提升**:通过在相关任务之间共享信息,模型对于未见过的数据的泛化能力通常会得到提高。

- **减少过拟合风险**:多任务学习引入了任务之间的正则化,有助于缓解过拟合现象。

### 2.1.2 多任务学习的关键挑战

尽管多任务学习具有上述优势,但在实践中,它也面临一系列的挑战:

- **任务间相关性的识别**:如何识别和度量任务间的相关性是决定模型性能的一个关键因素。

- **任务权重的分配**:在训练过程中确定每个任务的重要性,并相应地调整权重是一个复杂的问题。

- **数据不平衡问题**:不同任务的数据规模往往不同,导致训练过程中出现偏向数据量大的任务的情况。

为了解决这些挑战,研究人员提出了多种方法和策略,例如使用软参数共享、动态权重调整等机制。在本章后续的内容中,我们将详细探讨在PyTorch框架中实现这些策略的技术细节。

## 2.2 PyTorch框架介绍

### 2.2.1 PyTorch的核心概念

PyTorch是Facebook开发的一个开源机器学习库,它被广泛用于计算机视觉、自然语言处理等领域的研究和应用开发中。PyTorch的核心概念包括张量操作、自动梯度计算、动态计算图等。

- **张量操作**:PyTorch使用张量来表示数据,张量可以被看作是多维数组,支持丰富的数学运算,这些运算可以被自动地分配到GPU以加速计算。

- **自动梯度计算**:PyTorch通过自动微分机制(Autograd)实现自动梯度计算,用户只需定义前向传播过程,反向传播过程中所需的所有梯度会自动计算。

- **动态计算图**:PyTorch采用动态计算图,这意味着图是根据运行时的数据动态构建的,提供了更高的灵活性和适应性。

### 2.2.2 PyTorch与多任务学习的兼容性

PyTorch设计的灵活性和动态计算图的特点,使其非常适合进行多任务学习的实验和研究。PyTorch支持复杂的模型结构和参数共享机制,这使得设计和实现多任务学习变得相对简单。此外,PyTorch拥有活跃的社区和丰富的资源,包括预训练模型、扩展库等,为多任务学习提供了良好的生态环境。

在PyTorch中实现多任务学习,可以通过定义多个损失函数,并结合任务权重来计算总体损失。通过这种方式,模型能够同时学习多个任务,达到提升性能的目的。下面的代码示例展示了一个简单的多任务学习模型的构建过程:

```python

import torch

import torch.nn as nn

class MultiTaskModel(nn.Module):

def __init__(self):

super(MultiTaskModel, self).__init__()

# 定义共享的特征提取层

self.feature_extractor = nn.Sequential(

nn.Linear(input_size, hidden_size),

nn.ReLU(),

nn.Linear(hidden_size, shared_feature_size)

)

# 定义任务特定层

self.task_specific_layer = nn.ModuleDict({

'task1': nn.Linear(shared_feature_size, task1_output_size),

'task2': nn.Linear(shared_feature_size, task2_output_size)

})

def forward(self, x):

features = self.feature_extractor(x)

output = {}

for task_name, layer in self.task_specific_layer.items():

output[task_name] = layer(features)

return output

# 创建模型实例

model = MultiTaskModel()

# 定义任务的损失函数

task_losses = {

'task1': nn.CrossEntropyLoss(),

'task2': nn.MSELoss()

}

# 假设input和labels为批次数据

inputs = torch.randn(batch_size, input_size)

task1_labels = torch.randint(0, task1_output_size, (batch_size,))

task2_labels = torch.randn(batch_size, task2_output_size)

# 前向传播

outputs = model(inputs)

# 计算任务损失

losses = {}

for task_name in task_losses.keys():

losses[task_name] = task_losses[task_name](outputs[task_name], globals()[f"{task_name}_labels"])

# 综合损失

total_loss = sum(losses.values())

```

在上述代码中,我们定义了一个多任务学习模型,其中包含了共享的特征提取层和两个任务特定的层。然后计算每个任务的损失,并将它们综合起来得到总的损失。这个过程展示了如何在PyTorch中构建和训练一个简单的多任务学习模型。

## 2.3 构建多任务学习模型的步骤

### 2.3.1 数据准备和数据加载器

在开始构建多任务学习模型之前,首先要进行数据准备。数据集需要被合理地划分成训练集、验证集和测试集。对于多任务学习,通常每个任务的数据集都会有不同的特征和标签。数据加载器(DataLoader)在PyTorch中是一个重要的组件,它负责将数据分批次地送入模型进行训练和评估。

```python

from torch.utils.data import DataLoader, TensorDataset

# 假设我们有两个任务,每个任务都有输入和标签

task1_inputs, task1_labels = ... # 任务1的输入和标签数据

task2_inputs, task2_labels = ... # 任务2的输入和标签数据

# 创建数据集

task1_dataset = TensorDataset(task1_inputs, task1_labels)

task2_dataset = TensorDataset(task2_inputs, task2_labels)

# 创建数据加载器

task1_loader = DataLoader(task1_dataset, batch_size=batch_size, shuffle=True)

task2_loader = DataLoader(task2_dataset, batch_size=batch_size, shuffle=True)

```

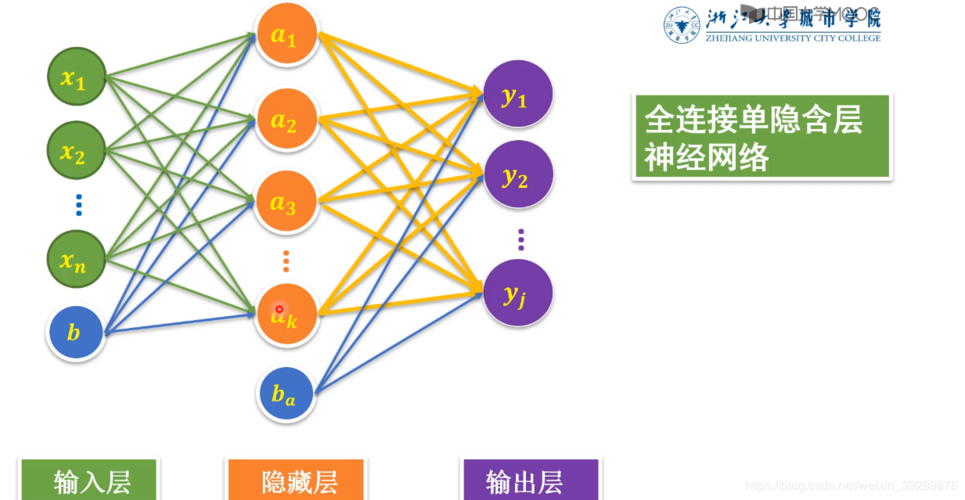

### 2.3.2 模型结构的设计

设计多任务学习模型的结构是关键的一步。模型通常包含共享的特征提取器和每个任务独立的输出层。设计时要考虑任务之间的相关性,以及如何平衡共享和特定任务的表示学习。

```python

class MultiTaskModel(nn.Module):

# ... 之前定义的部分

def forward(self, x):

features = self.feature_extractor(x)

return {

'task1': self.task_specific_layer['task1'](features),

'task2': self.task_specific_layer['task2'](features)

}

```

### 2.3.3 损失函数和优化器的选择

在多任务学习中,可能需要为每个任务选择合适的损失函数。例如,对于分类任务可以使用交叉熵损失(CrossEntropyLoss),对于回归任务可以使用均方误差损失(MSELoss)。

```python

# 定义损失函数

task1_loss_fn = nn.CrossEntropyLoss()

task2_loss_fn = nn.MSELoss()

# 定义优化器

optimizer = torch.optim.Adam(model.parameters(), lr=1e-3)

# 训练过程

for epoch in range(num_epochs):

for batch_data in zip(task1_loader, task2_loader):

task1_inputs, task1_labels = batch_data[0]

task2_inputs, task2_labels = batch_data[1]

# 前向传播

task1_outputs = model(

```

0

0