模型预测可视化:PyTorch与TensorBoard的完美融合

发布时间: 2024-12-12 04:28:49 阅读量: 13 订阅数: 5

Pytorch模型训练实用教程

# 1. 模型预测可视化的重要性与工具概述

在当今数据驱动的AI领域,模型预测的可视化不仅仅是一种展示结果的手段,更是理解和解释模型行为、进行模型调优以及发现潜在问题的关键工具。可视化可以将复杂的数据转换成直观的图像,帮助研究人员、工程师甚至最终用户更好地理解模型的性能和决策过程。

## 1.1 可视化在模型开发中的作用

可视化能够揭示模型预测的准确性,帮助识别数据集中的模式和异常值。此外,通过可视化历史训练数据,开发者可以观察模型对数据的理解是否与实际应用场景相匹配,确保模型的泛化能力。

## 1.2 选择合适的可视化工具

为了有效地实现模型可视化,选择合适的工具至关重要。一些常见的可视化工具包括matplotlib、seaborn、Plotly以及专门针对机器学习的TensorBoard等。这些工具各有特点,适用于不同的可视化需求,如二维图表、三维图形、实时数据流等。

## 1.3 持续集成可视化工具的重要性

随着模型开发过程的迭代,将可视化工具集成到模型训练、评估和部署的持续集成流程中,可以提供持续的洞察力。这种集成使得团队成员能够及时获得反馈,缩短开发周期,减少因误解模型行为而导致的错误决策。

# 2. PyTorch深度学习框架基础

## 2.1 PyTorch的核心组件介绍

### 2.1.1 张量操作和自动微分

在深度学习中,张量操作是构建和训练模型的基础,而自动微分则是进行梯度下降等优化算法的关键。PyTorch通过其核心组件张量(tensor)来执行这些操作,同时提供自动微分的能力,极大地简化了模型训练的过程。

张量可以视为一个多维数组,它与NumPy的ndarray类似,但张量可以在GPU上进行加速计算,这对于深度学习来说是非常重要的。通过PyTorch提供的各种操作,我们可以高效地进行矩阵运算、元素级运算以及复杂的变换。

```python

import torch

# 创建一个随机张量

x = torch.randn(3, 3)

print(x)

# 张量基本操作:加法

y = torch.randn(3, 3)

result = x + y

print(result)

# 张量基本操作:矩阵乘法

result = torch.mm(x, y.t())

print(result)

```

上述代码展示了创建随机张量、张量之间的基本操作。`torch.randn` 函数用于生成标准正态分布的随机数填充张量。`torch.mm` 函数执行矩阵乘法。这些操作都是对张量的基本运算操作。

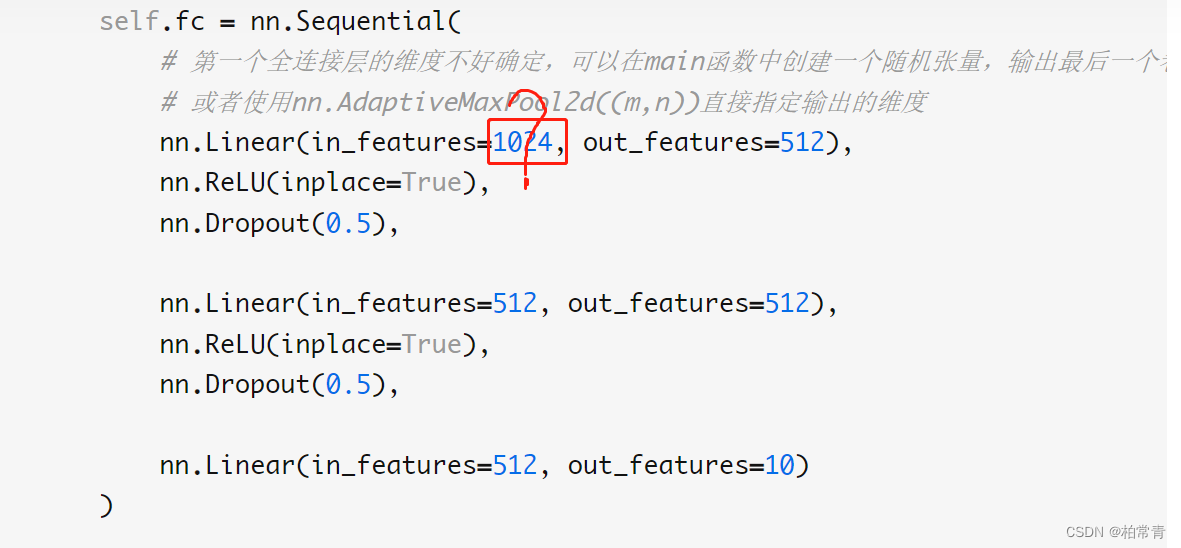

### 2.1.2 模型构建和训练循环

模型构建是通过定义一个从输入数据到输出数据的映射函数来完成的。在PyTorch中,这通常是通过定义一个`nn.Module`的子类,并在其中使用`nn.Linear`(线性层)和其他层类型来完成。一旦模型定义完成,就需要编写训练循环来完成模型的训练。

```python

import torch.nn as nn

import torch.nn.functional as F

class SimpleNeuralNetwork(nn.Module):

def __init__(self):

super(SimpleNeuralNetwork, self).__init__()

self.fc1 = nn.Linear(3, 256)

self.fc2 = nn.Linear(256, 10)

def forward(self, x):

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

# 实例化模型、损失函数和优化器

model = SimpleNeuralNetwork()

criterion = nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters())

# 训练循环

def train(model, data_loader, criterion, optimizer, num_epochs):

for epoch in range(num_epochs):

running_loss = 0.0

for inputs, labels in data_loader:

# 梯度清零

optimizer.zero_grad()

# 前向传播

outputs = model(inputs)

# 计算损失

loss = criterion(outputs, labels)

# 反向传播

loss.backward()

# 更新参数

optimizer.step()

running_loss += loss.item()

# 打印统计信息

print(f'Epoch {epoch+1}/{num_epochs} Loss: {running_loss/len(data_loader)}')

# 假设data_loader是已加载好的数据集

train(model, data_loader, criterion, optimizer, num_epochs=10)

```

上述代码定义了一个简单的全连接神经网络,并展示了如何进行一个基本的训练循环。在这个循环中,我们首先清零梯度,然后执行前向传播,计算损失,执行反向传播,最后更新模型的参数。这个训练循环是深度学习中的一个核心概念。

## 2.2 PyTorch高级特性

### 2.2.1 数据加载和预处理

数据加载和预处理是训练深度学习模型的重要步骤。PyTorch提供了`DataLoader`类和`Transforms`类来方便地完成这些任务。通过定义`Dataset`类,可以实现自定义的数据加载器。

```python

import torch.utils.data as data

class CustomDataset(data.Dataset):

def __init__(self, data, labels):

self.data = data

self.labels = labels

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

return self.data[idx], self.labels[idx]

# 假设data和labels是我们需要加载的数据和标签

dataset = CustomDataset(data, labels)

data_loader = data.DataLoader(dataset, batch_size=32, shuffle=True)

```

通过上述代码,我们定义了自定义的数据集,并通过`DataLoader`来创建数据批处理和打乱数据的功能,这是训练过程中常见的步骤。

### 2.2.2 模型保存与加载技巧

模型训练完成后,通常需要将模型保存下来,以便后续的加载和预测。PyTorch通过`torch.save`和`torch.load`提供了模型的保存和加载功能。

```python

# 保存模型

torch.save(model.state_dict(), 'model.pth')

# 加载模型

model = SimpleNeuralNetwork()

model.load_state_dict(torch.load('model.pth'))

model.eval() # 设置为评估模式

```

在保存模型时,通常只保存模型的参数(state_dict)。在加载模型时,需要创建模型的实例,并用`load_state_dict`方法加载参数。注意,在进行预测之前,需要将模型设置为评估模式(`model.eval()`),这会关闭一些影响模型评估的层,比如Dropout。

### 2.2.3 自定义层和函数

PyTorch的灵活性还体现在允许用户自定义层和函数。这在深度学习研究中非常有用,因为这可以创建研究人员需要的任何特定操作。

```python

class CustomLayer(nn.Module):

def __init__(self, in_channels, out_channels, kernel_size):

super(CustomLayer, self).__init__()

# 定义自定义层的内部结构

self.conv = nn.Conv2d(in_channels, out_channels, kernel_size)

def forward(self, x):

return self.conv(x)

# 使用自定义层

custom_layer = CustomLayer(in_channels=3, out_channels=64, kernel_size=3)

output = custom_layer(torch.rand(1, 3, 32, 32))

```

在这个例子中,我们定义了一个自定义层`CustomLayer`,它继承自`nn.Module`并重写了`forward`方法。之后,我们可以像使用内置层一样使用这个自定义层。

## 2.3 实践:PyTorch基本使用案例

### 2.3.1 简单神经网络的实现

下面将展示如何利用PyTorch实现一个简单的神经网络,并对其执行前向传播和反向传播的过程。

```python

import torch.nn as nn

import torch.nn.functional as F

class SimpleNet(nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.fc1 = nn.Linear(784, 256) # 输入层到隐藏层1

self.fc2 = nn.Linear(256, 10) # 隐藏层1到输出层

def forward(self, x):

x = F.relu(self.fc1(x.view(-1, 784))) # 展平后进行线性变换,加上激活函数

x = self.fc2(x)

return x

model = SimpleNet()

```

上述代码创建了一个简单的两层全连接神经网络。我们首先定义了模型的结构,然后创建了模型实例。这只是一个实例化模型的过程,真正的训练需要编写训练循环。

### 2.3.2 训练过程的可视化

训练过程的可视化是一个非常有用的工具,能够帮助我们更好地理解模型训练的状态以及是否存在任何问题,比如过拟合或欠拟合。

```python

import matplotlib.pyplot as plt

# 假设我们已经运行了训练函数,并且记录下了损失值

train_losses = [...] # 存储每个epoch的训练损失

val_losses = [...] # 存储每个epoch的验证损失

plt.figure()

plt.plot(train_losses, label='Training loss')

plt.plot(val_losses, label='Validation loss')

plt.legend()

plt.show()

```

在这段代码中,我们使用`matplotlib`库来绘制训练损失和验证损失随epoch变化的图。这种可视化的图表可以帮助我们快速了解模型训练的进度和可能的性能指标。

在实践中,可视化训练过程通常需要记录不同指标,如损失、准确率等,并将这些指标通过图表展示出来。这样的图表可以帮助研究人员或工程师直观地感知模型的训练情况。

# 3. TensorBoard可视化工具深入解析

### 3.1 TensorBoard基础使用

#### 3.1.1 安装与配置TensorBoard

TensorBoard是TensorFlow的可视化工具,但也可以与PyTorch集成,用于查看模型训练过程中的各种数据,比如损失值、准确率、权重分布等。首先,确保TensorFlow已经被安装。如果没有安装,可以使用pip进行安装:

```bash

pip install tensorflow

```

TensorBoard可以在训练脚本中通过日志记录器来收集数据。这些数据之后可以在TensorBoard界面中可视化。下面的代码块展示了如何初始化一个TensorBoard的日志记录器:

```python

import tensorflow as tf

# 创建一个日志目录

logdir = "logs/train"

writer = tf.summary.create_file_writer(logdir)

# 也可以使用上下文管理器

with writer.as_default():

# 记录一些简单的数据,例如训练步数

for i in range(100):

tf.summary.scalar('step', i, step=i)

```

此代码段创建了一个名为`logs/train`的日志目录,并通过`tf.summary.create_file_writer`初始化了一个写入器。写入器`writer`用于将数据写入该日志目录。在上下文管理器`with writer.as_default()`中,使用`tf.summary.scalar`记录了100个训练步数的数据。

#### 3.1.2 TensorBoard界面与功能概览

安装和配置完成后,启动TensorBoard服务,并指定日志目录:

```bash

tensorboard --logdir=logs/train

```

然后,通过浏览器访问TensorBoard服务的网址,通常为`http://localhost:6006`。界面概览包含以下几个主要部分:

- **Scalars:** 展示标量值随时间的变化,例如损失值、准确率。

- **Graphs:** 展示计算图,帮助理解模型结构。

- **Distributions:** 分布展示,帮助理解参数的分布情况。

- **Histograms:** 展示权重和偏置随时间的变化。

- **Projector:** 可以将高维数据投影到二维或三维空间进行可视化。

- **Audio:** 如果记录了音频数据,可以在此处播放。

### 3.2 TensorBoard高级功能

#### 3.2.1 自定义可视化面板

为了更好地展示数据,TensorBoard提供了自定义面板的功能。例如,可以创建一个面板来观察不同类别的准确率:

```python

# 在日志中记录类别准确率

for i in range(100):

accuracy = {

'class1': i * 0.01,

'class2': i * 0.02,

'class3': i * 0.03,

# ... 其他类别

}

with writer.as_default():

tf.summary.scalar('accuracy/class1', accuracy['class1'], step=i)

tf.summary.scalar('accuracy/class2', accuracy['class2'], step=i)

tf.summary.scalar('accuracy/class3', accuracy['class3'], step=i)

# ... 其他类别

```

在TensorBoard的`SCALARS`面板中,可以创建一个新的面板组(比如命名为`Custom Accuracy`),并添加所有新记录的准确率指标。

#### 3.2.2 超参数调整与实验对比

TensorBoard除了可视化训练过程中的性能指标外,还可以用来记录和对比不同的超参数设置。可以创建多个日志目录,每个目录对应一组超参数设置:

```bash

# 训练模型并记录超参数设置1

logdir超参数1 = "logs/train超参数1"

writer超参数1 = tf.summary.create_file_writer(logdir超参数1)

# 训练模型并记录超参数设置2

logdir超参数2 = "logs/train超参数2"

writer超参数2 = tf.summary.create_file_writer(logdir超参数2)

# ... 其他超参数设置

```

在TensorBoard的`HISTOGRAMS`面板中,可以根据超参数的不同设置,对比不同设置下参数分布的变化。

### 3.3 实践:TensorBoard在模型训练中的应用

#### 3.3.1 可视化损失函数和准确率

使用TensorBoard可视化损失函数和准确率是其最常见的应用之一。在PyTorch中,可以在每个epoch结束时记录损失和准确率,并在TensorBoard中进行可视化。

```python

for epoch in range(epochs):

# ... 模型训练代码

# 记录损失和准确率

with writer.as_default():

tf.summary.scalar('Loss/train', loss.item(), step=epoch)

tf.summary.scalar('Accuracy/train', accuracy.item(), step=epoch)

```

#### 3.3.2 张量和图形的可视化技巧

TensorBoard还可以用来可视化张量和计算图。通过`tf.summary.trace_on`启用追踪功能,然后执行模型的前向传播,TensorBoard将记录张量形状和计算图。

```python

# 启用追踪

tf.summary.trace_on(graph=True, profiler=True)

# 模型前向传播

for input, target in data_loader:

output = model(input)

loss = loss_fn(output, target)

# 将追踪的数据写入日志文件

with writer.as_default():

tf.summary.trace_export(

name="model_trace",

step=0,

profiler_outdir=logdir

)

```

在TensorBoard的`GRAPHS`面板中,用户可以查看并分析计算图的结构和参数。

通过掌握上述使用TensorBoard的技巧,您将能够有效地监控和分析模型的训练过程,为调优和改进提供直观的数据支持。

# 4. PyTorch与TensorBoard的集成与进阶应用

## 4.1 集成PyTorch和TensorBoard

### 4.1.1 日志记录与TensorBoard集成

集成PyTorch与TensorBoard首先要了解日志记录的重要性,它可以让我们对训练过程中的各类指标进行追踪。TensorBoard提供了丰富的可视化手段,以帮助开发者更好地理解这些指标的变化。

在PyTorch中,我们通常使用`torch.utils.tensorboard`中的`SummaryWriter`来记录日志。例如,记录损失值和准确率:

```python

from torch.utils.tensorboard import SummaryWriter

import numpy as np

# 初始化SummaryWriter

writer = SummaryWriter('runs/experiment_1')

# 假设num_epochs是我们训练的轮数

for epoch in range(num_epochs):

for i, (inputs, labels) in enumerate(train_loader):

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

# 记录训练过程中的损失值

writer.add_scalar('training loss', loss.item(), epoch * len(train_loader) + i)

# 假设我们有验证集的准确率

val_acc = ... # 这里是计算准确率的逻辑

writer.add_scalar('accuracy/val', val_acc, epoch)

# 关闭SummaryWriter

writer.close()

```

### 4.1.2 高级日志记录技巧与案例

当我们需要记录更多种类的日志时,例如图像、模型参数等,TensorBoard提供了更多高级的日志记录接口。例如,我们可以通过`add_image`记录训练过程中的图像样本,通过`add_histogram`记录模型参数的分布:

```python

# 假设我们有样本图像

sample_image = ... # 这里是获取样本图像的逻辑

writer.add_image('sample_image', sample_image, epoch)

# 记录模型参数分布

for name, param in model.named_parameters():

writer.add_histogram(name, param, bins='tensorflow')

```

这里,我们使用`add_image`函数在TensorBoard中展示图像,并通过`add_histogram`记录模型参数的直方图,以便我们观察参数在整个训练过程中的变化。

## 4.2 进阶可视化技术

### 4.2.1 高级数据可视化案例

在深度学习中,除了基本的标量指标(如损失值)外,我们还经常需要可视化复杂的数据结构,比如权重矩阵、注意力图等。TensorBoard的高级可视化工具可以帮助我们更好地理解这些数据。

例如,我们可以使用`add_pr_curve`来绘制精确度-召回率曲线,这对于分类问题特别有用:

```python

# 假设我们有一个多分类问题,并且有相应的标签和预测

labels = ... # 真实标签

predictions = ... # 预测概率

# 绘制精确度-召回率曲线

class_index = 1 # 我们关注的类别索引

writer.add_pr_curve(

tag=f'pr_curve_{class_index}',

labels=labels,

predictions=predictions[:, class_index],

global_step=epoch

)

```

### 4.2.2 动态图表和视频演示

TensorBoard也支持动态图表,这对于展示随时间变化的视觉效果非常有用。例如,我们可以记录视频并将其集成到TensorBoard中,从而可视化模型对视频序列的处理过程。

```python

# 假设我们有一个视频序列

video_frames = ... # 视频帧序列

# 创建视频摘要

video_summary = tf.summary.create_file_writer('video_summary')

with video_summary.as_default():

for frame in video_frames:

# 将视频帧转换为TensorBoard接受的格式

tf.summary.video('video', frame, step=epoch, fps=1)

```

在这里,我们创建了一个视频摘要,并将视频帧按帧记录下来。然后可以在TensorBoard中以视频形式播放。

## 4.3 实践:综合案例分析

### 4.3.1 端到端模型训练与可视化

在实际的深度学习项目中,我们会使用PyTorch来构建模型,并通过TensorBoard来监控训练过程。以下是一个简化的案例,展示从数据预处理到模型训练,再到最终的可视化分析。

```python

import torch

import torchvision

import torchvision.transforms as transforms

from torch.utils.tensorboard import SummaryWriter

from torch import nn, optim

# 数据预处理

transform = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))])

trainset = torchvision.datasets.MNIST(root='./data', train=True,

download=True, transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size=4,

shuffle=True, num_workers=2)

# 模型构建

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.fc1 = nn.Linear(28*28, 128)

self.fc2 = nn.Linear(128, 64)

self.fc3 = nn.Linear(64, 10)

def forward(self, x):

x = x.view(-1, 28*28)

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

x = self.fc3(x)

return x

net = Net()

# 损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(net.parameters(), lr=0.001, momentum=0.9)

# 训练模型

writer = SummaryWriter('runs/end_to_end_example')

num_epochs = 5

for epoch in range(num_epochs):

running_loss = 0.0

for i, data in enumerate(trainloader, 0):

inputs, labels = data

# 前向传播、反向传播和优化

optimizer.zero_grad()

outputs = net(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

if i % 2000 == 1999: # 每2000个小批量打印一次

print('[%d, %5d] loss: %.3f' %

(epoch + 1, i + 1, running_loss / 2000))

writer.add_scalar('training loss',

running_loss / 2000, epoch * len(trainloader) + i)

running_loss = 0.0

print('Finished Training')

# 关闭SummaryWriter

writer.close()

```

### 4.3.2 案例研究:图像识别模型可视化

以图像识别任务为例,我们可以使用TensorBoard来可视化模型在训练过程中的表现。通过损失函数和准确率的可视化,我们可以了解模型是否在过拟合或欠拟合,以及是否需要调整超参数。

以下是一些关键的可视化步骤:

- 监控训练集和验证集上的准确率。

- 监控训练过程中的损失下降情况。

- 使用`add_graph`来可视化模型结构。

- 使用`add_pr_curve`或`add_confusion_matrix`来分析模型的分类性能。

通过将这些技术应用于案例研究,我们可以更好地理解PyTorch和TensorBoard的集成所带来的可视化优势。

# 5. 未来展望与最佳实践

随着人工智能技术的不断发展,模型预测的可视化不仅仅局限于数据的直观展示,而是扩展到了模型解释性、实验流程管理以及跨学科沟通等更广阔的领域。本章将探讨当前可视化技术的局限性与挑战,预测未来发展的趋势,并提出最佳实践和建议。

## 当前可视化技术的局限与挑战

当前的可视化技术虽然已经能够满足大部分数据展示的需求,但仍存在一些局限和挑战。首先,对于高维数据的可视化仍是一个难题,需要采用降维技术,如t-SNE或UMAP等,来辅助展示。其次,实时数据流的可视化对计算性能提出了较高的要求,如何在不影响训练效率的前提下实时展示数据,是一个需要解决的问题。再者,不同的研究人员和开发者可能需要不同的可视化工具和方法,如何使可视化工具能够满足个性化需求,提高其灵活性和可扩展性,也是当前面临的挑战之一。

## 未来发展趋势分析

在未来的发展中,可视化技术将会更加重视以下几个方面:

1. **模型解释性**:随着模型的复杂性增加,如何提高模型的解释性成为一个重要的研究方向。可视化技术可以帮助开发者理解模型的工作原理,特别是在深度学习模型中,可视化技术通过展示内部结构和决策过程,使得模型更加透明。

2. **交互式分析**:交互式可视化工具允许用户通过直接操作来探索数据,如调整参数、放大缩小等,这种互动性将为研究人员提供更深入的洞察力。

3. **集成与自动化**:集成不同的可视化工具以及自动化报告生成,可以提高工作效率,使得研究人员可以将更多的时间投入到模型开发而非重复的报告工作中。

## 最佳实践和建议

### 如何构建可重复的实验流程

可重复的实验流程对科研和产品开发至关重要。要构建这样的流程,需要遵循以下建议:

1. **标准化数据处理**:记录所有数据预处理步骤,并确保在不同实验中可以复现相同的预处理流程。

2. **版本控制**:使用版本控制系统管理代码和配置文件,确保每一次实验的完整性和可追溯性。

3. **自动化记录**:自动化记录实验过程中的关键参数和日志信息,使用工具如TensorBoard来记录训练过程中的各项指标。

### 如何利用可视化进行模型解释和沟通

可视化不仅仅是数据的图形化表示,更是沟通和解释模型决策过程的有力工具。以下是一些建议:

1. **简化和清晰的图表**:使用简单清晰的图表来表达复杂概念,使得非技术背景的人员也能够理解模型的工作原理和结果。

2. **交互式可视化**:利用交互式可视化技术,允许观众通过鼠标操作、缩放等来探索数据,增加信息传递的深度和广度。

3. **可视化故事叙述**:将可视化元素组织成一个故事,讲述数据和模型是如何影响决策的,这对于汇报工作、产品演示等方面具有巨大价值。

通过上述章节内容的探讨和分析,可以看出可视化技术在人工智能领域的重要性,以及它在解决复杂问题和促进沟通方面的潜力。希望未来的可视化技术能够在现有的基础上取得新的突破,为人类带来更多的便利和洞见。

0

0