模型并行VS数据并行:PyTorch选择最佳策略的指南

发布时间: 2024-12-12 04:01:25 阅读量: 10 订阅数: 12

跨越时间的智能:PyTorch模型保存与加载全指南

# 1. 并行计算基础与PyTorch概览

## 1.1 并行计算简述

并行计算是提高计算机处理能力的一种关键方式,它通过多个处理器同时工作来加速计算任务。在深度学习领域,随着模型和数据量的不断增长,传统的单机计算已无法满足需求,因此并行计算成为了实现大规模模型训练和推理的必要手段。

## 1.2 PyTorch并行计算框架

PyTorch是一个开源的机器学习库,它提供了多种并行计算工具和接口,极大地简化了并行编程的复杂性。PyTorch的并行计算框架包括了模型并行和数据并行,这两者可以独立使用,也可以组合使用,来适应不同的计算需求和硬件资源。

## 1.3 PyTorch并行计算优势

PyTorch并行计算框架的优势在于它高度的模块化和灵活性,使得开发者能够根据具体的应用场景和硬件环境,快速构建并优化并行策略。同时,由于PyTorch在研究社区的广泛使用,大量相关的并行计算技术和优化方法可供参考和应用,极大地加速了模型的训练和部署过程。

本章总结了并行计算的重要性,并对PyTorch并行计算框架进行了简要介绍,为后续章节中详细介绍模型并行和数据并行以及其实战操作打下了基础。

# 2. 模型并行与数据并行的理论分析

## 2.1 模型并行的基本概念

### 2.1.1 模型并行的工作原理

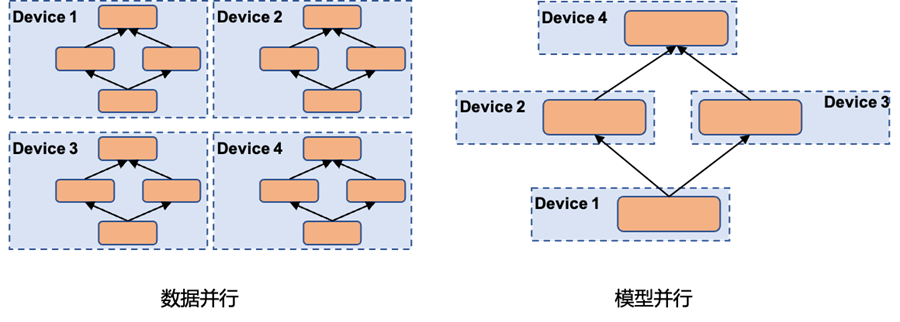

模型并行是一种在深度学习训练过程中常用的技术,它将一个深度神经网络的不同部分分配到不同的计算设备上进行训练。这种策略在处理巨大模型时尤其有用,因为这些模型可能无法在单一设备上容纳全部参数。

工作原理上,模型并行要求系统维护多个模型副本的相同部分,这样各个设备可以独立执行计算。在前向传播过程中,数据会根据模型的结构被分发到不同的设备上进行处理。同样地,在后向传播过程中,各个设备会计算梯度的部分值,然后将这些局部梯度汇总起来进行全局梯度更新。

这种方法的一个关键挑战是如何有效地划分模型以及如何同步不同设备间的信息。模型划分不仅要考虑内存和计算限制,还需要考虑设备间的通信开销。

### 2.1.2 模型并行的优势与局限性

模型并行的优势在于它允许训练那些在单个设备上无法存储或处理的超大型模型。例如,当模型参数的数量远远超过单个GPU的内存容量时,模型并行成为一种必要的选择。另外,模型并行使得可以利用分散的计算资源进行联合训练,为大规模并行化提供了可能。

然而,模型并行也有它的局限性。首先,网络通信开销可能成为性能瓶颈。当模型被分散到多个设备上时,设备间需要频繁地交换数据,如果通信速度跟不上计算速度,那么整个训练过程会受到明显拖慢。其次,实现模型并行通常比数据并行更复杂,需要更多的编程工作和调试工作。而且,模型并行往往难以扩展到大规模,因为它需要仔细设计来优化计算与通信之间的平衡。

## 2.2 数据并行的核心原理

### 2.2.1 数据并行的实现机制

数据并行是一种利用多计算设备对相同模型处理不同数据子集的训练策略。其核心思想是将输入数据分割为多个批次(batch),然后每个计算设备处理一个或多个批次的数据,同时使用相同的模型结构和参数。

在数据并行中,每个设备负责计算部分的损失值并对该部分数据进行前向和后向传播计算。每个设备独立地进行梯度计算,随后将各自计算出的梯度平均化,并更新全局模型参数。这一过程通常通过参数服务器(Parameter Server)或Ring-AllReduce通信模式来协调和同步梯度更新。

数据并行的关键优势是它通过分散数据处理来加速训练过程,使得可以有效地利用多个设备的计算能力。同时,这种方法相对简单易于实现,因为它不需要对模型架构进行修改。

### 2.2.2 数据并行的应用场景

数据并行特别适合于那些需要在大规模数据集上训练的模型,特别是卷积神经网络(CNN)和循环神经网络(RNN)。在训练图像识别、自然语言处理等任务时,数据集通常很大,而数据并行能够显著减少单个设备的内存和计算负载,从而加快整个训练过程。

此外,数据并行也便于并行化工作,使得我们可以使用多GPU或多机器环境进行分布式训练,从而缩短了模型训练的时间。随着现代深度学习框架如PyTorch和TensorFlow对数据并行的优化和支持,这一策略变得越来越受欢迎。

## 2.3 并行策略的对比分析

### 2.3.1 模型并行与数据并行的适用性对比

模型并行和数据并行各有其适用场景。模型并行更适合于处理那些模型尺寸过大的情况,即模型参数的数量远超单个GPU能够处理的范围。对于这类超大型模型,无论数据量大小,都需要采取模型并行策略来解决内存限制问题。

而数据并行则适用于拥有大量数据和足够单个设备处理的模型。数据并行可以快速地在多个设备之间分配数据批次的训练,以此来加速训练过程。数据并行策略一般更容易实现,并且扩展性较好。

在实际应用中,当遇到既需要处理大量数据又需要训练超大模型的复杂情况时,我们可能会同时采用模型并行和数据并行的混合策略。这需要根据具体的模型结构、数据量、硬件资源等多种因素综合考虑和权衡。

### 2.3.2 理论上的性能考量与评估

从理论上讲,模型并行和数据并行的性能评估主要取决于计算效率、通信开销以及资源利用率。模型并行的性能瓶颈往往出现在设备间的通信延迟上,而数据并行的性能瓶颈则可能出现在I/O带宽限制或参数服务器的处理能力上。

要评估这两种并行策略的性能,需要计算并行执行时间、计算与通信开销比率、并行加速比等关键指标。加速比是衡量并行策略效果的一个重要指标,它表示了并行处理相对于串行处理的性能提升程度。

在实施并行策略时,理想情况下,我们希望随着并行设备数量的增加,加速比能接近线性增长。然而,在实际中,由于各种资源限制和开销,加速比往往达不到理论上的最优值。因此,系统设计者需要通过合理的资源调度和优化,尽可能地提高加速比并减少资源浪费。

下一章节将基于上述理论分析,深入介绍在PyTorch框架中如何实现并行计算,以及具体的实践操作和技巧。

# 3. PyTorch中的并行计算实践

## 3.1 PyTorch并行计算框架介绍

### 3.1.1 PyTorch Distributed库概述

PyTorch Distributed库是PyTorch为了支持分布式训练而提供的一个扩展库。它允许开发者在多个计算节点上部署模型,并通过数据并行和模型并行的方式对模型进行训练。分布式库设计的核心是易于使用,同时它通过优化底层通信和同步机制,实现了良好的性能。

PyTorch Distributed为分布式训练提供了丰富的API,包括但不限于初始化分布式环境、创建和管理进程组、同步的点对点通信以及广播、收集和分散数据的集体操作。这些API的设计考虑到了易用性和灵活性,使得开发者能够根据具体的应用场景选择合适的通信策略。

### 3.1.2 PyTorch并行计算的基本API

PyTorch提供了一些基本的API来实现并行计算,其中包括:

- `torch.distributed.init_process_group(backend, ...)`:初始化进程组,后端可以是`gloo`或者`nccl`等。

- `torch.distributed.barrier()`:在所有进程上设置屏障,确保它们在继续执行之前达到相同的执行点。

- `torch.distributed.reduce(tensor, ...)`:将多个进程中的张量归约到指定进程。

- `torch.distributed.broadcast(tensor, ...)`:在所有进程间广播张量。

- `torch.distributed.all_reduce(tensor, ...)`:将所有进程中的张量进行归约后广播到所有进程。

这些API是构建复杂并行算法的基础,但开发者需要注意通信和同步的细节,以免在分布式环境中产生死锁或其他并发问题。

## 3.2 模型并行的实战操作

### 3.2.1 模块划分与分割策略

模型并行要求将模型的各个部分分布到不同的计算节点上进行训练。在PyTorch中,这通常意味着需要手动地将模型拆分成不同的模块,并将这些模块分配到不同的设备(如GPU或CPU)上。分割策略的选取取决于模型的结构和参数量,其中关键是要减少节点间的通信开销。

一个常见的分割策略是,将模型中参数量较大的部分放在一个节点上,而参数量较小的部分放在其他节点上。这样可以平衡节点间的计算负载和内存使用。此外,可以对网络层进行重新组织,以减少跨节点的通信次数,例如合并相邻的线性层或卷积层。

### 3.2.2 数据流与通信机制

在模型并行中,数据流的设计非常关键。数据需要从数据源加载,经过预处理后分发到各个节点。这个过程中,要确保每个节点上的模型模块能够及时接收到需要处理的数据。

通信机制是模型并行中的另一个重要组成部分。在PyTorch中,可以通过分布式库中的集体操作如`all_reduce`来同步不同节点上的梯度信息。但在实践中,由于不同节点间的通信延迟,往往需要对梯度聚合的时间进行精细的调整。

## 3.3 数据并行的实战操作

### 3.3.1 数据划分与批处理策略

数据并行是将模型的副本部署到多个计算节点上,每个节点处理输入数据的一

0

0