混合精度训练掌握:PyTorch提升数据并行性能的关键技术

发布时间: 2024-12-12 03:50:12 阅读量: 14 订阅数: 12

实现SAR回波的BAQ压缩功能

# 1. 混合精度训练基础与重要性

在深度学习领域,模型的训练过程要求高精度的计算,但同时也需要高效的执行速度和较低的资源消耗。混合精度训练作为一种先进的技术,通过结合不同精度的数值格式,解决了这一矛盾,从而在保证模型精度的同时,大幅度提高了训练的效率。

## 1.1 混合精度训练的基本概念

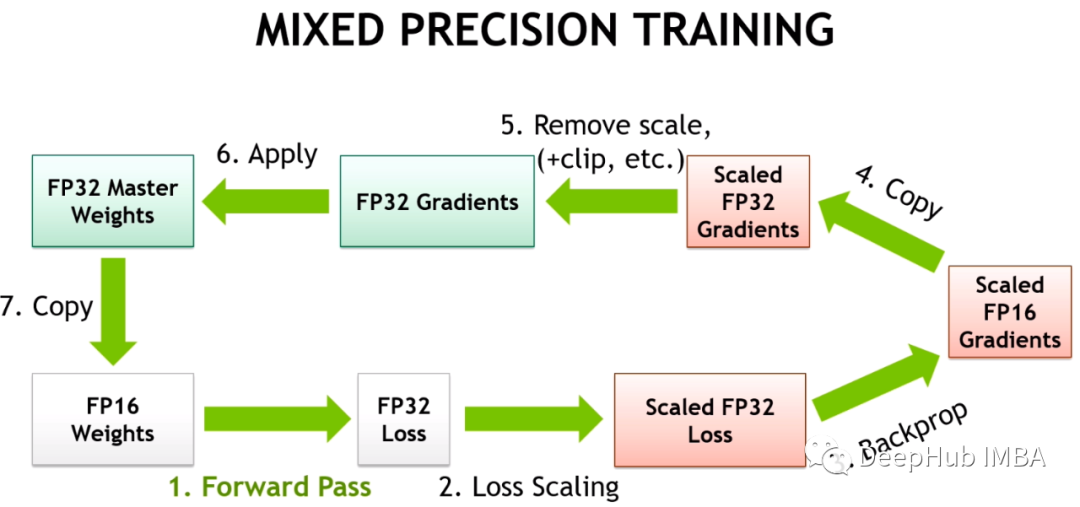

混合精度训练的核心思想是利用半精度(FP16)或更低精度的数据类型来执行计算,同时辅以单精度(FP32)来维持数值稳定性。这种做法不仅可以减少内存占用和提高运算速度,还可以通过特定硬件(例如NVIDIA的Tensor Core)实现显著的加速效果。

## 1.2 混合精度训练的优势分析

采用混合精度训练相比传统的单精度训练方式,有着以下几个明显优势:

- **提升计算效率**:半精度浮点数的运算速度和内存占用都远低于单精度浮点数。

- **减少内存占用**:可以有效降低内存使用,这对于训练超大型模型尤为重要。

- **加速训练过程**:特别是结合现代GPU的专门硬件加速技术,如Tensor Core,训练速度可以大幅提升。

实现混合精度训练时,我们需要注意的是,在训练过程中保持模型的数值稳定性和减少精度损失,这将在后续章节中详细讨论。

# 2. PyTorch中的混合精度实现

## 2.1 混合精度训练的基本概念

### 2.1.1 浮点数精度与计算效率

在深度学习训练中,浮点数精度是影响计算效率和模型表现的关键因素之一。单精度浮点数(float32)是最常用的数值表示方式,它在内存占用和计算速度方面达到了良好的平衡,同时也能够满足大多数深度学习模型的精度要求。然而,随着模型规模的扩大,对于计算资源的需求也在不断增加。为此,研究者开发了混合精度训练方法,通过结合单精度浮点数和半精度浮点数(float16),以减少内存占用并加快计算速度,从而在一定程度上缓解硬件资源的压力。

### 2.1.2 混合精度训练的优势分析

混合精度训练的优势主要体现在两个方面:内存效率和计算效率。通过使用float16,可以减少模型参数和激活值的存储需求,降低内存占用,进而使得在相同硬件资源下能够训练更大的模型。同时,支持float16的硬件通常能够提供更高的计算吞吐量,从而加快训练速度。混合精度训练还有助于改善训练过程中的数值稳定性,通过梯度缩放等技术,确保训练的收敛性。

## 2.2 PyTorch自动混合精度API使用

### 2.2.1 AMP API概述

PyTorch提供了自动混合精度(AMP)API,目的是为了简化混合精度训练的实现。AMP能够自动识别模型中可以使用float16进行运算的部分,同时保持关键计算使用float32,以确保训练的数值稳定性。AMP API支持两种模式:一种是纯脚本模式,另一种是GradScaler模式,后者能够在训练过程中自动进行梯度缩放,帮助解决混合精度训练中可能出现的梯度消失或梯度爆炸问题。

### 2.2.2 如何在PyTorch中启用AMP

启用PyTorch中的AMP非常简单,只需要导入`torch.cuda.amp`模块中的`autocast`和`GradScaler`。在训练循环中,使用`autocast`上下文管理器包围模型的前向传播和损失计算,这样就能自动将这些部分的计算使用float16执行。对于反向传播,使用`GradScaler`来缩放梯度,然后用优化器正常进行参数更新。以下是启用AMP的代码示例:

```python

import torch

from torch.cuda.amp import autocast, GradScaler

model = ... # 模型定义

optimizer = ... # 优化器定义

scaler = GradScaler()

for input, target in data:

optimizer.zero_grad(set_to_none=True)

# autocast上下文管理器确保浮点数运算使用float16

with autocast():

output = model(input)

loss = loss_fn(output, target)

# 使用梯度缩放避免数值问题

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

```

### 2.2.3 AMP的实践应用场景

混合精度训练尤其适用于大规模的深度学习模型,例如在自然语言处理(NLP)和计算机视觉(CV)领域的大型模型。这些模型通常有数十亿甚至数千亿的参数,对内存和计算资源的需求巨大。在实际应用中,开发者可以将AMP API与PyTorch的数据并行性结合,进一步提升模型的训练效率。此外,AMP也常用于在GPU集群上进行分布式训练,以缩短训练时间,提高研究和产品开发的迭代速度。

## 2.3 混合精度训练中的错误和调试

### 2.3.1 常见问题及解决方案

在混合精度训练过程中,开发者可能会遇到一系列问题,例如梯度消失或爆炸、精度损失等。这些问题通常与数值精度和数值稳定性有关。解决这些问题的常用策略包括:

- **梯度缩放**:使用GradScaler在反向传播之前放大梯度,这样可以防止在低精度下梯度消失的问题。

- **损失缩放**:在损失计算之前对损失值进行缩放,以便

0

0