【模型性能全面剖析】:PyTorch中的多角度评估方法

发布时间: 2024-12-11 12:32:52 阅读量: 11 订阅数: 12

Python_PyTorch中的深度学习人物再识别.zip

# 1. PyTorch框架简介与模型性能评估的重要性

## 1.1 PyTorch框架简介

PyTorch是一个开源机器学习库,它基于Python语言构建,广泛用于计算机视觉和自然语言处理领域。PyTorch采用动态计算图,使得构建复杂的神经网络成为可能,并且可以实现高效的梯度计算与反向传播。此外,其易用性和灵活性让它在研究人员和工业界中都颇受欢迎。

## 1.2 模型性能评估的重要性

在机器学习和深度学习项目中,准确评估模型的性能对于研究和实际应用都至关重要。良好的性能评估方法可以帮助我们了解模型的强项与弱点,并指导我们进行模型的优化。通过合理的评估,可以确保模型在未知数据上的泛化能力,提高模型在实际应用中的鲁棒性和可信度。

# 2. 理论基础 - 模型性能评估指标

模型性能评估是机器学习和深度学习研究中不可或缺的一环。它涉及到的不仅仅是一个简单的指标,而是多个指标共同作用,互相补充,形成一个全面的评估体系。本章将带您深入探讨性能评估指标,涵盖从传统机器学习到深度学习特有的性能度量,再到多标签分类和多任务学习的评估方法。

## 2.1 传统机器学习性能指标

在机器学习领域,评估一个模型的好坏通常基于其在验证集或测试集上的表现。这一部分将详细讨论几个最为常见的评估指标:准确率、精确率和召回率,以及F1分数、ROC曲线与AUC值。

### 2.1.1 准确率、精确率和召回率

准确率(Accuracy)是最为直观的评估指标,它描述了模型正确预测的样本数量占总样本数量的比例。虽然准确率简单易懂,但在数据不平衡的情况下,它可能会产生误导。这时,精确率(Precision)和召回率(Recall)成为了更加合适的评估工具。

精确率回答了“被模型预测为正类的样本中,有多少是真的正类?”的问题。而召回率则回答了“所有真的正类中,有多少被模型正确地预测出来了?”的问题。两者都是针对正类的评估指标,它们在不平衡数据集上比准确率更有解释力。

### 2.1.2 F1分数、ROC曲线与AUC值

当精确率和召回率都需要被考虑时,F1分数是一个很好的折中指标。F1分数是精确率和召回率的调和平均数,它考虑了两者的平衡,是精确率和召回率之和为常数时的最优解。

接收者操作特征曲线(ROC曲线)及其下的面积(AUC值)提供了一种评估分类器性能的手段,尤其在二分类问题中广泛应用。ROC曲线在不同的分类阈值下绘制了真正类率(True Positive Rate, TPR)与假正类率(False Positive Rate, FPR)之间的关系,而AUC值则是该曲线下的面积,提供了一个从0到1的单一度量值。AUC值越接近1,表示分类器的性能越好。

## 2.2 深度学习特有的性能指标

深度学习模型由于其强大的拟合能力,在性能评估上也拥有特殊的指标。在这一小节,我们将探讨混淆矩阵的定义与应用,以及损失函数与优化目标如何作为评估指标。

### 2.2.1 混淆矩阵及其应用

混淆矩阵(Confusion Matrix)是一个更加详细的性能评估工具,它不仅能够提供准确率和召回率的信息,还能详细展示分类器的预测结果。具体来说,混淆矩阵显示了每个类别的真正例、假正例、真负例和假负例的数目。

在多分类问题中,混淆矩阵的分析变得更加复杂,但同时也更有信息量。例如,在一个多分类模型中,混淆矩阵能够帮助我们了解模型在不同类别上的表现差异,哪些类别容易被混淆等。

### 2.2.2 损失函数与优化目标

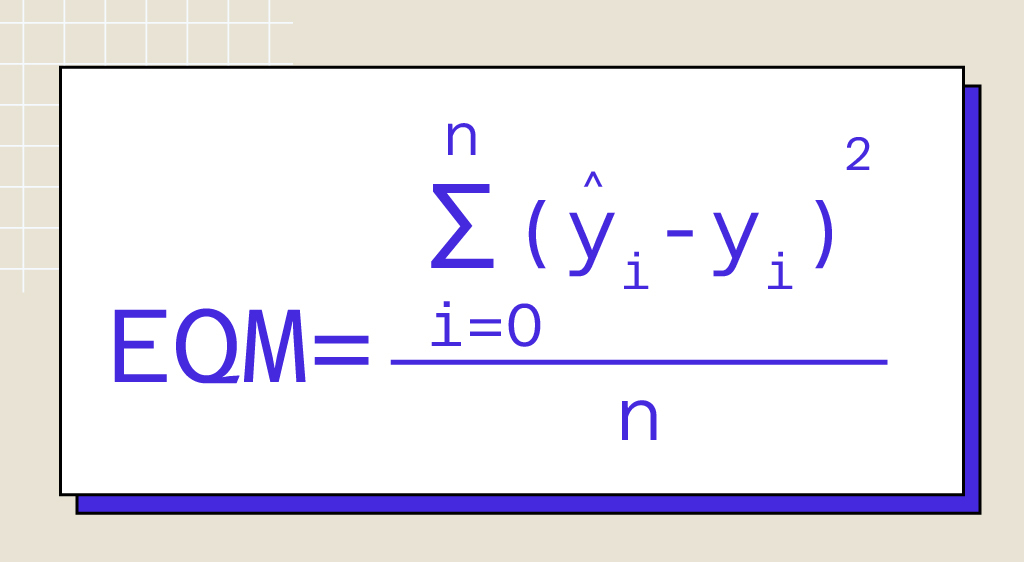

在深度学习中,损失函数是衡量模型预测值与实际值差异的函数。通过最小化损失函数,可以实现模型参数的优化。损失函数通常与优化目标直接相关,是模型训练的核心驱动力。

常见的损失函数包括均方误差(MSE)用于回归问题,交叉熵损失用于分类问题。不同的损失函数反映了模型关注的优化方向,例如,交叉熵损失对类别分布的预测误差十分敏感。

## 2.3 多标签分类与多任务学习评估

多标签分类与多任务学习是机器学习中更为复杂的场景。在这一小节中,我们将探讨这两种情况下的性能度量方法,以及如何在多任务中权衡不同任务的性能。

### 2.3.1 多标签分类的性能度量方法

在多标签分类问题中,每个样本可能属于多个类别。评估这种类型的模型时,需要考虑到每个标签的预测准确率,同时也需要评价所有标签的整体表现。

评价多标签分类的常用指标包括标签级别的准确率、精确率和召回率,以及针对整体分类效果的指标,如例子平均精确率(Example-wise Average Precision, EAP)和微平均精确率(Micro-averaged Precision)等。

### 2.3.2 多任务学习中的权衡与评估

多任务学习指的是同时在多个相关任务上训练模型。在多任务学习中,任务之间可能存在竞争和协同的关系,因此评估和优化时需要综合考虑所有任务的表现。

在多任务学习中,可以使用基于损失函数的加权策略来平衡不同任务的重要性。此外,还可以通过分析不同任务在验证集上的表现,来调整训练过程中任务的优先级。

接下来,我们将深入到第三章,实际操作章节,介绍如何在PyTorch中应用这些理论知识进行模型评估。

# 3. 实践操作 - PyTorch中评估模型的方法

在深度学习领域,理论模型的构建和算法的提出是基础,然而,如何准确地评估这些模型的性能同样至关重要。PyTorch作为一个先进的深度学习框架,为我们提供了丰富的工具和方法来进行模型评估。接下来,我们将深入探讨如何在PyTorch中实现模型的性能评估,并通过具体操作来加深理解。

## 3.1 使用PyTorch内置函数进行评估

### 3.1.1 验证集上的性能测试

在深度学习模型训练过程中,通常会将数据集划分为训练集、验证集和测试集。训练集用于模型的训练,验证集用于在训练过程中进行性能测试,以调整模型超参数,而测试集则用于最终的模型评估。使用PyTorch内置函数评估模型性能的一个常见步骤如下:

```python

import torch

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# 数据集加载与划分

transform = transforms.Compose([transforms.ToTensor()])

train_dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

test_dataset = datasets.MNIST(root='./data', train=False, transform=transform)

train_loader = DataLoader(dataset=train_dataset, batch_size=64, shuffle=True)

test_loader = DataLoader(dataset=test_dataset, batch_size=64, shuffle=False)

# 假设我们已经有了训练好的模型model

# model = ... # 训练模型的代码在这里

# 验证集上的性能测试

def evaluate_model(model, data_loader):

model.eval()

total_correct = 0

total_images = 0

for images, labels in data_loader:

with torch.no_grad(): # 不计算梯度,提高测试速度

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total_images += labels.size(0)

total_correct += (predicted == labels).sum().item()

accuracy = total_correct / total_images

return accuracy

# 在验证集上测试模型性能

validation_accuracy = evaluate_model(model, train_loader)

print(f"Model accuracy on the training set: {validation_accuracy:.2f}")

```

在上述代码中,`evaluate_model`函数通过遍历数据加载器中的所有样本,计算模型在验证集上的准确率。值得注意的是,在评估过程中,我们调用了`model.eval()`来切换模型为评估模式,这是因为在训练过程中启用了一些如Dropout和Batch Normalization的层,这些层在评估过程中应该被固定下来。

### 3.1.2 测试集上的准确率计算

测试集是模型训练完成后用于评估模型泛化能力的关键部分。在测试集上的准确率计算方法与在验证集上的方法类似,但是要确保模型没有在测试集上进行过任何训练过程中的调整。

```python

# 测试集上的性能评估

test_accuracy = evaluate_model(model, test_loader)

print(f"Model accuracy on the test set: {test_accuracy:.2f}")

```

在以上代码段中,我们使用相同的`evaluate_model`函数来评估测试集上的模型性能。由于模型在测试集上是独立的,我们能够得到关于模型在未见数据上表现的真实评估。

## 3.2 自定义评估指标与损失函数

### 3.2.1 自定义评估函数的创建

PyTorch的内置函数虽然方便,但在实际应用中,我们往往需要根据具体问题定制评估函数。例如,在图像分割任务中,我们需要计算像素级别的准确率而非整体图像的准确率。以下是如何创建一个自定义的评估函数来计算像素级别的准确率的示例:

```python

import torch.nn.functional as F

def custom_pixel_accuracy(output, target, num_classes):

_, predicted = torch.max(output, 1)

total = target.size(0) * target.size(1) * target.size(2)

correct = (predicted == target).sum().item()

pixel_accuracy = correct / total

return pixel_accuracy

# 假设output是模型输出的预测,target是真实的标签

# output, target

```

0

0