【ROC曲线与AUC值】:深度解读PyTorch中的模型性能分析

发布时间: 2024-12-11 12:04:08 阅读量: 58 订阅数: 12

毕设&课程作业_基于深度学习框架pytorch实现的中文文本分类.zip

# 1. ROC曲线与AUC值的基础理论

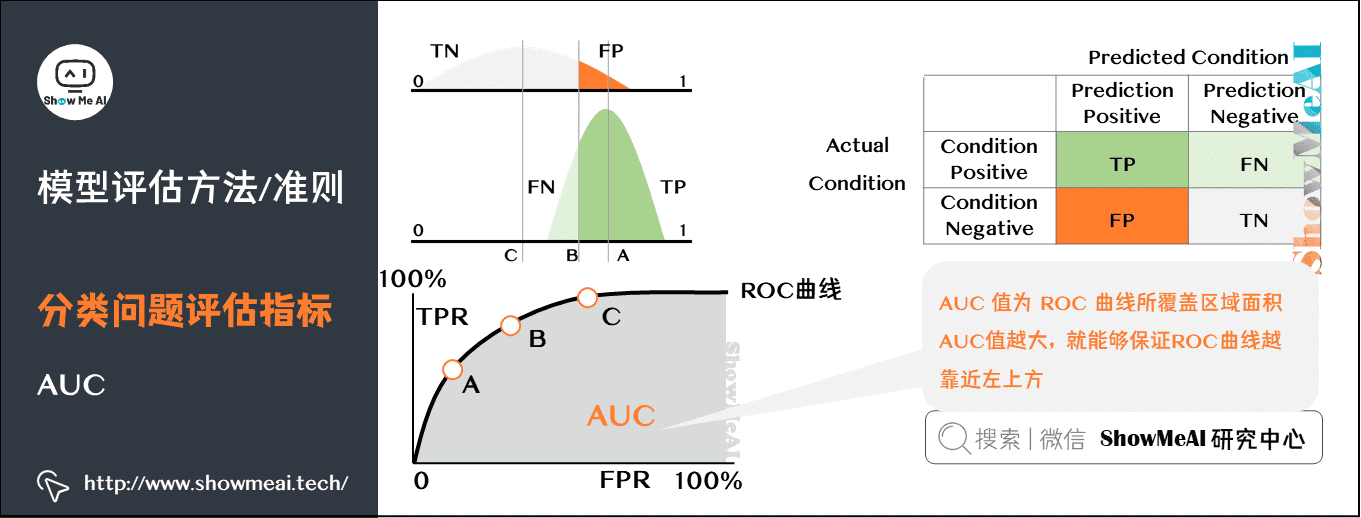

在机器学习领域,模型的评估是一个至关重要的环节,尤其在分类问题中,我们需要通过有效的指标来衡量模型的表现。ROC曲线(Receiver Operating Characteristic Curve)和AUC值(Area Under Curve)是评价分类器性能的两个重要工具,它们在处理二分类问题时尤其受到青睐。ROC曲线是一个图形化工具,展示了在不同分类阈值下,真正例率(True Positive Rate, TPR)与假正例率(False Positive Rate, FPR)之间的关系。而AUC值则是ROC曲线下的面积,用于量化模型的整体性能。

ROC曲线与AUC值不依赖于特定的阈值设定,这使得它们在面对不同分布的数据时更加稳健。尤其是在样本不平衡的情况下,传统的准确率可能不足以反映模型的实际效果,此时ROC曲线和AUC值就显得格外重要。理解这两者的计算和应用,可以有效地帮助数据科学家优化模型,提升预测性能。

在下一章节中,我们将深入探讨PyTorch中的模型评估基础,并介绍如何在实践中运用这些理论知识。

# 2. PyTorch中的模型评估基础

## 2.1 模型评估的基本概念

### 2.1.1 混淆矩阵的理解

在机器学习和深度学习中,混淆矩阵是一个评估模型性能的重要工具,尤其在分类问题中。它是一个表格,用于展示分类模型在测试集上的实际类别与预测类别的对应关系。混淆矩阵可以直观地展示模型在各个类别的分类能力,比如准确预测和错误预测的分布。

混淆矩阵的四个重要组成分别是:真正例(True Positive, TP),假正例(False Positive, FP),真负例(True Negative, TN)和假负例(False Negative, FN)。通过这些值,我们可以计算出其他一系列有用的评估指标,例如精确率、召回率、F1分数等。

```mermaid

graph TD;

A[实际类别] -->|正类| B[预测为正类];

A -->|负类| C[预测为负类];

B -->|TP| D[真正例];

B -->|FP| E[假正例];

C -->|TN| F[真负例];

C -->|FN| G[假负例];

```

### 2.1.2 精确率和召回率的平衡

精确率(Precision)和召回率(Recall)是评估模型分类性能的两个重要指标。精确率衡量的是模型预测为正例中实际为正例的比例,而召回率衡量的是所有实际为正例中模型预测对了多少。在实际应用中,这两个指标常常存在一定的权衡关系,即一个指标提高往往会导致另一个指标降低。

精确率计算公式为:`Precision = TP / (TP + FP)`

召回率计算公式为:`Recall = TP / (TP + FN)`

当我们在不同场景中,可能需要根据需求来平衡精确率和召回率。例如,医疗诊断中我们会更偏向于高召回率,即使牺牲一定的精确率,也要尽可能地减少漏诊。而在垃圾邮件过滤中,我们可能会更偏向于高精确率,以确保重要的邮件不会被错误地过滤掉。

## 2.2 PyTorch中的损失函数与评估指标

### 2.2.1 损失函数的作用和选择

损失函数是衡量模型预测值与真实值之间差异的函数,它是模型优化的直接目标。在训练神经网络时,通过最小化损失函数,我们可以使模型的预测结果尽可能地接近真实值。在二分类问题中常用的损失函数包括交叉熵损失(Cross-Entropy Loss),而在多分类问题中,多类别交叉熵损失(Multiclass Cross-Entropy Loss)或其变体是常见的选择。

选择合适的损失函数对于训练效果有着显著的影响。例如,当数据存在不平衡的情况时,可能会选择加权交叉熵损失函数(Weighted Cross-Entropy Loss)来增加少数类的权重,以便更好地优化模型。

### 2.2.2 如何在PyTorch中使用评估指标

在PyTorch中,除了损失函数外,还有其他一些评估指标用于衡量模型性能。这些指标可以通过`torchmetrics`库获得。使用这些评估指标,可以更容易地对模型在验证集和测试集上的性能进行监控和评估。

以下是一个使用PyTorch进行二分类问题性能评估的简单示例,其中使用了精确率(Precision)和召回率(Recall):

```python

import torch

from torchmetrics import Precision, Recall

# 假设y_true和y_pred分别是真实的标签和模型预测的标签

y_true = torch.tensor([0, 1, 1, 1, 0, 0, 1, 0, 0, 1])

y_pred = torch.tensor([0, 0, 1, 1, 0, 0, 1, 0, 1, 1])

# 初始化评估指标

precision = Precision(num_classes=2, average='binary', mdmc_average='global')

recall = Recall(num_classes=2, average='binary', mdmc_average='global')

# 计算评估指标

precision_score = precision(torch.where(y_pred > 0.5, 1, 0), y_true)

recall_score = recall(torch.where(y_pred > 0.5, 1, 0), y_true)

print(f'Precision: {precision_score:.4f}')

print(f'Recall: {recall_score:.4f}')

```

这段代码首先导入必要的库,并定义了真实标签和预测标签。然后初始化`Precision`和`Recall`评估指标,最后计算并打印精确率和召回率。注意`num_classes`参数需要根据问题的类别数进行设置,`average`参数确定了如何平均多类别的指标。

## 2.3 实际案例分析:二分类问题的模型评估

### 2.3.1 构建二分类模型的步骤

构建一个基本的二分类模型通常遵循以下步骤:

1. 数据准备:准备并预处理数据集,划分成训练集和测试集。

2. 模型构建:设计神经网络架构,定义模型的输入、隐藏层和输出。

3. 损失函数与优化器:选择合适的损失函数和优化器,如交叉熵损失和Adam优化器。

4. 训练过程:在训练集上迭代训练模型,不断更新模型权重。

5. 性能评估:使用测试集评估模型性能,计算损失值和各项评估指标。

6. 模型优化:基于性能评估的结果,调整模型结构或参数,进行超参数优化。

以下是一个使用PyTorch构建二分类模型的简单示例:

```python

import torch

import torch.nn as nn

from torch.utils.data import DataLoader, TensorDataset

# 生成模拟数据

X = torch.randn(100, 20) # 假设有20个特征

y = torch.randint(0, 2, (100,)) # 二分类标签

# 创建数据加载器

dataset = TensorDataset(X, y)

dataloader = DataLoader(dataset, batch_size=10, shuffle=True)

# 定义模型结构

class Model(

```

0

0