YOLOv8训练中断应对术:保证训练连续性的最佳实践

发布时间: 2024-12-11 15:01:25 阅读量: 4 订阅数: 11

# 1. YOLOv8训练中断问题概述

在机器学习和深度学习领域,YOLOv8作为一种先进的目标检测系统,已经广泛应用于图像处理和对象识别任务。然而,在训练YOLOv8模型时,经常会遇到训练中断的问题,这直接影响了模型训练的效率和准确率。训练中断问题不仅浪费资源,还会延误项目进度,因此理解和解决这些问题至关重要。

本章将概述YOLOv8训练中断的主要问题,为读者提供一个关于训练中断问题的总体认识。我们将探讨训练中断的常见表现形式,比如训练突然停止、系统崩溃或者资源耗尽等现象。同时,本章也会为读者揭示这些问题背后可能的原因,为接下来的详细诊断和故障排查工作打下基础。

为了进一步理解和解决训练中断的问题,接下来的章节将从理论基础、预防措施、故障应对以及实际案例分析等角度展开,提供深入的解决方案和优化策略。这一流程的目的是为了帮助技术人员提升YOLOv8模型训练的稳定性和可靠性,减少潜在的中断风险。

# 2. 理论基础与故障诊断

## 2.1 YOLOv8架构与训练原理

### 2.1.1 YOLOv8的基本概念

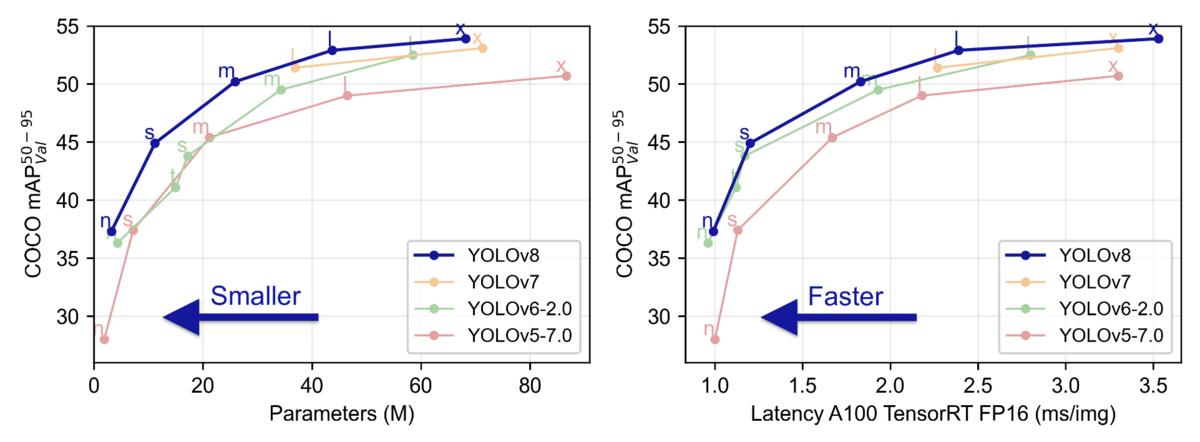

YOLOv8(You Only Look Once)是一个流行的实时对象检测系统,由Joseph Redmon等人最初开发,并在后续版本中不断改进。YOLO系列模型以其速度和准确性的平衡而著称,广泛应用于图像识别、自动驾驶、安防监控等领域。YOLOv8作为最新版本,引入了更多创新的特性来提升性能和易用性。

YOLOv8的核心思想是将对象检测任务视为一个回归问题,直接从图像像素到边界框坐标和类别概率的映射。这与传统的基于区域的方法不同,后者会首先生成一系列候选框然后再对这些候选框进行分类。YOLOv8的单阶段检测方法大大提高了检测速度。

### 2.1.2 训练过程中的关键步骤

YOLOv8的训练流程包括几个关键步骤,从数据预处理到模型的迭代优化,以下是几个主要步骤的概述:

1. 数据准备:收集并标注用于训练的数据集。标注过程需要指定每个对象的边界框和类别标签。

2. 模型选择:根据需求选择合适的YOLOv8模型架构。每个版本的YOLOv8都有特定的配置文件,包含了不同网络层的参数设置。

3. 配置训练参数:设置训练过程中的参数,如学习率、批次大小、优化器类型、损失函数等。

4. 训练执行:启动训练过程,监控训练进度,调整超参数以达到更好的性能。

5. 验证与测试:使用验证集和测试集对训练好的模型进行评估,确定其泛化能力和准确性。

## 2.2 常见训练中断原因分析

### 2.2.1 硬件资源不足

硬件资源是训练深度学习模型的基础,包括但不限于GPU计算资源、内存以及存储空间。在训练YOLOv8模型时,如果硬件资源不足以满足模型的计算需求,会导致训练过程中的中断。

例如,GPU内存不足时会引发显存溢出错误(out-of-memory, OOM),导致程序崩溃。解决此类问题通常需要增加GPU的数量,减少批次大小,或者优化模型结构以降低内存使用。

### 2.2.2 软件配置错误

软件配置错误是导致训练中断的另一个常见原因。深度学习训练需要对系统进行复杂的配置,包括环境变量的设置、依赖包的安装、版本兼容性等。

错误的配置可能会导致训练脚本无法正确执行,例如,Python环境中的包版本冲突、路径配置错误或者配置文件中参数设置不正确等。要预防这类问题,需要遵循官方文档进行系统配置,使用环境管理工具(如conda)来隔离不同的开发环境,确保软件配置的一致性和准确性。

### 2.2.3 网络或电源问题

网络和电源问题在服务器环境中也可能会导致训练中断。网络问题可能是由于网络不稳定导致的连接中断,或者由于缺少GPU驱动程序更新引起的设备兼容性问题。电源问题则包括服务器突然停电或电源不稳定导致的意外重启。

为预防网络问题,建议定期更新GPU驱动程序和确保网络连接的稳定性。对于电源问题,应使用不间断电源(UPS)或在数据中心中安排专业的电源维护。

## 2.3 故障诊断与监控工具

### 2.3.1 使用日志文件进行诊断

日志文件是故障诊断的重要工具,它们记录了程序运行时的状态信息和错误信息。通过分析日志文件,可以快速定位训练中断的原因。

在使用YOLOv8进行训练时,应开启详细的日志记录功能,记录每个epoch的训练状态、损失值变化和任何出现的异常信息。一旦训练中断,可以利用日志文件快速找到问题发生的时间点和可能的原因。

下面是一个日志文件的示例片段,并提供了分析:

```log

2023-04-01 12:00:00,000 [INFO] Starting training for 100 epochs with batch size 32.

2023-04-01 12:02:15,321 [ERROR] CUDA out of memory error detected in forward() at epoch 1, batch 10.

2023-04-01 12:02:15,322 [DEBUG] Freeing up GPU memory...

2023-04-01 12:02:15,323 [INFO] Attempting to resume training from epoch 1, batch 9.

```

从日志中可以看出,在第1个epoch的第10个batch时,程序因为显存不足而中断。根据这一信息,可以调整批次大小,再次尝试训练。

### 2.3.2 实时监控系统状态

实时监控系统状态对于预防训练中断尤为重要。可以使用各种监控工具来跟踪系统的CPU、GPU、内存使用情况以及网络状态等。这些工具能实时显示资源的使用情况,并在资源使用接近上限时提供预警。

对于YOLOv8的训练,建议使用如NVIDIA System Management Interface (nvidia-smi)和监控软件Prometheus结合Grafana来追踪GPU资源的使用情况。同时,可以编写脚本来定期检查GPU显存占用,并在显存占用达到预设阈值时进行报警。

```shell

watch -n 1 "nvidia-smi --query-gpu=memory.free,memory.used --format=csv,nounits,noheader"

```

该命令每秒检查一次GPU的内存使用情况,并输出可用内存和已使用内存,方便监控和预警。

在本章节中,我们介绍了YOLOv8的基本概念,训练过程中的关键步骤,分析了导致训练中断的常见原因,并探讨了使用日志文件进行故障诊断和实时监控系统状态的方法。通过这些知识,可以更好地理解YOLOv8训练中断的根源,并采取适当的措施预防和应对。在下一章节中,我们将深入探讨如何通过优化系统环境配置、调整YOLOv8训练参数以及建立备份恢复机制来提高训练过程的稳定性和可靠性。

# 3. 预防措施与稳定性提升

## 3.1 系统环境的优化配置

### 3.1.1 硬件资源的合理分配

在深度学习和计算机视觉任务中,YOLOv8模型对硬件资源的要求较高。合理分配硬件资源不仅可以提升训练效率,而且能有效预防因资源不足导致的训练中断问题。对于GPU资源的配置,确保有足够的显存来处理大型模型和批量数据。通常,通过显存占用监控工具定期检查显存使用情况,并根据模型实际需求灵活调整GPU数量或显存分配策略。

**代码块展示和分析:**

```bash

# 使用NVIDIA的nvidia-smi工具来监控显存占用情况

nvidia-smi --query-gpu=memory.used,memory.free --format=csv

```

**逻辑分析和参数说明:**

上述命令会输出当前系统中所有NVIDIA GPU的显存使用情况和剩余显存。`--query-gpu`指定了需要查询的GPU属性,这里设置为`memory.used`(已用显存)和`memory.free`(剩余显存)。参数`--format=csv`表示输出格式为CSV,方便后续使用脚本解析或在表格中展示。

### 3.1.2 操作系统的性能调优

操作系统性能的优化也是预防训练中断的关键措施之一。通过调整操作系统的调度策略、内存管理机制等,可确保YOLOv8训练在稳定、高效的系统环境下运行。例如,Linux系统中可以通过调整内核参数来优化IO调度策略,减少磁盘

0

0