新闻爬虫:实时监测行业动态,把握先机

发布时间: 2024-06-19 12:50:58 阅读量: 79 订阅数: 33

# 1. 新闻爬虫概述

新闻爬虫是一种专门用于从新闻网站和其他在线来源收集新闻数据的软件程序。它在信息收集、舆情监测和数据分析等领域有着广泛的应用。

新闻爬虫的工作原理是通过模拟浏览器的行为,向新闻网站发送请求,获取新闻网页的HTML代码,然后从中提取和解析新闻内容。为了有效地抓取新闻数据,新闻爬虫需要具备以下核心功能:

- **网络爬虫:**负责发送请求、获取网页内容,并根据预定义的规则进行页面解析。

- **新闻内容提取器:**从网页中识别和提取新闻标题、正文、作者、发布时间等关键信息。

- **数据存储和管理:**将提取的新闻数据存储到数据库或其他存储介质中,并提供查询和检索功能。

# 2. 新闻爬虫的理论基础

### 2.1 网络爬虫的基本原理

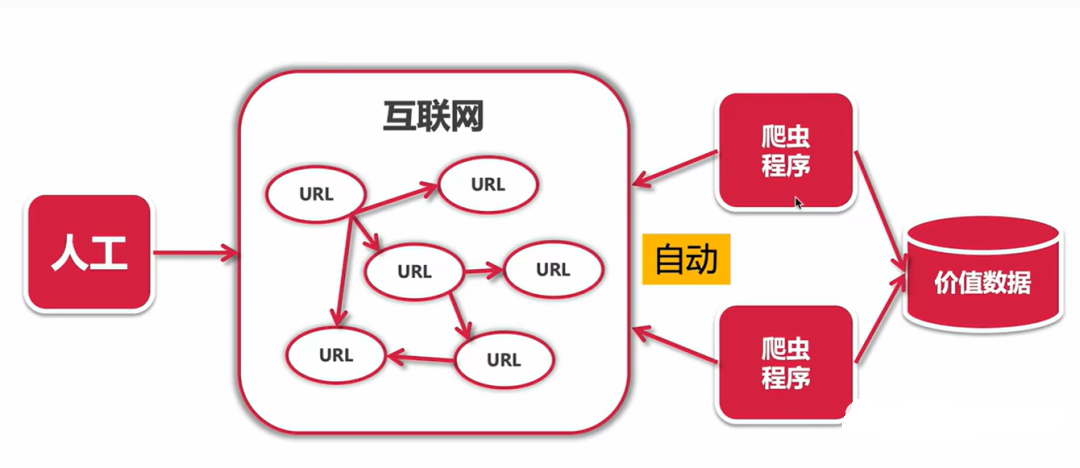

#### 2.1.1 爬虫的架构和工作流程

网络爬虫是一种自动化程序,用于从互联网上抓取和提取信息。其架构通常包括以下组件:

- **调度器:**负责管理爬取队列,确定要抓取的 URL。

- **下载器:**负责下载指定 URL 的网页内容。

- **解析器:**负责解析下载的网页内容,提取所需信息。

- **存储器:**负责存储提取的信息。

爬虫的工作流程如下:

1. 调度器从队列中获取一个 URL。

2. 下载器下载该 URL 的网页内容。

3. 解析器解析网页内容,提取所需信息。

4. 存储器存储提取的信息。

5. 调度器将新的 URL 添加到队列中,重复步骤 1-4。

#### 2.1.2 爬虫的算法和策略

爬虫算法决定了爬虫如何选择和抓取 URL。常见算法包括:

- **广度优先搜索 (BFS):**从种子 URL 开始,逐层抓取所有链接。

- **深度优先搜索 (DFS):**从种子 URL 开始,沿着一条路径深入抓取,直到无法继续为止。

- **优先级队列:**根据 URL 的重要性或其他指标对 URL 进行排序,优先抓取重要的 URL。

爬虫策略用于优化爬虫的效率和有效性。常见策略包括:

- **限制爬取频率:**避免给网站服务器造成过大负载。

- **处理重复 URL:**避免重复抓取同一 URL。

- **使用代理:**绕过网站的访问限制。

### 2.2 新闻网站的结构分析

#### 2.2.1 新闻网站的常见结构

新闻网站通常具有以下常见的结构:

| 特征 | 描述 |

|---|---|

| 首页 | 列出最新新闻和热门新闻。 |

| 新闻类别 | 按类别组织新闻,如政治、经济、科技等。 |

| 新闻详情页 | 提供特定新闻的详细信息,包括标题、内容、作者、时间等。 |

| 搜索功能 | 允许用户搜索特定新闻或关键字。 |

| 评论区 | 允许用户对新闻发表评论。 |

#### 2.2.2 新闻内容的提取规则

提取新闻内容需要定义规则来识别和提取所需信息。常见规则包括:

- **标题:**通常使用 `<h1>` 或 `<h2>` 标签。

- **内容:**通常使用 `<p>` 或 `<div>` 标签,并包含新闻正文。

- **作者:**通常使用 `<meta>` 标签或 `<author>` 标签。

- **时间:**通常使用 `<meta>` 标签或 `<time>` 标签。

**代码块:**

```python

import scrapy

class NewsSpider(scrapy.Spider):

name = "news_spider"

allowed_domains = ["example.com"]

start_urls = ["https://example.com/news"]

def parse(self, response):

# 提取新闻标题

titles = response.css("h1::text").extract()

# 提取新闻内容

contents = response.css("div.news-content::text").extract()

```

0

0