【DistCp性能优化大师】:大数据迁移效率提升200%的秘诀

发布时间: 2024-10-29 09:10:16 阅读量: 59 订阅数: 40

混合云大数据迁移实践.pptx

# 1. DistCp工具简介与大数据迁移挑战

在大数据处理的领域中,数据迁移是一个经常面临的挑战,而DistCp(Distributed Copy)作为Hadoop生态系统中的一个实用工具,其在处理大规模数据复制和迁移任务中扮演着重要角色。本章旨在简要介绍DistCp工具的基本功能,并探讨在大数据迁移过程中可能遇到的挑战。

首先,了解DistCp工具是任何需要在Hadoop集群间迁移数据的专业人士的基础。DistCp的基本思想是将一个大数据集分割成若干个小的数据块,然后并行地在多个MapReduce任务中复制这些数据块。这种方式大大提高了数据迁移的效率,尤其是在处理PB级别数据时,显得尤为重要。

然而,在实际操作中,使用DistCp进行大数据迁移也面临诸多挑战。例如,集群的带宽限制、源和目标集群之间的硬件配置差异、数据一致性保持、以及容错机制等都是必须考虑的因素。此外,随着数据量的不断增长,如何有效地进行数据管理和迁移,以便于分析和存储,也是一个持续的挑战。

在接下来的章节中,我们将深入探讨DistCp的性能优化理论基础、实用技巧,以及高级优化策略,并通过案例分析展示如何在实际场景中应用这些策略以解决具体问题。同时,我们还将关注未来大数据技术的发展趋势,以及DistCp如何适应这些变化并实现进一步的演进。

# 2. DistCp性能优化理论基础

在对大数据环境下的数据迁移有了初步了解之后,深入探讨DistCp工具的性能优化理论基础变得至关重要。本章将详细介绍分布式计算的基本原理、性能优化理论模型,以及DistCp工具的工作机制,为后续的实战优化技巧打下坚实的理论基础。

## 2.1 分布式计算原理

分布式计算是大数据处理的核心技术之一,它涉及到数据的分布、存储和处理方式。理解这些基本原理,对于设计和优化数据迁移方案至关重要。

### 2.1.1 分布式数据处理概念

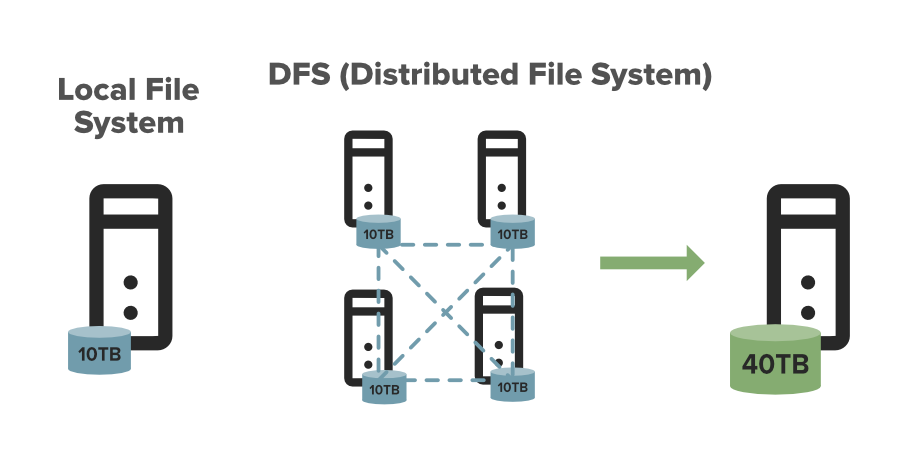

分布式数据处理是将大规模数据集分散存储在多台机器上,并且通过分布式算法并行处理这些数据。与传统的集中式处理方式不同,分布式数据处理强调的是将任务拆分并且在多节点上协同工作。这种方法特别适合于处理PB级别的数据,因为它能利用大量廉价的硬件设备,实现高吞吐量的数据处理。

### 2.1.2 Hadoop分布式文件系统(HDFS)原理

HDFS是支持Hadoop分布式计算框架的数据存储层,为处理大数据提供了一个可靠、可扩展且容错的文件系统。HDFS的核心思想是将文件切分成多个块(block),默认块大小为128MB(可配置),然后将这些块复制并分布到不同的数据节点(DataNode)上。这样,即使某些节点发生故障,HDFS也可以通过备份机制快速恢复数据。

核心组件包括:

- **NameNode**:管理文件系统的命名空间,记录文件系统树及整个文件系统的所有文件和目录。这个节点并不存储实际的数据。

- **DataNode**:在本地文件系统存储数据块的节点,负责处理文件系统客户端的读写请求。

- **Secondary NameNode**:定期合并编辑日志与文件系统状态,帮助NameNode减轻重载。

理解HDFS原理对于优化DistCp性能至关重要,因为DistCp本质上就是通过Hadoop的MapReduce框架,利用HDFS进行大规模数据复制的一个工具。

## 2.2 性能优化的理论模型

在深入实践之前,了解性能优化的理论模型能够帮助我们更有针对性地进行调优。

### 2.2.1 瓶颈分析与识别

在优化过程中,首先需要识别出系统的瓶颈所在。瓶颈可以是CPU资源不足、磁盘I/O慢、网络带宽限制等。通过使用系统监控工具来分析CPU、内存、磁盘和网络的性能指标,我们可以找到影响整体性能的关键因素。

### 2.2.2 性能优化的基本原则

性能优化通常遵循以下原则:

- **最小化资源竞争**:确保系统资源不会成为处理瓶颈。

- **并行化处理**:在可能的情况下,并行执行任务以提高效率。

- **减少不必要的数据移动**:数据移动的成本很高,应当尽量减少数据在网络中的传输。

- **优化I/O操作**:针对磁盘I/O进行优化,比如合并小文件和减少随机写入。

遵循这些原则能帮助我们系统地分析和优化DistCp性能。

## 2.3 DistCp的工作机制

DistCp是分布式复制(Distributed Copy)的简称,是一个在Hadoop平台上执行大规模数据复制的工具。它使用MapReduce来并行处理数据。

### 2.3.1 DistCp的基本流程

DistCp的基本工作流程如下:

1. 将目标文件或目录的列表分成多个数据块。

2. 为每个数据块启动一个Map任务,这些任务并行运行。

3. 每个Map任务负责将源路径中的数据块复制到目标路径中。

4. 在复制完成后,MapReduce框架会进行清理工作。

### 2.3.2 DistCp的参数解析

在使用DistCp时,可以通过命令行参数对其进行配置。以下是一些关键参数的介绍:

- `-p`:复制过程中保持文件权限和时间戳。

- `-update`:仅复制那些源目录比目标目录新的文件。

- `-skipCRC`:跳过CRC校验,加快复制过程,但可能会有数据完整性风险。

- `-m`:设置并行度,即同时运行的Map任务数。

- `-log`:指定日志文件路径,用于记录任务执行的详细信息。

通过合理配置这些参数,可以在保证数据迁移效率的同时,确保数据的完整性和一致性。

通过以上章节的介绍,我们对DistCp工具有了更深入的理解,这将为我们后续章节中介绍的性能优化技巧提供理论支撑。

# 3. DistCp性能优化实战技巧

在大数据处理和迁移过程中,性能优化是确保项目成功的关键因素之一。Apache DistCp(Distributed Copy)是Hadoop生态系统中用于在Hadoop文件系统(HDFS)和其他分布式存储系统之间高效复制数据的工具。在本章中,我们将深入了解如何通过实战技巧对DistCp进行性能优化。

## 3.1 资源配置的优化

资源的合理配置是性能优化的首要步骤。对于任何分布式计算任务来说,CPU、内存和网络带宽的合理配置能够显著影响任务的执行效率。

### 3.1.1 CPU资源的合理分配

合理的CPU资源分配对于提高任务并行度和减少不必要的上下文切换至关重要。在使用DistCp进行数据迁移时,可以采取以下步骤优化CPU资源的分配:

1. **资源预留**:使用YARN(Yet Another Resource Negotiator)等资源管理器预留CPU资源,确保数据迁移任务有足够的计算能力。

2. **任务优先级调整**:根据数据迁移的紧急程度调整任务优先级,避免与高优先级任务发生资源争抢。

3. **CPU亲和性设置**:合理设置CPU亲和性,减少任务在不同CPU核心间的迁移,提升执行效率。

### 3.1.2 内存和网络带宽的调整

内存和网络带宽是影响数据传输速率的关键因素。针对内存使用,应当:

1. **内存预分配**:根据任务需求预先为DistCp作业分配足够的内存,防止内存溢出导致任务失败。

2. **堆外内存配置**

0

0