【distcp高级应用】:掌握overwrite参数,优化大数据迁移与备份流程

发布时间: 2024-10-29 13:17:04 阅读量: 30 订阅数: 33

# 1. distcp工具概述与基础应用

## 1.1 distcp简介

distcp(Distributed Copy)是Hadoop生态圈中的一个工具,专门用于高效地在Hadoop文件系统(HDFS)或其他支持Hadoop API的文件系统之间复制大量数据。它可以并行地复制数据,从而显著提高数据传输的效率。distcp支持多种存储系统,包括但不限于HDFS、Amazon S3、Azure Blob存储、Google Cloud Storage等。

## 1.2 基础应用

对于新用户来说,使用distcp的基本流程包括定义源路径和目标路径,指定要复制的文件或目录,然后执行命令。例如:

```bash

hadoop distcp /path/to/source /path/to/destination

```

这个命令会将`source`路径下的内容复制到`destination`路径。在此过程中,distcp会自动创建目标路径并保留文件的权限和时间戳信息。对于初学者来说,先从这个基础用法开始实践是非常有益的。随着对工具的进一步了解,用户可以根据需要定制更复杂的迁移任务。

# 2. 掌握distcp的overwrite参数

数据迁移是IT运维工作中不可或缺的一部分。在使用distcp进行数据迁移时,常常涉及到数据的覆盖问题,而overwrite参数在这种情况下起到了关键性的作用。本章将深入探讨overwrite参数的作用、配置以及在保证数据完整性方面的重要性。

## 2.1 overwrite参数的作用与影响

### 2.1.1 overwrite参数的定义

在使用distcp工具时,overwrite参数用于控制是否覆盖目标目录中已存在的文件。当设置为true时,distcp会将源目录中所有的文件复制到目标目录,即使目标目录中已有同名文件。若设置为false,则跳过这些文件,不进行覆盖操作。

### 2.1.2 overwrite参数在数据一致性中的角色

数据一致性是指数据在复制过程中的完整性保持不变。在数据迁移时,使用overwrite参数可以确保目标目录中的数据与源目录完全一致。当进行跨环境的数据迁移时,overwrite参数提供了一种简单有效的方式来同步数据,确保目标环境中的文件状态反映了源环境的最新状态。

## 2.2 overwrite参数的高级配置

### 2.2.1 配置项的详细解读

对于overwrite参数,除了直接设置true或false之外,还可以通过配置不同的参数来实现更加复杂的数据同步需求。例如,可以通过添加过滤条件来指定覆盖特定条件下的文件,或者在脚本中通过编程逻辑来动态决定是否覆盖某个文件。

### 2.2.2 实例演练:配置overwrite参数以优化数据覆盖

接下来,我们将通过一个实例来演示如何配置overwrite参数。假设我们正在从开发环境向测试环境迁移数据,我们希望只有在源文件比目标文件更新时才进行覆盖操作。

```bash

hadoop distcp -overwrite -update \

hdfs://namenode1/data/dev \

hdfs://namenode2/data/test

```

上述命令中的`-update`选项确保了只有在目标文件不存在或者目标文件比源文件旧时,才会被覆盖。这有效地防止了数据的意外丢失,同时减少了不必要的数据传输,优化了数据迁移过程。

## 2.3 overwrite参数与数据完整性

### 2.3.1 数据完整性的重要性

数据完整性是指数据在存储、处理和传输过程中的准确性和一致性。在数据迁移场景下,保持数据完整性是至关重要的,因为它直接关系到迁移后数据的可用性和可靠性。确保数据完整性可以避免诸如数据丢失、数据损坏或数据不一致等问题。

### 2.3.2 如何使用overwrite参数保证数据完整性

要利用overwrite参数来保证数据的完整性,首先需要了解当前的数据状态和迁移的目标。然后,在进行数据迁移前,应当进行数据校验,确认文件的完整性和一致性。在distcp命令中,使用`-m`参数指定MapReduce作业的数量,以并行处理数据同步,从而加速数据完整性验证。

```bash

hadoop distcp -m 100 \

-overwrite -update \

hdfs://namenode1/data/dev \

hdfs://namenode2/data/test

```

上述命令示例中,`-m 100`指定了使用100个MapReduce任务来并行迁移数据,加快了数据同步的速度。在数据同步结束后,还需要进行校验步骤,确保所有文件都被正确同步。这样的操作可以最大限度地减少因数据覆盖导致的数据完整性问题。

在下一章节中,我们将深入探讨distcp在大数据环境下的应用,包括其工作原理以及如何在避免数据丢失的同时进行高效的大数据迁移。

# 3. 大数据迁移中的distcp应用

在大数据时代背景下,数据迁移已成为企业IT日常操作的一部分。使用distcp进行大规模数据迁移是企业必须掌握的技能之一。本章深入探讨distcp在大数据迁移中的应用,包括其工作原理、避免数据丢失与错误覆盖的策略、以及不同存储系统间的数据迁移案例。

## 3.1 distcp在大数据环境下的工作原理

### 3.1.1 Hadoop分布式文件系统的特性

Hadoop Distributed File System(HDFS)是一个高度容错性的系统,旨在部署在廉价硬件上,为大数据应用提供高吞吐量的数据访问。HDFS的设计与实现受到了一些关键原则的驱动:

- **硬件失效假设:** HDFS假设其所在的硬件环境并不完美,存在较高的硬件故障率。因此,它通过数据的冗余存储来提高数据的可靠性。

- **流式数据访问:** HDFS旨在支持高吞吐量的数据访问,非常适合于大规模数据集的应用程序。这使得HDFS适合于批处理而不是用户交互式服务。

- **大文件:** HDFS适合存储大文件,支持的文件大小可以达到GB、TB甚至PB级别。

- **简单的一致性模型:** HDFS提供了强一致性模型,一旦文件被创建、写入和关闭,它就可以被读取,并且所有的更改都会立即对后续读取可见。

### 3.1.2 distcp如何高效地迁移大数据

distcp(分布式复制)工具使用MapReduce作业来执行分布式复制任务,它可以在两个HDFS集群之间复制数据,或者在同一个集群的不同目录间复制数据。以下是distcp迁移大数据的几个关键点:

- **并行处理:** 使用MapReduce的并行处理能力,distcp可以同时在多个节点上运行多个数据复制任务,大大加快了数据的迁移速度。

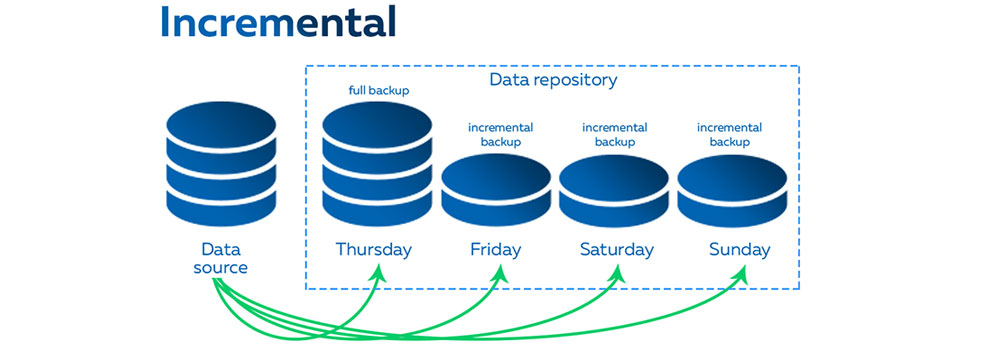

- **增量复制:** distcp可以检测源和目标路径之间的差异,并只复制变化的数据。这使得它非常适合执行定期的数据备份任务。

- **容错处理:** 如果在复制过程中某个任务失败,MapReduce会自动重新调度失败的任务,从而保证数据迁移的可靠性。

- **监控和日志:** distcp通过Hadoop的监控和日志系统,提供了详细的执行报告,方便用户监控迁移进程和在出现问题时进行故障排查。

## 3.2 避免数据丢失与错误覆盖的策略

### 3.2.1 实现数据版本控制的技巧

数据版本控制是避免数据丢失的重要策略之一。在使用distcp进行数据迁移时,以下技巧可以帮助实现有效的数据版本控制:

- **命名约定:** 在文件或目录名称中加入时间戳或版本号,以便于区分不同版本的数据。

- **使用HDFS快照:** 利用HDFS的快照功能可以创建数据集的静态视图,从而在不影响正在读写的主数据的情况下,进行数据备份和恢复。

- **操作审计:** 记录每次数据迁移的详细日志,并结合版本控制信息建立审计跟踪,以便在需要时回溯数据版本。

### 3.2.2 实例解析:错误覆盖的预防与恢复机制

在数据迁移过程中,错误覆盖是需要特别注意的问题,下面是一个关于如何预防和处理错误覆盖的实例:

假设我们正在将一个大数据集从HDFS的一个目录迁移到另一个目录。在执行distcp命令之前,首先需要检查目标目录中是否已有相同名称的数据。如果存在,可以通过下面的方式防止覆盖:

```shell

hadoop distcp -update -overwrite /path/to/source /path/to/destination

```

如果确实发生了错误覆盖,那么我们可以利用HDFS的快照功能进行数据恢复。通过以下命令创建快照:

```shell

hdfs dfs -createSnapshot /path/to/destination snapshot_name

```

一旦确认数据被错误覆盖,可以通过快照恢复到正确的版本:

```shell

hdfs dfs -renameSnapshot /path/to/destination snapshot_name old_snapshot_name

hdfs dfs -cp /path/to/destination/. /path/to/destination/

```

在表格形式下,我们可以详细记录预防和处理错误覆盖的步骤和注意事项:

| 步骤 | 预防措施 | 错误处理 | 备注 |

| --- | --- | --- | --- |

| 检查目标目录 | 使用HDFS命令检查目标目录中数据 | 若数据覆盖,立即停止操作 | 避免手动操作,减少人为错误 |

| 使用快照 | 利用快照创建数据的备份视图 | 快照可用作恢复点 | 需要在HDFS配置启用快照 |

| 数据备份 | 定期执行数据备份 | 若发生错误覆盖,可从备份恢复

0

0