【避免数据灾难】:distcp工具在企业级应用中的最佳实践

发布时间: 2024-10-29 13:00:41 阅读量: 21 订阅数: 33

ia-desastres:在FIB的AI科目中实践灾难

# 1. distcp工具概述与企业级需求

## 1.1 工具的定义与重要性

distcp(分布式复制)是Hadoop生态系统中的一个重要工具,用于在Hadoop分布式文件系统(HDFS)中高效地传输大量数据。随着企业数据量的指数级增长,传统的数据同步和备份方法已无法满足快速、可靠、安全的企业级需求。distcp提供了一种高性能、可扩展的解决方案,以适应现代数据处理的要求。

## 1.2 企业级数据同步需求

对于需要高可靠性和一致性的企业数据环境,数据同步的挑战在于如何确保数据在不同的环境或集群中保持实时或近实时的同步。企业往往寻求一种能够在保证一致性的同时,尽量减少对现有系统性能影响的方法。distcp作为一种成熟的分布式数据复制工具,能够满足这些严格的要求。

## 1.3 工具与企业需求的关联

随着数据仓库和大数据应用的普及,对数据的实时处理和分析要求也越来越高。distcp通过在多个Hadoop集群之间提供快速、安全的数据复制,使得企业能够有效地进行数据备份、迁移和灾难恢复等操作。这一工具的使用,不仅提升了数据处理的效率,而且增强了整个数据管理生命周期的安全性和可靠性。

# 2. 理解distcp的工作机制

随着企业数据量的增长,有效地管理和复制数据成为大数据环境中的关键任务。distcp,作为一个分布式复制工具,被广泛应用于数据的迁移、备份和恢复等多个场景中。为了深入理解其工作机制,本章将从基本原理、数据同步策略、性能优化三个方面展开讨论。

## 2.1 distcp基本原理与功能介绍

### 2.1.1 分布式复制工具的定义

distcp(Distributed Copy)是一个基于MapReduce框架的工具,专为Hadoop环境设计,用于高效地在Hadoop文件系统(如HDFS)之间或HDFS与本地文件系统间复制大数据集。该工具采用了MapReduce的并行处理机制,能够将大文件分割成小块并使用多个Mapper任务同时进行数据的复制工作。与普通的文件复制命令相比,distcp能够利用整个集群的计算资源,从而显著提升数据复制的效率。

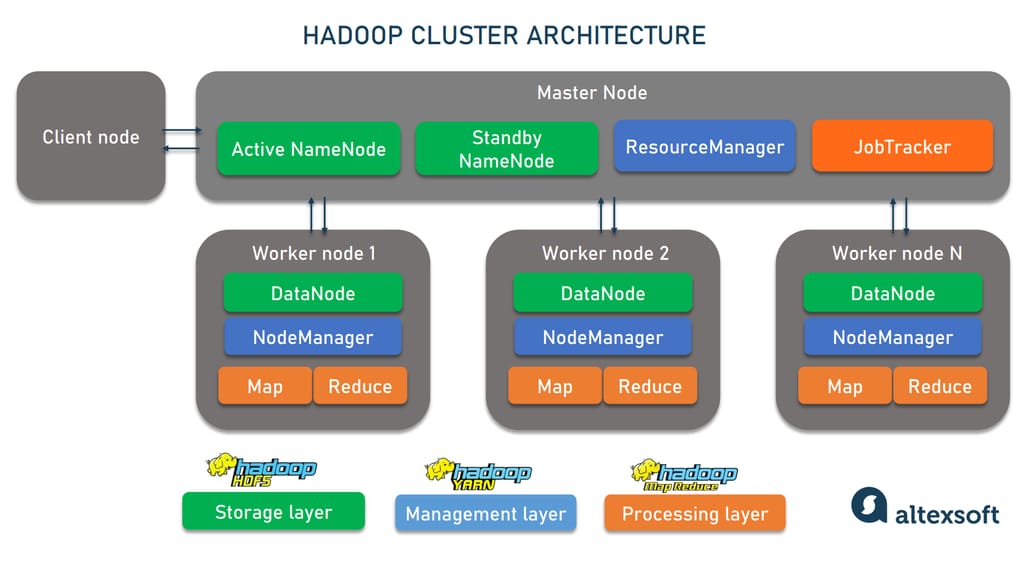

### 2.1.2 Hadoop生态中的角色与作用

在Hadoop生态系统中,distcp担当着重要角色。它是数据管理和优化的关键组件,支持跨不同Hadoop集群进行大规模数据迁移。此外,它还能用于数据备份、数据同步等多种场景。通过使用distcp,管理员可以更方便地对集群进行扩展、数据迁移、负载均衡等工作,有效提高了Hadoop集群的运维效率。

## 2.2 distcp的数据同步策略

### 2.2.1 完全数据复制与增量复制对比

distcp支持两种数据复制策略:完全复制和增量复制。完全复制是将源目录下的所有文件和数据都复制到目标目录,不考虑数据是否已存在;增量复制则仅复制那些自上次复制以来发生变化的文件和数据,大大节省了存储空间和传输带宽。

在选择复制策略时,需要考虑数据的更新频率、数据大小、网络带宽等因素。例如,如果源数据经常发生变化,则完全复制更为简单高效。而在源数据相对稳定的情况下,增量复制则能显著减少不必要的数据传输。

### 2.2.2 数据一致性保证机制

保证数据的一致性是数据复制过程中的一个关键点。distcp采用了原子操作的机制,确保复制过程要么完全成功,要么完全失败。在复制过程中,distcp通过记录每个文件的状态和校验和来保证复制的准确性和完整性。此外,针对增量复制,distcp支持一些高级选项,如排除指定文件或目录,从而进一步确保数据同步的精确性。

## 2.3 distcp的性能优化

### 2.3.1 网络与资源的优化配置

为了进一步提升distcp的工作效率,需要对网络和集群资源进行优化配置。优化措施包括合理分配带宽、优先级和队列管理等。通过适当调整这些参数,可以在不影响集群正常作业的情况下,提升数据复制的效率。

### 2.3.2 节点故障处理与作业调度

在大数据集群中,节点故障是不可避免的。distcp作业调度机制支持容错处理,一旦检测到节点故障,它可以自动调度其他节点完成复制任务。此外,合理规划作业的并发度和内存使用,避免因为资源争抢导致的性能瓶颈,也是提升整体性能的重要策略。

通过以上章节内容的介绍,我们可以看到distcp在数据复制领域具有强大的功能和灵活性。在下一章节,我们将深入探讨distcp的配置与部署,这将帮助读者更有效地利用distcp来解决实际的数据管理挑战。

# 3. distcp工具的配置与部署

## 3.1 配置distcp作业参数

### 3.1.1 核心参数解析

在使用distcp时,正确配置作业参数至关重要,它直接关系到数据复制的效率和成功率。以下是distcp的核心参数解析:

- `src`: 指定数据源路径,这是被复制的目录。

- `dest`: 指定目标路径,复制到的目录。

- `-m`: 指定运行distcp的MapReduce作业的最大数量,这影响到作业的并发性和资源利用。

配置示例:

```sh

hadoop distcp -m 10 /path/to/source /path/to/destination

```

解释:此示例中,`-m 10` 指定了使用10个Map任务来并行执行复制,适用于较大规模的数据迁移。

### 3.1.2 高级参数应用与案例

除了核心参数外,distcp还提供了一系列高级参数来处理复杂的复制场景:

- `--update`: 仅复制修改过的文件。

- `--overwrite`: 强制覆盖目标路径中的文件。

- `--filter`: 通过正则表达式排除不需要复制的文件或目录。

高级参数配置案例:

```sh

hadoop distcp --update --overwrite --filter ".*\.tmp$" /path/to/source /path/to/destination

```

解释:这个命令指定了更新已存在的文件,强制覆盖目标路径中的文件,并且忽略所有的临时文件(以.tmp结尾的文件)。

## 3.2 部署distcp环境

### 3.2.1 Hadoop集群的搭建与配置

部署distcp前,首先需要一个运行良好的Hadoop集群。以下是Hadoop集群搭建和配置的基本步骤:

1. **安装Hadoop**: 在所有节点上下载并解压Hadoop安装包。

2. **配置环境变量**: 设置HADOOP_HOME和PATH环境变量,以方便从任何位置执行Hadoop命令。

3. **配置Hadoop**: 编辑conf目录下的配置文件,如`core-site.xml`、`hdfs-site.xml`、`mapred-site.xml`和`yarn-site.xml`。

4. **启动集群**: 使用`start-dfs.sh`和`start-yarn.sh`脚本启动Hadoop集群。

### 3.2.2 distcp服务的安装与测试

安装distcp服务实际上是将Hadoop安装并配置成功后,distcp作为Hadoop的一个组件即可使用。

1. **验证安装**: 确认Hadoop集群的NameNode和DataNode服务运行正常。

2. **测试distcp**: 使用简单的distcp命令,如:

```sh

hadoop distcp /tmp/test /user/hadoop/test

```

3. **监控作业**: 查看Hadoop Web UI以监控复制作业的状态。

##

0

0