【数据仓库构建】:如何利用distcp避免文件覆盖问题

发布时间: 2024-10-29 12:47:51 阅读量: 27 订阅数: 25

# 1. 数据仓库构建概述

构建一个高效、可扩展的数据仓库是任何数据密集型企业的重要组成部分。为了应对不断增长的数据量和日益复杂的数据分析需求,数据仓库的构建需要考虑到数据的整合、存储、处理和访问。本章节将概述数据仓库的基本概念,包括它的核心组件、设计原则以及在构建过程中需要解决的关键问题。

## 1.1 数据仓库的核心组件

数据仓库通常包含以下几个核心组件:

- 数据源:原始数据的收集点,可以是各种类型的数据系统。

- ETL(提取、转换、加载)流程:数据的处理环节,负责清洗和转换数据到统一格式。

- 数据存储:用于存储处理后的数据,可以是关系型数据库、NoSQL数据库或其他数据存储方案。

- 数据访问层:为用户提供数据访问的接口,支持多样的查询和报表生成。

## 1.2 数据仓库设计原则

构建数据仓库时应遵循以下设计原则:

- **数据一致性**:确保数据仓库中的数据是准确和一致的。

- **可扩展性**:数据仓库应能适应数据量增长和用户需求变化。

- **灵活性**:设计应能够适应业务和技术的快速发展和变化。

- **性能优化**:为查询和报表提供最优的数据访问速度。

通过遵循这些原则,数据仓库可以更有效地支持决策制定过程和满足业务分析需求。接下来的章节将进一步探讨在实际操作中如何应对构建数据仓库时可能遇到的问题,特别是文件覆盖问题的避免和处理。

# 2. distcp技术简介

### 2.1 数据复制的基本概念

#### 2.1.1 数据复制的目的和重要性

数据复制是一种技术手段,旨在创建和维护数据的多个副本,以提高数据的可靠性和可用性。在一个分布式系统中,数据可能存储在多个地理位置,从而必须保证在不同位置的数据一致性。复制可以减少数据丢失的风险,同时在数据访问量增加时提供负载均衡和高可用性。对于数据仓库构建而言,数据复制不仅关系到数据的完整性,还涉及到数据的实时性和准确性,对于支持数据分析和决策具有不可或缺的作用。

#### 2.1.2 常见的数据复制工具对比

常见的数据复制工具有多种,比如 rsync, lsyncd, BorgBackup, 还有 Hadoop 生态系统中的 distcp。rsync 是基于文件差异进行传输的,效率较高,但不适用于大规模分布式系统。lsyncd 则是利用 inotify 机制对文件系统进行监控,实现同步更新。BorgBackup 以压缩和加密的方式存储备份数据。distcp 是 Hadoop 生态中的分布式复制工具,特别适用于大规模数据集,能够利用 Hadoop 集群的并行处理能力,同时优化网络带宽的使用,适合于数据仓库的构建场景。

### 2.2 distcp的工作原理

#### 2.2.1 distcp的分布式复制机制

distcp (Distributed Copy) 是 Hadoop 生态中的一个命令行工具,用于在 HDFS (Hadoop Distributed File System) 集群之间复制数据。它的分布式复制机制基于 MapReduce 模型,将大型文件分割成多个块(block),然后在源和目标集群之间并行复制这些块。每个 Map 任务负责复制一部分数据,最后通过 Reduce 任务进行汇总。这种机制允许 distcp 非常高效地复制大规模数据集,同时保持高吞吐量和容错能力。

#### 2.2.2 避免文件覆盖的工作原理

为了避免在复制过程中覆盖目标集群上已有的文件,distcp 使用了严格的文件检查机制。它会预先检查目标路径下是否已经存在同名文件,并对文件的元数据(如修改时间、大小等)进行比较。只有当源文件比目标文件更新(或不存在目标文件时)才会执行复制操作。这一机制确保了数据的一致性和完整性,防止了数据的意外丢失。

### 2.3 distcp的使用场景分析

#### 2.3.1 数据仓库中distcp的适用性

在数据仓库的构建中,distcp 特别适用于迁移和同步大规模数据集。由于数据仓库通常需要处理 TB 至 PB 级别的数据量,distcp 的高吞吐量和容错能力使其成为理想的选择。同时,它也支持对数据文件的完整性和一致性进行校验,确保在数据仓库中存储的数据是准确无误的。

#### 2.3.2 典型应用案例

在构建一个新的数据仓库时,一个典型的应用场景是将源数据集从一个 HDFS 集群迁移到目标集群上。这可以通过使用 distcp 工具来实现,通过分布式复制来保证数据的完整性和可靠性。另一个例子是数据仓库的定期更新和同步,这需要 distcp 在不同时间点对数据集进行快速复制,支持数据仓库的持续数据维护和分析工作。

通过本节的介绍,我们了解了 distcp 的基本概念、工作原理、使用场景,以及它在数据仓库构建中的重要性。接下来章节将继续深入探讨避免文件覆盖的实践技巧,并提供具体的技术操作和案例分析。

# 3. 避免文件覆盖的实践技巧

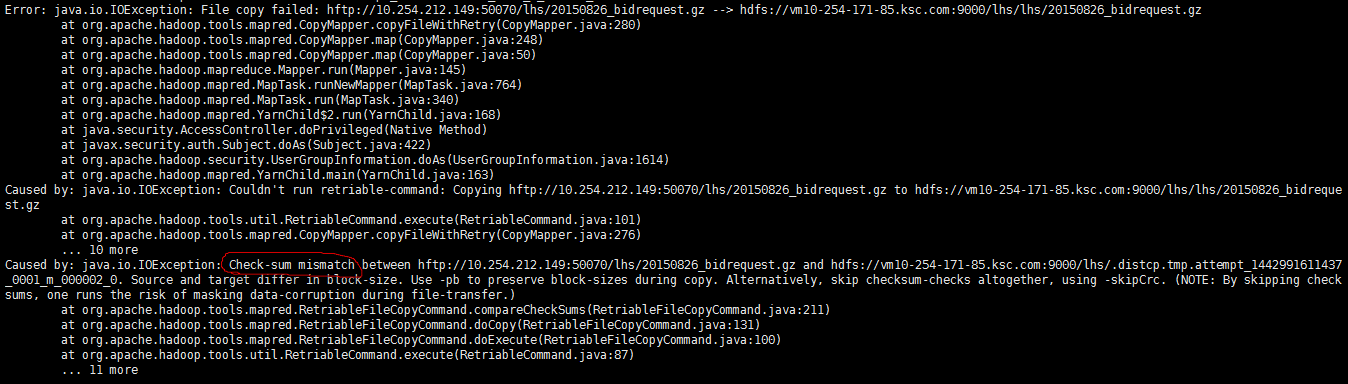

为了避免在数据仓库构建过程中发生文件覆盖的问题,本章节将详细介绍避免文件覆盖的实践技巧。我们将从配置参数详解开始,到文件覆盖检测与处理,最后关注日志监控与错误处理。每一个环节都至关重要,都需要细致的操作和管理。

## 3.1 配置参数详解

### 3.1.1 分块大小的设置

在使用distcp进行数据复制时,合理的设置分块大小至关重要。分块大小决定了文件被切分成多少个小块进行并行复制,从而影响数据复制的效率和性能。

```bash

hadoop distcp -m 10 -update src dst

```

在上述命令中,`-m`参数代表的是Map任务的数量,与分块大小紧密相关。将`-m`设置为10意味着会有10个Map任务并行执行,进而影响到分块的大小。如果需要更细粒度的控制,可以通过`-blocksize`参数来直接设置分块大小。

合理设置分块大小可以避免网络拥塞以及优化磁盘I/O性能,通常需要根据集群的实际性能进行调整。

### 3.1.2 重试和复制的策略

当复制过程中发生错误时,distcp提供了重试机制,允许对出错的文件或任务进行重试。在某些情况下,重试能够成功完成任务,避免了因一次性失败而放弃整个复制任务。

```bash

hadoop distcp -update -strategy OncedFailedOnly src dst

```

在上述命令中,`-strategy`参数设置了复制的策略。`OncedFailedOnly`表示只有在之前尝试失败的文件或目录会被重试。这个策略在减少不必要的重试同时,尽可能保证了数据的完整性。

## 3.2 文件覆盖检测与处理

### 3.2.1 检测机制的实现

为了避免文件覆盖,我们需要实现一个有效的检测机制,可以在文件复制前检查目标路径中是否存在同名文件,并进行适当的处理。我们可以编写一个简单的脚本来检查文件是否存在,并在存在时提示用户或阻止复制过程。

### 3.2.2 避免覆盖的解决方案

检测到潜在的文件覆盖风险后,可以采取多种策略来避免覆盖发生:

- **重命名**:在复制文件前对目标路径中的同名文件进行重命名操作,可以是在文件名后添加时间戳或者递增序号。

0

0