【distcp工具详解】:如何确保数据在文件覆盖时的一致性与安全

发布时间: 2024-10-29 13:50:43 阅读量: 25 订阅数: 23

# 1. distcp工具概览与应用场景

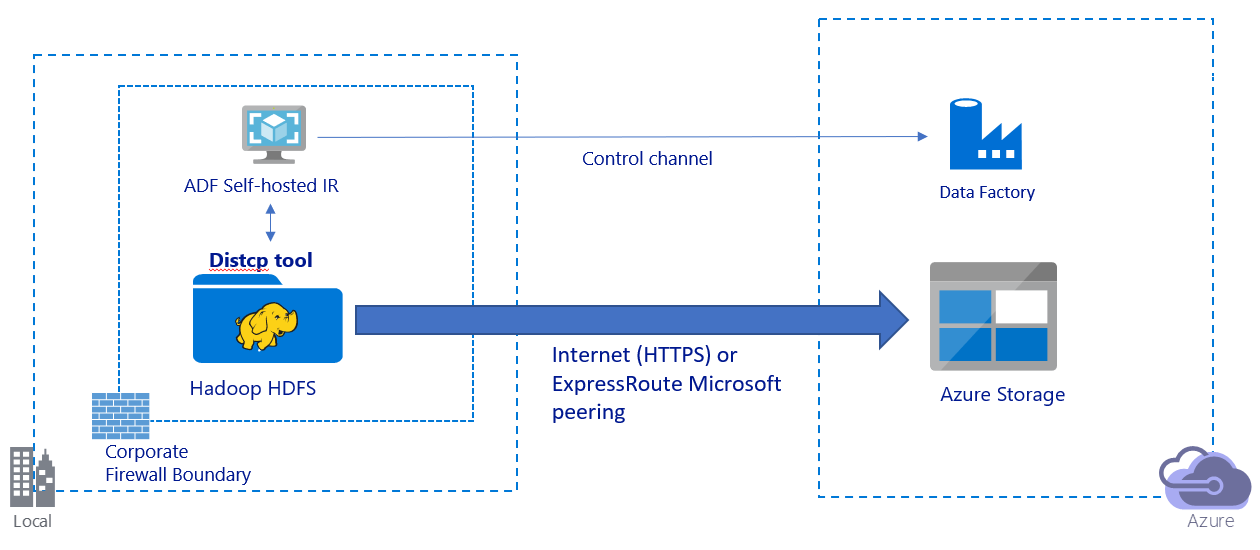

## 1.1 distcp简介

distcp(Distributed Copy)是一个用于在Hadoop文件系统(HDFS)之间高效地复制大数据的工具。它利用MapReduce来并行处理数据,极大提高了数据复制的速度和效率。作为一种常用于大数据环境下的数据迁移和备份的解决方案,distcp可以有效地扩展到数百个节点,高效处理PB级别的数据。

## 1.2 应用场景

在进行Hadoop环境升级、数据迁移、备份或负载均衡时,distcp可以作为核心工具发挥作用。它支持大范围的复制任务,包括但不限于跨集群的数据同步,灾难恢复计划中数据的紧急备份,以及对数据仓库的数据更新等。

## 1.3 使用distcp的优势

使用distcp具有以下几个优势:

- **高效**:通过MapReduce实现高度并行处理,大幅提升数据复制的速度。

- **容错性**:能够处理节点故障,保证复制任务的完整性。

- **一致性**:确保数据源和目标之间的最终一致性。

例如,要从一个HDFS集群复制数据到另一个集群,我们可以使用如下命令:

```bash

hadoop distcp hdfs://source-cluster/path hdfs://target-cluster/path

```

该命令会启动一个MapReduce作业,将源路径下的数据复制到目标路径。接下来的章节将深入探讨distcp的工作原理和关键技术。

# 2. distcp的工作原理和关键技术

## 2.1 distcp的工作流程解析

### 2.1.1 基本的数据复制机制

distcp(Distributed Copy)是一个用于分布式环境中高效地在Hadoop文件系统(HDFS)之间复制大量数据的工具。它将数据复制任务分解成多个子任务,这些子任务可以并行执行,充分利用集群的计算资源。在深入了解distcp的工作原理之前,我们需要了解其基本的数据复制机制。

distcp工作流程始于用户执行distcp命令并指定源目录和目标目录。以下是其基本操作步骤:

1. **解析命令行参数**:distcp根据命令行参数确定要复制的数据范围。

2. **列出数据**:通过访问源目录,distcp列出所有文件和目录。

3. **计算数据分区**:将数据集分成多个小块,这些小块大小相等且能够并行复制。

4. **任务分配**:为每个数据块创建复制任务,并将任务分配给集群中的不同节点。

5. **执行复制操作**:集群中的节点执行实际的数据复制操作。

6. **监控与同步**:监控复制任务的状态,确保所有数据块成功复制。

7. **清理与确认**:一旦所有任务完成,清理临时数据,并确认复制完成。

每个步骤都是为了提高数据复制的效率和可靠性。其中关键的一步是任务的并行处理,它可以显著减少总体的复制时间。

### 2.1.2 面向Hadoop生态的数据复制策略

由于distcp是为Hadoop生态设计的工具,它必须能够处理HDFS的特定特性和限制。HDFS的块存储机制、高容错性、数据本地性等特性都被distcp充分考虑在内。

- **HDFS块存储**:HDFS将文件分成一系列的块,这些块存储在不同的数据节点(DataNodes)上。distcp复制过程中会考虑这些块的存储位置,以实现数据的高效本地化传输。

- **容错机制**:HDFS通过在多个节点上存储数据的多个副本保证数据安全。distcp在复制过程中会检查并确保数据副本的正确性。

- **数据本地性**:在执行MapReduce任务时,Hadoop会优先在包含数据副本的节点上调度任务,以减少网络传输。distcp在执行复制时也会尽可能利用这一特性来减少数据传输量。

接下来,我们更深入地探讨distcp在数据一致性和性能优化方面是如何实现的。

## 2.2 数据一致性保证机制

### 2.2.1 原子性操作原理

数据一致性是数据复制过程中非常重要的要求。distcp提供原子性操作保证数据在复制过程中的完整性。这主要体现在它能够处理复制失败的情况,确保不会出现部分更新的问题。

数据一致性保证的关键点包括:

- **备份机制**:在开始复制之前,distcp会创建源数据的备份,防止复制过程中出现错误导致源数据损坏。

- **任务原子性**:每个复制任务要么完全成功,要么完全失败,不会产生中间状态。

### 2.2.2 数据校验和修复机制

复制完成后,distcp会进行数据校验,以确保数据的一致性。这包括检查复制到目标目录的文件和目录是否与源完全一致。如果在任何复制任务中出现错误,distcp会记录错误并提供选项让用户决定如何处理这些问题。

- **校验过程**:通过计算源目录和目标目录下相同文件的校验和(checksum),distcp可以比较数据的完整性。

- **修复选项**:对于校验不一致的文件,distcp提供了重新复制或使用源文件覆盖目标目录的选项。

## 2.3 distcp的性能优化

### 2.3.1 并行复制与网络优化

为了提升性能,distcp使用并行复制来充分利用集群的计算能力。它通过创建多个复制任务并行执行来实现这一目标。这不仅可以加快数据的复制速度,还可以提高网络带宽的利用率。

- **并行度设置**:用户可以通过设置参数来控制并行复制任务的数量。

- **网络调度**:distcp在执行复制时会根据网络状况动态调度任务,避免网络拥塞。

### 2.3.2 资源调度和错误处理

除了并行复制,distcp还通过有效的资源调度和错误处理机制来优化性能。这包括对集群资源的合理分配和对复制过程中可能出现的错误进行及时处理。

- **资源管理**:distcp根据集群资源状况合理安排复制任务,确保不会因为资源竞争导致任务延迟或失败。

- **错误重试策略**:在遇到临时错误(如网络中断)时,distcp会自动尝试重新执行复制任务。

在了解了distcp的工作流程和数据一致性保证机制之后,我们可以看到,这是一个在大数据环境下非常重要的工具,能够高效、安全地完成大规模数据复制任务。接下来的章节将详细介绍如何在实际应用中保持数据一致性,并且在实践中应用distcp。

# 3. distcp数据覆盖与一致性实践

在大数据环境中,确保数据的一致性和完整性是至关重要的。distcp(distributed copy)工具不仅支持高效的数据复制,还集成了多种机制来防止数据覆盖和保持数据一致性。本章将深入探讨如何在使用distcp时避免数据丢失和覆盖,如何处理实际场景中出现的一致性问题,并提供一些关于安全性最佳实践的建议。

## 3.1 避免数据丢失与覆盖策略

### 3.1.1 备份与恢复机制

在执行数据复制之前,一个可靠的备份策略是防止数据丢失的关键步骤。备份机制通常需要满足以下几个基本要求:

- **完整性**:备份数据应能够完整反映原始数据的状态。

- **效率**:备份操作不能显著降低系统性能。

- **可靠性**:备份数据应当易于恢复,并且能够应对各种灾难场景。

对于使用distcp的场景,可以通过以下步骤实现备份:

1. 在执行distcp之前,先将目标目录进行快照或复制,保留原始数据的副本。

2. 在复制过程中,定时在新创建的目录下备份已复制的数据。

3. 一旦检测到数据丢失或覆盖,可以通过备份恢复到最近的一致状态。

下面提供一个简单的备份脚本示例:

```bash

#!/bin/bash

# 设置目标路径和备份目录

dest_path="/path/to/destination"

backup_path="/path/to/backup"

# 创建备份目录

mkdir -p "${backup_path}/$(date +%Y%m%d%H%M%S)"

# 同步目标路径到备份路径

distcp "${dest_path}" "${backup_path}/$(date +%Y%m%d%H%M%S)"

# 可以定期(例如每小时)执行此脚本进行备份

```

### 3.1.2 版本控制与数据保留策略

版本控制是另一种有效防止数

0

0