机器学习背后的矩阵论:揭秘算法的核心原理

发布时间: 2025-01-07 00:04:50 阅读量: 15 订阅数: 19

# 摘要

矩阵论在机器学习领域扮演着基础且关键的角色,它不仅为算法提供了数学表达的基础,还优化了计算过程。本文从矩阵论的基本概念和性质出发,深入探讨了矩阵的基本运算和分解技术,及其在线性回归、主成分分析(PCA)、支持向量机(SVM)和神经网络等机器学习算法中的应用。接着,文章分析了矩阵运算的优化技术,如高效的矩阵乘法和大规模矩阵处理技术。案例研究展示了矩阵论在图像处理和网络分析中的具体应用。最后,本文展望了矩阵论在机器学习领域的未来趋势,包括新进展和与量子计算的结合潜力。

# 关键字

矩阵论;机器学习;线性代数;矩阵运算优化;主成分分析;量子计算

参考资源链接:[矩阵论同步辅导详解:张凯院&徐仲编教材配套习题与试题解析](https://wenku.csdn.net/doc/19gtw6e4ft?spm=1055.2635.3001.10343)

# 1. 矩阵论在机器学习中的基础作用

## 1.1 矩阵论与数据表示

在机器学习领域,数据的处理和分析往往涉及大量的数值运算。矩阵论为我们提供了一种强大的工具,它在表示和操作数据结构方面扮演着基础角色。矩阵可以表示为二维数组,其元素可以是数字、图像、声音等数据类型。通过矩阵,复杂的多维数据可以被有效地表示和处理,这是实现机器学习算法的前提。

## 1.2 矩阵运算与算法效率

矩阵运算在机器学习中无处不在,从线性回归到深度学习的每一步都离不开它们。矩阵运算不仅在计算上高度并行化,而且有助于简化算法的表达和提高计算效率。矩阵乘法、加法、逆运算等基础操作是构建复杂机器学习模型的基石。

## 1.3 矩阵分解与特征提取

特征提取是机器学习中数据分析的关键步骤之一,而矩阵分解技术如奇异值分解(SVD)和主成分分析(PCA)提供了强大的工具。通过矩阵分解,数据的内在结构可以被揭示和提取,这有助于理解数据集的特征空间,从而在降维、去噪等方面起到重要作用。

## 1.4 总结

矩阵论为我们提供了一套丰富的数学工具,它们在机器学习领域的应用极为广泛。从数据表示、算法效率提升到特征提取,矩阵论在机器学习的众多环节中发挥着不可替代的作用。通过深入理解和掌握矩阵论,我们能够更好地推动机器学习技术的发展。

# 2. 矩阵论的基本概念与性质

## 2.1 矩阵的定义和分类

### 2.1.1 向量和矩阵的定义

向量是机器学习中描述特征和数据点的基础数学对象。数学上,向量可以视为一列有序的数,通常用斜体小写字母表示,如 \( \mathbf{x} \)。这些数称为向量的元素或分量,可以是实数也可以是复数,而向量的维度就是其分量的数量。

矩阵是一个由数排列成的矩形阵列,用大写字母表示,如 \( \mathbf{A} \)。矩阵中的数称为矩阵的元素,每一行和每一列都有一个索引。例如,一个 \( m \times n \) 的矩阵有 \( m \) 行和 \( n \) 列。矩阵在数学和工程中具有广泛的应用,包括但不限于线性变换、系统方程组的表示等。

### 2.1.2 矩阵的基本类型

矩阵的种类繁多,按照不同的分类标准有不同的类型:

- **按矩阵的大小分类**:矩阵可以分为方阵、行矩阵、列矩阵等。

- **按元素的特性分类**:如实数矩阵、复数矩阵。

- **按特殊性质分类**:例如零矩阵(所有元素为零)、单位矩阵(对角线元素为1,其余元素为零)、对角矩阵(除了对角线之外的元素都为零)等。

## 2.2 矩阵的基本运算

### 2.2.1 矩阵加法和数乘

矩阵加法是对应位置元素相加的运算。设有两个同型矩阵 \( \mathbf{A} \) 和 \( \mathbf{B} \),其加法运算定义为:

```math

\mathbf{A} + \mathbf{B} = [a_{ij} + b_{ij}]_{m \times n}

```

其中 \( a_{ij} \) 和 \( b_{ij} \) 分别是矩阵 \( \mathbf{A} \) 和 \( \mathbf{B} \) 的第 \( i \) 行第 \( j \) 列的元素。只有当两个矩阵具有相同的尺寸时,矩阵加法才有定义。

数乘则是将矩阵的每一个元素乘以一个标量的运算。如果有标量 \( k \) 和矩阵 \( \mathbf{A} \),其数乘运算定义为:

```math

k \mathbf{A} = [k \cdot a_{ij}]_{m \times n}

```

### 2.2.2 矩阵乘法及其性质

矩阵乘法是线性代数中最重要的运算之一。设有两个矩阵 \( \mathbf{A}_{m \times n} \) 和 \( \mathbf{B}_{n \times p} \),它们的乘法 \( \mathbf{C} = \mathbf{A} \mathbf{B} \) 定义为:

```math

c_{ij} = \sum_{k=1}^{n} a_{ik} b_{kj}

```

这个运算的结果是一个 \( m \times p \) 的矩阵 \( \mathbf{C} \)。矩阵乘法的一个重要性质是,它不满足交换律,即 \( \mathbf{A} \mathbf{B} \neq \mathbf{B} \mathbf{A} \),除非两个矩阵都是方阵并且可交换。

### 2.2.3 矩阵的逆和伪逆

矩阵的逆指的是方阵 \( \mathbf{A} \) 拥有一个满足 \( \mathbf{A}^{-1} \mathbf{A} = \mathbf{A} \mathbf{A}^{-1} = \mathbf{I} \) 的矩阵 \( \mathbf{A}^{-1} \),其中 \( \mathbf{I} \) 是单位矩阵。逆矩阵并不是所有矩阵都存在的,只有当矩阵是可逆的,即行列式不为零时,才有逆矩阵。

对于非方阵或者是不可逆方阵,可以考虑计算伪逆矩阵。伪逆矩阵(也称为摩尔-彭若斯逆)是一个特殊的广义逆矩阵,它允许对非方阵或奇异方阵进行矩阵乘法运算,为机器学习中的许多问题提供了一个数学上的解决方案。

## 2.3 矩阵分解技术

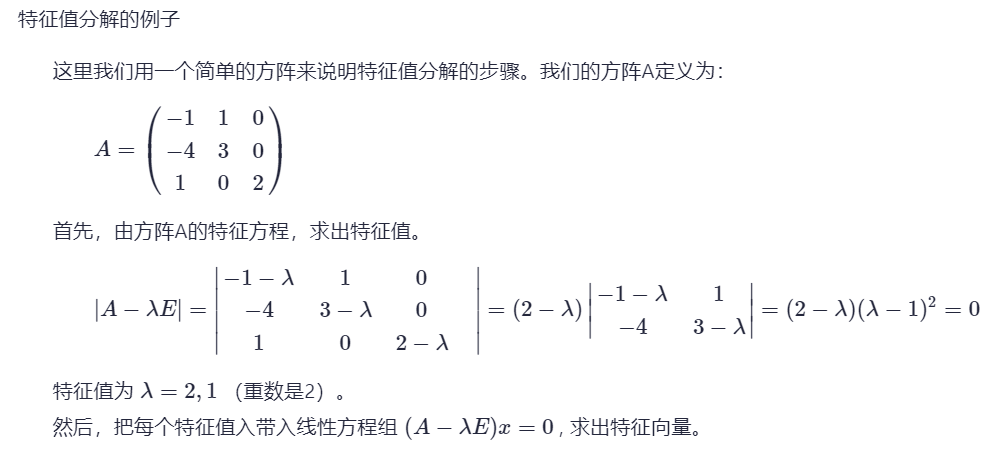

### 2.3.1 特征值分解

特征值分解是将方阵 \( \mathbf{A} \) 表示为一组特征值和特征向量乘积的和,形式如下:

```math

\mathbf{A} = \mathbf{PDP}^{-1}

```

其中,\( \mathbf{D} \) 是对角矩阵,其对角线上的元素是 \( \mathbf{A} \) 的特征值,而 \( \mathbf{P} \) 是由 \( \mathbf{A} \) 的特征向量组成的矩阵。特征值分解在主成分分析(PCA)等算法中有广泛应用。

### 2.3.2 奇异值分解(SVD)

奇异值分解(SVD)是一种分解非方阵的方法,它可以将矩阵 \( \mathbf{A} \) 分解为三个矩阵的乘积:

```math

\mathbf{A} = \mathbf{U} \Sigma \mathbf{V}^T

```

这里,\( \mathbf{U} \) 和 \( \mathbf{V} \) 是正交矩阵,而 \( \Sigma \) 是一个对角矩阵,其对角线上的元素是奇异值,是 \( \mathbf{A} \mathbf{A}^T \) 和 \( \mathbf{A}^T \mathbf{A} \) 的非负平方根。SVD在图像处理、数据压缩等领域有着重要应用。

### 2.3.3 LU分解和QR分解

LU分解是将一个方阵分解为一个下三角矩阵 \( \mathbf{L} \) 和一个上三角矩阵 \( \mathbf{U} \) 的乘积:

```math

\mathbf{A} = \mathbf{L} \mathbf{U}

```

LU分解在解线性方程组中非常有用,尤其是当需要对同一个矩阵求解多个不同的常数向量时。

QR分解则是将一个矩阵分解为一个正交矩阵 \( \mathbf{Q} \) 和一个上三角矩阵 \( \mathbf{R} \) 的乘积:

```math

\mathbf{A} = \mathbf{Q} \mathbf{R}

```

它在最小二乘问题和计算矩阵的伪逆时非常有用。

在本章节中,我们通过介绍矩阵的定义、分类、基本运算以及矩阵分解技术,搭建了学习矩阵论和进一步探索其在机器学习中应用的基础。这些基本概念的掌握对于理解后续的算法和优化策略至关重要。

# 3. 线性代数与机器学习算法

线性代数是机器学习的数学基础之一,提供了描述和操作数据、模型和算法的工具。这一章我们将深入探讨矩阵在机器学习算法中的关键作用,特别是线性回归模型、主成分分析(PCA)以及矩阵在其他算法中的应用。

## 3.1 线性回归模型

线性回归是最基础的机器学习模型之一,它通过构建数据点的线性关系来预测结果。在线性回归中,矩阵表示提供了一种强大且灵活的方法来描述和解决问题。

### 3.1.1 模型的矩阵表示

线性回归模型可以通过矩阵方程来表示,即`Y = Xβ + ε`,其中`Y`是因变量向量,`X`是自变量矩阵,`β`是系数向量,而`ε`是误差向量。矩阵的运用在这里使得问题更加直观且易于操作。

```python

import numpy as np

# 示例数据

X = np.array([[1, 2], [3, 4], [5, 6]]) # 自变量矩阵

Y = np.array([1, 3, 5]) # 因变量向量

```

### 3.1.2 参数估计与正规方程

参数估计是线性回归的核心。使用最小二乘法可以通过正规方程`β = (X^T * X)^(-1) * X^T * Y`来求解参数`β`。这里`X^T`是`X`的转置,而`(X^T * X)^(-1)`则是矩阵的逆。

```python

# 计算参数估计

beta = np.linalg.inv(X.T @ X) @ X.T @ Y

```

在这个例子中,我们首先计算了`X`的转置与`X`的乘积,接着求出了这个矩阵的逆。最后,我们利用这个逆矩阵与`X`的转置和`Y`的乘积得到了参数`β`的估计值。

## 3.2 主成分分析(PCA)

PCA是一种常用的数据降维技术,它通过矩阵分解来提取数据中最重要的特征。

### 3.2.1 PCA

0

0