Fluentd插件生态系统大揭秘

发布时间: 2024-12-13 17:42:56 阅读量: 8 订阅数: 12

参考资源链接:[Fluent入门指南:理解和应用shadow面及初始化策略](https://wenku.csdn.net/doc/63yh5d3q83?spm=1055.2635.3001.10343)

# 1. Fluentd基础知识介绍

Fluentd作为一个开源的数据收集器,它的目标是将分散的日志数据汇聚起来并进行统一管理。通过其独特的数据流模型和插件机制,Fluentd能够实现日志数据的灵活转发。

## 1.1 简介

Fluentd通过使用JSON作为内部数据格式,确保了插件之间的无缝协作。无论数据来源或目的地是什么,Fluentd都能以一种统一的方式处理它们,极大地简化了日志数据的集成与管理。

## 1.2 关键特性

- **统一的日志层**:Fluentd为应用程序日志、系统日志、事件等提供统一的日志层。

- **健壮性和可靠性**:即使在部分组件失效的情况下,Fluentd也能保证日志数据的完整性和可靠性。

- **扩展性**:Fluentd通过插件生态系统提供了强大的扩展能力,可以轻松地适应新的数据源或输出目标。

接下来,我们将深入探讨Fluentd的核心架构以及其插件机制,理解它是如何实现高效的日志数据处理与传输的。

# 2. Fluentd核心架构与插件机制

## 2.1 Fluentd的架构原理

### 2.1.1 数据流模型概述

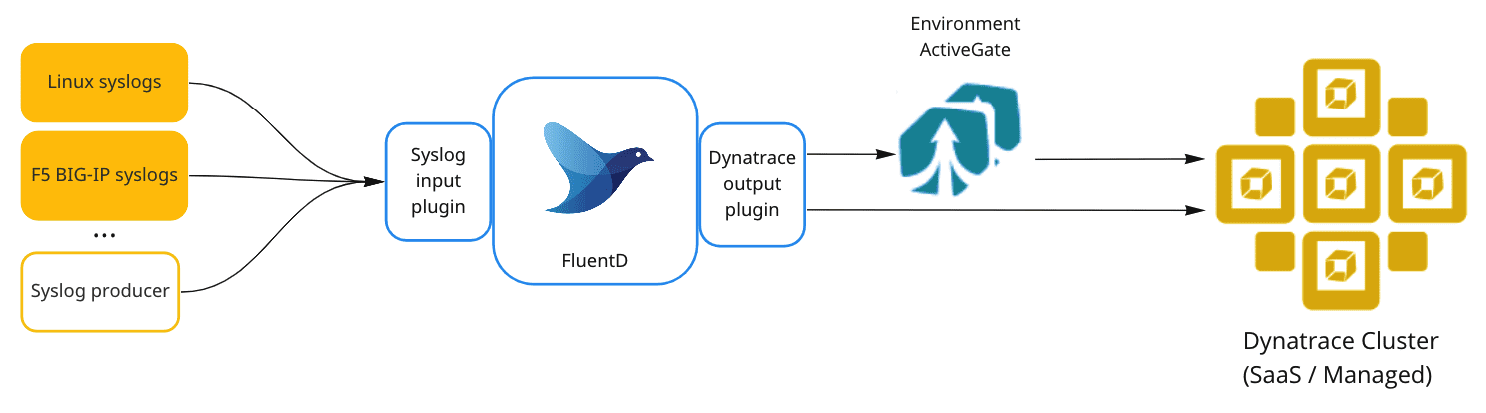

Fluentd的设计初衷是为了解决数据收集和转发的灵活性和可靠性问题。Fluentd通过其独特的数据流模型实现这一目标,它将数据收集器、过滤器和转发器三个角色分离,使得每个组件都能够独立地专注于其核心功能。

数据流模型由以下三个部分组成:

- **Sources**:负责接收来自各个数据源的数据。

- **Parsers/Filters**:解析和处理数据。

- **Outputs**:将处理后的数据发送到指定的目的地。

数据以JSON格式在Fluentd内部流动,这种方式统一了数据的格式,并且易于扩展和处理。这种设计使得Fluentd能够轻松地集成不同的数据源和目的地,并且可以方便地进行数据过滤和转换。

### 2.1.2 核心组件和插件的角色

核心组件包括但不限于:

- **Fluentd Daemon**:运行在服务器上的守护进程,管理所有的 Sources, Parsers/Filters, 和 Outputs。

- **Plugin**:用于定义 Sources, Parsers/Filters, 和 Outputs 的可插拔组件。

插件是Fluentd架构的支柱,它们允许Fluentd轻松适应不断变化的日志格式和技术栈。由于其可插拔性,用户可以扩展或更换插件以满足不同的业务需求。这种模块化的设计,使得Fluentd在保证核心功能稳定的同时,可以快速迭代更新,适应日志技术的发展。

#### Fluentd Daemon

Fluentd Daemon作为守护进程,负责监听配置文件中定义的Source。一旦接收到数据,它会根据配置文件中的定义,将数据传递给相应的Parser/Filter进行处理。处理后的数据会被路由到配置好的Output目的地。

#### 插件

Fluentd的插件分为三类:Source插件、Filter插件和Output插件。

- **Source插件**负责从各种数据源接收数据。数据源可以是文件系统、网络服务、数据库等。

- **Filter插件**是核心组件之一,它允许用户定义数据处理的逻辑。包括数据清洗、格式化、记录日志等操作。

- **Output插件**负责将处理后的数据发送到外部系统,如数据库、搜索引擎、云存储服务等。

## 2.2 插件生态系统综述

### 2.2.1 插件的分类与功能

Fluentd的插件生态非常丰富,截至2023年,Fluentd社区已经提供了超过600个插件供用户选择,这些插件按照其功能可以分为以下几类:

- **协议类插件**:负责与外部系统通信,例如HTTP、TCP、UDP、Kafka等。

- **存储类插件**:负责将数据存储起来,如Elasticsearch、MySQL、MongoDB、Amazon S3等。

- **解析类插件**:将原始数据解析为可理解的格式,如Apache、JSON、CSV等。

- **输出类插件**:处理并转发数据到其他系统,如Fluent Bit、Treasure Data、Amazon Kinesis等。

### 2.2.2 插件在数据处理中的作用

在数据处理的流程中,插件承担了至关重要的角色。它们可以根据用户需求定制数据流的行为:

- **自定义数据源接入**:Fluentd能够通过Source插件接入几乎所有类型的数据源。

- **数据处理和转换**:Filter插件可以进行数据清洗、字段重命名、条件判断等操作。

- **数据持久化**:Output插件负责将数据持久化到外部存储系统中,或转发到其他服务。

## 2.3 插件的安装与管理

### 2.3.1 插件安装方法

安装Fluentd插件非常简单,可以通过命令行工具进行:

```bash

gem install fluent-plugin-<plugin-name>

```

也可以通过Fluentd的配置文件指定插件进行安装:

```xml

<match mytag.**>

@type <plugin-name>

# 插件配置项...

</match>

```

对于某些插件,还可以通过Fluentd的RubyGems包管理器直接安装。

### 2.3.2 插件版本管理与更新

随着系统环境的变化和插件自身更新,维护插件的版本非常重要。可以通过以下方法管理插件版本:

- **RubyGems版本约束**:在Gemfile中指定插件的版本范围。

- **命令行更新**:使用`gem update`命令可以全局更新所有或指定的Fluentd插件。

```bash

gem update fluent-plugin-<plugin-name>

```

- **Fluentd配置文件**:在Fluentd配置文件中指定插件版本,这可以在更新系统时提供精确控制。

```xml

<match mytag.**>

@type <plugin-name>, <version>

# 插件配置项...

</match>

```

在维护过程中,及时更新和测试新版本插件是保证系统稳定运行的关键步骤。

至此,我们已经介绍了Fluentd的核心架构和插件机制的基础知识。接下来的章节,我们将深入探讨如何在实际环境中应用这些插件,并展示一些实战案例和优化技巧。

# 3. Fluentd插件实战应用

## 3.1 输入插件的使用与案例分析

### 3.1.1 常见输入插件的对比

在Fluentd中,输入插件是接收数据的端点,它们负责从各种数据源收集数据。Fluentd拥有多种类型的输入插件,用于满足不同的需求。下面是几个常见的输入插件对比:

- **Tail插件**:适用于监控文件变化并读取新内容。适合于日志文件等数据源。它仅支持读取文件尾部的数据,因此适用于日志轮转频繁的场景。

- **HTTP插件**:可以接收HTTP请求中的数据。适合于Web应用程序,或者需要远程发送数据的场景。由于它支持HTTP协议,因此可以很容易地与各种后端服务集成。

- **TCP/UDP插件**:通过网络端口接收数据。适合于需要通过网络传输日志数据的场景。这两个插件的使用依赖于网络编程,因此需要额外注意安全性和性能。

- **exec插件**:运行指定的命令并收集其输出。适合于动态生成数据的程序或脚本。

这些插件各有其适用场景,选择合适的插件需要基于数据源、数据量、实时性要求等因素来决定。在实际部署时,往往需要综合考虑性能、资源占用和维护成本。

### 3.1.2 输入插件配置示例及优化

为了更好地理解如何配置和优化输入插件,这里给出一个具体的

0

0