Fluentd与ELK对比分析

发布时间: 2024-12-13 17:05:16 阅读量: 11 订阅数: 12

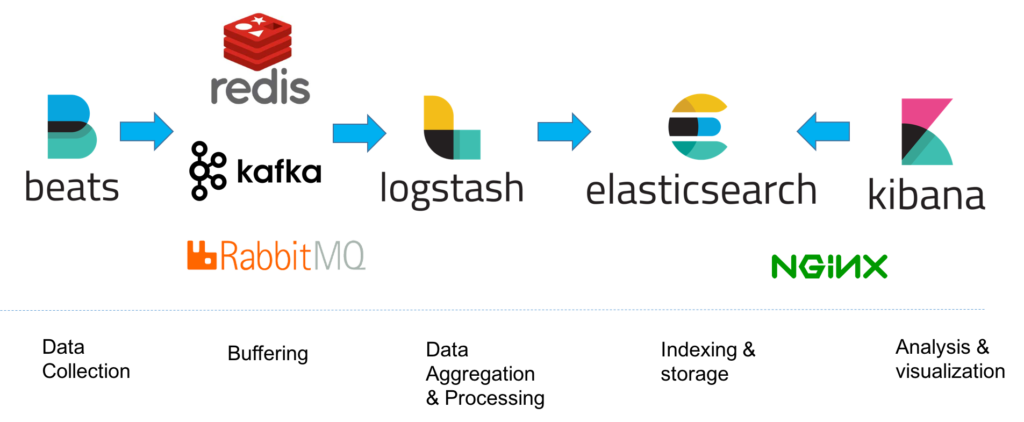

ELK与EFK1

参考资源链接:[Fluent入门指南:理解和应用shadow面及初始化策略](https://wenku.csdn.net/doc/63yh5d3q83?spm=1055.2635.3001.10343)

# 1. 日志数据处理概述

## 1.1 日志数据的重要性

日志数据是信息系统运行中的副产品,它记录了系统的运行状态和用户的活动记录。在故障排查、性能分析、安全审计等多个方面,日志数据扮演着至关重要的角色。它的价值随着数据量的增加而显著提高,因此如何高效地处理和分析日志数据成为了IT领域的重要议题。

## 1.2 日志数据处理的目标

处理日志数据的目标包括但不限于以下几点:

- **实时监控**:快速识别并响应系统异常和安全威胁。

- **数据分析**:通过聚合和查询日志数据,进行业务趋势和用户行为分析。

- **长期存储**:确保关键信息的安全存储,满足法规遵从性和事后审计需求。

## 1.3 日志数据处理的挑战

尽管日志数据处理的重要性不言而喻,但在实施过程中存在如下挑战:

- **数据量大**:随着系统和用户规模的扩张,日志数据的量级呈指数级增长。

- **数据种类多**:不同应用和服务产生的日志格式多样,处理起来复杂度高。

- **实时性要求高**:对日志数据的实时处理能力提出了更高的要求,尤其是在实时监控和告警场景中。

通过掌握日志数据处理的基本理论和工具,能够更好地应对这些挑战,提高IT系统的稳定性和业务价值。接下来的章节我们将深入探讨具体工具如Fluentd和ELK栈的应用与对比。

# 2. Fluentd的基础知识与架构

## 2.1 Fluentd的基本概念与特点

### 2.1.1 Fluentd的设计理念

Fluentd的核心设计理念是提供统一的日志层,旨在简化和统一日志数据的收集、聚合和消费过程。它通过将数据输入、处理和输出分离,实现了高可用性和可扩展性。Fluentd的设计理念还体现在它的插件架构上,允许开发者轻松地扩展其功能。

与传统的日志处理工具相比,Fluentd强调数据处理的可编程性、数据模型的一致性和插件系统的可扩展性。这种设计理念使得Fluentd可以在各种不同的环境中灵活部署,从简单的单机应用到大规模的分布式系统。

### 2.1.2 Fluentd的架构与组件

Fluentd的架构非常简洁明了,主要由三部分组成:源(Source)、输出(Output)和Fluentd引擎。数据流从源开始,经过Fluentd引擎处理后,最终流向输出。

- **源(Source)**:源是数据流入Fluentd的点。它可以是文件、标准输出、HTTP请求等。Fluentd支持多源并行输入,这使得它能够同时处理来自多个来源的数据。

- **Fluentd引擎**:引擎是Fluentd的心脏,负责读取源中的数据,执行数据转换,并将数据传输到输出。它使用一种名为“记录”的JSON格式,确保了数据的一致性。

- **输出(Output)**:输出是数据从Fluentd流出的点。它可以是各种数据存储系统,如文件系统、数据库或消息队列等。

这种架构设计使得Fluentd非常适合用作日志聚合器。它能够高效地处理大规模的数据流,同时通过插件系统使得整个生态系统能够持续地扩展和更新。

## 2.2 Fluentd的数据处理流程

### 2.2.1 日志输入与数据流管理

在Fluentd中,日志数据的输入通常通过配置文件中的source块来定义。例如,要收集日志文件,可以使用file插件作为source,并指定日志文件的路径。

```markdown

<source>

@type tail

path /var/log/syslog

pos_file /var/log/syslog.pos

tag system.syslog

format none

</source>

```

该配置使用了`tail`插件来持续追踪文件的更新。`path`参数指定了要监控的文件路径,`pos_file`用于保存当前读取的位置,以确保不会漏读或重复读取日志。`tag`参数用于标记数据流,`format none`表示不对日志内容进行解析,保留原始格式。

数据流管理的关键在于,Fluentd能够将不同格式的日志统一处理,通过内部的记录系统将所有数据转换成JSON格式,这为后续的数据处理和分析打下了基础。

### 2.2.2 数据转换与过滤机制

数据一旦被读取进入Fluentd,就可以通过filter插件进行转换和过滤。Fluentd的filter插件非常强大,可以实现复杂的逻辑,如数据格式转换、字段提取、数据修改等。

```markdown

<filter system.syslog>

@type record_transformer

enable_ruby true

<record>

host ${hostname}

severity ${record['severity']}

</record>

</filter>

```

在上述配置中,`record_transformer`插件用于修改数据记录。这里,我们添加了`host`字段,并提取了`severity`字段的值。`enable_ruby true`表示允许使用Ruby代码进行更复杂的处理。

过滤机制不仅限于添加或修改字段,还可以基于条件来过滤日志,如只转发严重级别为“ERROR”的日志消息。

```markdown

<filter system.syslog>

@type grep

<exclude>

key severity

pattern ^DEBUG$

</exclude>

</filter>

```

在这个例子中,`grep`插件被用来排除所有严重级别为“DEBUG”的日志。这样,只有不是DEBUG级别的日志才会被转发到下一个输出目标。

## 2.3 Fluentd的实践应用案例分析

### 2.3.1 实际部署与监控

Fluentd的部署非常灵活。它可以作为服务运行在各个服务器上,也可以部署在容器化环境中。在实际部署过程中,通常需要考虑以下几个关键点:

- **配置管理**:对于大型部署,通常会使用配置管理工具如Ansible或Chef来自动化部署Fluentd。

- **资源监控**:使用像Prometheus这样的监控工具来收集Fluentd的性能指标。

- **日志聚合**:Fluentd的日志可以被推送到集中式日志分析平台,如ELK或Splunk。

```markdown

# 示例命令:使用fluentd-gem安装fluentd并启动服务

$ fluentd-gem install fluent-plugin-elasticsearch

$ fluentd -c fluentd.conf -vv &

```

上述命令展示了如何使用fluentd-gem工具安装一个针对Elasticsearch的输出插件,并启动Fluentd服务。参数`-c`指定了配置文件的位置,而`-vv`则提供了详

0

0