XGBoost模型诊断与优化:确保稳定与高效的模型运行

发布时间: 2024-09-30 13:20:46 阅读量: 53 订阅数: 22

人工智能和机器学习之回归算法:XGBoost回归:XGBoost的可解释性与模型诊断.docx

# 1. XGBoost模型简介与安装配置

XGBoost(eXtreme Gradient Boosting)是目前非常流行的机器学习模型之一,以其出色的性能和稳定性在数据科学竞赛和工业界广泛应用。它是基于梯度提升决策树(Gradient Boosting Decision Tree,GBDT)算法的实现,但是在速度、可扩展性、以及灵活性上有显著的改进。

在本章节中,我们将介绍XGBoost的基本概念,并对如何在计算机上安装和配置XGBoost环境进行深入的探讨。XGBoost支持多种编程语言,其中Python和R是最常用的。以下是Python版本的XGBoost安装步骤:

1. 打开命令行界面,输入以下命令进行安装:

```bash

pip install xgboost

```

2. 验证安装是否成功,通过导入XGBoost库并检查其版本信息:

```python

import xgboost as xgb

print(xgb.__version__)

```

为了确保XGBoost的正确安装和配置,建议进行简单的测试运行,这样可以保证后续章节中模型的训练与验证工作能够顺利进行。安装XGBoost后,您将准备好进入第二章,学习XGBoost的核心理论和原理。

# 2. XGBoost模型的核心理论

### 2.1 梯度提升决策树算法基础

#### 2.1.1 梯度提升的原理与应用

梯度提升(Gradient Boosting)是一种集成学习方法,它通过逐步添加基学习器(通常是决策树)来构建强学习器。与随机森林等并行学习方法不同,梯度提升的每一步都是通过解决损失函数的梯度下降问题来实现的。

一个典型的梯度提升模型如图所示:

```mermaid

graph TD;

A[开始] --> B[初始化模型]

B --> C[计算残差]

C --> D[拟合基学习器]

D --> E[更新模型]

E --> F{是否满足停止条件}

F --> |是| G[结束]

F --> |否| C

```

梯度提升的关键在于如何精确地拟合上一步的残差,这通常通过添加一个新树来实现。这种方法在多种任务中都有出色的表现,如回归、分类以及非参数建模等。

```python

from sklearn.ensemble import GradientBoostingClassifier

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 生成模拟数据

X, y = make_classification(n_samples=1000, n_features=4, random_state=0)

# 划分数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=0)

# 初始化梯度提升分类器

gb_clf = GradientBoostingClassifier(n_estimators=10, learning_rate=0.1, max_depth=1, random_state=0)

# 训练模型

gb_clf.fit(X_train, y_train)

# 预测

predictions = gb_clf.predict(X_test)

# 评估模型

print("Accuracy: {:.2f}%".format(accuracy_score(y_test, predictions) * 100))

```

#### 2.1.2 决策树的构建过程

在XGBoost中,每棵树的构建过程是有序的,通过利用前一棵树的预测结果来指导下一棵树的构建。简单来说,XGBoost使用损失函数的负梯度作为拟合数据的目标,即通过最小化损失函数的梯度来构建每棵树。

```python

import xgboost as xgb

import numpy as np

# 模拟数据

X = np.random.rand(100, 10)

y = np.random.rand(100, )

# 定义损失函数

def loss(y_true, y_pred):

return np.mean((y_true - y_pred) ** 2)

# 计算梯度和二阶导数

y_pred = np.zeros_like(y)

g = (y - y_pred)

h = np.zeros_like(y)

for i in range(len(y)):

g[i] = loss(y[i], y_pred[i])

h[i] = loss(y[i], y_pred[i]) + 1

# 初始化树结构

tree = {'leaf': []}

# 构建决策树

def build_tree(x, g, h):

# 寻找最佳分割点

best_split = (0, np.inf, np.inf, -np.inf)

for i, xi in enumerate(x):

for j in range(10):

left_g, left_h, right_g, right_h = g.copy(), h.copy()

for split_point in np.linspace(xi.min(), xi.max(), 10):

idx_left = xi < split_point

idx_right = xi >= split_point

left_g[idx_left] = g[idx_left].sum()

left_h[idx_left] = h[idx_left].sum()

right_g[idx_right] = g[idx_right].sum()

right_h[idx_right] = h[idx_right].sum()

score = (left_g**2 / left_h).sum() + (right_g**2 / right_h).sum()

if score < best_split[3]:

best_split = (i, j, split_point, score)

return best_split

# 在最佳分割点构建树

split = build_tree(X, g, h)

if split != (0, np.inf, np.inf, -np.inf):

node_idx, feature_idx, split_point, score = split

tree['leaf'].append(split)

left_mask = X[:, feature_idx] < split_point

right_mask = ~left_mask

y_pred[left_mask] += 1

y_pred[right_mask] -= 1

g[left_mask] = (y[left_mask] - y_pred[left_mask]).sum()

g[right_mask] = (y[right_mask] - y_pred[right_mask]).sum()

h[left_mask] = (y[left_mask] - y_pred[left_mask]).sum()

h[right_mask] = (y[right_mask] - y_pred[right_mask]).sum()

build_tree(X[left_mask], g[left_mask], h[left_mask])

build_tree(X[right_mask], g[right_mask], h[right_mask])

# 打印构建的树结构

print(tree)

```

在这个简化的例子中,我们构建了一个决策树来最小化损失函数。真实的XGBoost实现更为复杂,但这个例子展示了如何通过损失函数的梯度来指导决策树的构建。

# 3. XGBoost模型诊断技巧

在机器学习模型开发中,模型诊断是一个关键步骤,它涉及到识别和解决模型可能存在的问题,如过拟合、欠拟合以及特征重要性评估等。掌握这些诊断技巧可以帮助开发者提升模型性能,优化预测结果。

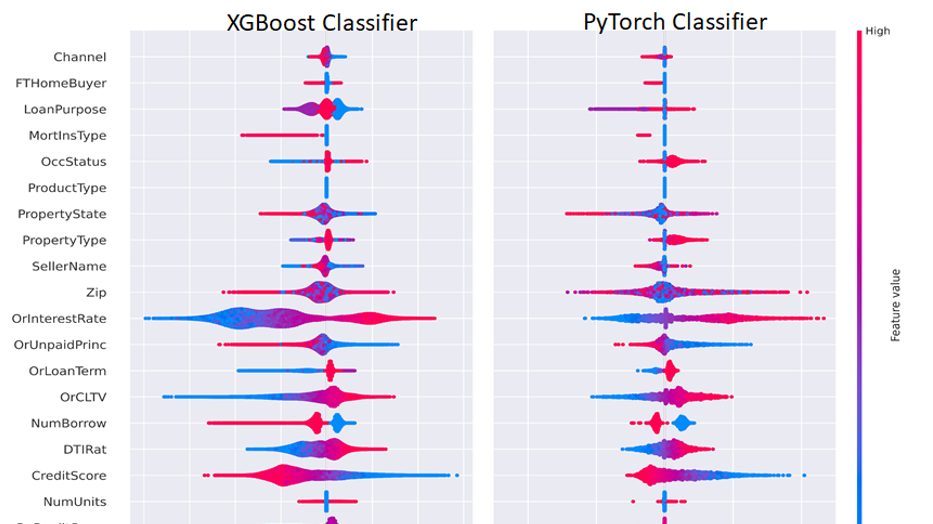

## 特征重要性分析

### 特征重要性的评估方法

特征重要性是指在模型中,各个特征对于最终预测结果的贡献程度。在XGBoost中,有多种方法可以用来评估特征的重要性。

一种常用的方法是基于模型中的分数(gain)来评估。在XGBoost中,每个特征在每次分割中都有一个分数,这个分数反映了该分割对模型性能的提升。通过对所有树的分割进行累加,可以得到每个特征的总分数,分数越高,表示该特征越重要。

另一种方法是根据特征出现的次数来评估,即在所有树中,某个特征作为分割点出现的频率。这个频率也可以作为特征重要性的一个度量。

### 特征选择和降维技巧

通过特征重要性分析,可以识别出对模型贡献最大的特征,并可能剔除掉一些不重要的特征,这个过程称为特征选择。特征选择有多种方法:

- 基于阈值的选择:设定一个阈值,只保留重要性超过该阈值的特征。

- 递归特征消除(RFE):从所有特征开始,逐步剔除特征重要性最低的特征,然后重新训练模型,直到达到某个条件为止。

特征选择可以简化模型,减少过拟合的风险,同时可能提高模型的预测速度。

```python

import xgboost as xgb

# 加载数据集

data = xgb.DMatrix('data.csv')

# 定义模型参数

params = {

'max_depth': 6,

'min_child_weight': 1,

```

0

0