XGBoost特征工程全攻略:打造更强大的预测模型

发布时间: 2024-09-30 12:53:56 阅读量: 42 订阅数: 45

# 1. XGBoost特征工程概述

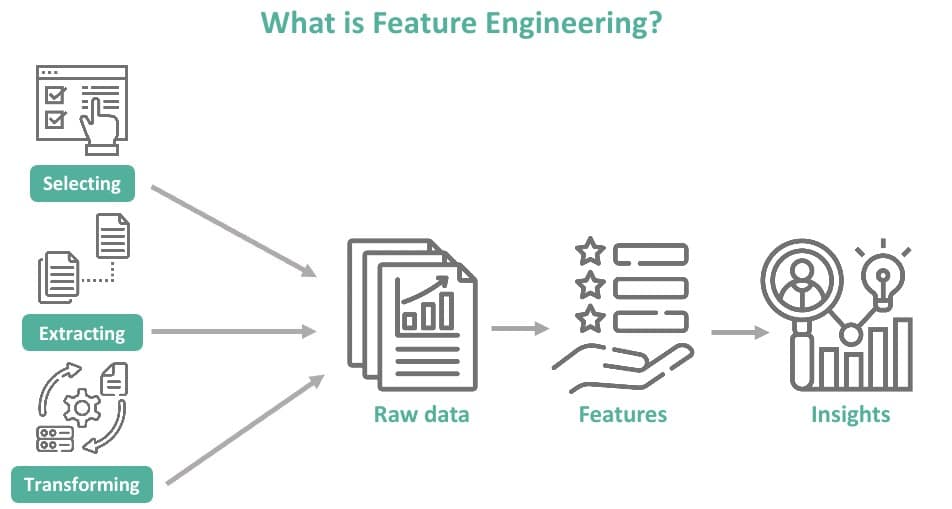

## 1.1 特征工程的重要性

特征工程是机器学习中的核心步骤,它对模型性能的提升有着至关重要的影响。在使用XGBoost等集成学习算法时,合理的特征工程能够使模型更准确地捕捉数据的内在规律,提高预测的准确度。不同于传统的机器学习模型,XGBoost提供了一系列内置的特征选择和处理工具,但人工干预和优化依然是提升模型性能的关键。

## 1.2 XGBoost简介

XGBoost(eXtreme Gradient Boosting)是一种基于梯度提升树算法的高效实现。该算法在众多数据科学竞赛中因其出色的性能而倍受欢迎。它利用二阶导数的信息,通过迭代地添加树来减少损失函数,构建出一个强大的预测模型。XGBoost不仅提供了正则化项来防止模型过拟合,还提供了对缺失值处理、剪枝、并行计算等高级功能的支持。

## 1.3 特征工程在XGBoost中的应用

在XGBoost中,特征工程是通过选择合适的特征和对特征进行转换来提高模型的预测性能。特征的选择不仅影响模型的泛化能力,而且也关系到模型训练的效率。此外,特征的表示形式和范围对模型的收敛速度和最终的预测效果均有显著的影响。XGBoost提供了一系列的特征选择和处理方法,通过精心设计的特征工程策略,可以使得XGBoost模型更好地从数据中学习,从而在各种机器学习任务中达到更优的性能。

# 2. 数据预处理与探索性分析

### 2.1 数据清洗与预处理

在机器学习项目中,数据预处理是一个至关重要的步骤。它不仅涉及确保数据的质量,而且可以显著改善模型的性能。

#### 2.1.1 缺失值处理方法

缺失值是数据集中常见的问题,可能由多种原因导致,包括数据未收集、错误、丢失或其他原因。处理缺失值的方法包括:

- **删除含有缺失值的记录**:当数据集很大且缺失值占比较小时,可以考虑删除这些记录。

- **填充缺失值**:可以通过均值、中位数、众数或特定值填充。对于数值型数据,使用均值或中位数填充较为常见;对于分类数据,使用众数填充比较合适。

- **预测缺失值**:利用回归、k-最近邻或其他预测模型来估算缺失值。

- **使用算法适应性**:某些算法(如决策树)能够处理含有缺失值的数据,可以利用这些算法来避免显式的处理。

在Python中,可以使用pandas库进行缺失值的处理。以下是一个简单的代码示例:

```python

import pandas as pd

# 创建一个含有缺失值的DataFrame

data = pd.DataFrame({

'A': [1, 2, 3, None],

'B': [4, None, 6, 7]

})

# 显示数据集

print(data)

# 删除含有缺失值的行

data_cleaned = data.dropna()

# 使用均值填充数值型数据的缺失值

data_filled = data.fillna(data.mean())

# 使用众数填充分类数据的缺失值

mode_value = data['B'].mode()[0]

data_filled['B'] = data['B'].fillna(mode_value)

print(data_cleaned)

print(data_filled)

```

#### 2.1.2 异常值检测与处理

异常值是数据集中偏离正常范围的值,它们可能由错误或非典型的事件造成。检测和处理异常值对于保持数据的质量至关重要。

- **标准差方法**:根据均值和标准差来识别异常值。

- **箱形图(Boxplot)**:根据四分位数范围来确定异常值。

- **Z-score方法**:使用Z-score值识别异常值。

处理异常值通常包括:

- **删除异常值**:如果数据量足够大,删除异常值可以是一个简单有效的方法。

- **修正异常值**:基于数据的分布和上下文进行合理的调整。

- **保留异常值**:在某些情况下,异常值可能具有分析价值,应该保留。

```python

import numpy as np

import seaborn as sns

import matplotlib.pyplot as plt

# 创建一个含有异常值的DataFrame

np.random.seed(1)

data = pd.DataFrame({

'A': np.random.randn(100).cumsum()

})

# 添加一个异常值

data.loc[90] = data.loc[90] + 30

# 绘制箱形图识别异常值

plt.figure(figsize=(10, 5))

sns.boxplot(y=data['A'])

plt.show()

# 删除异常值

data = data[data['A'] <= data['A'].quantile(0.99) * 1.5]

# 显示处理后的数据

print(data.describe())

```

### 2.2 探索性数据分析(EDA)

#### 2.2.1 数据分布的可视化

探索性数据分析的目的是使用图表和图形来发现数据的模式和趋势。可视化是快速了解数据分布的关键方法。

- **直方图**:展示数据分布。

- **箱形图**:展示数据的四分位数,帮助识别异常值。

- **散点图**:分析两个变量之间的关系。

```python

# 使用直方图展示数据分布

plt.figure(figsize=(10, 5))

sns.histplot(data['A'], kde=True)

plt.title('Data Distribution of Column A')

plt.show()

# 使用散点图分析两个变量之间的关系

# 假设我们有两个变量的数据

data['B'] = data['A'] + np.random.randn(100).cumsum()

sns.scatterplot(x='A', y='B', data=data)

plt.title('Relationship Between A and B')

plt.show()

```

#### 2.2.2 特征间相关性的分析

分析特征之间的相关性可以帮助我们发现哪些特征可能对模型训练有帮助,或者哪些特征是冗余的。

- **皮尔逊相关系数**:用于评估两个连续变量之间的线性相关性。

- **斯皮尔曼等级相关系数**:用于评估两个变量之间的单调关系。

```python

# 计算相关系数矩阵

corr_matrix = data.corr()

# 绘制热图展示相关性

plt.figure(figsize=(8, 6))

sns.heatmap(corr_matrix, annot=True, cmap='coolwarm')

plt.title('Correlation Matrix Heatmap')

plt.show()

```

### 2.3 特征编码与转换

#### 2.3.1 独热编码与标签编码

在将数据输入到模型之前,对于分类数据进行编码是必不可少的步骤。独热编码(One-Hot Encoding)和标签编码(Label Encoding)是两种常见的编码方法。

- **独热编码**:为每个类别创建一个新列,类别对应的值为1,其他为0。

- **标签编码**:将类别值映射为整数。

```python

from sklearn.preprocessing import OneHotEncoder, LabelEncoder

# 假设有一个分类特征

category_feature = ['cat', 'dog', 'fish', 'cat', 'dog', 'cat']

# 标签编码

label_encoder = LabelEncoder()

encoded = label_encoder.fit_transform(category_feature)

print('Label Encoding:', encoded)

# 独热编码

onehot_encoder = OneHotEncoder()

category_feature = np.array(category_feature).reshape(-1, 1)

encoded = onehot_encoder.fit_transform(category_feature)

encoded_df = pd.DataFrame(encoded.toarray(), columns=onehot_encoder.get_feature_names_out(['category']))

print('One-Hot Encoding:\n', encoded_df)

```

#### 2.3.2 特征缩放方法

特征缩放对于提高机器学习模型的性能至关重要。常见的特征缩放方法包括:

- **标准化(Standardization)**:通过减去均值,然后除以标准差进行缩放。

- **归一化(Normalization)**:将特征缩放到0到1之间的值。

```python

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 假设有数值型特征

numerical_feature = [10, 5, 20, 3, 50]

# 标准化缩放

scaler_standard = StandardScaler()

numerical_feature_scaled = scaler_standard.fit_transform(np.array(numerical_feature).reshape(-1, 1))

print('Standardization:\n', numerical_feature_scaled)

# 归一化缩放

scaler_minmax = MinMaxScaler()

numerical_feature_scaled = scaler_minmax.fit_transform(np.array(numerical_feature).reshape(-1, 1))

print('Normalization:\n', numerical_feature

```

0

0