【理论深化】:破解GAN收敛难题:从理论到实践的深度解析

发布时间: 2024-09-01 14:58:45 阅读量: 96 订阅数: 79

R中的深度学习实践:从入门到应用详解

# 1. 生成对抗网络(GAN)简介

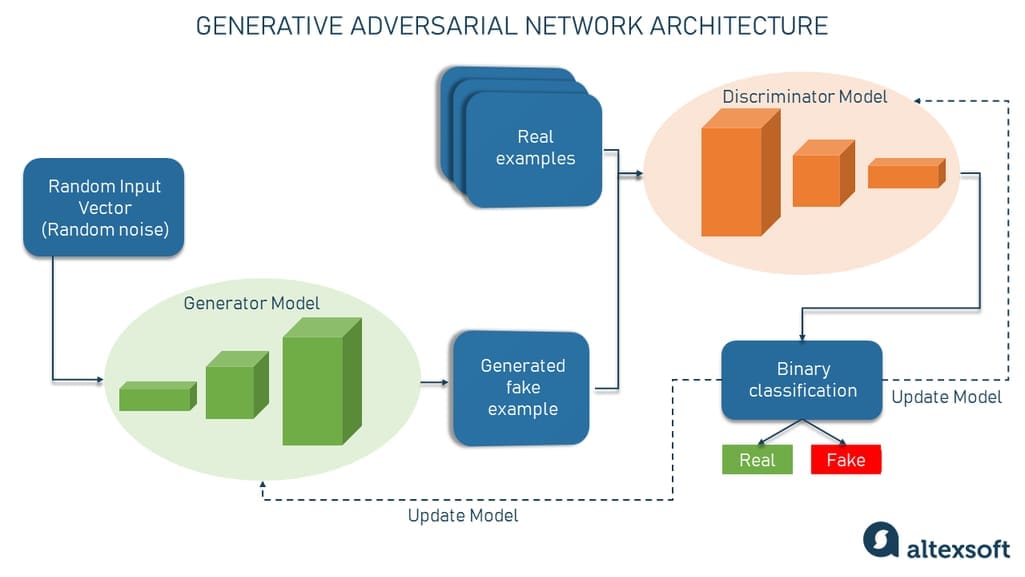

生成对抗网络(GAN)是近年来深度学习领域的一个重要突破。它由两部分组成:生成器和判别器。生成器的目的是生成与真实数据尽可能相似的数据,而判别器的目的是尽可能准确地识别出生成的数据和真实数据。两者相互对抗,共同推动模型的进步。

## 1.1 GAN的基本组成与工作原理

GAN的训练过程可以理解为一个"造假者"和一个"警察"的博弈。"造假者"不断尝试制造更逼真的假数据,而"警察"则尝试更准确地区分真假数据。在这个过程中,两者的能力都得到提升,最终生成的数据质量也越来越高。

## 1.2 GAN的应用领域

GAN的应用非常广泛,包括图像生成、图像编辑、图像超分辨率、数据增强等。它甚至可以用于生成艺术作品,为艺术家和设计师提供无限可能。此外,GAN在医学、游戏开发、自然语言处理等领域也有着巨大的潜力。

## 1.3 GAN的优势与挑战

GAN的最大优势在于其强大的生成能力,它能够生成高度逼真的数据,而且不需要大量的标注数据。然而,GAN也面临着一些挑战,如模式崩溃、训练不稳定等问题。这些问题的解决需要深入理解GAN的原理和机制。

# 2. GAN理论基础与数学原理

## 2.1 GAN的基本概念和组成

### 2.1.1 生成器与判别器的互动机制

生成对抗网络(GAN)由两部分核心组成:生成器(Generator)和判别器(Discriminator)。生成器的任务是从随机噪声中创造出看似真实的数据,而判别器的任务则是区分生成数据与真实数据。

生成器的训练依赖于判别器的反馈。在训练过程中,生成器不断生成数据,判别器评估其真实性,并给予反馈。生成器利用判别器提供的信息不断调整参数,以提升生成数据的质量。

为了理解生成器和判别器的互动,我们可以将其比作一场对抗游戏。在这个游戏中,生成器和判别器互相竞争,相互促进,直至达到一种平衡状态,此时生成器能够生成与真实数据几乎无法区分的数据,而判别器无法有效区分生成数据和真实数据。

```python

# 以下是一个简化的GAN模型的代码示例

# 导入必要的库

from keras.layers import Input, Dense, Reshape, Flatten, Dropout

from keras.layers import BatchNormalization, Activation, LeakyReLU

from keras.layers.advanced_activations import LeakyReLU

from keras.models import Sequential, Model

from keras.optimizers import Adam

# 生成器和判别器的架构定义

def build_generator(z_dim):

model = Sequential()

# 此处添加网络层

return model

def build_discriminator(img_shape):

model = Sequential()

# 此处添加网络层

return model

# 模型的构建与编译

z_dim = 100

img_shape = (28, 28, 1) # 以MNIST数据集为例

generator = build_generator(z_dim)

discriminator = build_discriminator(img_shape)

# 判别器训练时只训练判别器的权重,生成器的权重设置为不可训练

discriminator.trainable = False

# 接下来定义GAN模型

z = Input(shape=(z_dim,))

img = generator(z)

valid = discriminator(img)

combined = Model(z, valid)

***pile(loss='binary_crossentropy', optimizer=Adam(0.0002, 0.5))

# 训练时的逻辑

# 此处省略具体的训练代码,但一般包括批量生成假数据和真数据,然后对判别器进行训练,接着固定判别器参数训练生成器,如此循环

```

### 2.1.2 损失函数与优化目标

GAN的训练目标是使得生成器和判别器的性能尽可能接近,这通常表示为一个极小极大(minimax)问题。在理想情况下,当生成器和判别器达到纳什均衡时,生成器产生的数据将无法被判别器有效区分。

在数学上,GAN的损失函数通常定义为交叉熵损失函数,用于衡量生成数据与真实数据之间的差异。判别器的损失函数最小化真实数据被识别为真的概率与生成数据被识别为真的概率之间的差距。相应地,生成器的损失函数最小化生成数据被识别为真的概率。

```python

# GAN的损失函数可以采用以下形式

# 对于判别器

def discriminator_loss(real_output, fake_output):

real_loss = binary_crossentropy(tf.ones_like(real_output), real_output)

fake_loss = binary_crossentropy(tf.zeros_like(fake_output), fake_output)

total_loss = real_loss + fake_loss

return total_loss

# 对于生成器

def generator_loss(fake_output):

return binary_crossentropy(tf.ones_like(fake_output), fake_output)

```

训练GAN时,我们通常需要对判别器和生成器交替进行训练,直到模型收敛。在实践中,这个过程可能需要大量的迭代和调参才能达到理想效果。

## 2.2 GAN的数学模型解析

### 2.2.1 概率分布与采样理论

为了理解GAN如何工作,需要先了解概率分布的概念。在GAN中,生成器从一个潜在空间(通常是一个多维高斯分布)采样,然后通过神经网络映射到数据空间。判别器则试图区分这些由生成器产生的数据和真实数据。

采样理论是研究如何从概率分布中抽取样本的一系列理论。在GAN中,生成器的采样过程需要能够捕捉到真实数据分布的关键特性,从而产生高质量的合成数据。为了实现这一点,生成器需要在训练过程中不断学习真实数据分布的结构。

数学上,我们可以把生成器的采样过程表示为一个映射函数 \(G: Z \rightarrow X\),其中 \(Z\) 是潜在空间,\(X\) 是数据空间。这个过程是通过神经网络参数化的,参数 \(\theta_G\) 将潜在变量 \(z\) 映射到数据 \(x\)。

### 2.2.2 泛化能力与模型容量

泛化能力是机器学习模型根据训练数据预测未见数据的能力。GAN的泛化能力对于生成逼真数据至关重要。模型容量指的是模型能够拟合数据的复杂性,过低的模型容量可能导致欠拟合,而过高的模型容量可能导致过拟合。

在GAN中,泛化能力和模型容量受到生成器和判别器架构的影响。太简单的模型可能无法捕捉到数据的真实分布,而太复杂的模型可能在训练数据上过拟合,导致泛化性能下降。

为了平衡模型的容量和泛化能力,通常需要仔细设计网络架构,可能还需要引入正则化技术,比如Dropou

0

0