:神经网络激活函数:探索不同激活函数的特性和应用(深入研究)

发布时间: 2024-07-11 14:43:31 阅读量: 89 订阅数: 35

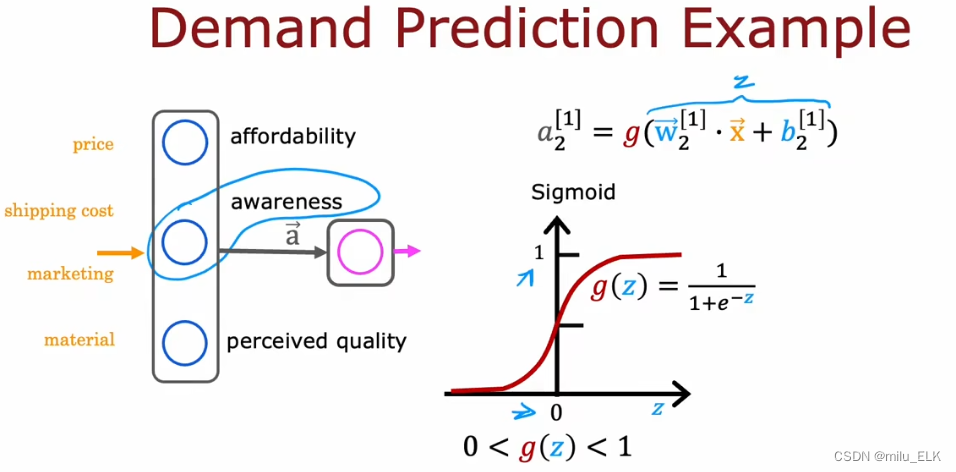

# 1. 神经网络激活函数概述

神经网络激活函数是神经网络中用于将神经元输入转换为输出的数学函数。它们在神经网络的学习和预测过程中扮演着至关重要的角色。激活函数的类型和特性直接影响着神经网络的性能和收敛性。在这一章中,我们将概述激活函数的基本概念,并介绍其在神经网络中的作用。

# 2. 激活函数的理论基础

### 2.1 激活函数的类型和特性

激活函数是神经网络中用于引入非线性关系的关键组件。它们决定了神经元输出的信号如何随输入信号的变化而变化。激活函数的类型和特性对于神经网络的性能至关重要。

#### 2.1.1 线性激活函数

线性激活函数以恒定的斜率将输入信号映射到输出信号。最常见的线性激活函数是恒等函数,它简单地将输入信号传递到输出。

**恒等函数:**

```

f(x) = x

```

**特性:**

* 线性关系:输出与输入成正比。

* 可导且导数为 1。

* 不引入非线性。

#### 2.1.2 非线性激活函数

非线性激活函数引入非线性关系,允许神经网络学习复杂模式。它们将输入信号映射到一个非线性的输出,从而使神经网络能够对复杂输入进行建模。

**常见的非线性激活函数:**

* **Sigmoid 函数:**将输入映射到 0 到 1 之间的 S 形曲线。

* **ReLU 函数:**将输入映射到正值或 0。

* **Leaky ReLU 函数:**将输入映射到正值或输入的线性函数。

**特性:**

* 非线性关系:输出与输入之间存在非线性关系。

* 可导:导数不为常数。

* 引入非线性,允许神经网络学习复杂模式。

### 2.2 激活函数的数学性质

激活函数的数学性质对于理解神经网络的行为至关重要。这些性质包括导数、可微性和收敛性。

#### 2.2.1 导数和可微性

激活函数的导数表示输出信号相对于输入信号的变化率。可微性是指激活函数在所有点都具有导数。

**导数:**

```

f'(x) = df/dx

```

**可微性:**

* 可微激活函数在所有点都具有导数。

* 不可微激活函数在某些点没有导数。

#### 2.2.2 激活函数的收敛性

激活函数的收敛性是指输出信号在输入信号趋于无穷大或无穷小时的行为。收敛性对于确保神经网络的稳定性和训练收敛至关重要。

**收敛性:**

* **有界收敛:**输出信号在输入信号趋于无穷大或无穷小时都保持在有限范围内。

* **无界收敛:**输出信号在输入信号趋于无穷大或无穷小时趋于无穷大或无穷小。

# 3. 常见激活函数的应用

### 3.1 Sigmoid激活函数

#### 3.1.1 Sigmoid函数的特性和应用

Sigmoid函数,又称逻辑函数,是一种常用的非线性激活函数,其数学表达式为:

```

f(x) = 1 / (1 + exp(-x))

```

Sigmoid函数的输出范围为(0, 1),具有以下特性:

* 非线性:Sigmoid函数是非线性的,这意味着它可以将线性不可分的数据映射到非线性空间。

* 平滑:Sigmoid函数是连续可微的,这使其易于优化。

* 单调递增:Sigmoid函数是单调递增的,这使其适合于二分类任务。

Sigmoid函数广泛应用于二分类任务,如逻辑回归和神经网络中的输出层。

#### 3.1.2 Sigmoid函数的局限性

尽管Sigmoid函数具有广泛的应用,但它也存在一些局限性:

* 梯度消失:当输入值较大或较小时,Sigmoid函数的导数会变得很小,导致梯度消失问题。

* 计算复杂:Sigmoid函数的计算涉及指数运算,这使其计算复杂度较高。

### 3.2 ReLU激活函数

#### 3.2.1 ReLU函数的特性和应用

ReLU(Rectified Linear Unit)激活函数是一种非线性激活函数,其数学表达式为:

```

f(x) = max(0, x)

```

ReLU函数的输出范围为[0, ∞),具有以下特性:

* 非线性:ReLU函数是非线性的,可以将线性不可分的数据映射到非线性空间。

* 简单高效:ReLU函数的计算非常简单,仅涉及一个比较操作。

* 避免梯度消失:ReLU函数在正输入区域的导数为1,避免了梯度消失问题。

ReLU函数广泛应用于图像分类、自然语言处理等任务,是目前最常用的激活函数之一。

#### 3.2.2 ReLU函数的变体

为了解决ReLU函数在

0

0