【揭秘神经网络架构:剖析不同网络结构的优缺点】

发布时间: 2024-07-11 14:24:07 阅读量: 74 订阅数: 44

教你看懂各种神经网络

# 1. 神经网络基础**

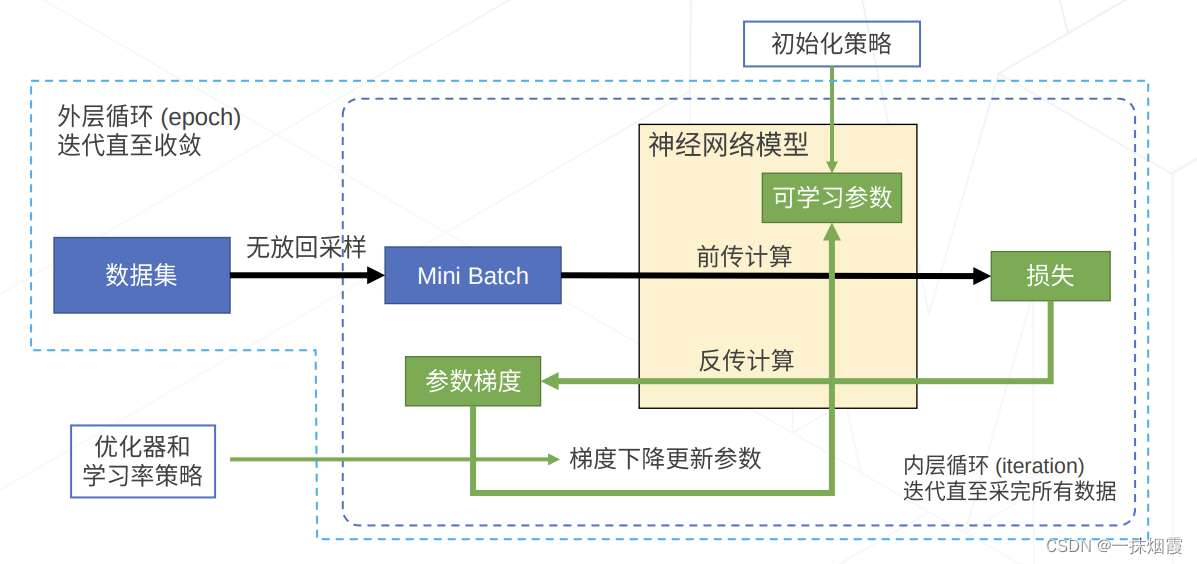

神经网络是一种机器学习模型,它受到人类大脑结构和功能的启发。它由大量相互连接的节点(称为神经元)组成,这些神经元排列成层。神经网络通过学习输入数据的模式和特征,从数据中提取知识。

神经网络的训练过程涉及调整神经元之间的连接权重,以最小化预测输出与实际输出之间的误差。通过反复迭代,神经网络可以优化其权重,从而提高其对数据的预测能力。

# 2.1 卷积神经网络(CNN)

### 2.1.1 CNN的基本原理

卷积神经网络(CNN)是一种深度神经网络,专为处理具有网格状结构的数据(如图像)而设计。CNN的核心思想是利用卷积运算来提取数据的局部特征。

**卷积运算:** 卷积运算是一种数学操作,用于将一个卷积核(一个小矩阵)与输入数据(一个矩阵)滑动相乘,从而产生一个特征图。卷积核的大小和形状决定了提取的特征的类型。

**池化:** 池化是一种降采样技术,用于减少特征图的大小。池化操作通过将特征图中的相邻元素组合成一个单一元素来实现,从而降低了计算成本并提高了特征的鲁棒性。

### 2.1.2 CNN的层级结构

CNN通常由以下层级结构组成:

**卷积层:** 卷积层负责提取输入数据的局部特征。每个卷积层包含多个卷积核,每个卷积核提取特定类型的特征。

**池化层:** 池化层用于减少特征图的大小并提高特征的鲁棒性。池化层通常使用最大池化或平均池化操作。

**全连接层:** 全连接层将卷积层和池化层提取的特征转换为最终输出。全连接层通常使用softmax激活函数来生成分类概率。

**代码示例:**

```python

import tensorflow as tf

# 定义输入图像

input_image = tf.keras.Input(shape=(28, 28, 1))

# 定义卷积层

conv1 = tf.keras.layers.Conv2D(32, (3, 3), activation='relu')(input_image)

# 定义池化层

pool1 = tf.keras.layers.MaxPooling2D((2, 2))(conv1)

# 定义全连接层

fc1 = tf.keras.layers.Dense(128, activation='relu')(pool1)

output = tf.keras.layers.Dense(10, activation='softmax')(fc1)

# 构建模型

model = tf.keras.Model(input_image, output)

# 逻辑分析:

# 卷积层conv1使用3x3的卷积核提取输入图像的局部特征,激活函数为ReLU。

# 池化层pool1使用2x2的最大池化操作降低特征图的大小。

# 全连接层fc1将提取的特征转换为128维的向量,激活函数为ReLU。

# 全连接层output将128维的向量转换为10维的分类概率,激活函数为softmax。

```

# 3. 神经网络架构实践

### 3.1 图像分类任务

#### 3.1.1 CNN在图像分类中的应用

CNN在图像分类任务中取得了卓越的性能。其基本原理是利用卷积操作提取图像特征,再通过池化操作减少特征图的尺寸,从而获得具有平移不变性的特征表示。

#### 3.1.2 CNN模型的优化和调参

为了提高CNN模型的性能,需要进行模型优化和调参。常见的优化策略包括:

- **数据增强:**通过随机裁剪、翻转和旋转等操作,增加训练数据集的多样性,提高模型的泛化能力。

- **正则化:**使用L1或L2正则化项,防止模型过拟合。

- **学习率衰减:**随着训练的进行,逐渐降低学习率,使模型在训练后期更稳定地收敛。

调参方面,需要调整超参数,如学习率、批次大小和网络结构。可以通过网格搜索或贝叶斯优化等方法,找到最优超参数组合。

### 3.2 自然语言处理任务

#### 3.2.1 RNN在自然语言处理中的应用

RNN是一种序列模型,特别适用于处理时序数据。在自然语言处理中,RNN被广泛用于文本分类、机器翻译和问答系统等任务。

#### 3.2.2 Transformer在自然语言处理中的应用

Transformer是一种基于注意力机制的模型,能够捕捉文本中的长距离依赖关系。在自然语言处理中,Transformer取得了比RNN更好的性能,尤其是在机器翻译和问答系统等任务中。

### 3.3 时序预测任务

#### 3.3.1 RNN在时序预测中的应用

RNN能够处理时序数据,因此在时序预测任务中得到了广泛应用。例如,RNN可以用于预测股票价格、天气变化和交通流量等。

#### 3.3.2 Transformer在时序预测中的应用

Transformer也可以用于时序预测任务。与RNN相比,Transformer具有并行化的优势,能够更有效地处理长序列数据。

# 4. RNN、Transformer 的优缺点对比

在本章节中,我们将对 CNN、RNN 和 Transformer 这三种神经网络架构进行优缺点对比,以帮助读者深入了解它们的特性和适用场景。

### 4.1.1 优点对比

| 特性 | CNN | RNN | Transformer |

|---|---|---|---|

| 空间特征提取 | 优秀 | 较弱 | 较弱 |

| 时序特征提取 | 较弱 | 优秀 | 优秀 |

| 并行计算 | 容易 | 困难 | 容易 |

| 记忆能力 | 短期 | 长期 | 长期 |

| 适用场景 | 图像处理、计算机视觉 | 自然语言处理、语音识别 | 自然语言处理、机器翻译 |

### 4.1.2 缺点对比

| 特性 | CNN | RNN | Transformer |

|---|---|---|---|

| 计算量 | 大 | 大 | 非常大 |

| 参数量 | 大 | 大 | 非常大 |

| 训练时间 | 长 | 长 | 非常长 |

| 梯度消失/爆炸 | 容易出现 | 容易出现 | 不容易出现 |

| 适用数据类型 | 结构化数据 | 序列数据 | 序列数据 |

### 4.1.3 适用场景对比

| 任务类型 | CNN | RNN | Transformer |

|---|---|---|---|

| 图像分类 | 非常适合 | 不适合 | 不适合 |

| 自然语言处理 | 不适合 | 非常适合 | 非常适合 |

| 时序预测 | 不适合 | 非常适合 | 非常适合 |

| 机器翻译 | 不适合 | 不适合 | 非常适合 |

### 4.1.4 总结

CNN、RNN 和 Transformer 是三种不同的神经网络架构,各有其优缺点和适用场景。CNN 擅长提取空间特征,RNN 擅长提取时序特征,Transformer 擅长提取序列特征。在选择神经网络架构时,需要考虑任务类型、数据类型和计算资源等因素。

# 5. 神经网络架构优化

神经网络模型在实际应用中往往面临着计算资源受限、部署成本高昂等问题。为了解决这些问题,需要对神经网络架构进行优化,以降低模型复杂度,提高模型效率。本章将介绍神经网络架构优化常用的技术,包括模型压缩和剪枝、量化和二值化、并行化和分布式训练。

### 5.1 模型压缩和剪枝

模型压缩和剪枝技术通过减少模型参数和层数来降低模型复杂度。

**5.1.1 模型压缩**

模型压缩是指通过减少模型参数的数量来降低模型大小。常用的模型压缩方法包括:

- **知识蒸馏:**将训练好的大型模型的知识转移到较小的模型中,从而实现较小的模型具有与大型模型相似的性能。

- **剪枝:**移除模型中不重要的参数和层,从而减少模型大小。

- **量化:**将模型参数从浮点数转换为低精度数据类型,例如int8或int16,从而减少模型大小。

**代码块:**

```python

import tensorflow as tf

# 创建一个模型

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(100, activation='relu'),

tf.keras.layers.Dense(50, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 压缩模型

compressed_model = tf.keras.models.model_to_sparse(model)

# 评估压缩后的模型

compressed_model.evaluate(x_test, y_test)

```

**逻辑分析:**

该代码示例演示了如何使用TensorFlow中的`model_to_sparse()`函数对模型进行压缩。`model_to_sparse()`函数通过移除模型中的零权重来创建稀疏模型,从而减少模型大小。

**5.1.2 模型剪枝**

模型剪枝是指移除模型中不重要的层和连接。常用的模型剪枝方法包括:

- **过滤器剪枝:**移除卷积神经网络中的不重要过滤器。

- **神经元剪枝:**移除全连接神经网络中的不重要神经元。

- **连接剪枝:**移除模型中不重要的连接。

**代码块:**

```python

import tensorflow as tf

# 创建一个模型

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(100, activation='relu'),

tf.keras.layers.Dense(50, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 剪枝模型

pruned_model = tf.keras.models.prune_low_magnitude(model, 0.5)

# 评估剪枝后的模型

pruned_model.evaluate(x_test, y_test)

```

**逻辑分析:**

该代码示例演示了如何使用TensorFlow中的`prune_low_magnitude()`函数对模型进行剪枝。`prune_low_magnitude()`函数通过移除权重幅度较小的参数来剪枝模型,从而减少模型复杂度。

### 5.2 量化和二值化

量化和二值化技术通过降低模型参数的精度来降低模型复杂度。

**5.2.1 量化**

量化是指将模型参数从浮点数转换为低精度数据类型,例如int8或int16。量化可以显著减少模型大小,同时保持模型的精度。

**代码块:**

```python

import tensorflow as tf

# 创建一个模型

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(100, activation='relu'),

tf.keras.layers.Dense(50, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 量化模型

quantized_model = tf.keras.models.quantize_model(model)

# 评估量化后的模型

quantized_model.evaluate(x_test, y_test)

```

**逻辑分析:**

该代码示例演示了如何使用TensorFlow中的`quantize_model()`函数对模型进行量化。`quantize_model()`函数通过将模型参数转换为int8数据类型来量化模型,从而减少模型大小。

**5.2.2 二值化**

二值化是指将模型参数转换为二进制值,即0或1。二值化可以进一步减少模型大小,但可能会降低模型的精度。

**代码块:**

```python

import tensorflow as tf

# 创建一个模型

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(100, activation='relu'),

tf.keras.layers.Dense(50, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 二值化模型

binarized_model = tf.keras.models.binarize_model(model)

# 评估二值化后的模型

binarized_model.evaluate(x_test, y_test)

```

**逻辑分析:**

该代码示例演示了如何使用TensorFlow中的`binarize_model()`函数对模型进行二值化。`binarize_model()`函数通过将模型参数转换为二进制值来二值化模型,从而进一步减少模型大小。

### 5.3 并行化和分布式训练

并行化和分布式训练技术通过利用多个计算设备来加速模型训练。

**5.3.1 并行化**

并行化是指在同一台机器上使用多个GPU或CPU并行训练模型。并行化可以显著缩短模型训练时间。

**代码块:**

```python

import tensorflow as tf

# 创建一个模型

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(100, activation='relu'),

tf.keras.layers.Dense(50, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 并行训练模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy')

model.fit(x_train, y_train, epochs=10, batch_size=32, use_multiprocessing=True)

```

**逻辑分析:**

该代码示例演示了如何使用TensorFlow中的`use_multiprocessing`参数来并行训练模型。`use_multiprocessing`参数指定是否使用多进程来并行训练模型,从而缩短训练时间。

**5.3.2 分布式训练**

分布式训练是指在多台机器上并行训练模型。分布式训练可以进一步缩短模型训练时间,并支持训练大型模型。

**代码块:**

```python

import tensorflow as tf

# 创建一个模型

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(100, activation='relu'),

tf.keras.layers.Dense(50, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 分布式训练模型

strategy = tf.distribute.MirroredStrategy()

with strategy.scope():

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy')

model.fit(x_train, y_train, epochs=10, batch_size=32)

```

**逻辑分析:**

该代码示例演示了如何使用TensorFlow中的`MirroredStrategy`来分布式训练模型。`MirroredStrategy`策略将模型的副本复制到多台机器上,并并行训练这些副本,从而缩短训练时间。

# 6. 神经网络架构创新

神经网络架构创新是神经网络领域的一个活跃的研究方向,旨在开发新的和改进的神经网络架构,以提高模型的性能、效率和通用性。以下是一些神经网络架构创新的关键方法:

### 6.1 混合神经网络架构

混合神经网络架构将不同类型的神经网络架构(例如 CNN、RNN 和 Transformer)结合起来,以利用不同架构的优势。例如,混合架构可以将 CNN 用于图像特征提取,将 RNN 用于序列建模,并将 Transformer 用于注意力机制。通过结合这些架构,混合神经网络可以实现更强大的性能,特别是在处理复杂任务时。

### 6.2 自适应神经网络架构

自适应神经网络架构能够根据输入数据或任务动态调整其架构。这可以通过使用元学习或强化学习技术来实现,这些技术允许神经网络在训练过程中学习其最佳架构。自适应神经网络架构可以提高模型的泛化能力,并使其能够适应不同的任务和数据集。

### 6.3 知识蒸馏和迁移学习

知识蒸馏是一种将知识从一个大型、复杂的神经网络(教师模型)转移到一个较小、更简单的神经网络(学生模型)的技术。通过蒸馏教师模型的知识,学生模型可以获得与教师模型相似的性能,同时具有更小的模型大小和更高的效率。迁移学习是一种将在一个任务上训练的神经网络应用于另一个相关任务的技术。通过迁移学习,神经网络可以利用其在第一个任务上学习的知识,从而更快、更有效地学习第二个任务。

### 代码示例:混合神经网络架构

```python

import tensorflow as tf

# 定义 CNN 模型

cnn_model = tf.keras.models.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Flatten()

])

# 定义 RNN 模型

rnn_model = tf.keras.models.Sequential([

tf.keras.layers.Embedding(1000, 128),

tf.keras.layers.LSTM(128, return_sequences=True),

tf.keras.layers.LSTM(128)

])

# 定义混合模型

mixed_model = tf.keras.models.Sequential([

cnn_model,

rnn_model,

tf.keras.layers.Dense(10, activation='softmax')

])

```

0

0