多头注意力机制与循环神经网络的对比:揭秘其异同与优势

发布时间: 2024-08-21 08:31:24 阅读量: 32 订阅数: 32

# 1. 多头注意力机制与循环神经网络概述

多头注意力机制和循环神经网络是自然语言处理和机器学习领域中两种重要的技术。多头注意力机制允许模型关注输入序列的不同部分,而循环神经网络可以处理序列数据并学习长期依赖关系。

本指南将提供多头注意力机制和循环神经网络的全面概述,包括它们的原理、应用和比较分析。通过对这些技术的深入理解,读者将能够利用它们来解决各种机器学习问题。

# 2. 多头注意力机制与循环神经网络的理论基础

### 2.1 多头注意力机制原理

#### 2.1.1 自注意力机制

自注意力机制是一种注意力机制,它允许模型关注输入序列中的不同部分。它通过计算输入序列中每个元素与自身和其他所有元素之间的相似性来实现。相似性分数通常使用点积或缩放点积计算。

**代码块:**

```python

import torch

import torch.nn as nn

class SelfAttention(nn.Module):

def __init__(self, embed_dim, num_heads):

super().__init__()

self.embed_dim = embed_dim

self.num_heads = num_heads

self.query = nn.Linear(embed_dim, embed_dim)

self.key = nn.Linear(embed_dim, embed_dim)

self.value = nn.Linear(embed_dim, embed_dim)

def forward(self, x):

# 计算查询、键和值

q = self.query(x)

k = self.key(x)

v = self.value(x)

# 计算注意力权重

attn_weights = torch.matmul(q, k.transpose(1, 2))

attn_weights = attn_weights / math.sqrt(self.embed_dim)

attn_weights = torch.softmax(attn_weights, dim=-1)

# 计算注意力输出

output = torch.matmul(attn_weights, v)

return output

```

**逻辑分析:**

* `query`、`key`和`value`是三个线性层,用于将输入嵌入转换为查询、键和值向量。

* `attn_weights`计算查询向量与键向量的点积,并应用缩放和softmax函数来获得注意力权重。

* 最后,注意力权重与值向量相乘,得到注意力输出。

#### 2.1.2 多头注意力机制

多头注意力机制是自注意力机制的扩展,它并行使用多个自注意力头。每个头计算不同的注意力权重,然后将这些权重连接起来形成最终的注意力输出。

**代码块:**

```python

import torch

import torch.nn as nn

class MultiHeadAttention(nn.Module):

def __init__(self, embed_dim, num_heads):

super().__init__()

self.embed_dim = embed_dim

self.num_heads = num_heads

self.attn_heads = nn.ModuleList([SelfAttention(embed_dim, num_heads) for _ in range(num_heads)])

def forward(self, x):

# 计算每个头的注意力输出

attn_outputs = [attn_head(x) for attn_head in self.attn_heads]

# 连接注意力输出

output = torch.cat(attn_outputs, dim=-1)

return output

```

**逻辑分析:**

* `attn_heads`是一个自注意力头的列表。

* `forward`方法并行调用每个自注意力头,并连接其输出。

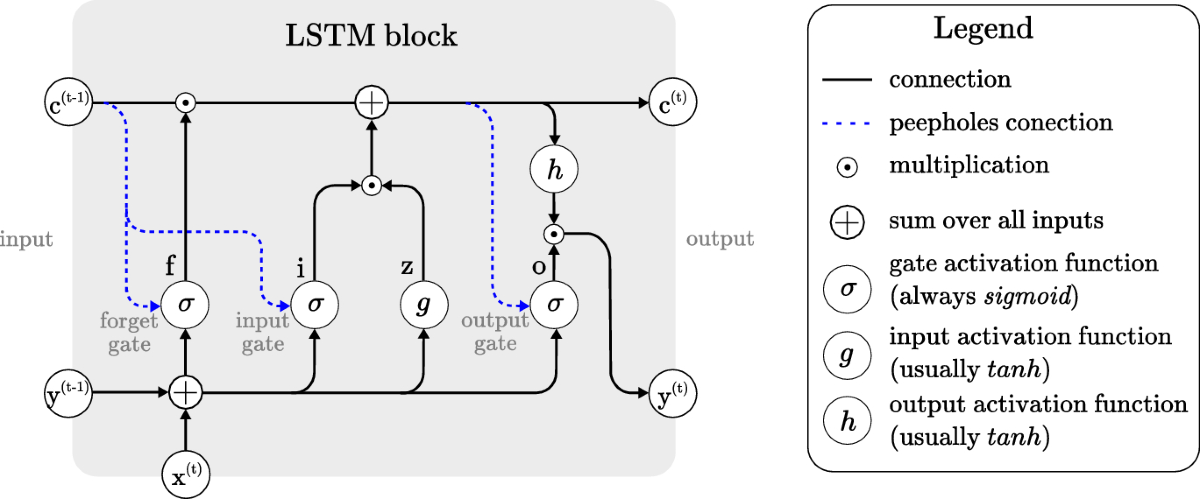

### 2.2 循环神经网络原理

#### 2.2.1

0

0