多头注意力机制在NLP中的应用:赋能语言理解与生成

发布时间: 2024-08-21 08:16:24 阅读量: 33 订阅数: 50

注意力机制:深度学习的核心机制及其在自然语言处理中的应用.pdf

# 1. 多头注意力机制概述

多头注意力机制是一种神经网络层,它通过计算查询、键和值之间的相似度来对输入序列中的元素分配不同的权重。它能够捕获序列中元素之间的长距离依赖关系,并且在自然语言处理(NLP)任务中取得了显著的成功。

多头注意力机制的核心思想是将输入序列分成多个子序列,并使用不同的注意力头对每个子序列进行注意力计算。每个注意力头计算一个不同的相似度矩阵,然后将这些矩阵连接起来形成最终的注意力权重。这种机制允许模型从不同角度关注输入序列,从而获得更丰富的表示。

# 2. 多头注意力机制的理论基础

### 2.1 自注意力机制原理

自注意力机制是一种神经网络层,它允许模型关注输入序列的不同部分,并计算它们之间的关系。它通过将输入序列映射到一个查询(Q)、键(K)和值(V)矩阵来工作。查询矩阵包含每个输入元素的查询向量,键矩阵包含每个输入元素的键向量,值矩阵包含每个输入元素的值向量。

自注意力机制的计算过程如下:

1. 计算查询矩阵和键矩阵的点积,得到一个相似度矩阵。相似度矩阵中的每个元素表示查询向量和键向量之间的相似度。

2. 对相似度矩阵进行softmax操作,得到一个概率分布。概率分布中的每个元素表示查询向量与键向量匹配的概率。

3. 将概率分布与值矩阵相乘,得到一个输出矩阵。输出矩阵中的每个元素表示查询向量与键向量匹配的值向量的加权和。

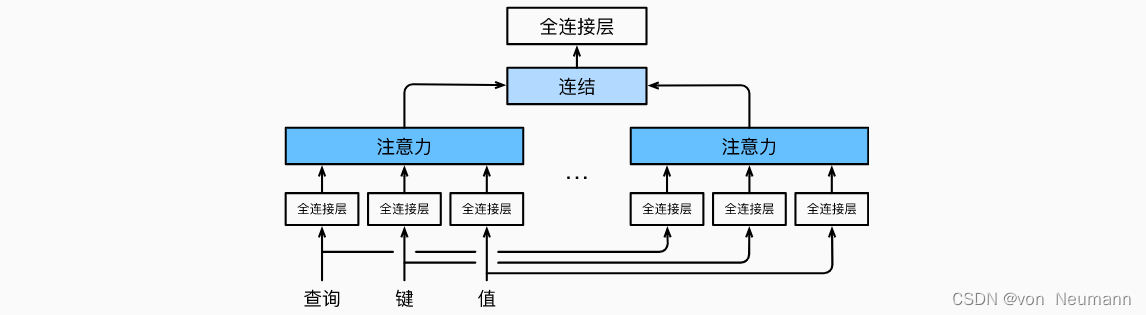

### 2.2 多头注意力机制的结构与计算

多头注意力机制是自注意力机制的扩展,它并行使用多个自注意力头。每个自注意力头独立地计算一个输出矩阵,然后将这些输出矩阵连接起来形成最终的输出矩阵。

多头注意力机制的结构如下:

```

Input Sequence -> Linear Projection -> Split Heads -> Self-Attention Heads -> Concatenate Heads -> Linear Projection -> Output Sequence

```

多头注意力机制的计算过程如下:

1. 将输入序列投影到查询、键和值矩阵。

2. 将查询矩阵和键矩阵拆分为多个头。

3. 对每个头计算自注意力机制。

4. 将每个头的输出矩阵连接起来。

5. 将连接后的矩阵投影到输出序列。

### 2.3 多头注意力机制的优势与局限

多头注意力机制具有以下优势:

* **并行计算:**多头注意力机制并行使用多个自注意力头,这可以提高计算效率。

* **捕捉多重关系:**多头注意力机制可以捕捉输入序列中不同类型的关系,因为它使用多个自注意力头。

* **鲁棒性:**多头注意力机制对输入序列的顺序不敏感,因为它使用点积操作来计算相似度。

多头注意力机制也有一些局限性:

* **计算成本高:**多头注意力机制需要计算多个自注意力头,这可能会增加计算成本。

* **参数数量多:**多头注意力机制需要学习多个自注意力头的参数,这可能会增加模型的参数数量。

* **难以解释:**多头注意力机制的输出很难解释,因为它涉及到多个自注意力头的复杂交互。

# 3.1 机器翻译中的多头注意力机制

**3.1.1 Transformer模型中的多头注意力**

Transformer模型是机器翻译领域的里程碑式模型,其核心组件之一便是多头注意力机制。Transformer模型通过将输入序列和输出序列表示为一个连续的向量序列,并使用多头注意力机制来计算每个输出向量与所有输入向量之间的注意力权重。

```python

import torch

from torch.nn import MultiheadAttention

# 输入序列和输出序列的向量表示

input_vectors = torch.randn(seq_len, batch_size, d_model)

output_vectors = torch.randn(seq_len, batch_size, d_model)

# 定义多头注意力层

attention = MultiheadAttention(d_model, num_heads=8)

# 计算注意力权重

attention_weights = attention(output_vectors, input_vectors, input_vectors)

```

**3.1.2 多头注意力机制对翻译质量的影响**

多头注意力机制对机器翻译质量的影响主要体现在以下几个方面:

- **捕捉长距离依赖关系:**多头注意力机制可以同时关注输入序列中不同位置的向量,从而捕捉长距离依赖关系,提高翻译准确性。

- **增强语义表示:**多头注意力机制通过不同的注意力头,可以从输入序列中提取出不同的语义特征,增强输出序列的语义表示。

- **提高鲁棒性:**多头注意力机制通过多个注意力头的并行计算,可以降低模型对单个注意力头的依赖,提高模型的鲁棒性。

### 3.2 文本摘要中的多头注意力机制

**3.2.1 抽取式摘要中的多头注意力**

抽取式摘要从输入文本中提取关键句子或短语来生成摘要。多头注意力机制可以用于计算每个输出句子与所有输入句子之间的注意力权重,从而确定哪些输入句子对输出摘要的贡献最大。

```python

import torch

from torch.nn import Transformer

# 输入文本的向量表示

input_vectors = torch.randn(num_sentences, d_model)

# 定义Transformer模型

transformer = Transformer(d_model, num_heads=8, num_encoder_layers=6, num_decoder_layers=6)

# 计算注意力权重

attention_weights = transformer.encoder(input_vectors)

```

**3.2.2 生成式摘要中的多头注意力**

生成式摘要从头开始生成摘要文本。多头注意力机制可以用于计

0

0