多头注意力机制的数学原理与直观理解:揭开其神秘面纱

发布时间: 2024-08-21 08:13:32 阅读量: 51 订阅数: 50

使用多头注意力机制实现数字预测

# 1. 多头注意力机制概述

多头注意力机制是一种神经网络层,它能够从输入序列中识别和关注重要的信息。它在自然语言处理和计算机视觉等领域得到了广泛的应用。

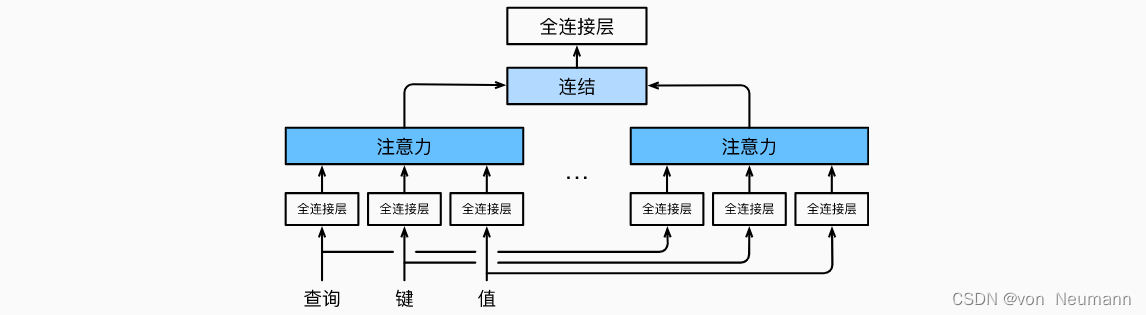

与传统的注意力机制不同,多头注意力机制使用多个并行的注意力头,每个头关注输入序列的不同子空间。这使得该机制能够捕获输入中更丰富的特征,从而提高模型的性能。

多头注意力机制的优势包括:

- 能够处理长序列输入

- 能够并行处理,提高效率

- 能够学习输入中不同子空间的特征

# 2. 多头注意力机制的数学原理

### 2.1 标量注意力机制

标量注意力机制是多头注意力机制的基础,它计算一个查询向量与一组键向量的相似度,然后将这些相似度转换为概率分布。公式如下:

```python

attention(query, key, value) = softmax(query^T * key) * value

```

其中:

* `query` 是一个查询向量,通常表示为一个词嵌入或句子嵌入。

* `key` 是一个键向量集,通常表示为一组词嵌入或句子嵌入。

* `value` 是一个值向量集,通常表示为一组词嵌入或句子嵌入。

* `softmax` 函数将相似度转换为概率分布,确保概率之和为 1。

### 2.2 多头注意力机制的公式推导

多头注意力机制将标量注意力机制应用于多个不同的子空间,然后将结果连接起来。公式如下:

```python

multi_head_attention(query, key, value) = Concat(head_1, head_2, ..., head_h) * W^O

```

其中:

* `head_i` 是第 `i` 个注意头,它计算一个查询向量与一组键向量的相似度,然后将这些相似度转换为概率分布。

* `W^O` 是一个权重矩阵,用于将不同注意头的输出连接起来。

### 2.3 多头注意力机制的优势和局限

**优势:**

* **并行处理:**多头注意力机制可以并行计算多个注意头,从而提高计算效率。

* **权重分配:**多头注意力机制允许模型为不同的子空间分配不同的权重,从而捕获更丰富的特征。

* **鲁棒性:**多头注意力机制对噪声和异常值具有鲁棒性,因为不同的注意头可以补偿彼此的错误。

**局限:**

* **计算成本:**多头注意力机制的计算成本比标量注意力机制更高,因为它需要计算多个注意头。

* **内存占用:**多头注意力机制需要存储多个键向量集和值向量集,这可能会占用大量的内存。

* **超参数调整:**多头注意力机制有多个超参数,如注意头数和连接权重的初始化,需要仔细调整以获得最佳性能。

# 3.1 类比现实世界中的注意力机制

**类比:**

多头注意力机制与现实世界中人类的注意力机制有许多相似之处。当我们专注于某项任务时,我们的注意力会集中在相关的信息上,同时忽略无关的信息。例如,当我们在阅读一本书时,我们的注意力会集中在文本上,而忽略周围的环境噪音。

**多头注意力机制的类比:**

多头注意力机制也采用类似的策略。它将输入数据分成多个“头”,每个头专注于不同的特征子空间。通过这种方式,多头注意力机制可以同时关注输入数据的不同方面,就像我们的大脑可以同时关注视觉、听觉和触觉信息一样。

### 3.2 多头注意力机制的并行处理

**并行处理:**

多头注意力机制的一个关键优势是其并行处理能力。它将输入数据分成多个头,每个头可以独立地处理数据。这使得多头注意力机制能够高效地处理大规模数据,因为多个头可以同时执行计算。

**类比:**

这类似于一个团队合作完成一项任务。每个团队成员专注于任务的不同部分,并行工作,从而提高整体效率。

### 3.3 多头注意力机制的权重分配

**权重分配:**

多头注意力机制通过计算每个头对输出的贡献来分配权重。权重基于每个头关注的特征子空间的重要性。通过这种方式,多头注意力机制可以学习哪些特征子空间对于给定任务更重要。

**类比:**

这类似于一个专家小组对某个问题提供建议。每个专家根据自己的专业知识提供意见,而最终的决定是基于所有专家意见的加权平均。

# 4. 多头注意力机制的实践应用

多头注意力机制在自然语言处理和计算机视觉等领域有着广泛的应用。它能够有效地处理序列数据,并捕捉数据之间的复杂关系。

### 4.1 自然语言处理中的应用

#### 4.1.1 机器翻译

在机器翻译中,多头注意力机制可以帮助模型理解源语言句子的结构和含义。它通过计算目标语言中每个单词与源语言中所有单词之间的注意力权重,从而生成准确且流畅的翻译。

**代码示例:**

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class Transformer(nn.Module):

def __init__(self, d_model, nhead, num_encoder_layers, num_decoder_layers, dim_feedforward=2048, dropout=0.1):

super(Transformer, self).__init__()

encoder_layer = nn.TransformerEncoderLayer(d_model, nhead, dim_feedforward, dropout)

encoder_norm = nn.LayerNorm(d_model)

self.encoder = nn.TransformerEncoder(encoder_layer, num_encoder_layers, encoder_norm)

decoder_layer = nn.TransformerDecoderLayer(d_model, nhead, dim_feedforward, dropout)

decoder_norm = nn.LayerNorm(d_model)

self.decoder = nn.TransformerDecoder(decoder_layer, num_decoder_layers, decoder_norm)

self.d_model = d_model

self.nhead = nhead

def forward(self, src, tgt, src_mask=None, tgt_mask=None):

memory = self.encoder(src, src_mask)

output = self.decoder(tgt, memory, tgt_mask, src_mask)

return output

```

**代码逻辑分析:**

* `Transformer`类定义了一个Transformer模型,它包含编码器和解码器。

* `encoder`和`decoder`函数分别执行编码和解码操作。

* `src`和`tgt`是源语言和目标语言的输入序列。

* `src_mask`和`tgt_mask`是掩码,用于防止模型看到未来单词。

* `memory`是编码器的输出,它包含源语言句子的编码表示。

* `output`是解码器的输出,它包含翻译后的目标语言句子。

#### 4.1.2 文本摘要

在文本摘要中,多头注意力机制可以帮助模型从长文本中提取关键信息,并生成简洁且信息丰富的摘要。它通过计算每个单词与其他单词之间的注意力权重,从而识别文本中的重要部分。

**代码示例:**

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class TransformerSummarizer(nn.Module):

def __init__(self, d_model, nhead, num_encoder_layers, num_decoder_layers, dim_feedforward=2048, dropout=0.1):

super(TransformerSummarizer, self).__init__()

encoder_layer = nn.TransformerEncoderLayer(d_model, nhead, dim_feedforward, dropout)

encoder_norm = nn.LayerNorm(d_model)

self.encoder = nn.TransformerEncoder(encoder_layer, num_encoder_layers, encoder_norm)

decoder_layer = nn.TransformerDecoderLayer(d_model, nhead, dim_feedforward, dropout)

decoder_norm = nn.LayerNorm(d_model)

self.decoder = nn.TransformerDecoder(decoder_layer, num_decoder_layers, decoder_norm)

self.d_model = d_model

self.nhead = nhead

def forward(self, src, tgt, src_mask=None, tgt_mask=None):

memory = self.encoder(src, src_mask)

output = self.decoder(tgt, memory, tgt_mask, src_mask)

return output

```

**代码逻辑分析:**

* `TransformerSummarizer`类定义了一个Transformer摘要模型,它包含编码器和解码器。

* `encoder`和`decoder`函数分别执行编码和解码操作。

* `src`和`tgt`是输入文本和摘要序列。

* `src_mask`和`tgt_mask`是掩码,用于防止模型看到未来单词。

* `memory`是编码器的输出,它包含输入文本的编码表示。

* `output`是解码器的输出,它包含生成的摘要。

### 4.2 计算机视觉中的应用

#### 4.2.1 图像分类

在图像分类中,多头注意力机制可以帮助模型捕捉图像中不同区域之间的关系,并识别图像的类别。它通过计算每个像素与其他像素之间的注意力权重,从而突出图像中的重要特征。

**代码示例:**

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class TransformerClassifier(nn.Module):

def __init__(self, d_model, nhead, num_encoder_layers, num_decoder_layers, dim_feedforward=2048, dropout=0.1):

super(TransformerClassifier, self).__init__()

encoder_layer = nn.TransformerEncoderLayer(d_model, nhead, dim_feedforward, dropout)

encoder_norm = nn.LayerNorm(d_model)

self.encoder = nn.TransformerEncoder(encoder_layer, num_encoder_layers, encoder_norm)

self.classifier = nn.Linear(d_model, num_classes)

def forward(self, src, src_mask=None):

output = self.encoder(src, src_mask)

logits = self.classifier(output)

return logits

```

**代码逻辑分析:**

* `TransformerClassifier`类定义了一个Transformer分类模型,它包含编码器和分类器。

* `encoder`函数执行编码操作,将图像表示为一个序列。

* `src_mask`是掩码,用于防止模型看到未来像素。

* `output`是编码器的输出,它包含图像的编码表示。

* `logits`是分类器的输出,它包含图像属于每个类别的概率。

#### 4.2.2 目标检测

在目标检测中,多头注意力机制可以帮助模型定位图像中的目标,并识别目标的类别。它通过计算每个像素与其他像素之间的注意力权重,从而识别图像中可能包含目标的区域。

**代码示例:**

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

class TransformerDetector(nn.Module):

def __init__(self, d_model, nhead, num_encoder_layers, num_decoder_layers, dim_feedforward=2048, dropout=0.1):

super(TransformerDetector, self).__init__()

encoder_layer = nn.TransformerEncoderLayer(d_model, nhead, dim_feedforward, dropout)

encoder_norm = nn.LayerNorm(d_model)

self.encoder = nn.TransformerEncoder(encoder_layer, num_encoder_layers, encoder_norm)

self.decoder = nn.Linear(d_model, num_classes)

def forward(self, src, src_mask=None):

output = self.encoder(src, src_mask)

logits = self.decoder(output)

return logits

```

**代码逻辑分析:**

* `TransformerDetector`类定义了一个Transformer检测模型,它包含编码器和解码器。

* `encoder`函数执行编码操作,将图像表示为一个序列。

* `src_mask`是掩码,用于防止模型看到未来像素。

* `output`是编码器的输出,它包含图像的编码表示。

* `logits`是解码器的输出,它包含图像中每个像素属于每个类别的概率。

# 5.1 多模态注意力机制

多模态注意力机制是一种扩展的多头注意力机制,它允许模型处理来自不同模态(例如,文本、图像、音频)的数据。这种机制通过将来自不同模态的数据投影到一个共同的表示空间中来实现,从而使模型能够学习跨模态关系并执行多模态任务。

### 5.1.1 多模态注意力机制的公式推导

假设我们有来自不同模态的数据,表示为 $X_1, X_2, ..., X_m$,其中 $X_i \in R^{d_i \times n_i}$,$d_i$ 是第 $i$ 个模态的维度,$n_i$ 是第 $i$ 个模态的数据点数量。多模态注意力机制的公式推导如下:

```

Q = X_1W_Q, K = X_2W_K, V = X_3W_V

A = softmax(QK^T / \sqrt{d_k})

Output = AV

```

其中,$W_Q, W_K, W_V$ 是投影矩阵,$d_k$ 是键向量的维度。

### 5.1.2 多模态注意力机制的优势

多模态注意力机制具有以下优势:

- **跨模态关系学习:**它允许模型学习不同模态之间的数据关系,从而提高跨模态任务的性能。

- **信息融合:**它将来自不同模态的数据融合到一个共同的表示中,从而丰富模型的输入。

- **可扩展性:**它可以轻松扩展到处理更多模态的数据。

### 5.1.3 多模态注意力机制的应用

多模态注意力机制广泛应用于以下任务:

- **视觉问答:**将图像和文本数据融合起来,以回答有关图像的问题。

- **视频字幕:**将视频和文本数据融合起来,为视频生成字幕。

- **情感分析:**将文本和语音数据融合起来,以分析文本的情感。

### 5.1.4 多模态注意力机制的示例

下表展示了一个使用多模态注意力机制的视觉问答模型的示例:

| 输入图像 | 输入文本 | 输出答案 |

|---|---|---|

| | "这张图片里有什么?" | "图片中有一只猫和一只狗。" |

在这个示例中,模型将图像和文本数据投影到一个共同的表示空间中,然后使用注意力机制学习图像和文本之间的关系,从而生成答案。

# 6.1 多头注意力机制的优化方向

### 减少计算量

多头注意力机制的计算量随着序列长度和头数的增加而显著增加。为了解决这一问题,研究人员提出了各种优化技术,例如:

- **稀疏注意力机制:**通过对注意力矩阵进行稀疏化,减少需要计算的注意力权重数量。

- **低秩近似:**使用低秩分解来近似注意力矩阵,从而降低计算复杂度。

- **并行化:**利用多核处理器或图形处理器(GPU)对注意力机制的计算进行并行化。

### 提高注意力权重的可解释性

多头注意力机制的注意力权重通常是难以解释的,这使得难以理解模型是如何做出决策的。为了提高可解释性,研究人员提出了以下技术:

- **可视化注意力权重:**使用热力图或其他可视化技术来显示注意力权重,从而直观地了解模型的关注点。

- **注意力解释方法:**开发解释方法来解释注意力权重,例如 LIME(局部可解释模型可解释性)或 SHAP(SHapley 值分析)。

### 探索新的注意力机制

除了多头注意力机制之外,研究人员还在探索新的注意力机制,例如:

- **自注意力机制:**一种注意力机制,允许序列中的元素相互关注,而无需外部查询。

- **多模态注意力机制:**一种注意力机制,可以处理来自不同模态(例如文本、图像、音频)的数据。

- **可解释注意力机制:**一种注意力机制,可以提供有关模型决策的可解释性。

0

0