YOLO训练GPU加速:提高训练效率,释放GPU潜能

发布时间: 2024-08-17 09:25:34 阅读量: 121 订阅数: 105

2024 YOLO开发操作指南:环境配置、模型训练与部署优化

# 1. YOLO训练简介**

YOLO(You Only Look Once)是一种实时目标检测算法,因其速度快、精度高而受到广泛关注。YOLO训练涉及使用大量图像和标签数据训练一个神经网络模型,以识别和定位图像中的对象。训练过程包括以下关键步骤:

- **数据预处理:**将图像和标签数据预处理成模型可以接受的格式,包括调整大小、归一化和数据增强。

- **模型构建:**选择或设计一个YOLO模型架构,并根据特定任务调整其超参数,例如层数、卷积核大小和激活函数。

- **损失函数:**定义一个损失函数来衡量模型预测与真实标签之间的差异,例如交叉熵损失或IoU损失。

- **优化器:**使用优化算法(如梯度下降或Adam)更新模型权重,以最小化损失函数。

# 2. GPU加速原理

### 2.1 GPU并行计算架构

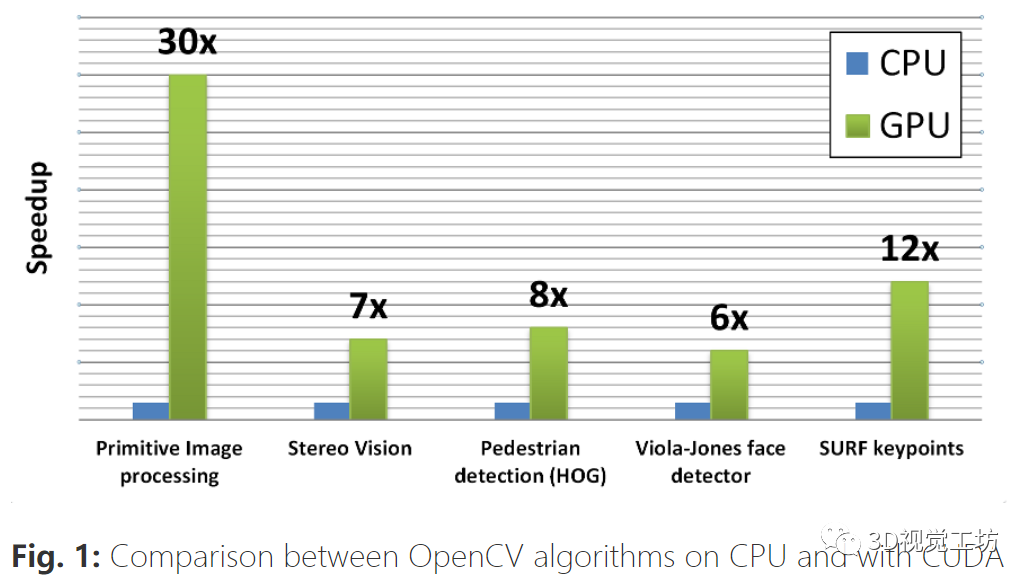

GPU(图形处理单元)是一种专门用于并行计算的硬件设备。与CPU(中央处理单元)不同,GPU具有以下并行计算架构特点:

- **多核架构:**GPU包含大量处理核,每个核可以同时执行多个线程。

- **SIMD(单指令多数据)架构:**GPU中的核可以同时执行相同的指令,但对不同的数据进行操作。

- **共享内存:**GPU中的核共享一个大容量的片上内存,可以快速访问数据。

这些特点使GPU非常适合处理大量并行计算任务,例如图像处理、视频编码和深度学习训练。

### 2.2 CUDA编程模型

CUDA(Compute Unified Device Architecture)是一种并行编程模型,用于开发GPU应用程序。CUDA允许程序员直接访问GPU硬件,并利用其并行计算能力。

CUDA编程模型包括以下关键概念:

- **内核:**内核是GPU上执行的并行代码块。

- **线程:**线程是内核中的并行执行单元。

- **线程块:**线程块是一组同时执行的线程,可以共享数据和同步。

- **网格:**网格是一组线程块,可以并行执行。

通过使用CUDA编程模型,程序员可以充分利用GPU的并行计算能力,从而显著提高应用程序的性能。

### 代码示例:CUDA并行计算

以下代码示例演示了如何使用CUDA进行并行计算:

```cuda

__global__ void add_vectors(float *a, float *b, float *c, int n) {

int idx = threadIdx.x + blockIdx.x * blockDim.x;

if (idx < n) {

c[idx] = a[idx] + b[idx];

}

}

int main() {

// 分配设备内存

float *a, *b, *c;

cudaMalloc(&a, sizeof(float) * n);

cudaMalloc(&b, sizeof(float) * n);

cudaMalloc(&c, sizeof(float) * n);

// 将数据复制到设备内存

cudaMemcpy(a, host_a, sizeof(float) * n, cudaMemcpyHostToDevice);

cudaMemcpy(b, host_b, sizeof(float) * n, cudaMemcpyHostToDevice);

// 启动内核

add_vectors<<<blocks_per_grid, threads_per_block>>>(a, b, c, n);

// 将结果复制回主机内存

cudaMemcpy(host_c, c, sizeof(float) * n, cudaMemcpyDeviceToHost);

// 释放设备内存

cudaFree(a);

cudaFree(b);

cudaFree(c);

return 0;

}

```

**代码逻辑分析:**

- `add_vectors`内核函数在GPU上并行执行,每个线程计算一个元素的和。

- `main`函数分配设备内存,将数据复制到设备内存,启动内核,并将结果复制回主机内存。

- `blocks_per_grid`和`threads_per_block`参数指定了网格和线程块的维度。

**参数说明:**

- `a`, `b`, `c`: 输入和输出向量。

- `n`: 向量长度。

- `blocks_per_gr

0

0