C++ OpenCV人脸跟踪实战指南:打造实时人脸识别系统,提升性能与准确度

发布时间: 2024-08-08 06:58:40 阅读量: 128 订阅数: 30

# 1. OpenCV人脸跟踪基础

人脸跟踪是计算机视觉领域的一项重要技术,它允许计算机在视频或图像序列中识别并跟踪人脸。OpenCV(Open Source Computer Vision Library)是一个流行的开源计算机视觉库,它提供了人脸跟踪所需的基本功能。

本节将介绍OpenCV人脸跟踪的基础知识,包括人脸检测和跟踪算法的原理。我们将讨论Haar级联分类器和各种跟踪算法,如Kalman滤波、粒子滤波和光流法。这些算法将为我们理解OpenCV人脸跟踪的实现奠定基础。

# 2. 人脸检测与追踪算法

人脸检测和追踪是计算机视觉领域的重要任务,广泛应用于安全监控、人机交互、医疗诊断等领域。本章节将介绍人脸检测与追踪的常用算法,包括Haar级联分类器、Kalman滤波、粒子滤波和光流法。

### 2.1 Haar级联分类器

#### 2.1.1 原理与实现

Haar级联分类器是一种基于特征的机器学习算法,用于检测图像中的人脸。其原理是将图像划分为多个子区域,并计算每个子区域的Haar特征。Haar特征是图像中矩形区域的像素和的差值,可以描述图像的局部纹理和形状。

Haar级联分类器通过训练大量人脸和非人脸图像,学习区分人脸和非人脸的特征。训练过程采用AdaBoost算法,逐级选择最优的Haar特征,并形成一个级联结构。

#### 2.1.2 训练与应用

Haar级联分类器的训练需要大量的人脸和非人脸图像数据集。训练过程包括以下步骤:

1. **特征提取:**从图像中提取Haar特征。

2. **特征选择:**使用AdaBoost算法选择最优的Haar特征。

3. **级联结构构建:**将选出的特征按权重从小到大排列,形成级联结构。

训练好的Haar级联分类器可以应用于人脸检测。其工作流程如下:

1. **图像分块:**将图像划分为多个子区域。

2. **特征计算:**计算每个子区域的Haar特征。

3. **级联检测:**从级联结构的顶层开始,逐级检测子区域是否包含人脸。

### 2.2 跟踪算法

人脸追踪是指在连续的图像序列中跟踪人脸的位置和形状。常用的跟踪算法包括Kalman滤波、粒子滤波和光流法。

#### 2.2.1 Kalman滤波

Kalman滤波是一种基于状态空间模型的递归滤波算法,用于估计动态系统的状态。在人脸追踪中,Kalman滤波器用于预测人脸的位置和速度,并根据新的观测值更新预测。

Kalman滤波器的状态空间模型如下:

```

x_k = A * x_{k-1} + B * u_k + w_k

y_k = C * x_k + v_k

```

其中:

* x_k:系统状态(人脸的位置和速度)

* u_k:控制输入(通常为 0)

* y_k:观测值(人脸的检测结果)

* w_k:过程噪声

* v_k:观测噪声

Kalman滤波器的更新过程包括以下步骤:

1. **预测:**根据状态空间模型预测下一时刻的状态。

2. **更新:**根据新的观测值更新预测。

#### 2.2.2 粒子滤波

粒子滤波是一种蒙特卡罗方法,用于估计非线性动态系统的状态。在人脸追踪中,粒子滤波器使用一组粒子(随机采样的状态)来表示人脸的状态分布。

粒子滤波器的更新过程包括以下步骤:

1. **重要性采样:**根据上一时刻的状态分布,采样一组粒子。

2. **权重更新:**计算每个粒子的权重,表示其与观测值的匹配程度。

3. **重采样:**根据粒子的权重,重新采样一组粒子,以减少粒子退化。

#### 2.2.3 光流法

光流法是一种基于图像亮度变化的运动估计算法。在人脸追踪中,光流法用于估计人脸在连续图像帧之间的运动。

光流法的基本原理是:如果图像中某一点在两个连续帧之间移动,则其亮度值保持不变。因此,可以通过计算图像中每个像素的亮度变化,来估计其运动。

光流法的更新过程包括以下步骤:

1. **亮度差分计算:**计算连续图像帧之间每个像素的亮度差分。

2. **运动估计:**使用光流方程估计每个像素的运动向量。

3. **人脸追踪:**根据人脸检测结果,将光流估计的运动向量应用于人脸区域,实现人脸追踪。

# 3.1 人脸检测与追踪实现

**3.1.1 图像预处理**

图像预处理是人脸检测和追踪的关键步骤,它可以去除图像中的噪声和干扰,增强人脸特征,从而提高检测和追踪的准确度。常用的图像预处理技术包括:

- **灰度转换:**将彩色图像转换为灰度图像,减少颜色信息的影响。

- **直方图均衡化:**调整图像的直方图,增强对比度和亮度。

- **滤波:**使用高斯滤波或中值滤波去除噪声,平滑图像。

- **图像缩放:**将图像缩放至适当的大小,减少计算量。

**代码块:**

```cpp

// 灰度转换

cv::cvtColor(image, grayImage, cv::COLOR_BGR2GRAY);

// 直方图均衡化

cv::equalizeHist(grayImage, grayImage);

// 高斯滤波

cv::GaussianBlur(grayImage, grayImage, cv::Size(5, 5), 0);

```

**逻辑分析:**

* `cvtColor()` 函数将彩色图像 `image` 转换为灰度图像 `grayImage`。

* `equalizeHist()` 函数对 `grayImage` 进行直方图均衡化,增强对比度和亮度。

* `GaussianBlur()` 函数使用高斯滤波去除噪声,平滑 `grayImage`。

**3.1.2 人脸检测**

人脸检测是确定图像中人脸位置的过程。OpenCV 提供了多种人脸检测算法,其中 Haar 级联分类器是一种快速且有效的算法。

**Haar 级联分类器:**

Haar 级联分类器是一种基于 Haar 特征的机器学习算法。它使用一系列 Haar 特征来检测人脸,这些特征是图像中矩形区域的像素和差。

**代码块:**

```cpp

// 加载 Haar 级联分类器

cv::CascadeClassifier faceDetector;

faceDetector.load("haarcascade_frontalface_default.xml");

// 人脸检测

std::vector<cv::Rect> faces;

faceDetector.detectMultiScale(grayImage, faces, 1.1, 3, 0|CV_HAAR_SCALE_IMAGE, cv::Size(30, 30));

```

**逻辑分析:**

* `faceDetector.load()` 加载 Haar 级联分类器。

* `faceDetector.detectMultiScale()` 函数在 `grayImage` 中检测人脸,并将检测到的面部矩形边界框存储在 `faces` 向量中。

* `1.1` 是缩放因子,表示在每个图像金字塔层中图像的缩放比例。

* `3` 是最小邻居数,表示每个检测到的面部矩形必须包含至少 3 个与该矩形重叠的面部矩形才能被认为是真实的人脸。

* `0|CV_HAAR_SCALE_IMAGE` 指定图像金字塔的类型。

* `cv::Size(30, 30)` 是 Haar 特征的最小尺寸。

**3.1.3 人脸追踪**

人脸追踪是跟踪图像序列中人脸位置的过程。OpenCV 提供了多种人脸追踪算法,其中 Kalman 滤波是一种广泛使用的算法。

**Kalman 滤波:**

Kalman 滤波是一种线性预测算法,用于估计动态系统的状态。它使用过去的状态和测量值来预测当前状态。

**代码块:**

```cpp

// 创建 Kalman 滤波器

cv::KalmanFilter kf(4, 2, 0);

kf.transitionMatrix = (cv::Mat_<float>(4, 4) <<

1, 0, 1, 0,

0, 1, 0, 1,

0, 0, 1, 0,

0, 0, 0, 1);

kf.measurementMatrix = (cv::Mat_<float>(2, 4) <<

1, 0, 0, 0,

0, 1, 0, 0);

kf.processNoiseCov = (cv::Mat_<float>(4, 4) <<

1, 0, 0, 0,

0, 1, 0, 0,

0, 0, 1, 0,

0, 0, 0, 1);

kf.measurementNoiseCov = (cv::Mat_<float>(2, 2) <<

1, 0,

0, 1);

kf.errorCovPost = (cv::Mat_<float>(4, 4) <<

1, 0, 0, 0,

0, 1, 0, 0,

0, 0, 1, 0,

0, 0, 0, 1);

// 初始化 Kalman 滤波器

kf.statePre.at<float>(0) = faces[0].x + faces[0].width / 2;

kf.statePre.at<float>(1) = faces[0].y + faces[0].height / 2;

kf.statePre.at<float>(2) = 0;

kf.statePre.at<float>(3) = 0;

// 人脸追踪

while (true) {

// 获取当前帧

cv::Mat frame;

cap >> frame;

// 人脸检测

std::vector<cv::Rect> faces;

faceDetector.detectMultiScale(grayImage, faces, 1.1, 3, 0|CV_HAAR_SCALE_IMAGE, cv::Size(30, 30));

// 更新 Kalman 滤波器

cv::Mat measurement = (cv::Mat_<float>(2, 1) <<

faces[0].x + faces[0].width / 2,

faces[0].y + faces[0].height / 2);

kf.correct(measurement);

// 预测人脸位置

cv::Mat prediction = kf.predict();

// 绘制预测的人脸位置

cv::rectangle(frame, cv::Rect(prediction.at<float>(0) - faces[0].width / 2, prediction.at<float>(1) - faces[0].height / 2, faces[0].width, faces[0].height), cv::Scalar(0, 255, 0), 2);

// 显示帧

cv::imshow("Frame", frame);

}

```

**逻辑分析:**

* `kf` 是一个 Kalman 滤波器对象。

* `kf.transitionMatrix` 和 `kf.measurementMatrix` 是状态转换矩阵和测量矩阵。

* `kf.processNoiseCov` 和 `kf.measurementNoiseCov` 是过程噪声协方差矩阵和测量噪声协方差矩阵。

* `kf.errorCovPost` 是后验误差协方差矩阵。

* `kf.statePre` 是滤波器的先验状态。

* `while` 循环不断获取帧,进行人脸检测,更新 Kalman 滤波器,预测人脸位置,并绘制预测的人脸位置。

# 4. 性能优化与准确度提升

### 4.1 优化算法

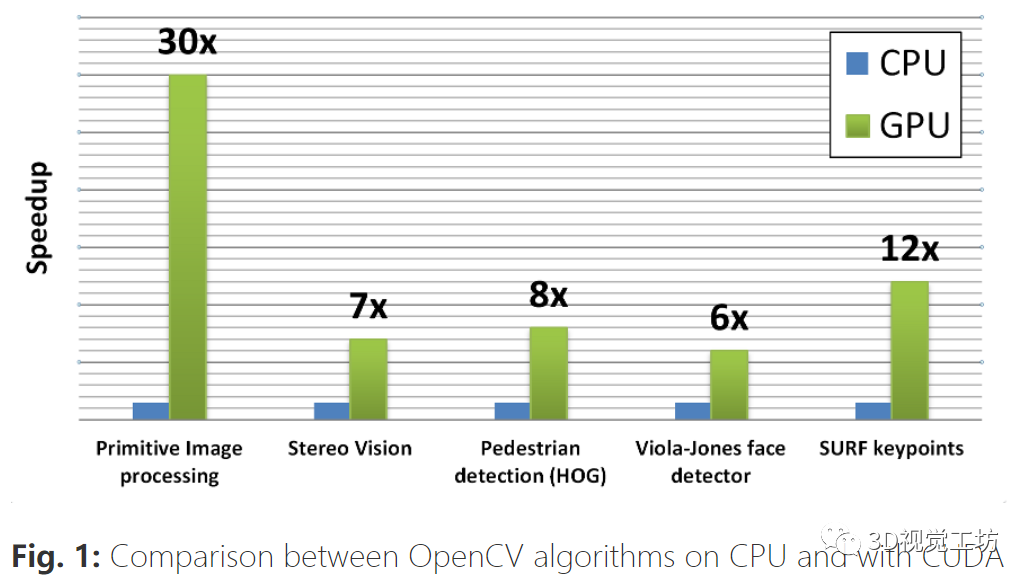

#### 4.1.1 并行化

并行化是一种通过同时执行多个任务来提高程序性能的技术。在人脸跟踪系统中,可以并行化以下任务:

- 图像预处理(例如,灰度化、直方图均衡化)

- 人脸检测

- 人脸追踪

**代码块:**

```cpp

#include <opencv2/opencv.hpp>

#include <omp.h>

int main() {

cv::Mat image = cv::imread("image.jpg");

// 并行化图像预处理

#pragma omp parallel for

for (int i = 0; i < image.rows; i++) {

for (int j = 0; j < image.cols; j++) {

// 图像预处理代码

}

}

// 并行化人脸检测

std::vector<cv::Rect> faces;

#pragma omp parallel for

for (int i = 0; i < image.rows; i++) {

for (int j = 0; j < image.cols; j++) {

// 人脸检测代码

}

}

// 并行化人脸追踪

#pragma omp parallel for

for (int i = 0; i < faces.size(); i++) {

// 人脸追踪代码

}

return 0;

}

```

**逻辑分析:**

- `#pragma omp parallel for` 指令指示编译器将循环并行化。

- 循环迭代变量 `i` 和 `j` 被分配给不同的线程,同时执行图像预处理、人脸检测和人脸追踪。

- 并行化可以显著提高性能,尤其是在处理大图像或视频流时。

#### 4.1.2 算法选择

不同的跟踪算法具有不同的性能特征。对于实时应用,选择低计算成本的算法非常重要。

**表格:**

| 算法 | 计算成本 | 准确度 |

|---|---|---|

| Kalman 滤波 | 低 | 中 |

| 粒子滤波 | 高 | 高 |

| 光流法 | 中 | 中 |

**参数说明:**

- **计算成本:**算法执行所需的时间和计算资源。

- **准确度:**算法跟踪人脸的能力。

根据应用场景,可以权衡计算成本和准确度来选择最合适的算法。

### 4.2 提高准确度

#### 4.2.1 数据增强

数据增强是一种通过对现有数据进行变换(例如,旋转、翻转、裁剪)来创建新数据集的技术。这可以增加训练数据的多样性,从而提高模型的泛化能力。

**代码块:**

```python

import cv2

import numpy as np

def augment_data(image, faces):

# 旋转

augmented_images = []

augmented_faces = []

for angle in range(-10, 10, 2):

rotated_image = cv2.rotate(image, cv2.ROTATE_90_CLOCKWISE, angle)

rotated_faces = [cv2.rotateRect(face, angle) for face in faces]

augmented_images.append(rotated_image)

augmented_faces.append(rotated_faces)

# 翻转

augmented_images.append(cv2.flip(image, 1))

augmented_faces.append([cv2.flipRect(face, 1) for face in faces])

# 裁剪

augmented_images.append(cv2.resize(image[0:int(image.shape[0]/2), 0:int(image.shape[1]/2)], (image.shape[1], image.shape[0])))

augmented_faces.append([cv2.resizeRect(face, (image.shape[1], image.shape[0])) for face in faces])

return augmented_images, augmented_faces

```

**逻辑分析:**

- `augment_data()` 函数对图像和人脸边界框进行旋转、翻转和裁剪变换,创建新的增强数据集。

- 这些变换可以模拟真实世界中人脸的各种姿势和角度,从而提高模型的鲁棒性。

#### 4.2.2 模型训练优化

模型训练优化是调整模型超参数(例如,学习率、批次大小)以提高准确度和训练效率的过程。

**Mermaid 流程图:**

```mermaid

graph LR

subgraph 模型训练优化

A[超参数调整] --> B[模型训练]

B --> C[模型评估]

C --> A

end

```

**参数说明:**

- **超参数调整:**调整学习率、批次大小等超参数以优化模型性能。

- **模型训练:**使用调整后的超参数训练模型。

- **模型评估:**评估训练模型的准确度和损失函数。

通过迭代调整超参数并评估模型性能,可以找到最优的模型配置,从而提高准确度。

# 5.1 人脸表情识别

### 5.1.1 表情分类

人脸表情识别是计算机视觉领域的一个重要应用,其目的是识别和分类人脸上的表情。表情分类通常分为以下几个步骤:

1. **人脸检测:**首先需要检测图像中的人脸区域。

2. **特征提取:**从检测到的人脸区域中提取代表表情的特征。

3. **分类:**使用机器学习算法对提取的特征进行分类,识别出特定的表情。

### 5.1.2 表情追踪

表情追踪是实时识别和跟踪人脸表情变化的过程。它可以应用于各种领域,例如人机交互、情绪分析和医疗保健。表情追踪通常涉及以下步骤:

1. **初始化:**首先需要初始化表情追踪器,包括人脸检测器和表情分类器。

2. **实时检测:**使用人脸检测器实时检测图像中的人脸。

3. **特征提取:**从检测到的人脸区域中提取表情特征。

4. **分类:**使用表情分类器对提取的特征进行分类,识别出当前的表情。

5. **追踪:**根据连续的图像帧追踪表情的变化。

### 代码示例

以下是一个使用 OpenCV 和 dlib 库进行人脸表情识别的代码示例:

```python

import cv2

import dlib

# 加载人脸检测器和表情分类器

face_detector = cv2.CascadeClassifier('haarcascade_frontalface_default.xml')

expression_classifier = dlib.shape_predictor('shape_predictor_68_face_landmarks.dat')

# 初始化表情追踪器

expression_tracker = dlib.correlation_tracker()

# 捕捉视频流

cap = cv2.VideoCapture(0)

while True:

# 读取帧

ret, frame = cap.read()

if not ret:

break

# 人脸检测

faces = face_detector.detectMultiScale(frame, 1.1, 4)

# 遍历人脸

for (x, y, w, h) in faces:

# 特征提取

shape = expression_classifier(frame, dlib.rectangle(x, y, x + w, y + h))

# 表情分类

expression = dlib.predict_landmark(shape)

# 表情追踪

expression_tracker.start_track(frame, dlib.rectangle(x, y, x + w, y + h))

# 绘制表情

cv2.rectangle(frame, (x, y), (x + w, y + h), (0, 255, 0), 2)

cv2.putText(frame, expression, (x, y - 10), cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 255, 0), 2)

# 显示帧

cv2.imshow('Expression Recognition', frame)

# 按 'q' 退出

if cv2.waitKey(1) & 0xFF == ord('q'):

break

# 释放视频流

cap.release()

cv2.destroyAllWindows()

```

0

0