Hadoop安全模式:集群启动与故障诊断的最佳实践

发布时间: 2024-10-26 09:24:35 阅读量: 92 订阅数: 24

# 1. Hadoop安全模式概述

Hadoop作为大数据领域的重要工具,其数据处理的高效性和可扩展性使其成为IT行业不可或缺的组成部分。然而,随着数据量的增长和应用的多样化,Hadoop集群的安全问题也日益凸显。Hadoop安全模式应运而生,它提供了一种机制,能在启动期间对集群进行检查,并确保数据的一致性和安全性。理解Hadoop安全模式,对于维护集群稳定运行、保证数据完整性具有至关重要的作用。在本章中,我们将深入探讨Hadoop安全模式的概念、作用、以及配置参数,为后续章节关于集群启动安全实践、故障诊断与处理、高级应用和最佳实践案例分析奠定基础。

# 2. Hadoop集群启动的安全实践

## 2.1 安全模式的理论基础

### 2.1.1 安全模式的概念与作用

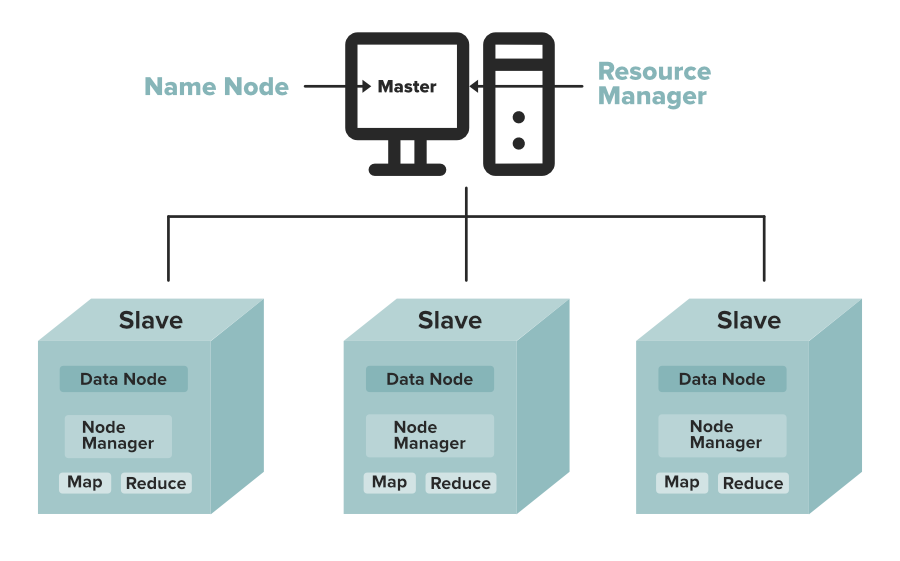

在分布式计算框架中,Hadoop的安全模式旨在提供一个隔离的环境,以确保集群在启动或维护过程中不受外部威胁。安全模式允许管理员在系统完全启动之前进行一系列检查,确保所有节点正常工作,并且数据的完整性和安全性得到保障。

安全模式下,NameNode不会进行数据块的复制操作,以避免对系统资源的额外消耗,并减少可能的安全风险。Hadoop集群在安全模式中可以进行关键组件的检查和修复,同时进行必要的系统监控和日志记录,确保集群恢复到一个安全和健康的状态。

### 2.1.2 Hadoop安全模式的配置参数详解

要启用和配置Hadoop的安全模式,需要调整`hdfs-site.xml`配置文件中的参数。关键参数包括:

- `dfs.namenode.safemode.threshold-pct`: 设定NameNode进入安全模式时,数据块的最小健康百分比。当健康的数据块低于此比例时,NameNode保持在安全模式下。

- `dfs.namenode.safemode.extension`: 定义安全模式的自动延长时间。即使数据块的健康比例超过了阈值,系统也会保持在安全模式下,直到超过这个时间。

- `dfs.safemode.min.datanodes`: 指定必须处于活跃状态的最小数据节点数。如果活跃节点数低于这个值,NameNode将不会离开安全模式。

这些参数的合理配置对于Hadoop集群的稳定性和安全性至关重要。管理员应根据实际的集群规模和使用模式仔细调整这些参数,以确保在不影响性能的前提下提供足够的安全保护。

## 2.2 启动过程中的安全检查

### 2.2.1 启动前的准备工作

在Hadoop集群启动之前,确保所有的硬件组件都已正确连接,并且网络配置无误。对于Hadoop集群的软件层面,管理员需要检查Java环境、Hadoop服务的安装和配置文件。

准备工作还包括检查集群中的节点状态,确保所有节点都是可访问的。使用`jps`命令可以查看各个节点上的Java进程,确认NameNode和DataNode是否正常运行。此外,检查磁盘空间和存储容量也是必要的步骤。

```bash

# 检查节点状态的命令示例

for i in {1..3}; do ssh node$i jps; done

```

### 2.2.2 安全模式下的系统检查流程

在Hadoop启动进入安全模式后,需要执行一系列的检查流程来确保系统的稳定性。首先,NameNode会检查其元数据和数据节点报告的健康状态。如果发现数据块不完整或校验失败,系统会尝试修复或重新复制数据块。

其次,系统会检查网络连接和配置。如果发现任何节点间的通信异常,系统会尝试修复网络连接。最后,系统还会对HDFS上的关键目录进行权限和所有权的校验。

```mermaid

graph LR

A[启动集群] --> B[安全模式检查]

B --> C[元数据完整性校验]

C --> D[数据块健康状态检查]

D --> E[网络连接检查]

E --> F[权限和所有权校验]

F --> G[安全模式退出条件评估]

```

### 2.2.3 常见错误及预防措施

在启动过程中,常见的错误包括节点宕机、数据不一致、网络异常等。对于节点宕机,可以事先设置心跳检测机制,一旦发现节点不可达,立即发出告警并启动备用节点。对于数据不一致的问题,可以设置定期的文件系统完整性检查,并在发现问题时自动触发数据修复流程。

网络异常往往是因为配置错误或硬件故障导致。因此,对于网络检查,除了常规的ping测试之外,还应该使用更复杂的网络诊断工具,如`iperf`,来测试网络的带宽和延迟。

## 2.3 安全模式下的集群启动脚本

### 2.3.1 自动化启动脚本的编写与管理

编写自动化启动脚本可以极大简化Hadoop集群的启动流程,并且减少人为错误。脚本通常包括启动顺序控制、错误处理和日志记录功能。使用Bash脚本是常见的做法,因其跨平台和易用性。

启动脚本应该首先检查配置文件的正确性,然后按顺序启动各个服务,如ZooKeeper、NameNode和DataNode。脚本还应检测服务是否正常启动,并在出现问题时进行自动重试或通知管理员。

```bash

#!/bin/bash

# 启动NameNode的示例脚本

if [ ! -f "/etc/hadoop/conf/hdfs-site.xml" ]; then

echo "配置文件缺失,无法启动"

exit 1

fi

start-dfs.sh >> /var/log/hadoop/start-dfs.log 2>&1

if [ $? -ne 0 ]; then

echo "启动失败,查看日志文件"

exit 1

fi

echo "Hadoop集群启动成功"

```

### 2.3.2 启动脚本的安全性优化策略

安全性优化策略涉及对启动脚本的权限管理、日志安全以及自动化响应错误。脚本文件的权限应该限制为只有特定的管理员用户可以读取和执行。日志文件也应该设置合适的权限,防止未授权访问。

另外,启动脚本可以集成故障自动响应机制,如监控服务状态并配置告警系统。如果发现服务异常退出,脚本可以自动重启服务,并发送通知给管理员。

```bash

# 配置文件权限设置示例

chmod 700 /path/to/startup-script.sh

# 日志文件权限设置示例

chmod 600 /var/log/hadoop/start-dfs.log

```

自动化启动脚本的编写和安全性优化策略需要综合考虑集群的规模、业务的复杂性以及安全

0

0